导言

目标读者

本书《TensorStack AI 计算平台 - 用户使用手册》 的目标读者是 “TensorStack AI 计算平台” 的使用者,包括:

- AI 研究人员

- 建模工程师

- 数据处理工程师

- 机器学习工程师

- AI 应用开发工程师等

系统管理员、运维人员需要参考另外的《TensorStack AI 计算平台 - 管理员手册》系列。

如何使用

概述 介绍了产品的基本功能和使用模式。

用户首次使用可以跟从快速开始的内容,快速完成基本的体验。

然后,用户可以阅读 AI 开发和应用章节,以学习 AI 开发相关的概念。

其他章节内容如下:

- 账户和安全 讨论用户账户和系统安全问题。

- 计算资源 讨论如何使用集群计算资源。

- 存储 章节对平台的存储方面的支持进行了说明。

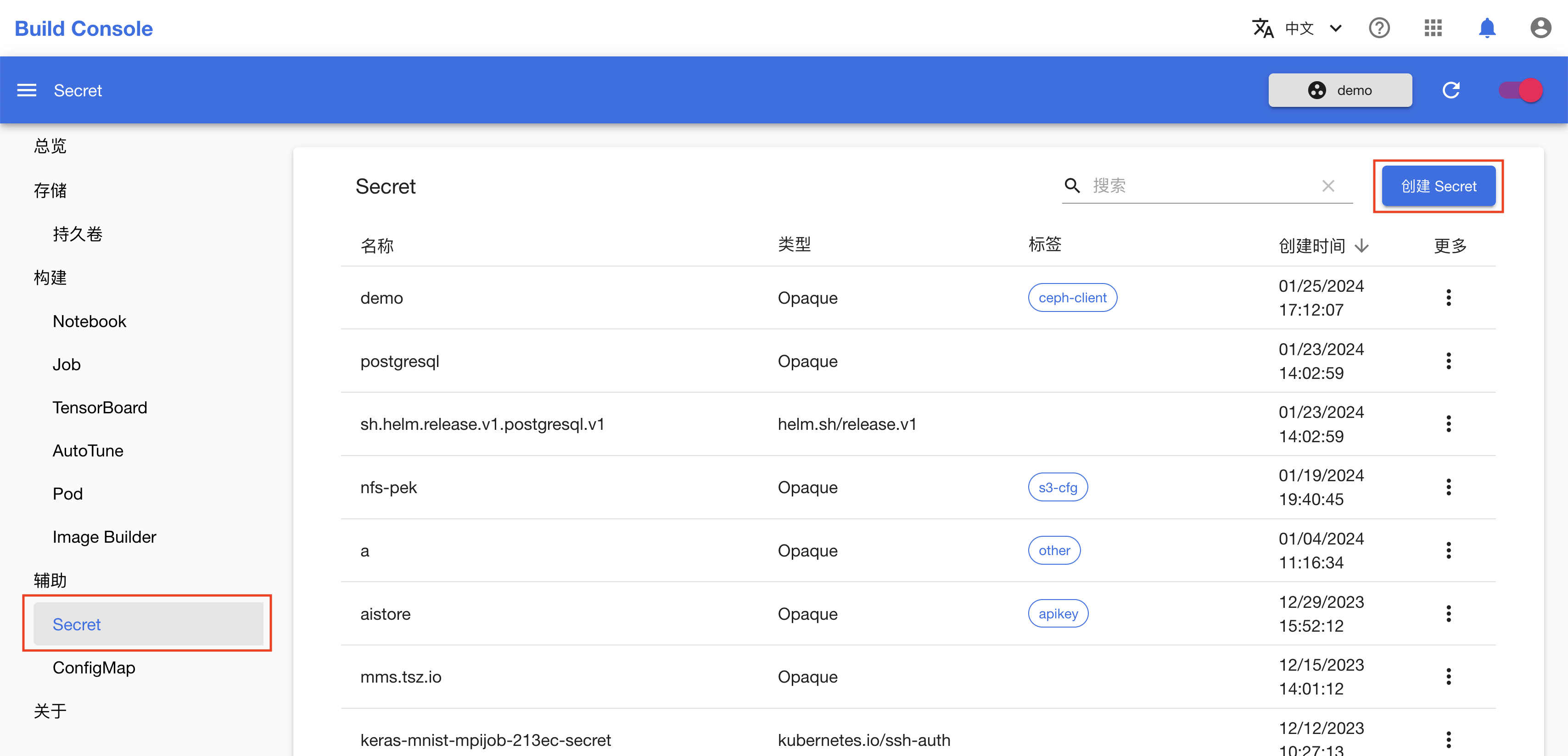

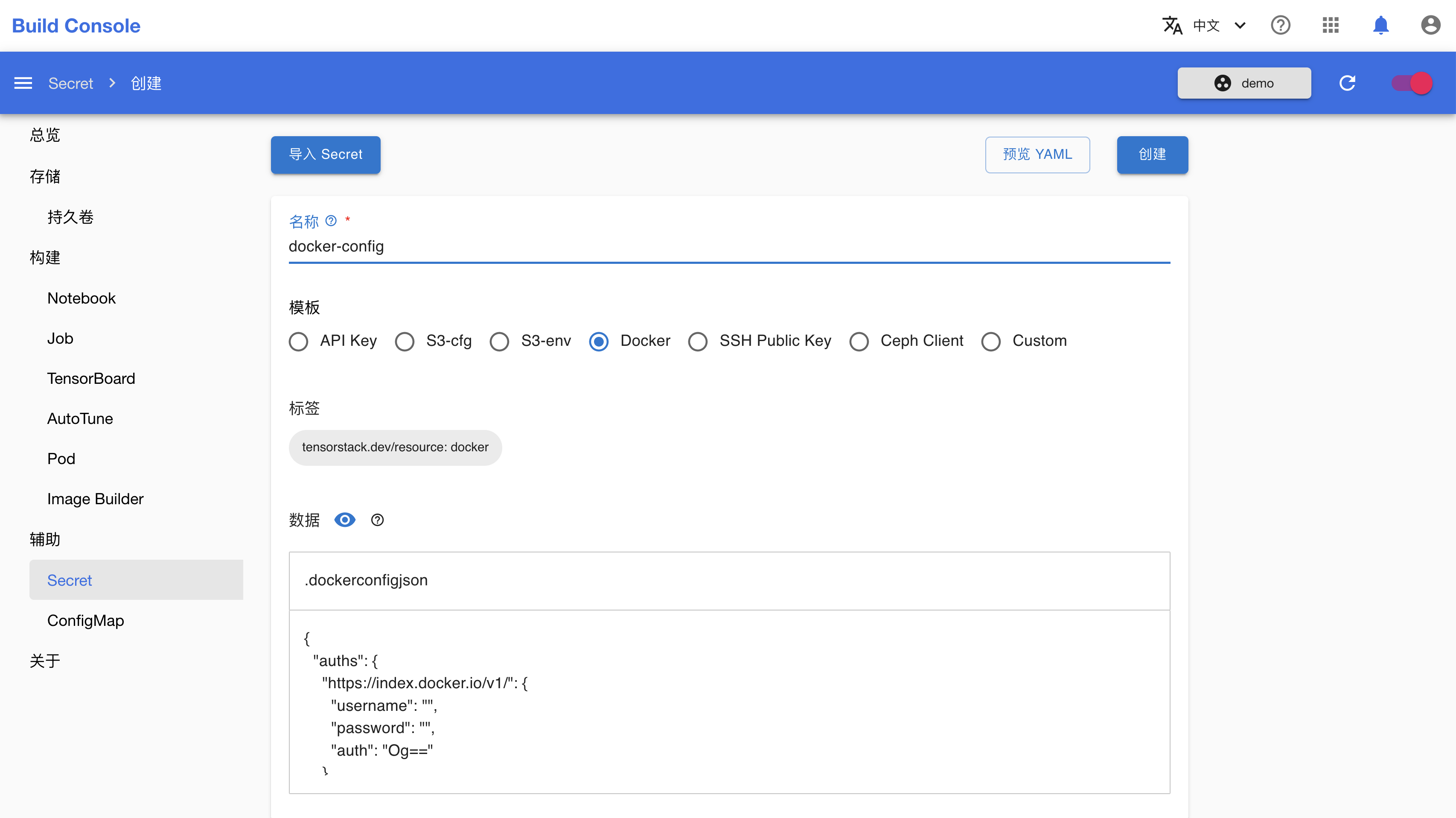

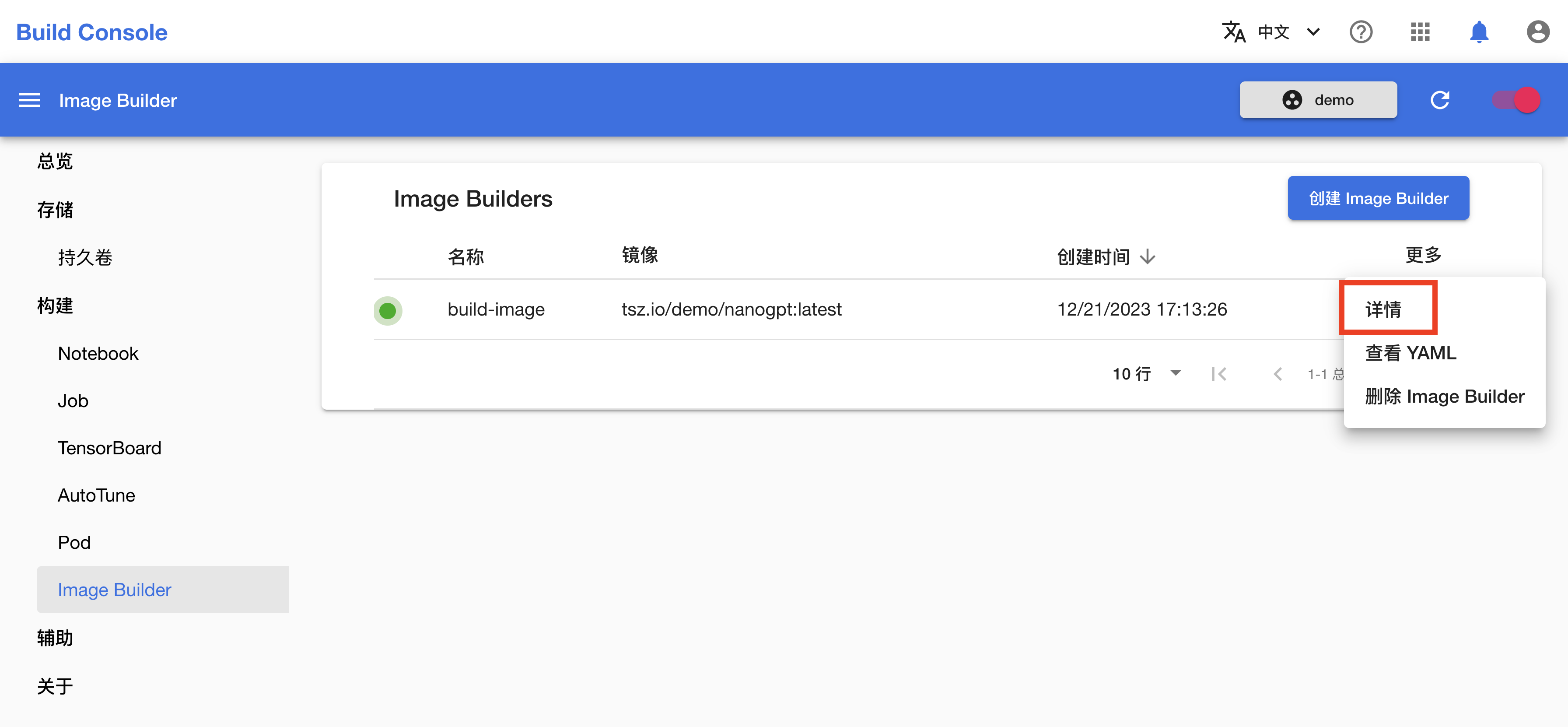

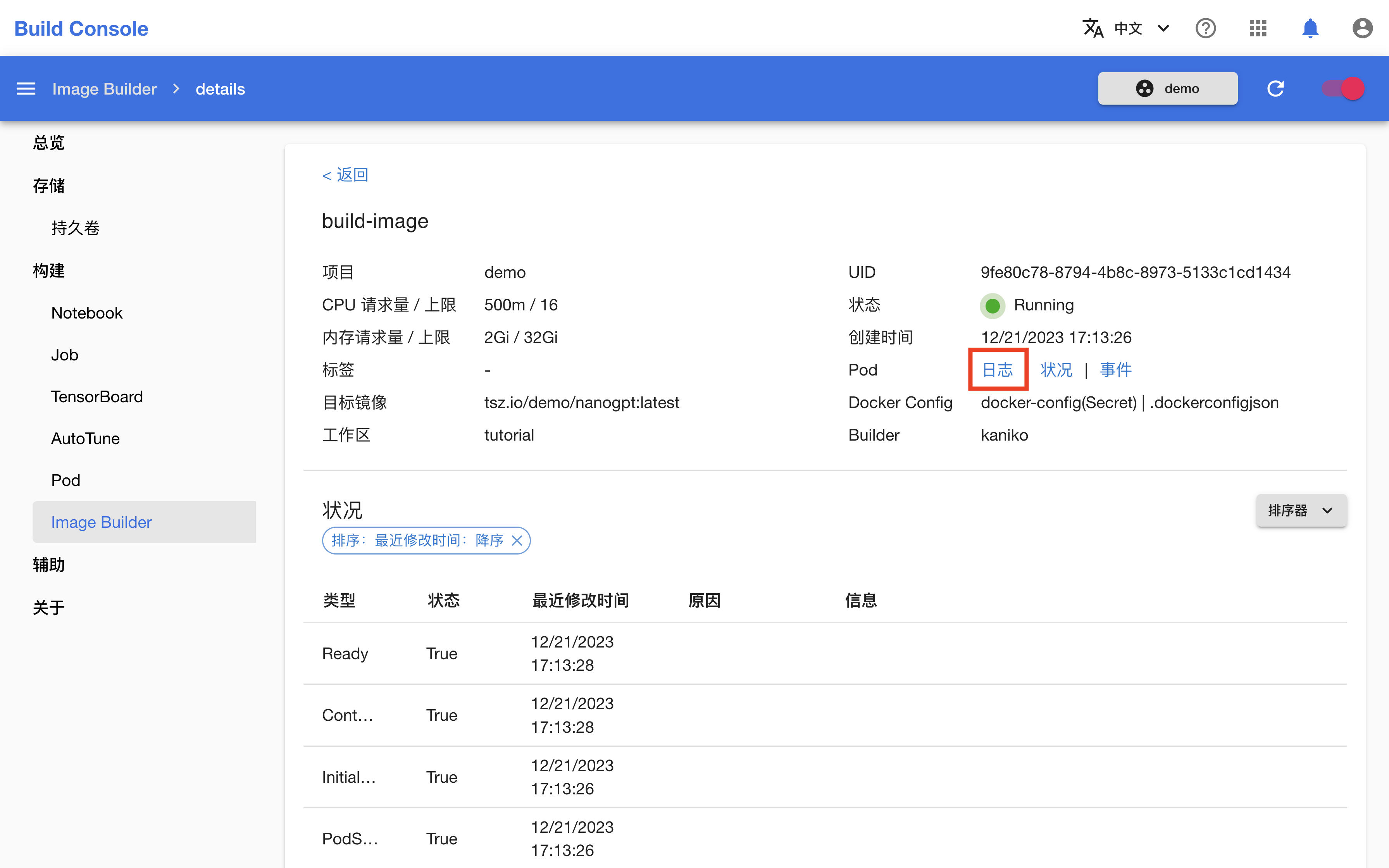

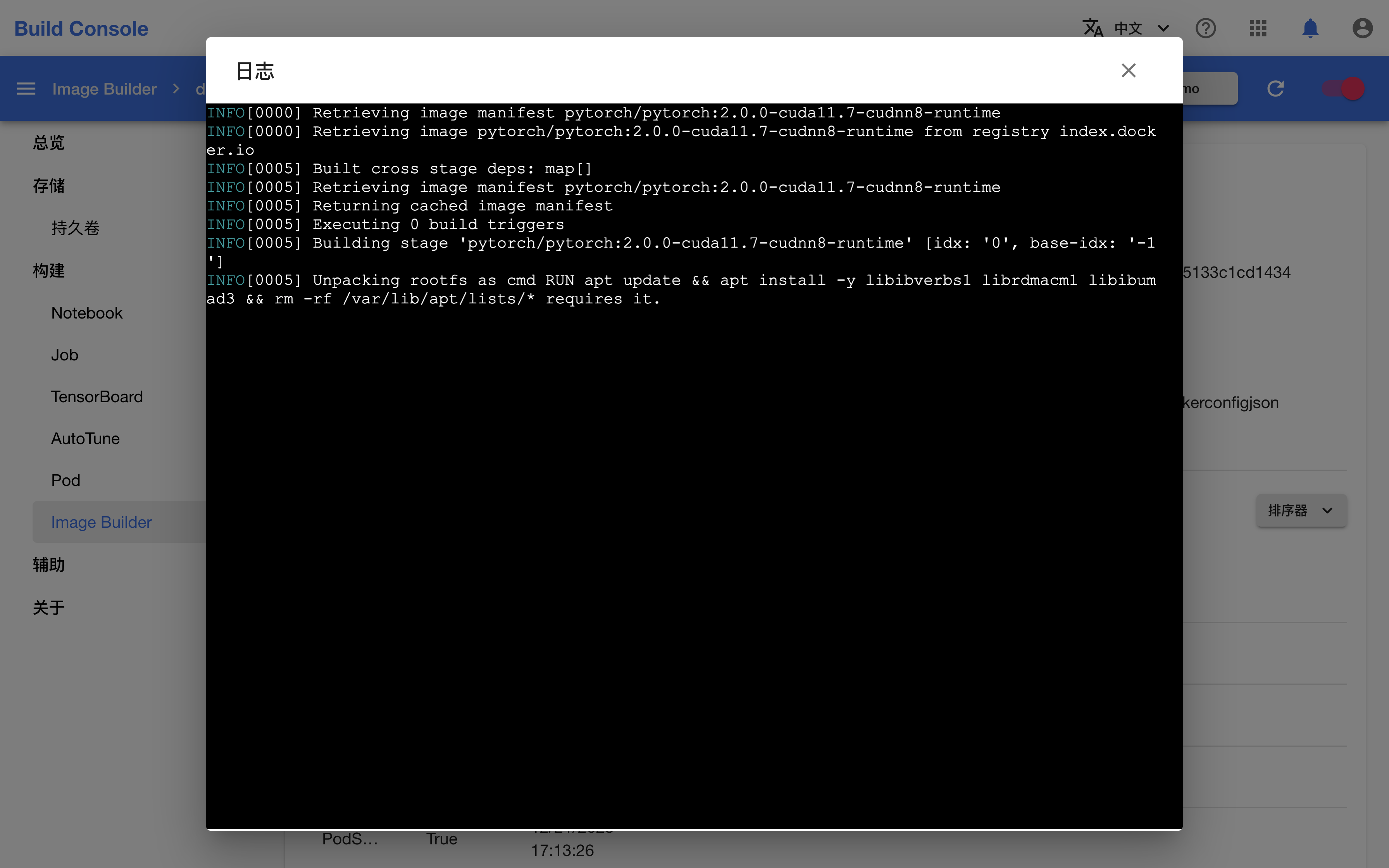

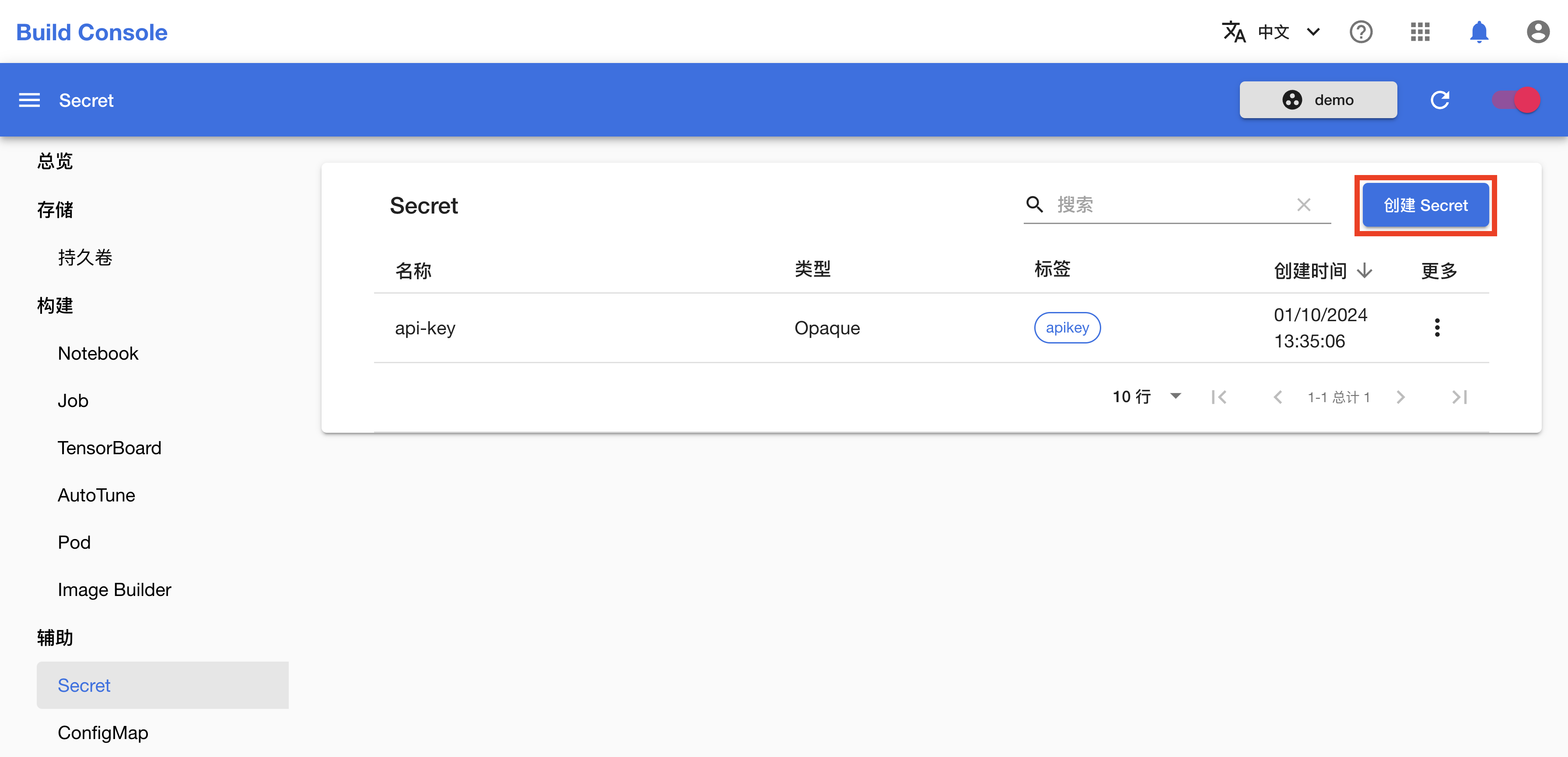

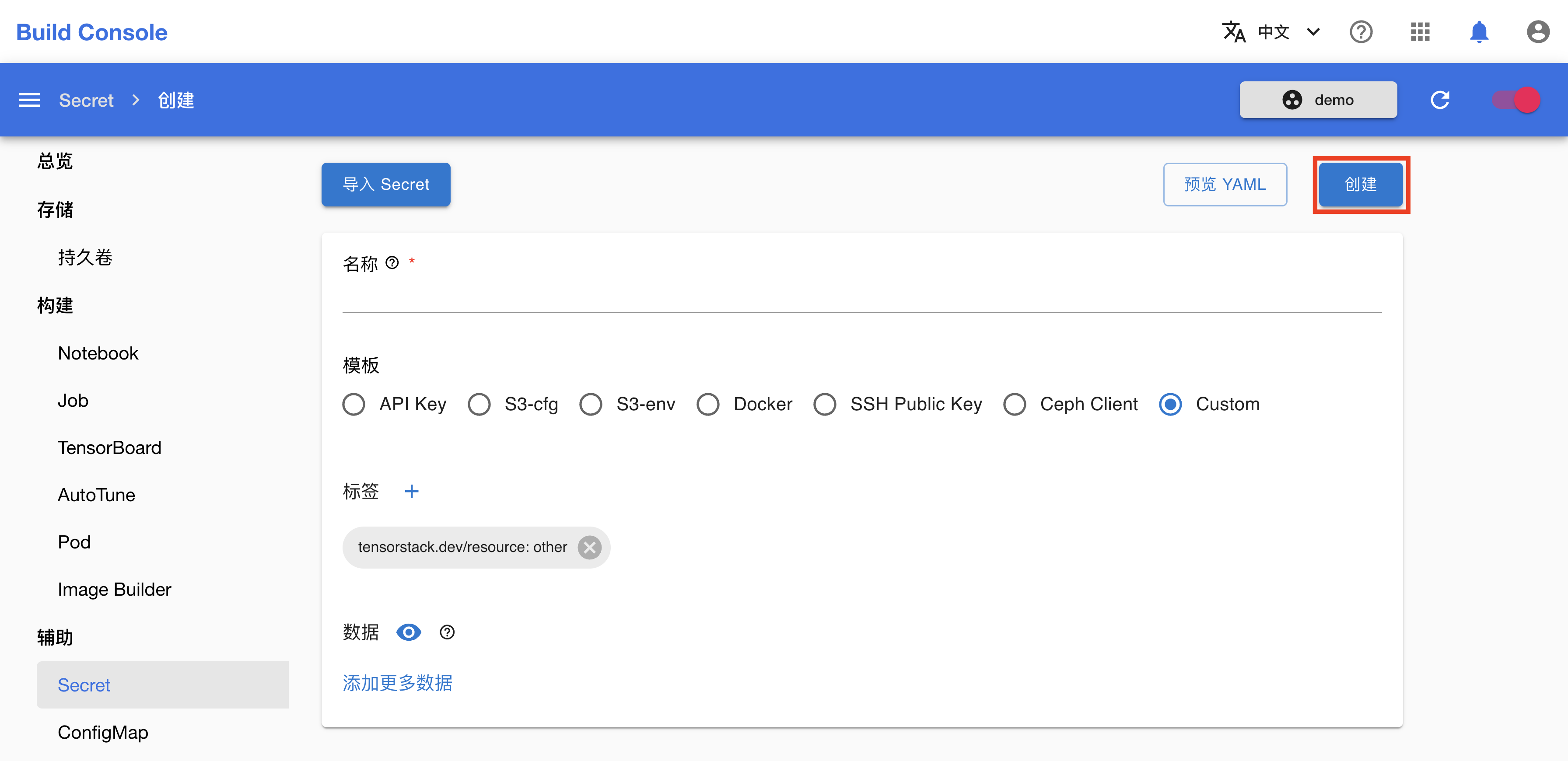

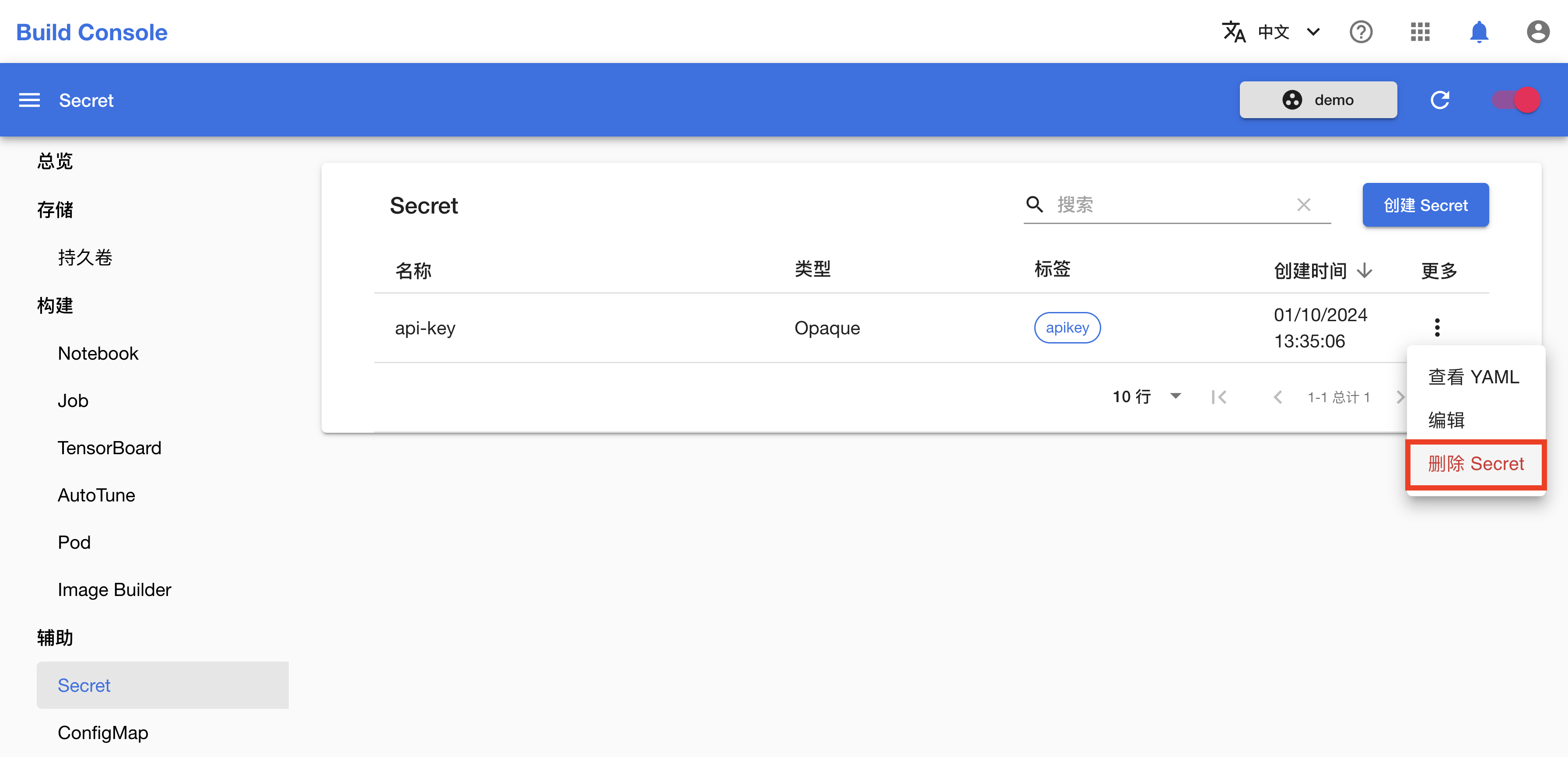

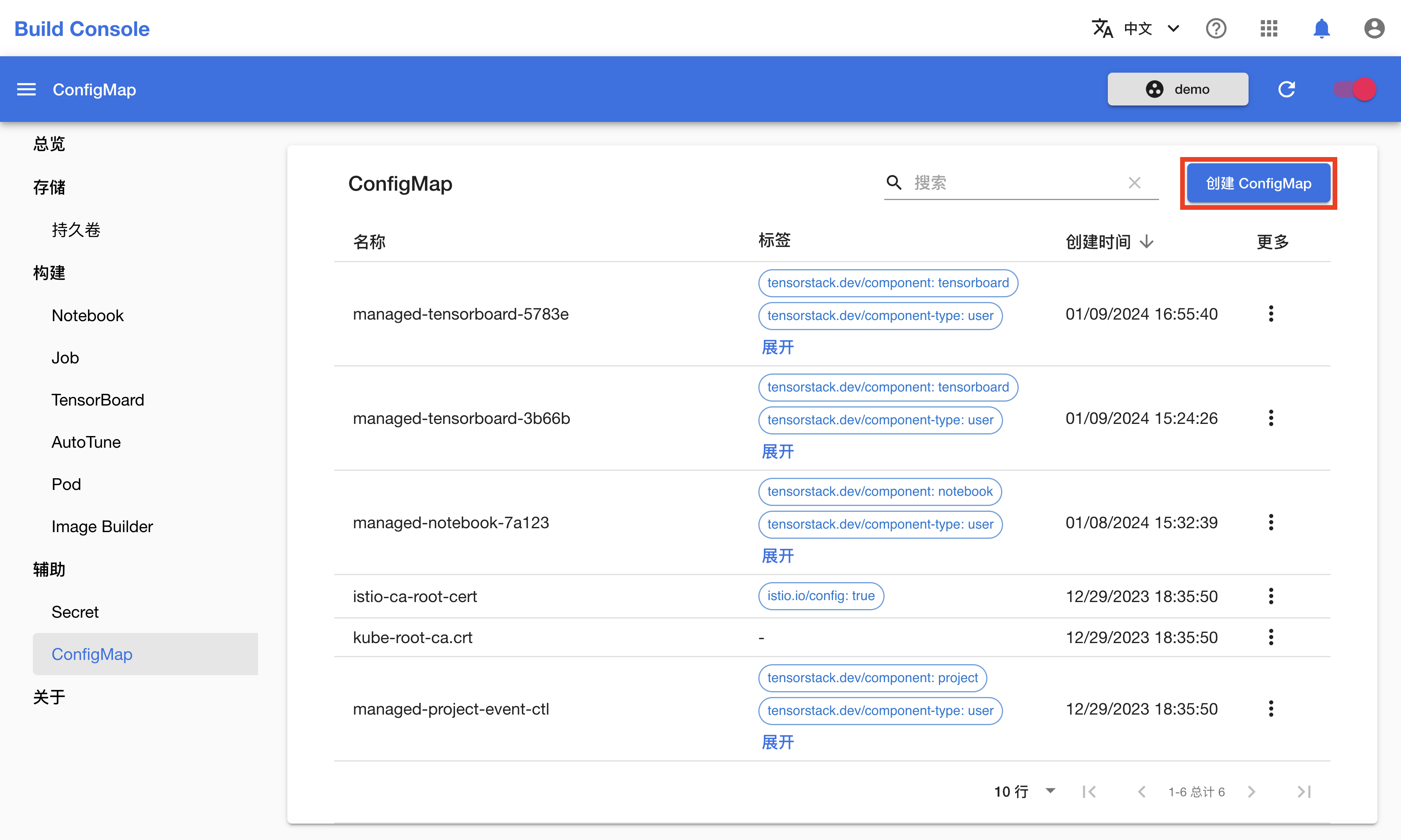

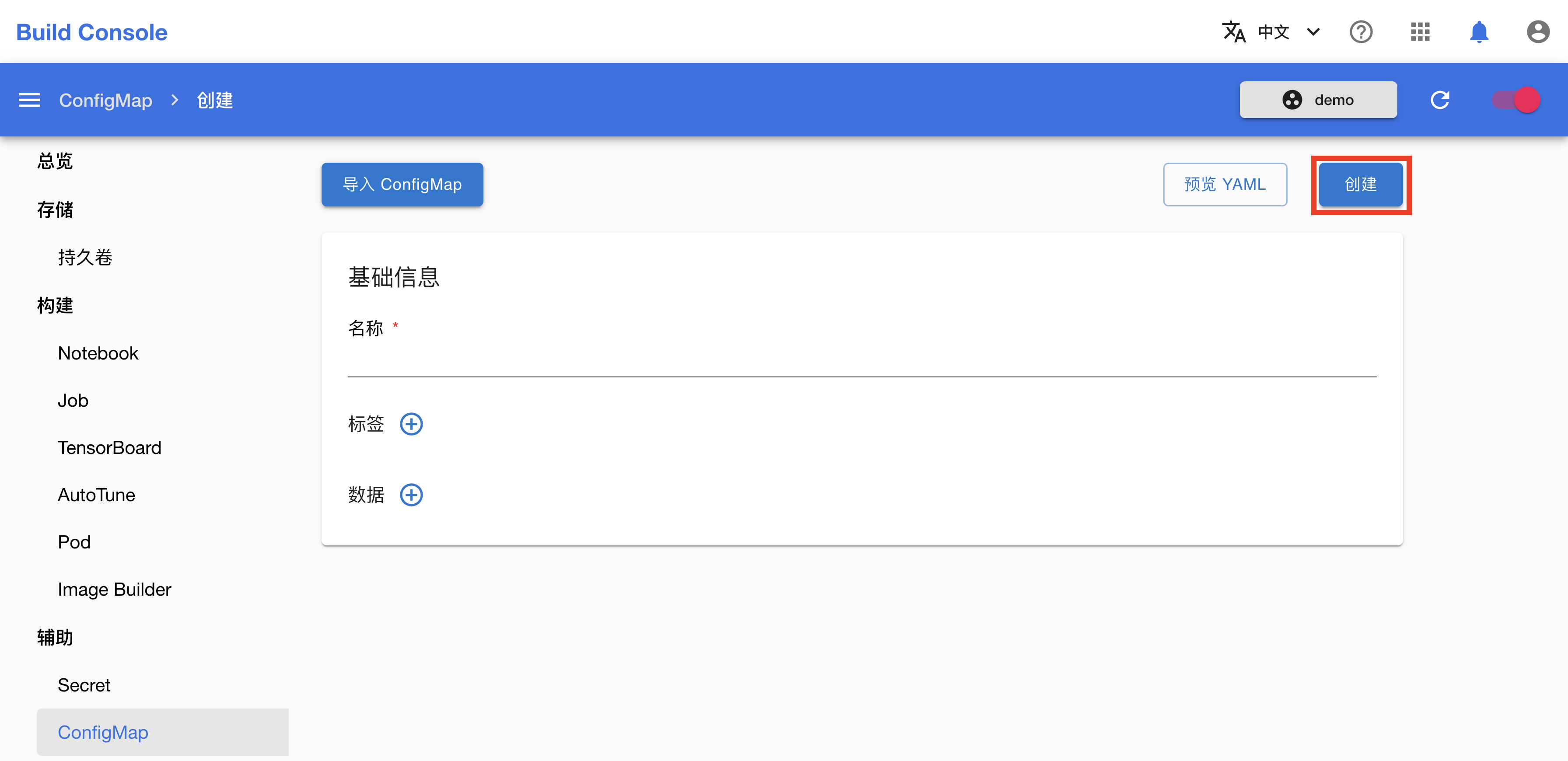

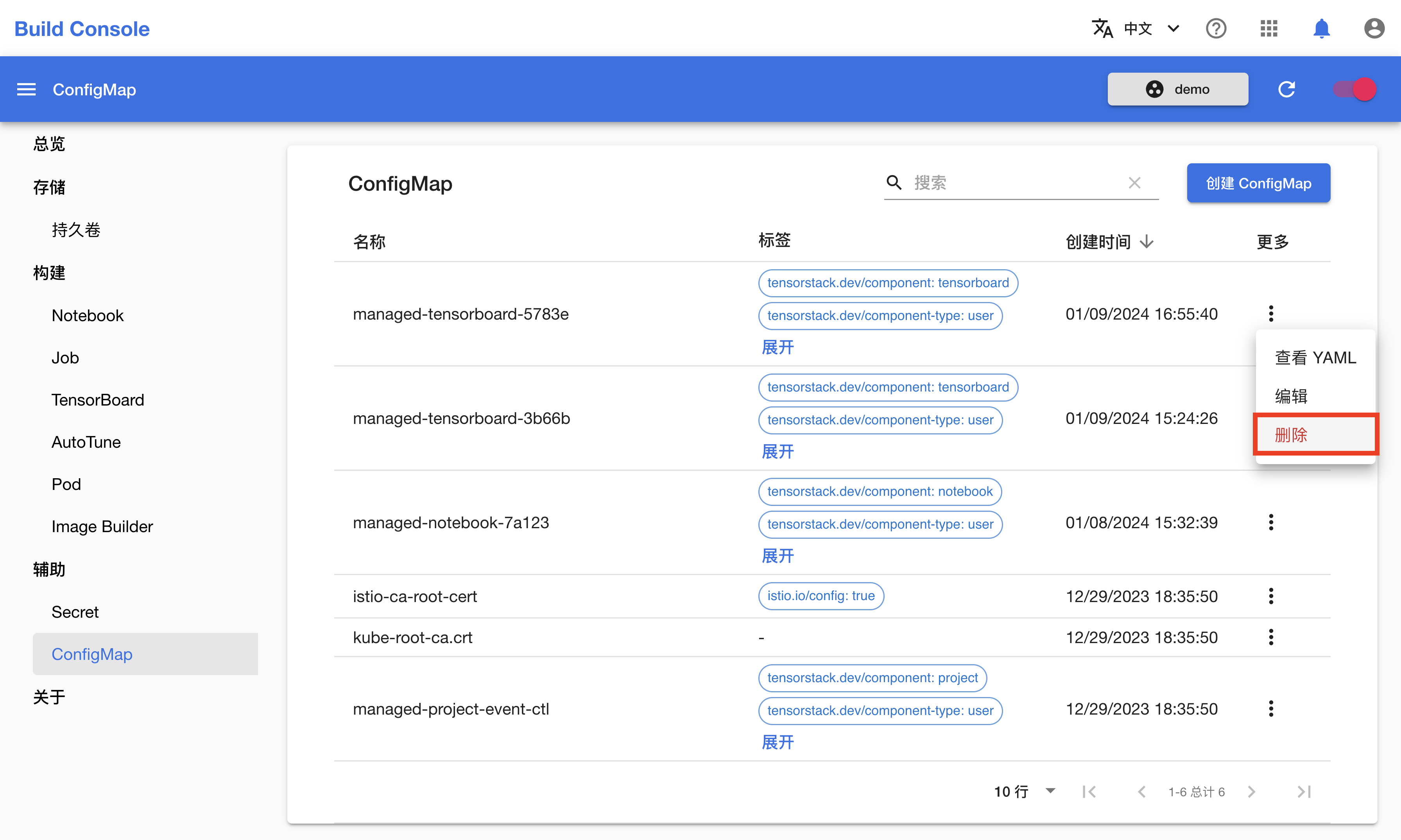

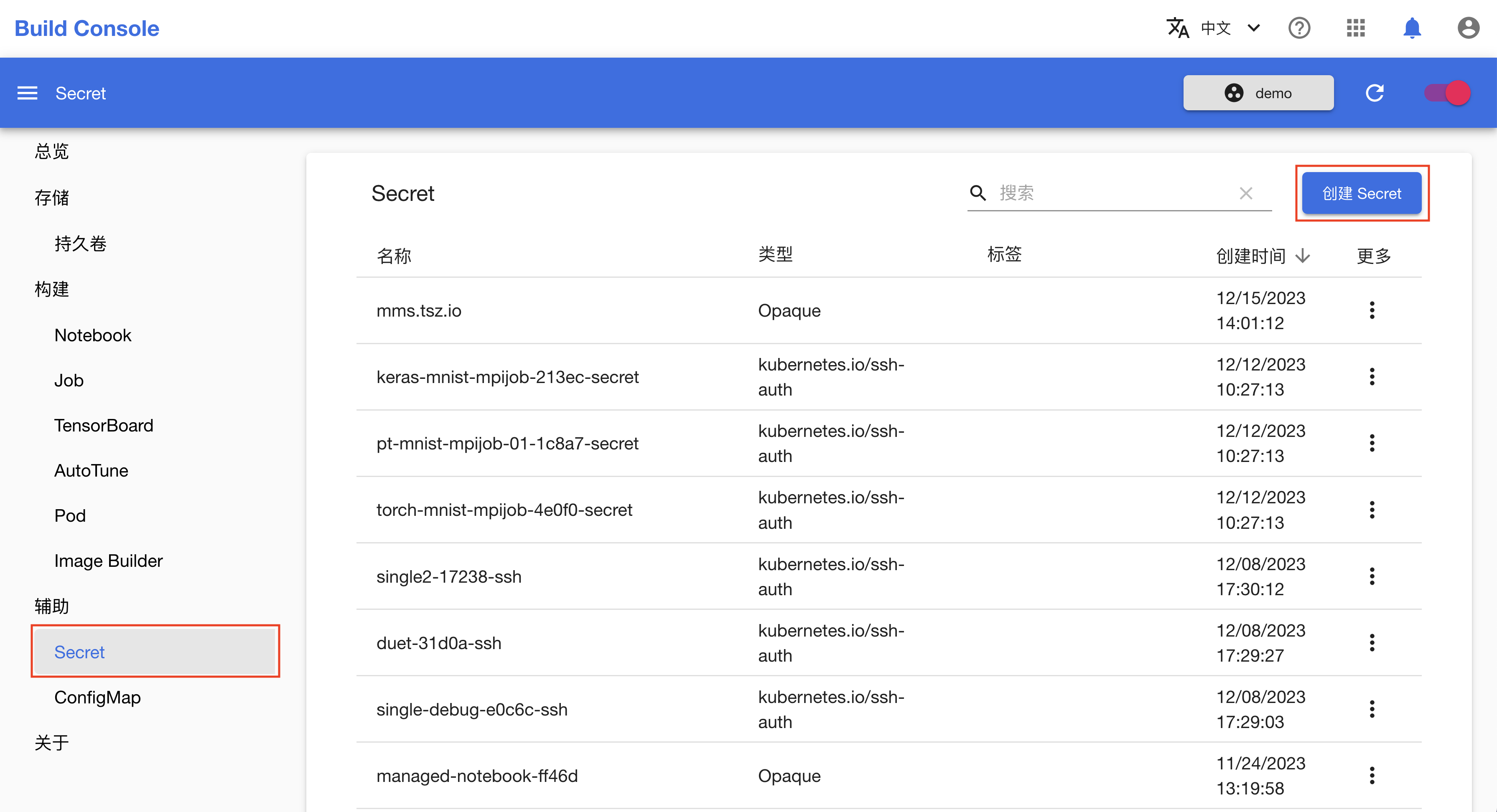

- 辅助 章节描述平台提供的一些重要辅助功能,例如如何处理敏感秘密信息,打包容器镜像等。

- 命令行工具和 SDK 讨论平台的提供的命令行工具和 Python SDK 。

- 操作示例 章节提供了一些具体的操作指南。

- 参考 章节对 API 提供了完整的描述。

- 示例 章节提供了一些具体的应用示例,特别是对 LLM 领域的场景提供了全面的支持演示。

- 集成 章节讨论了一些优秀的第三方工具在平台上的集成及使用。

- 附录1:背景 介绍了产品的技术架构和设计思路等。

“TensorStack AI 计算平台” 是一个功能强大且灵活的产品,支持在大规模(10^3 节点)集群上进行各种 AI 场景的计算。用户在一定的时间的学习、使用、探索、积累之后,就能对其功能有深入的理解,并在上面完成各种优秀的工作。

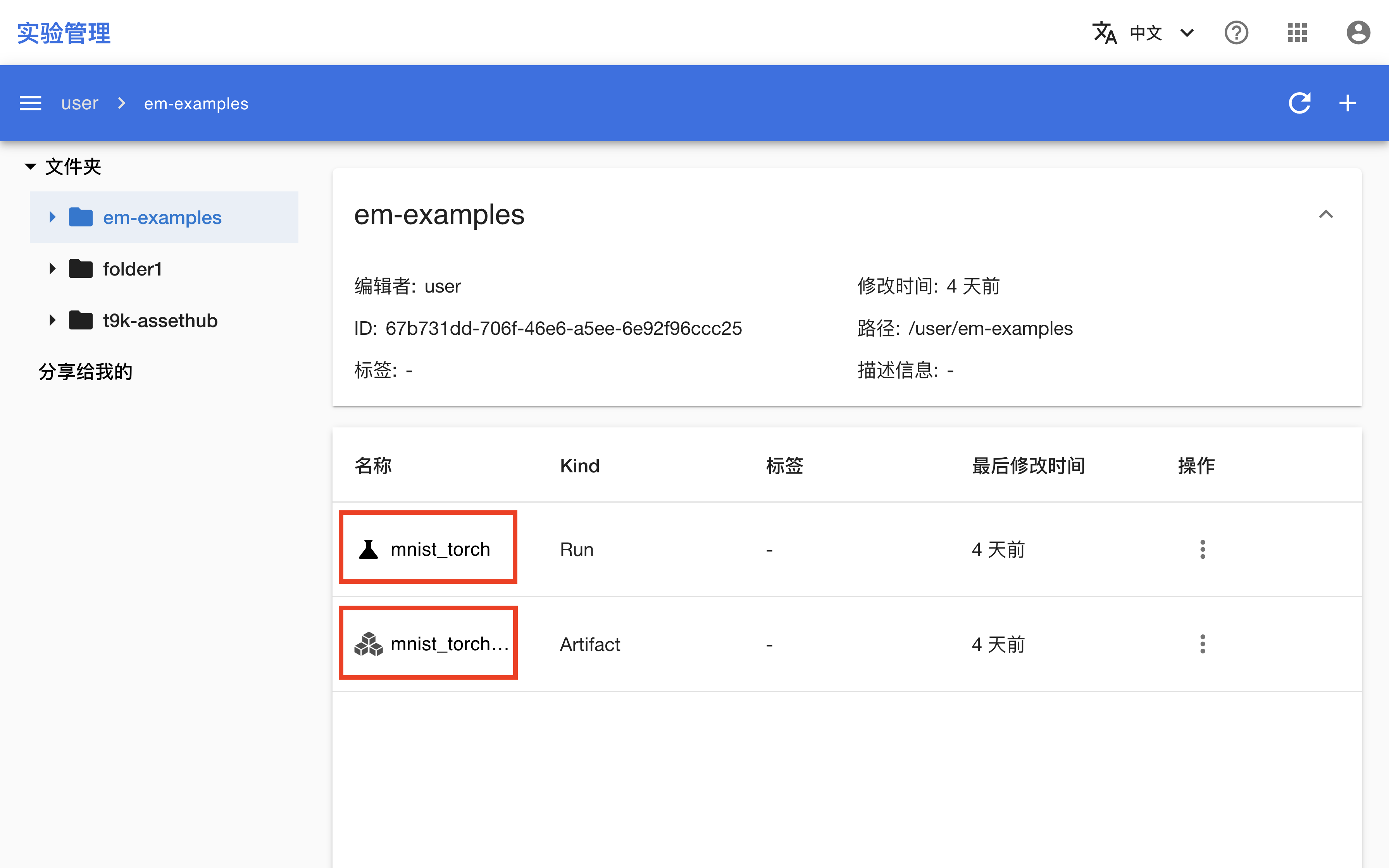

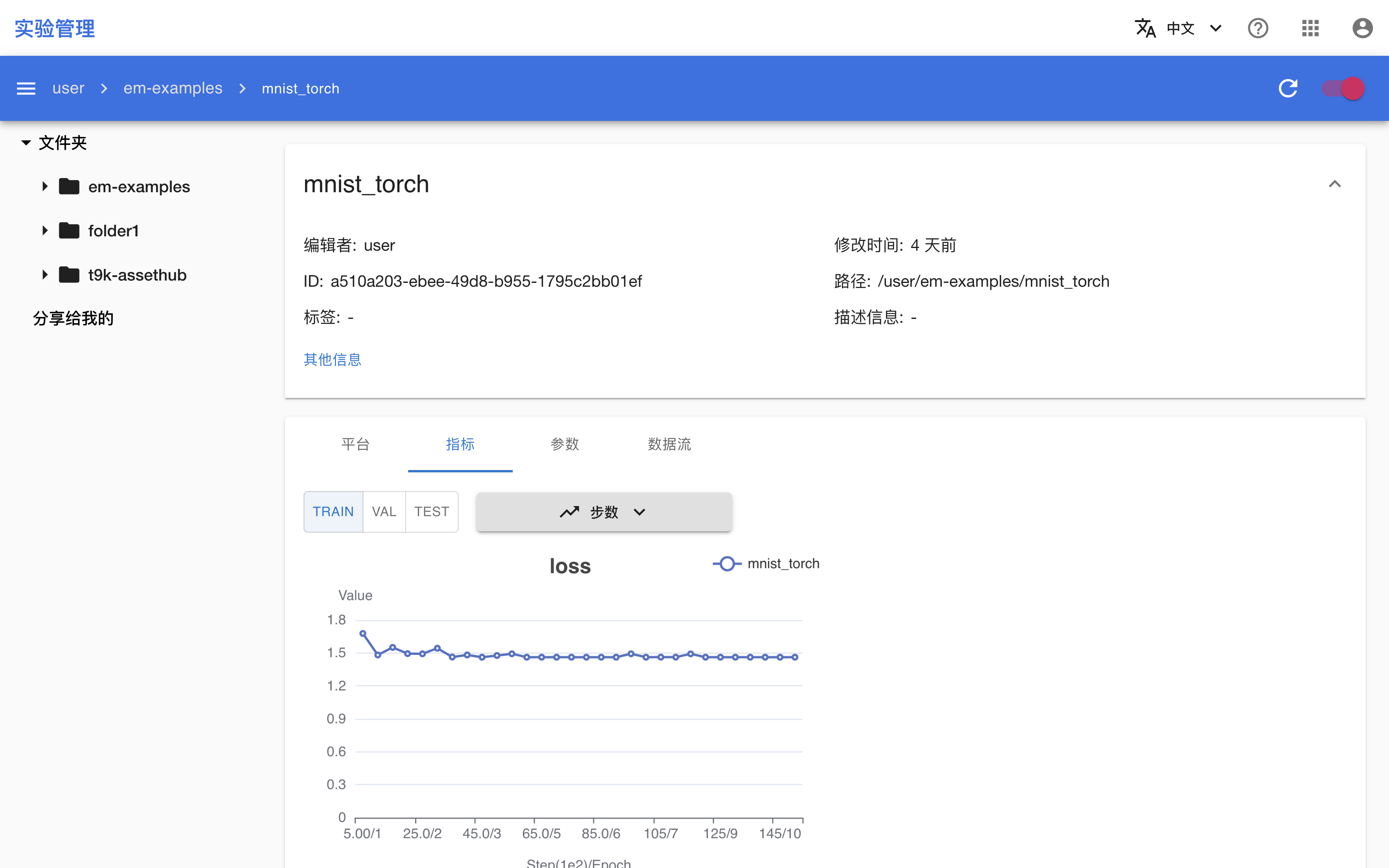

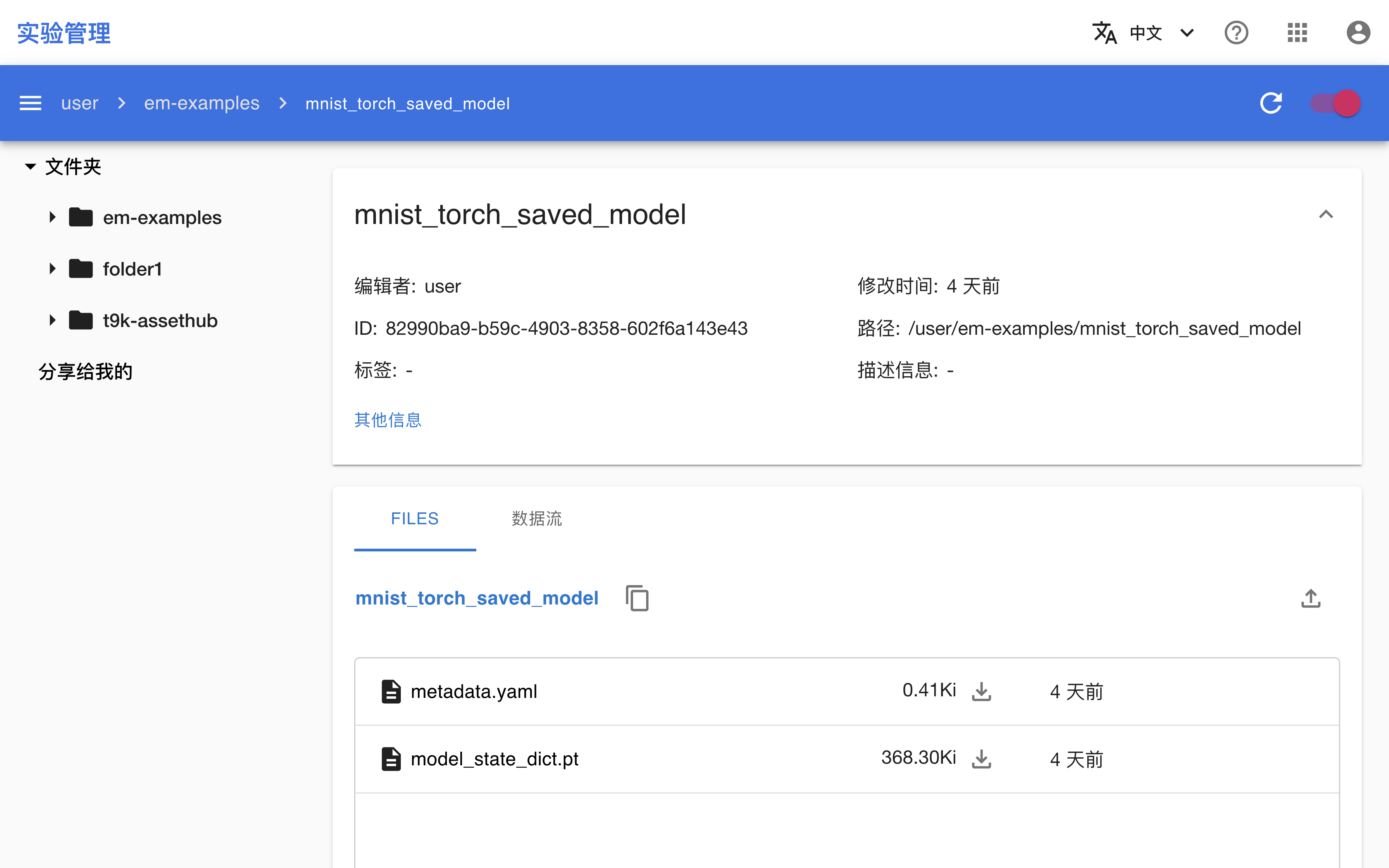

本手册使用的例子一般存放在下列 repos:

反馈

非常欢迎各种反馈,可在 Github Issues 页面 创建 issue。

版权声明

© 2023-2024 TensorStack.

本书/网站的内容版权由 TensorStack 所有,欢迎使用。

概述

产品介绍

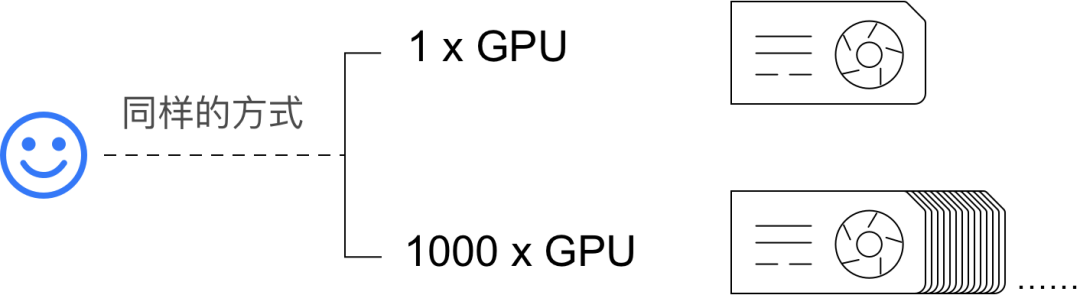

“TensorStack AI 计算平台” 是面向 AI 集群的系统软件,针对 AI 集群的硬件架构和 AI 领域的计算任务的特性和需求,提供稳定、可扩展的 AI 技术平台能力,服务 AI 技术研发和规模化落地。

AI 集群的拥有者可以使用这套软件,构建自己的 “AI 私有云” 或 “AI 混合云” 基础设施服务。

通过先进的架构和丰富的 API + 系统服务,“TensorStack AI 计算平台” 合理地隐藏了分布式并行、异构计算、加速计算等技术的复杂细节,提高了抽象层次,并为 AI 领域的各种计算提供了针对性的支持,极大地提升了 AI 技术研究、开发、应用的工作效率。

基本流程

用户使用 “TensorStack AI 计算平台” 的基本交互流程:

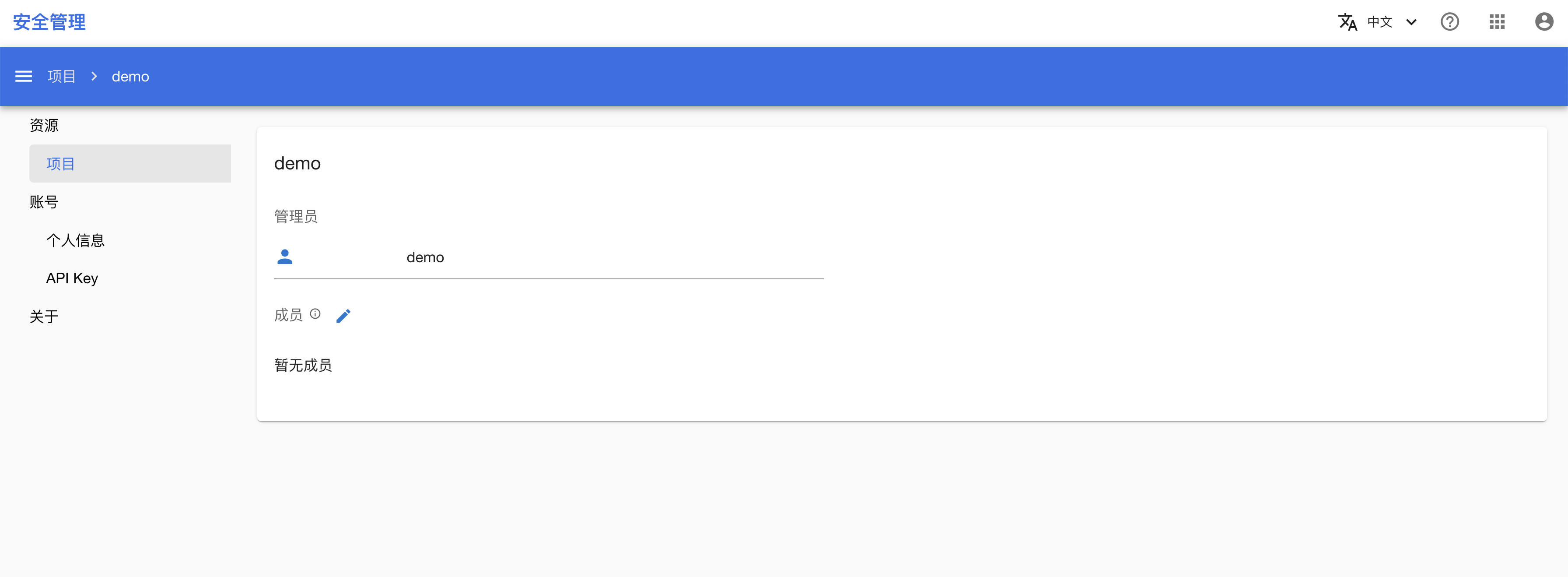

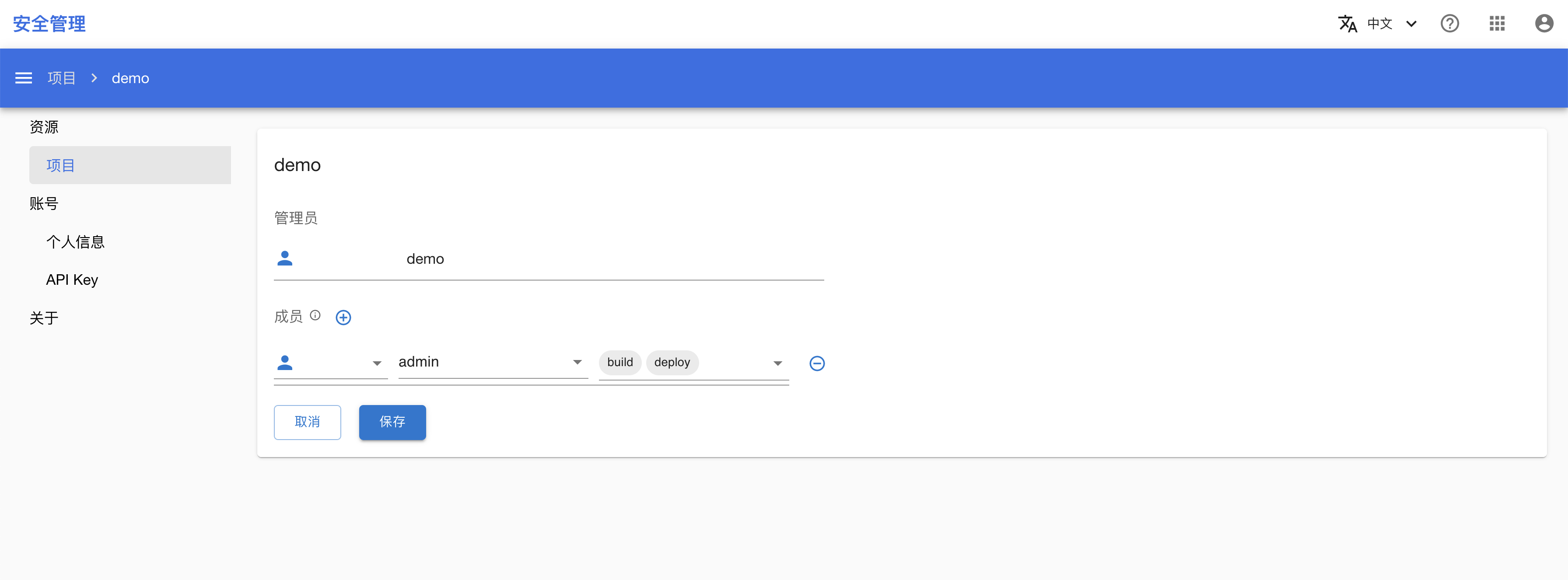

- 管理员 - 创建 - 项目(Project)并设定项目管理员。

- 用户以项目管理员或者普通成员的方式使用项目。

- 用户可以同时使用多个项目。

- 管理员 - 创建 - 用户帐户。

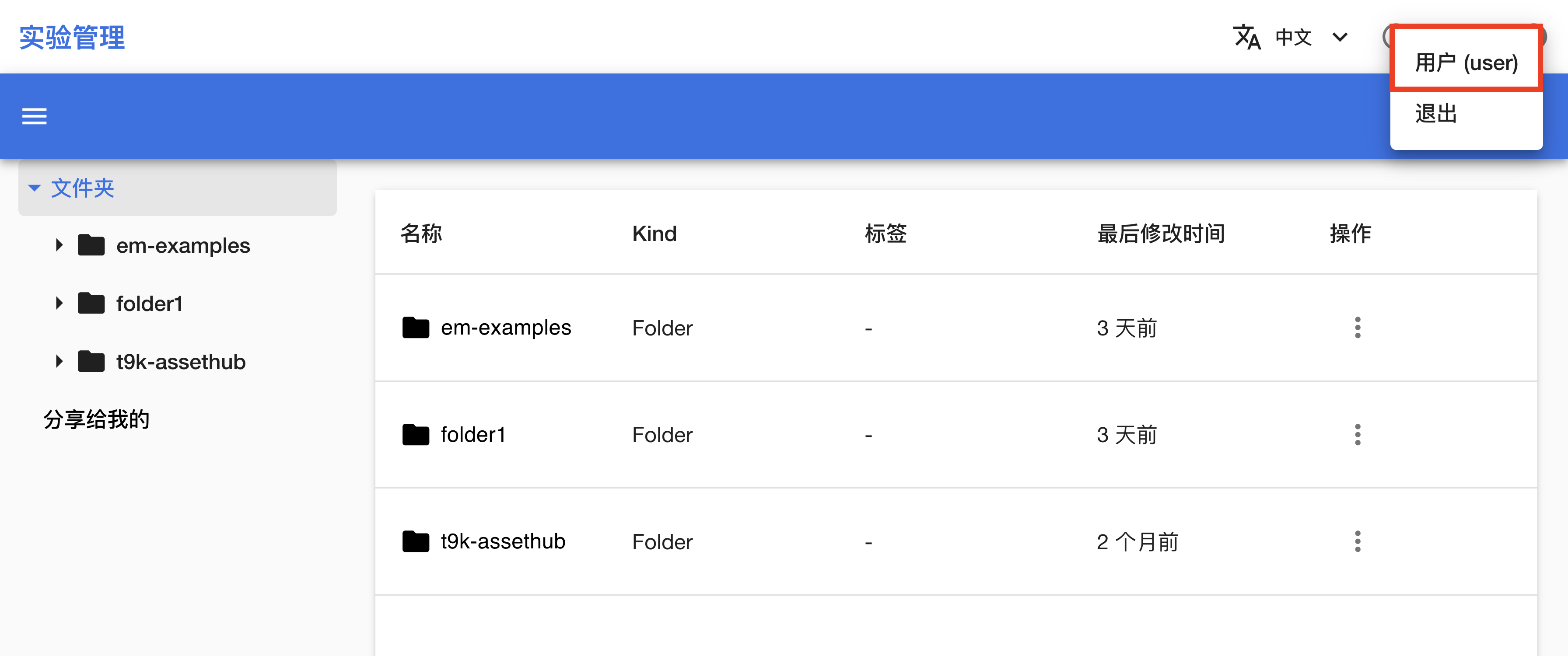

- 用户 - 使用其帐户 - 登录系统。

- 用户 - 在项目中 - 完成工作(创建各种计算任务)。

使用功能

用户主要通过创建各种类型 CRD 的实例(instance)使用产品的功能。例如:

- 创建一个

NotebookCRD 的实例,以使用 Jupyter Notebook; - 为了使用 DeepSpeed 进行大规模并行的 LLM 预训练,创建一个

DeepSpeedJobCRD 的实例; - 为了部署一个模型推理服务,并支持服务规模的自动伸缩,创建一个

MLServiceCRD 的实例;

CLI

CRD 实例(instance)的创建总是可以通过命令行实现,例如使用 kubectl 可以方便地创建一个 Notebook:

# create a notebook

kubectle create -f notebook-tutorial.yaml

notebook-tutorial.yaml

# notebook-tutorial.yaml

apiVersion: tensorstack.dev/v1beta1

kind: Notebook

metadata:

name: tutorial

spec:

type: jupyter

template:

spec:

containers:

- name: notebook

image: t9kpublic/torch-2.1.0-notebook:1.77.1

volumeMounts:

- name: workingdir

mountPath: /t9k/mnt

resources:

requests:

cpu: '8'

memory: 16Gi

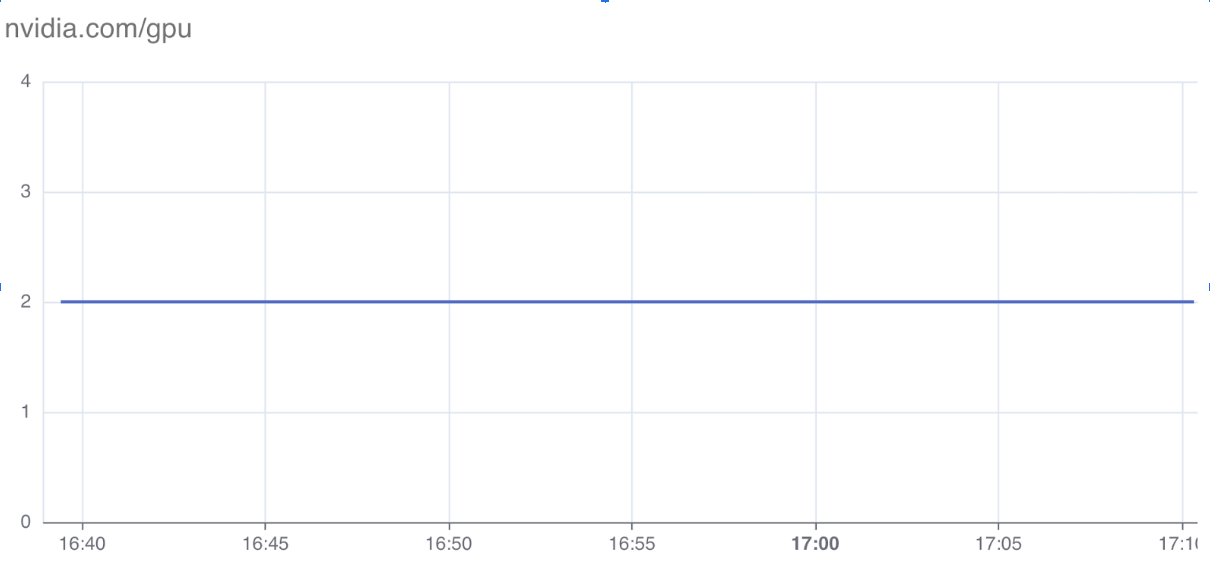

nvidia.com/gpu: 1

limits:

cpu: '16'

memory: 32Gi

nvidia.com/gpu: 1

volumes:

- name: workingdir

persistentVolumeClaim:

claimName: tutorial

UI

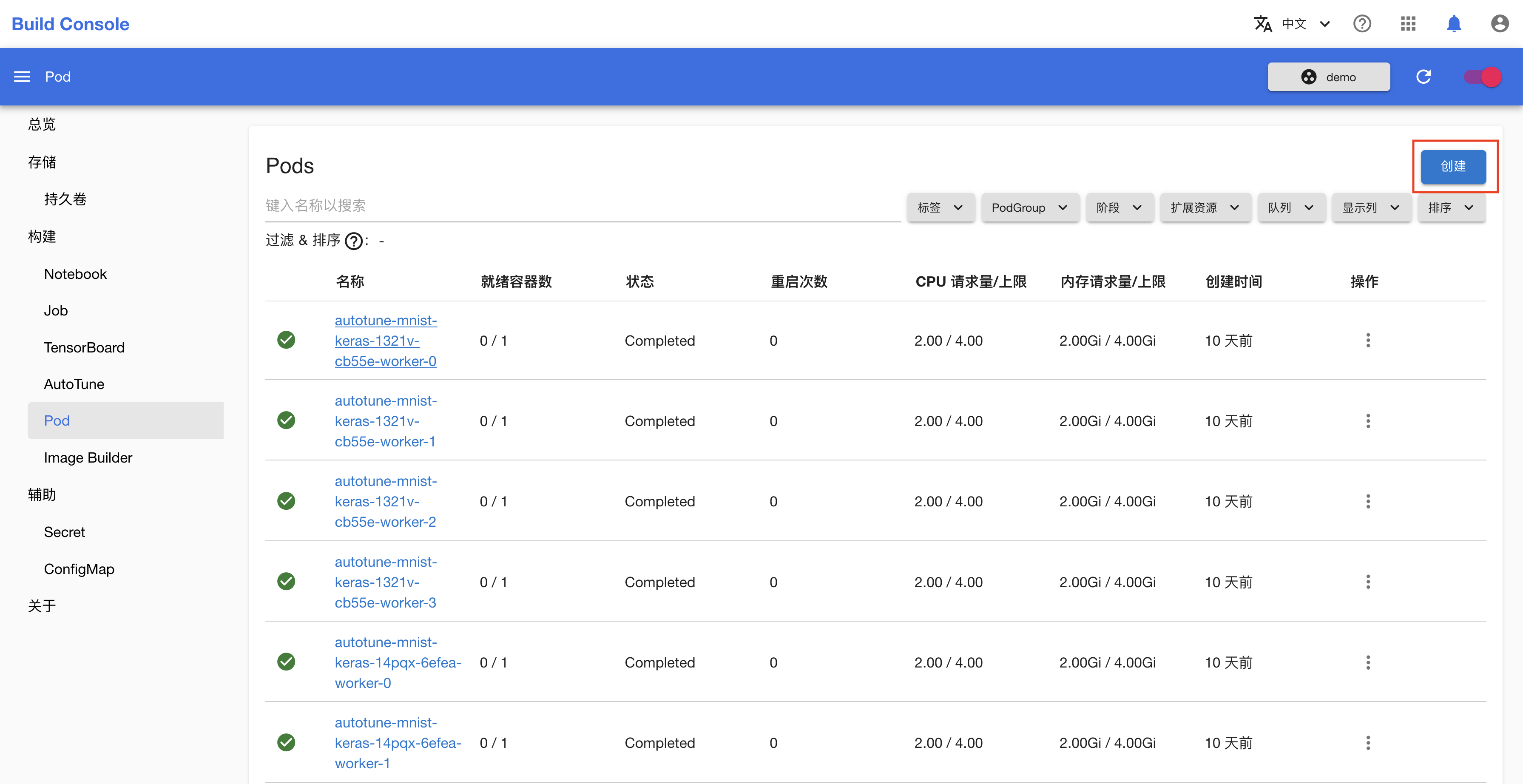

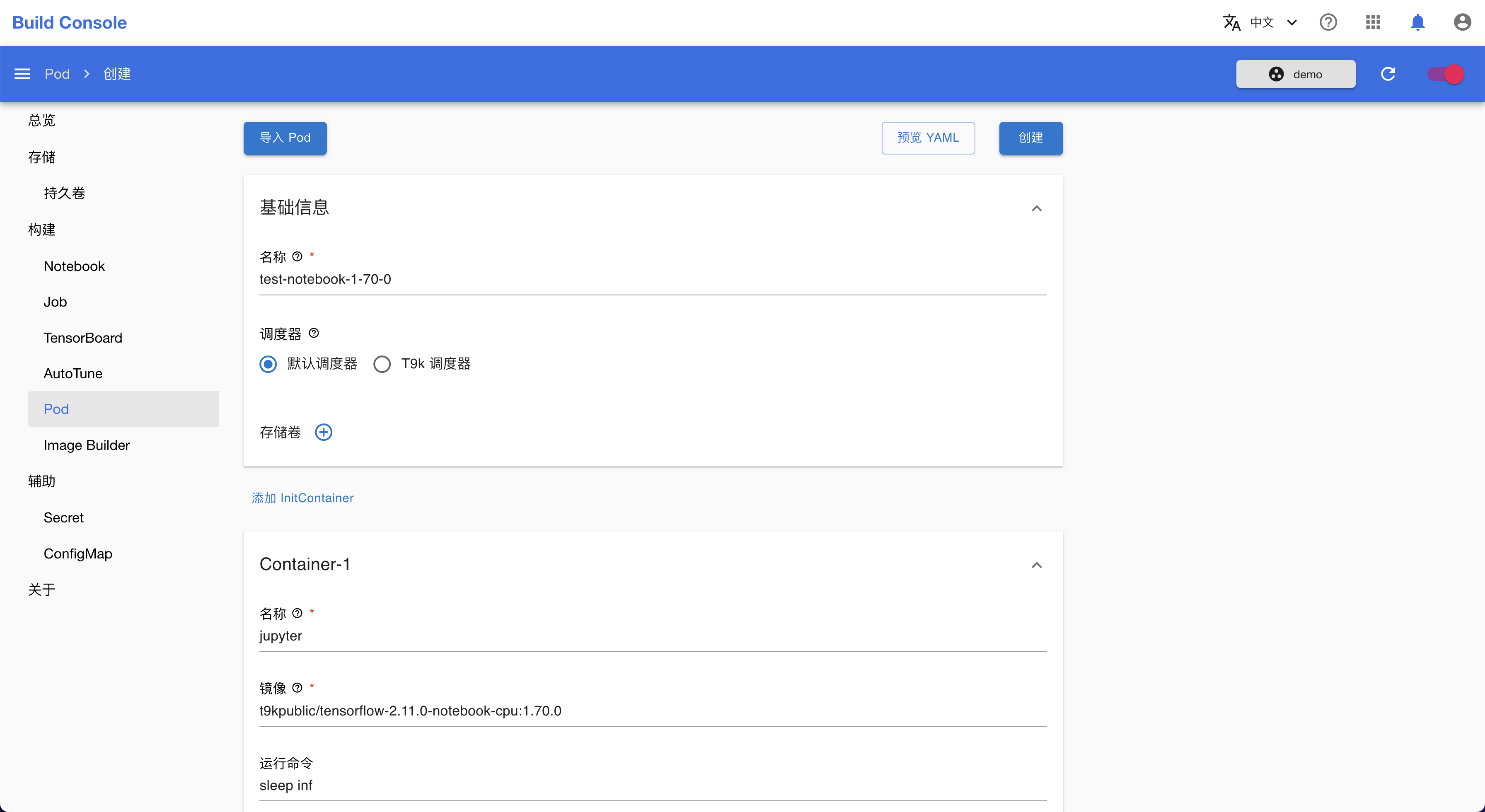

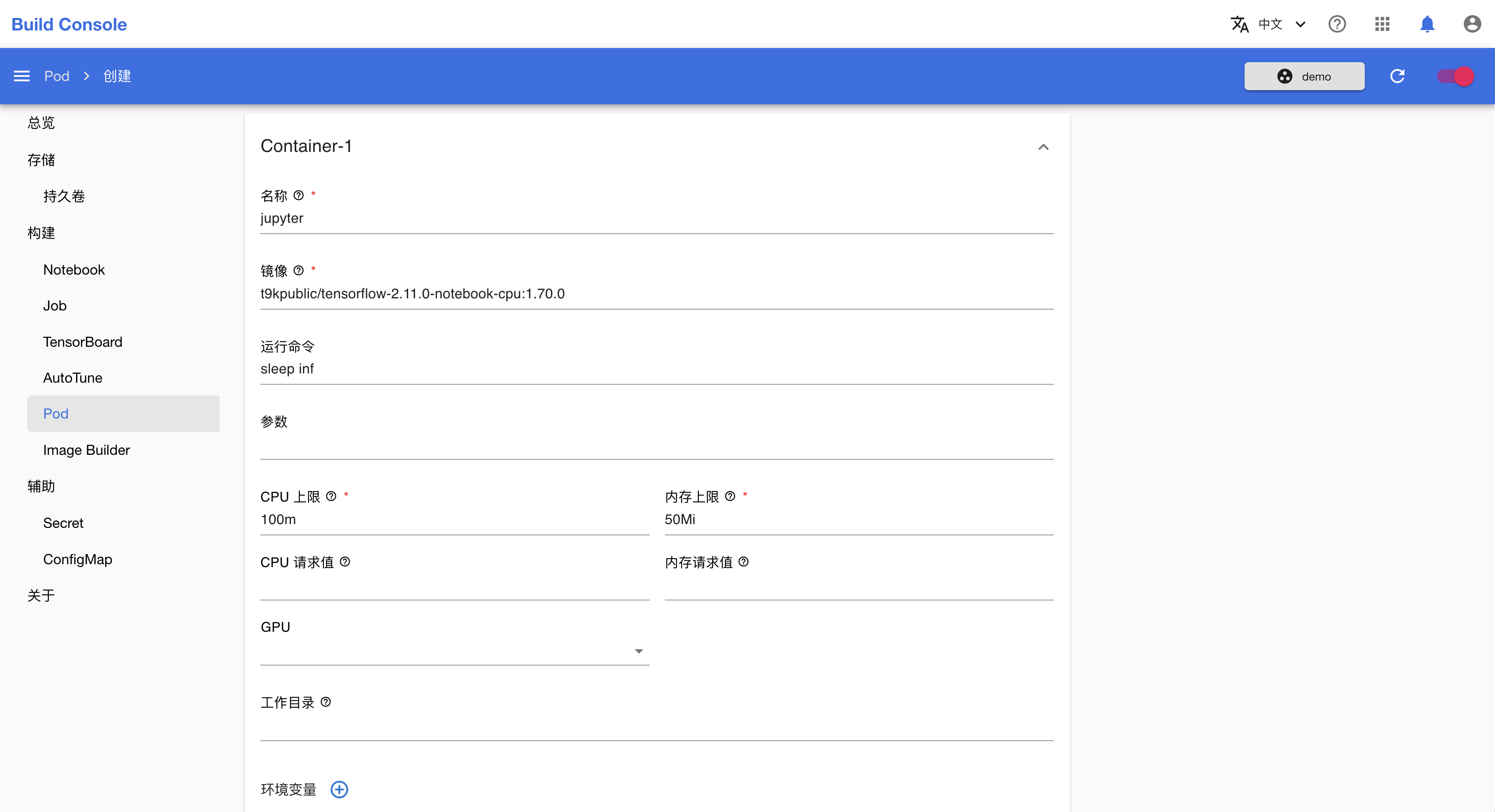

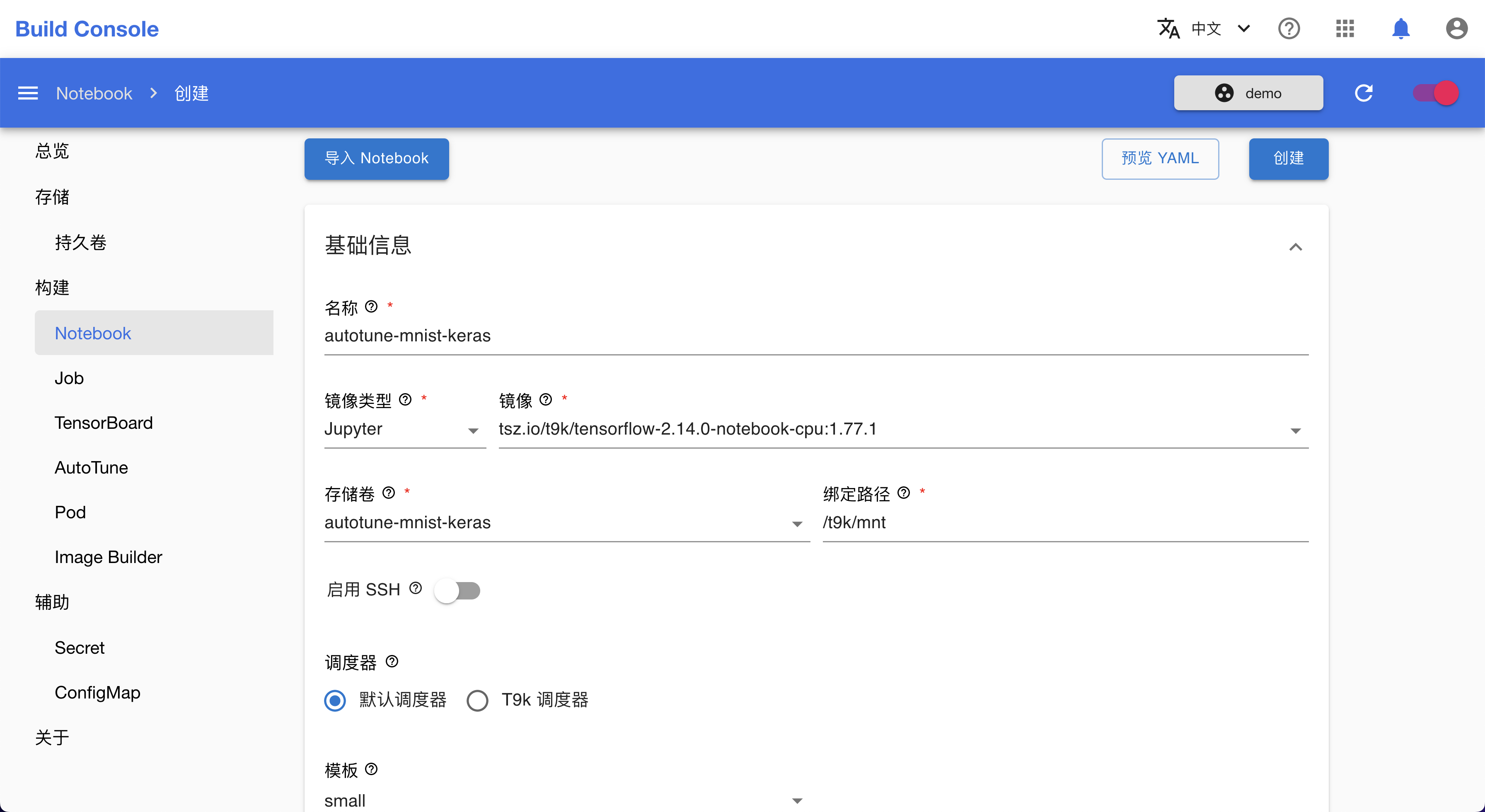

对于很多 CRD,TensorStack 的 Web 控制台(console)提供了通过表单(form)创建其实例的方式。

例如,可使用如下表单创建 Notebook 实例:

下一步

快速入门

欢迎使用“TensorStack AI 平台”!

本节将带领你快速体验 “TensorStack AI 平台” 的基本功能,并完成一个简单的 AI 项目,涵盖模型的构建、训练、部署等。

使用 TensorStack AI 平台之前,你需要:

下一步

训练你的第一个模型

本教程带领你使用 Notebook,来构建和训练一个 AI 模型。

创建 Notebook

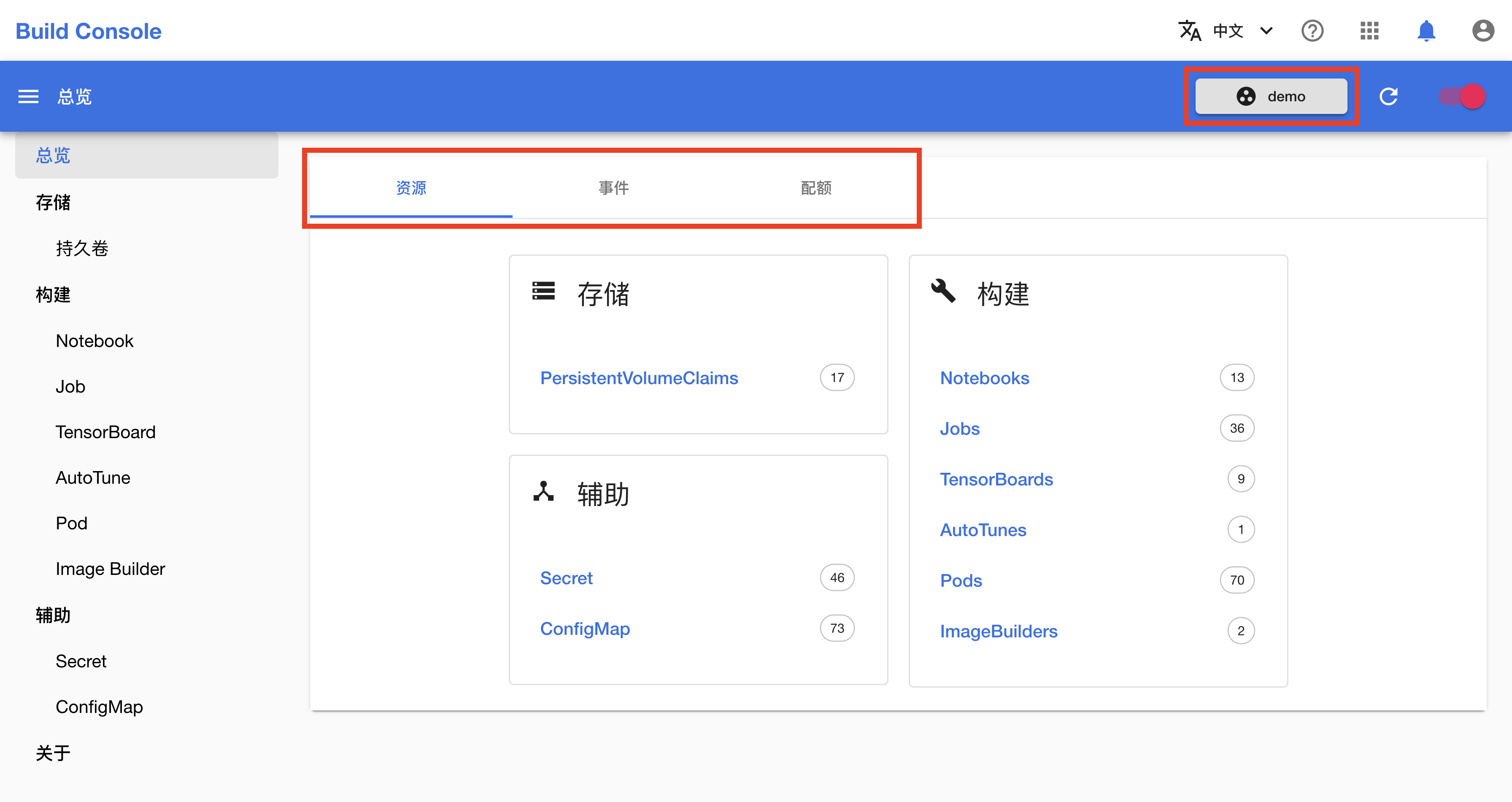

在 TensorStack AI 平台首页,点击模型构建进入构建控制台(Build Console)。

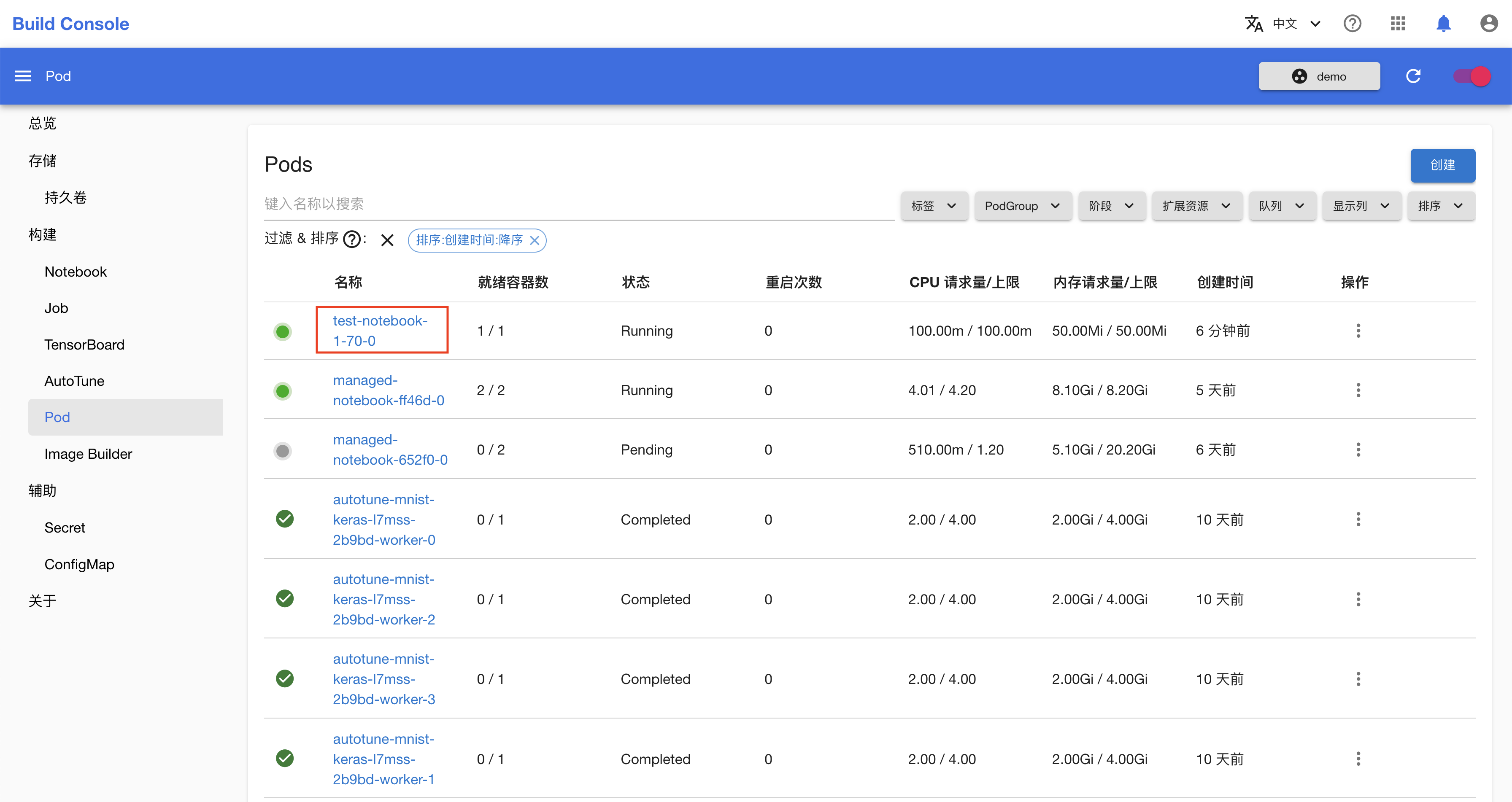

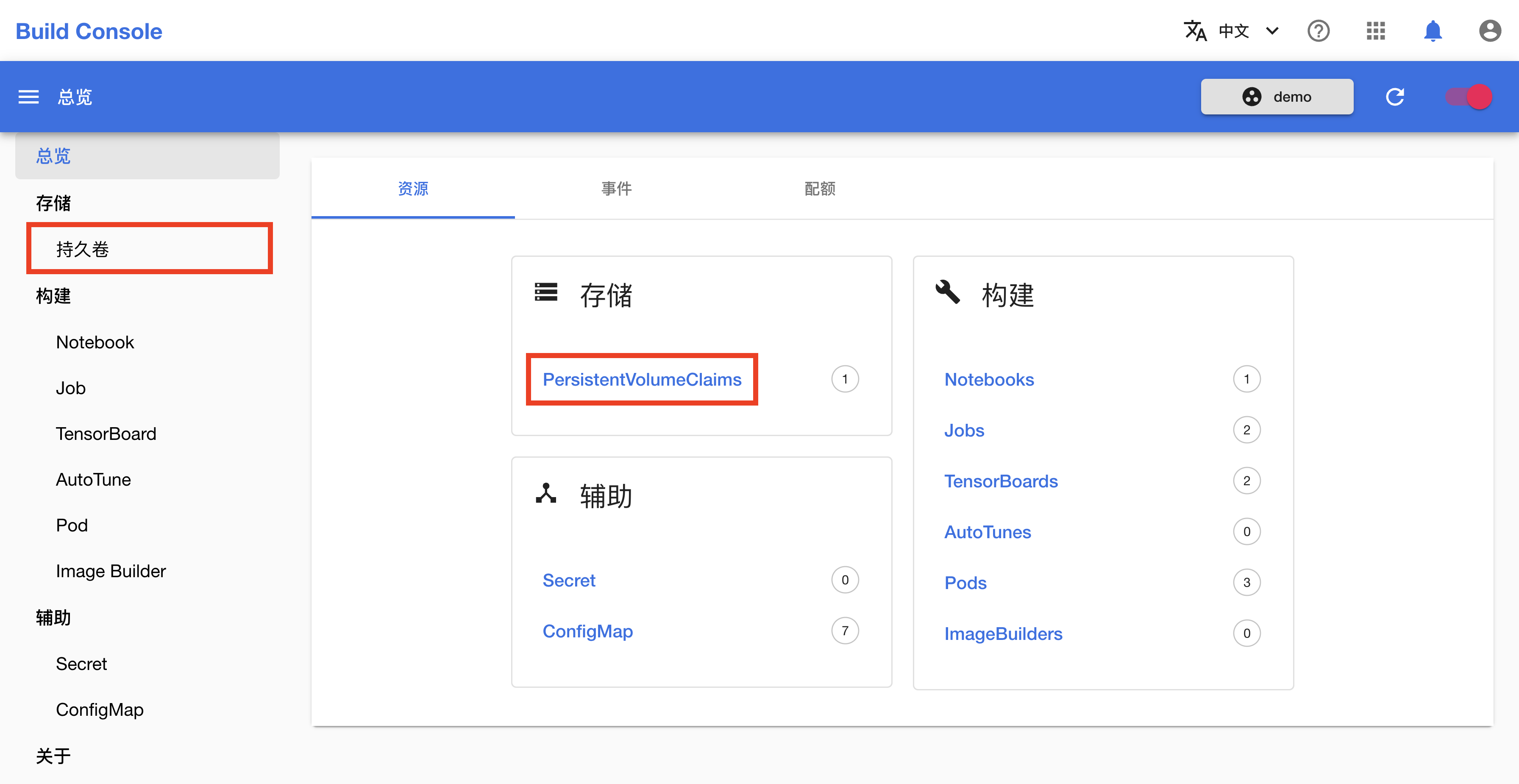

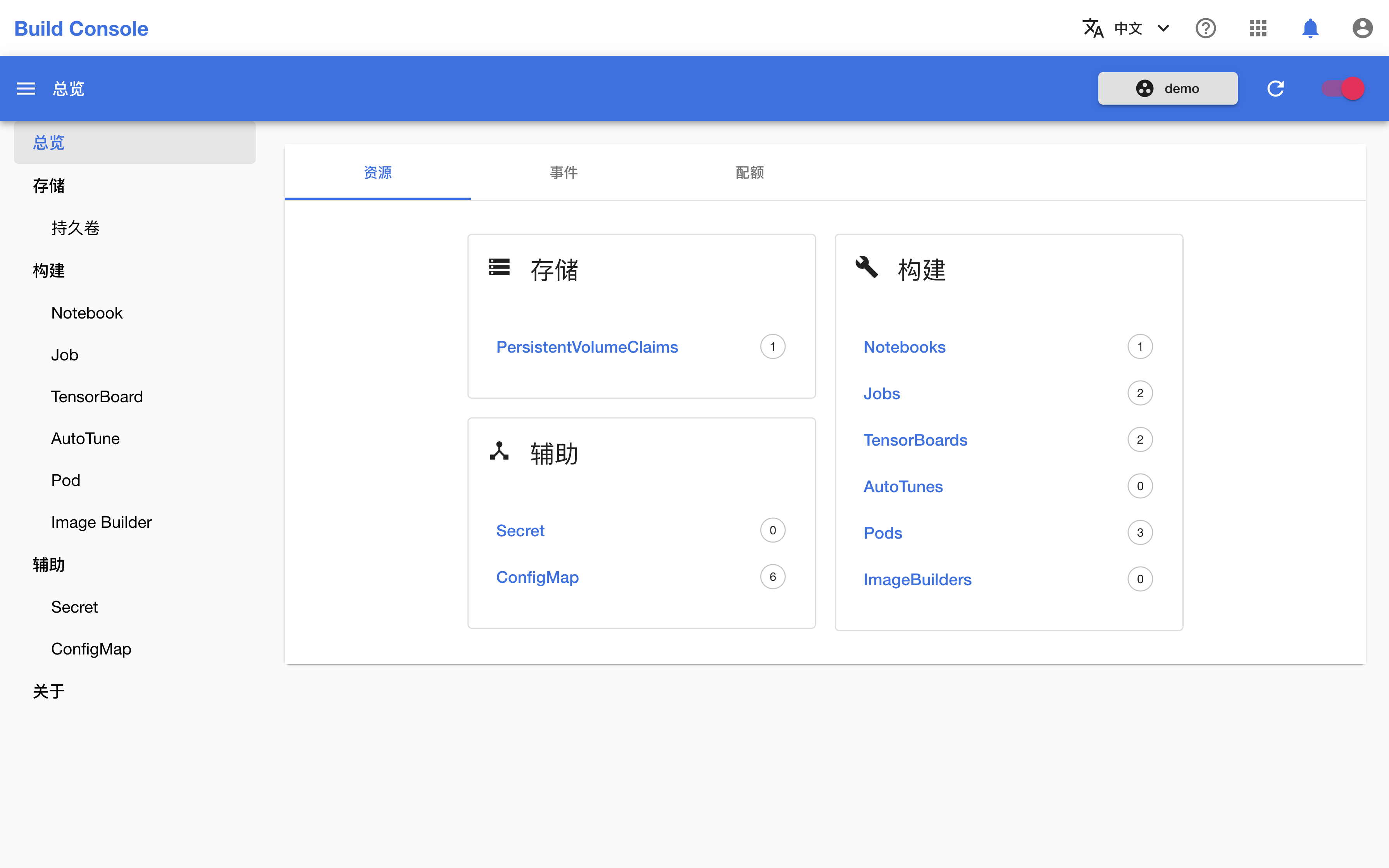

构建控制台(Build Console)的总览页面展示了多种 API 资源,你可以点击右上角的按钮切换 Project,也可以点击事件和配额标签页以查看当前 Project 最近发生的事件以及计算资源(CPU、内存、GPU 等)配额。

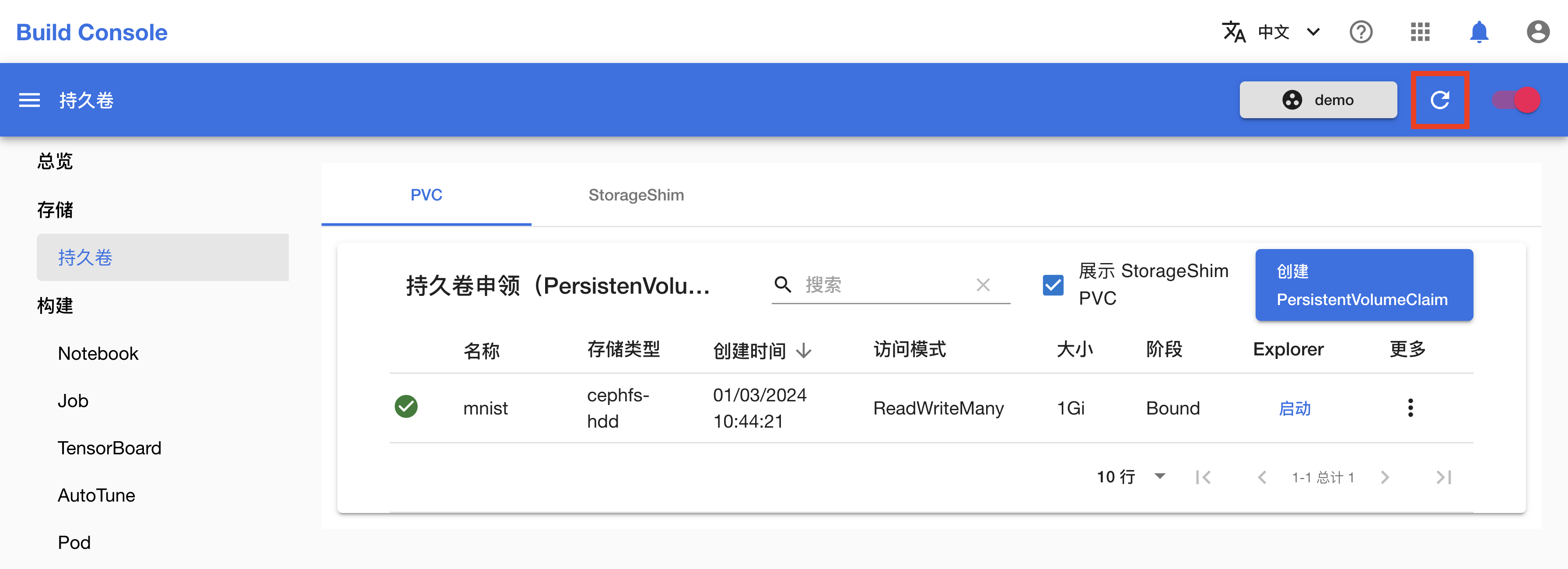

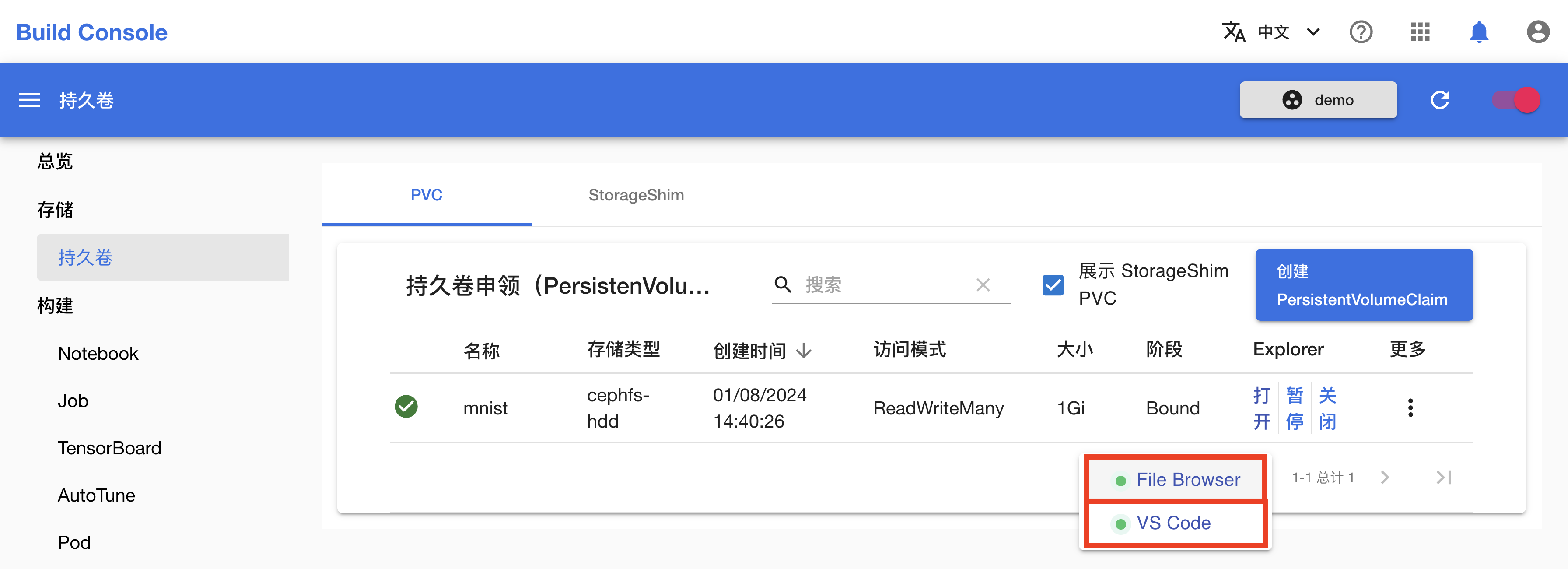

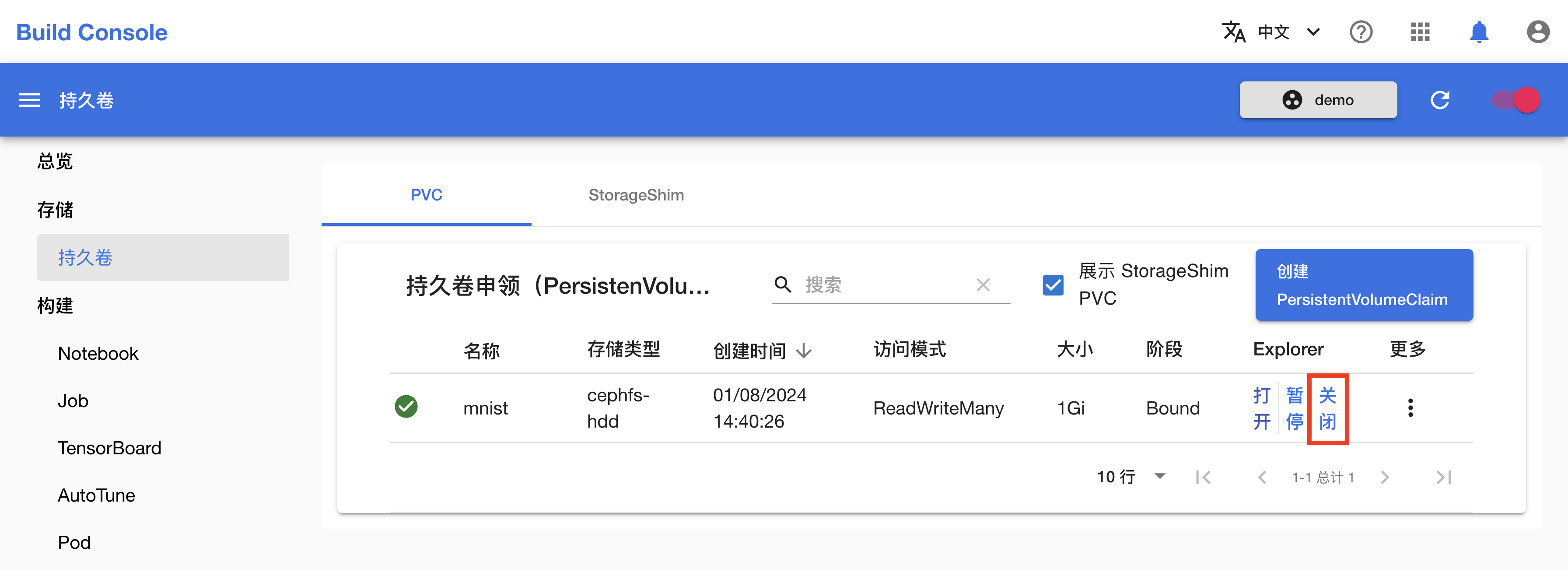

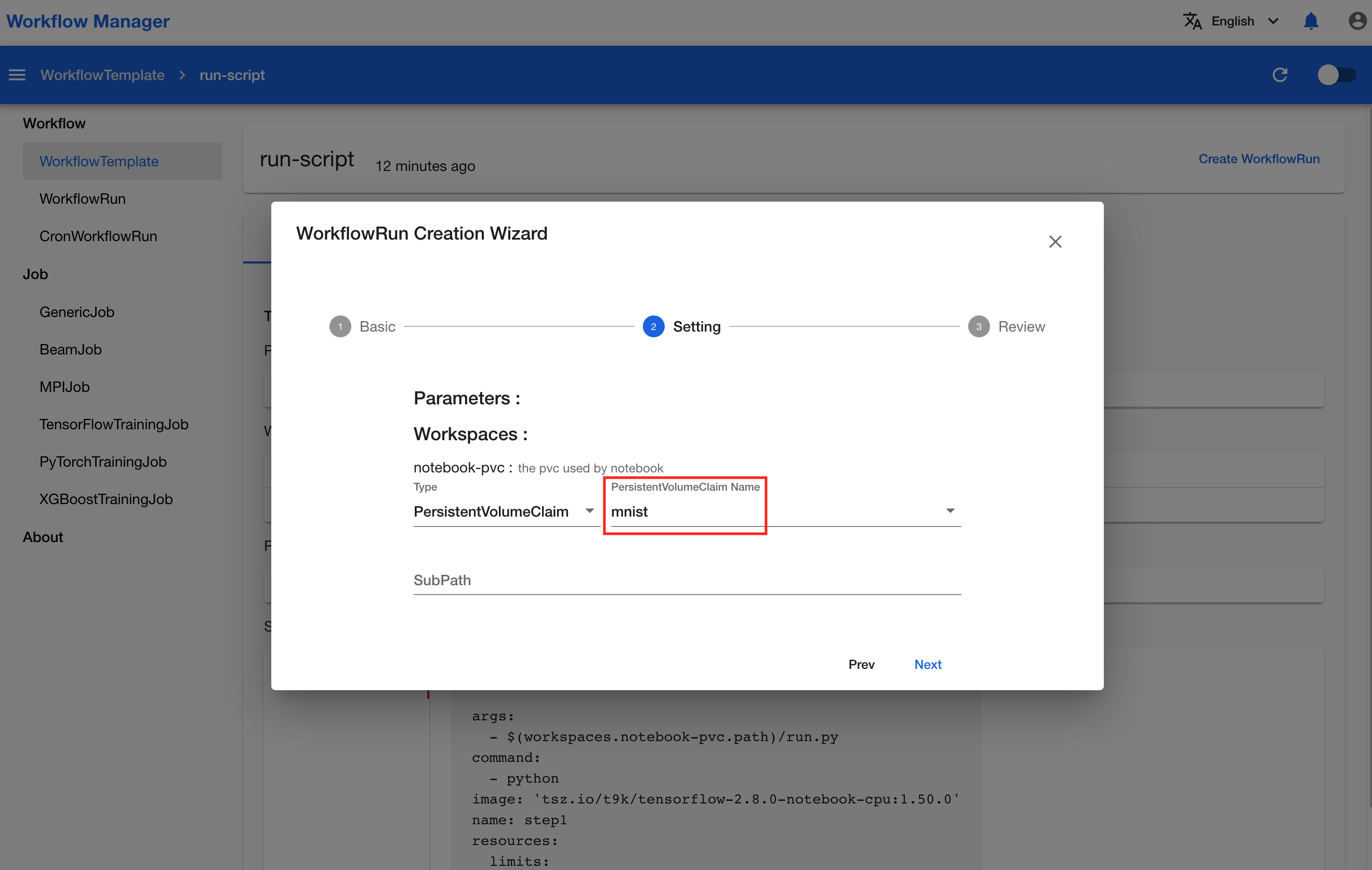

创建 PVC

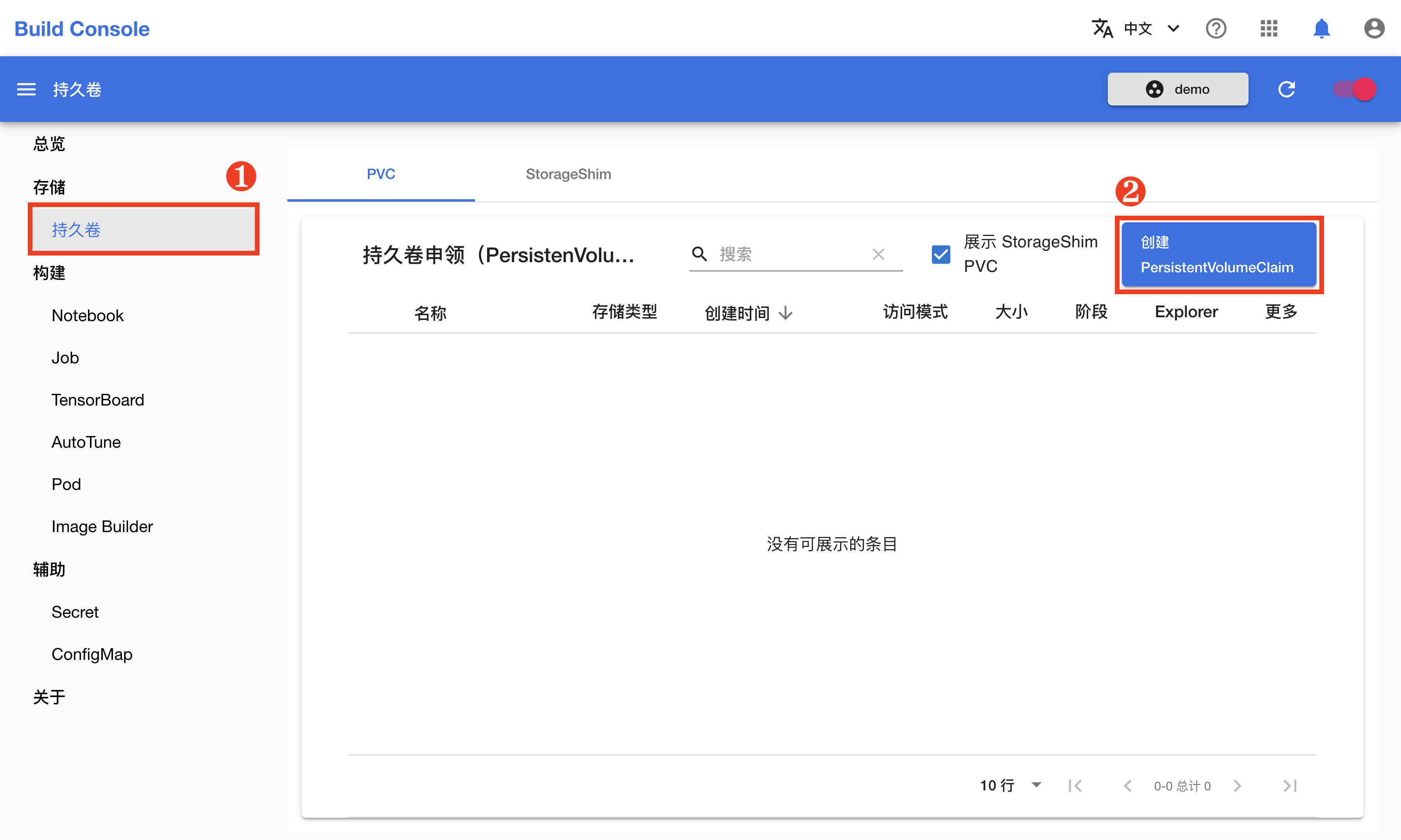

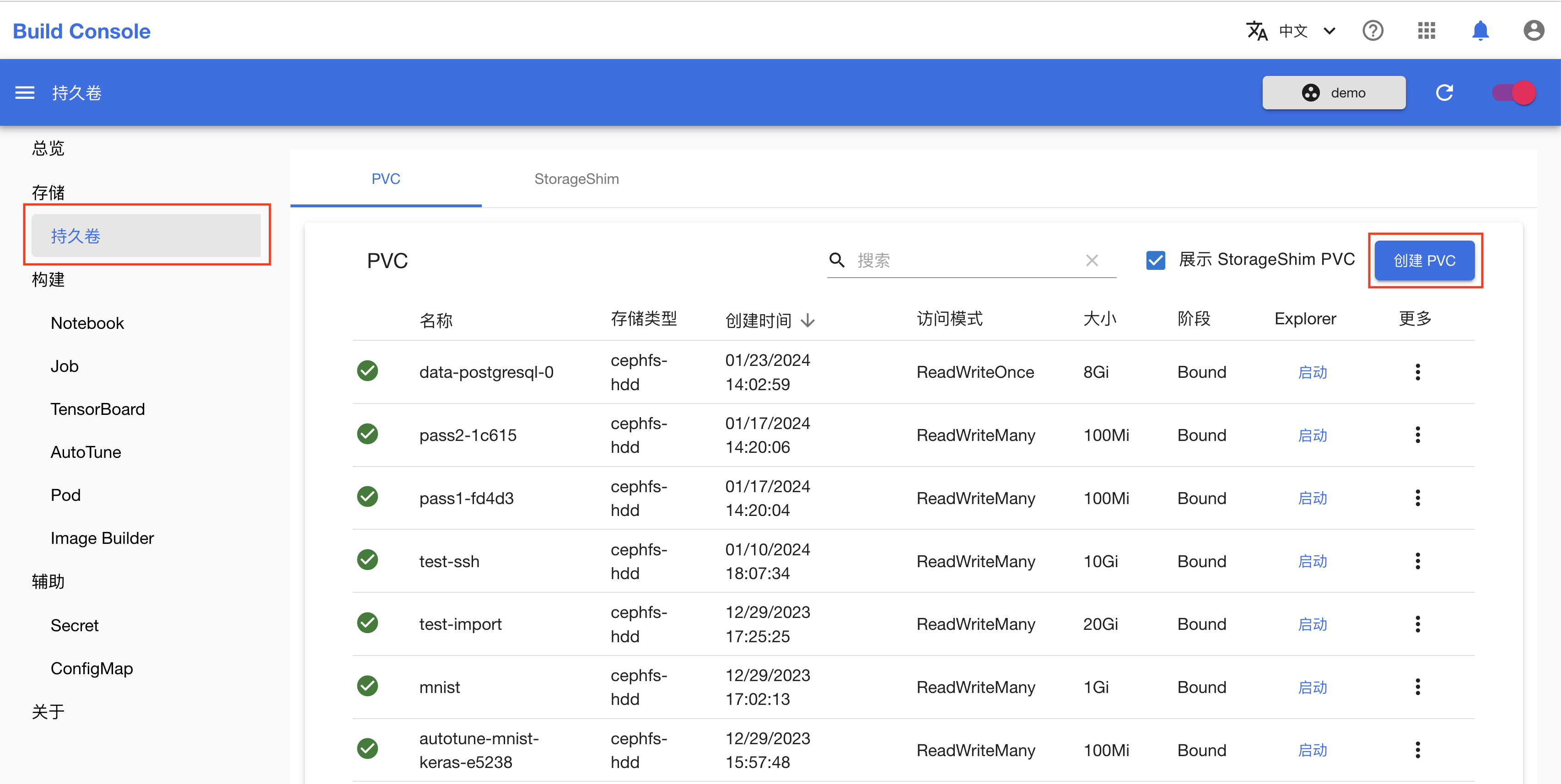

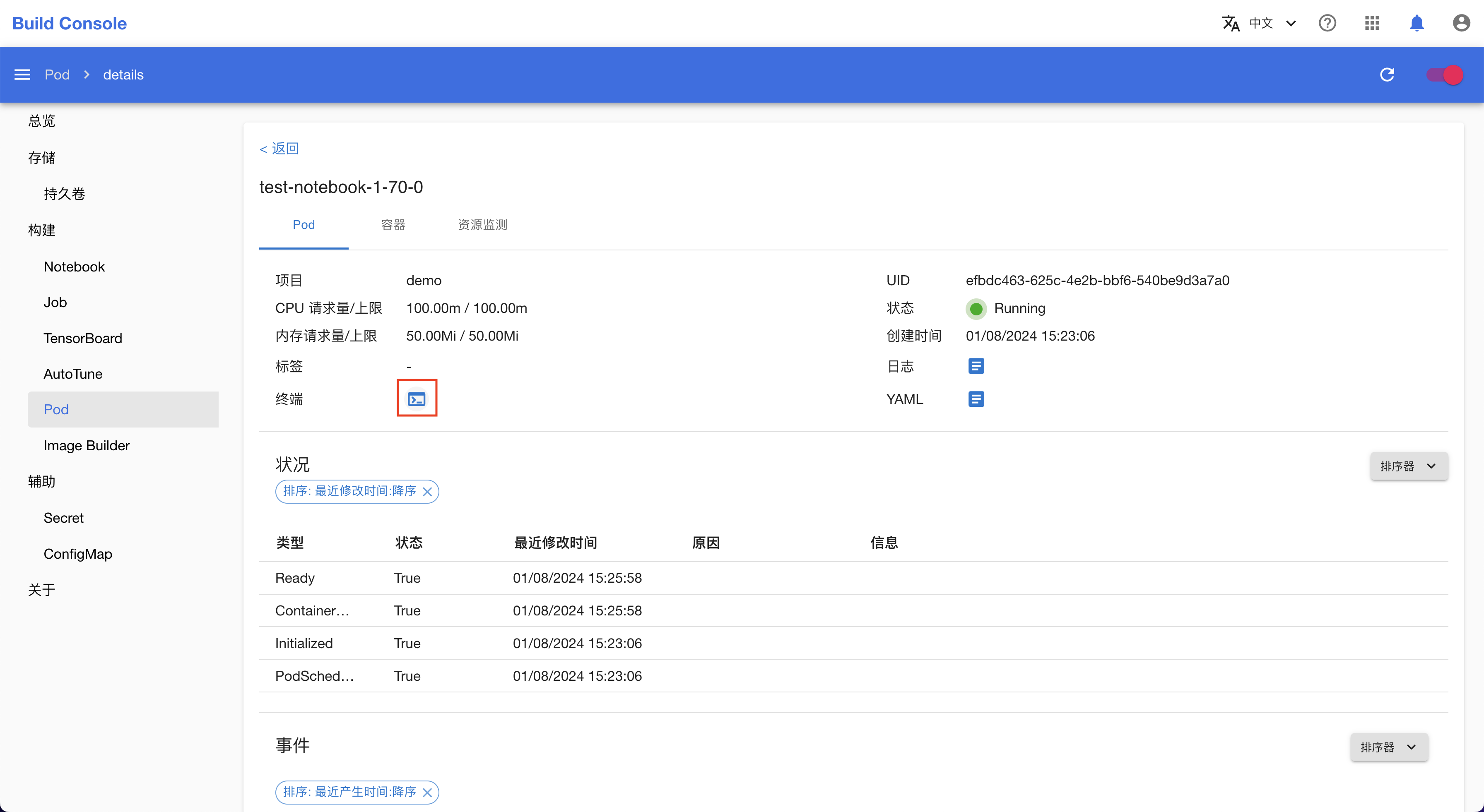

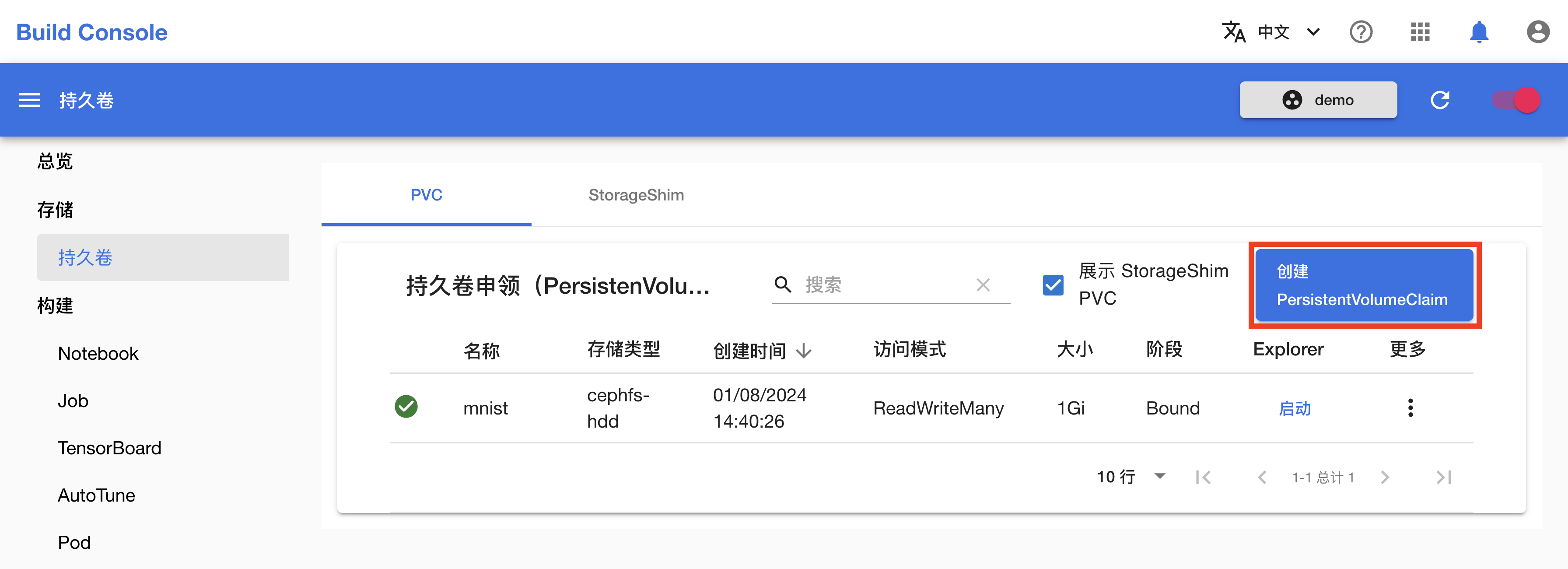

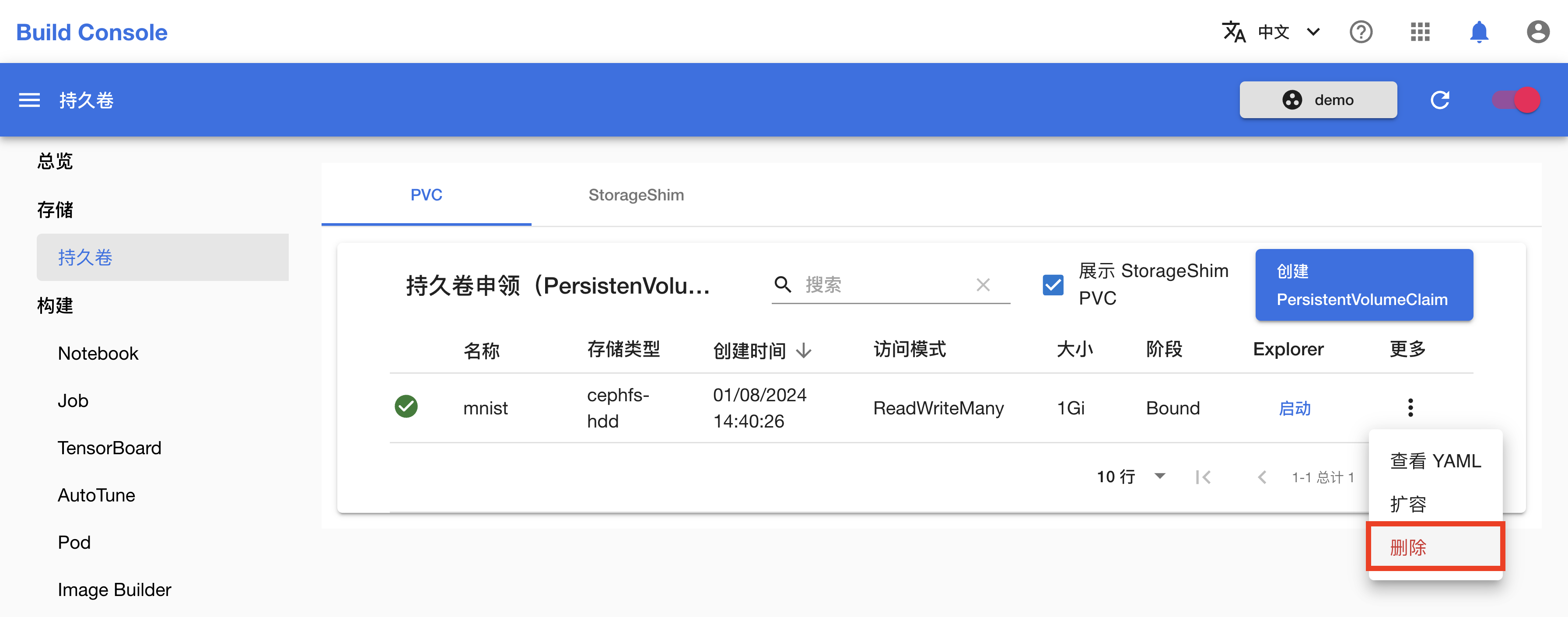

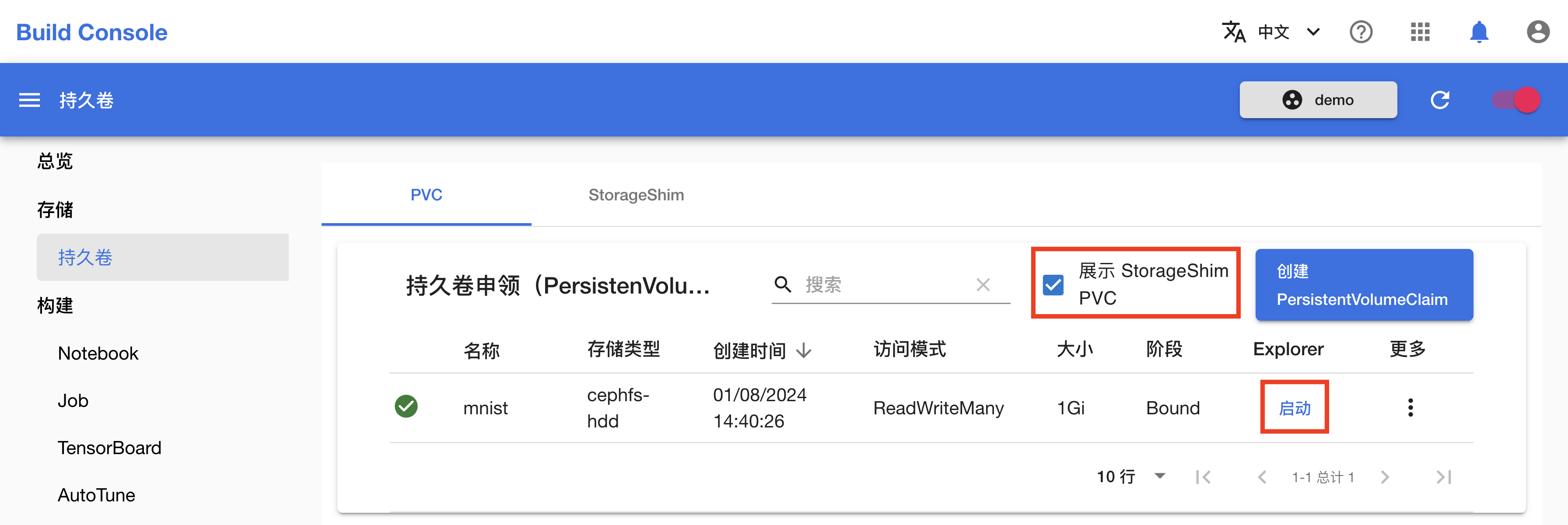

在创建 Notebook 之前,首先需要创建一个用于存储文件的 PVC(持久卷)。在左侧的导航菜单中点击存储 > 持久卷进入 PVC 管理页面,然后点击右上角的创建 PVC。

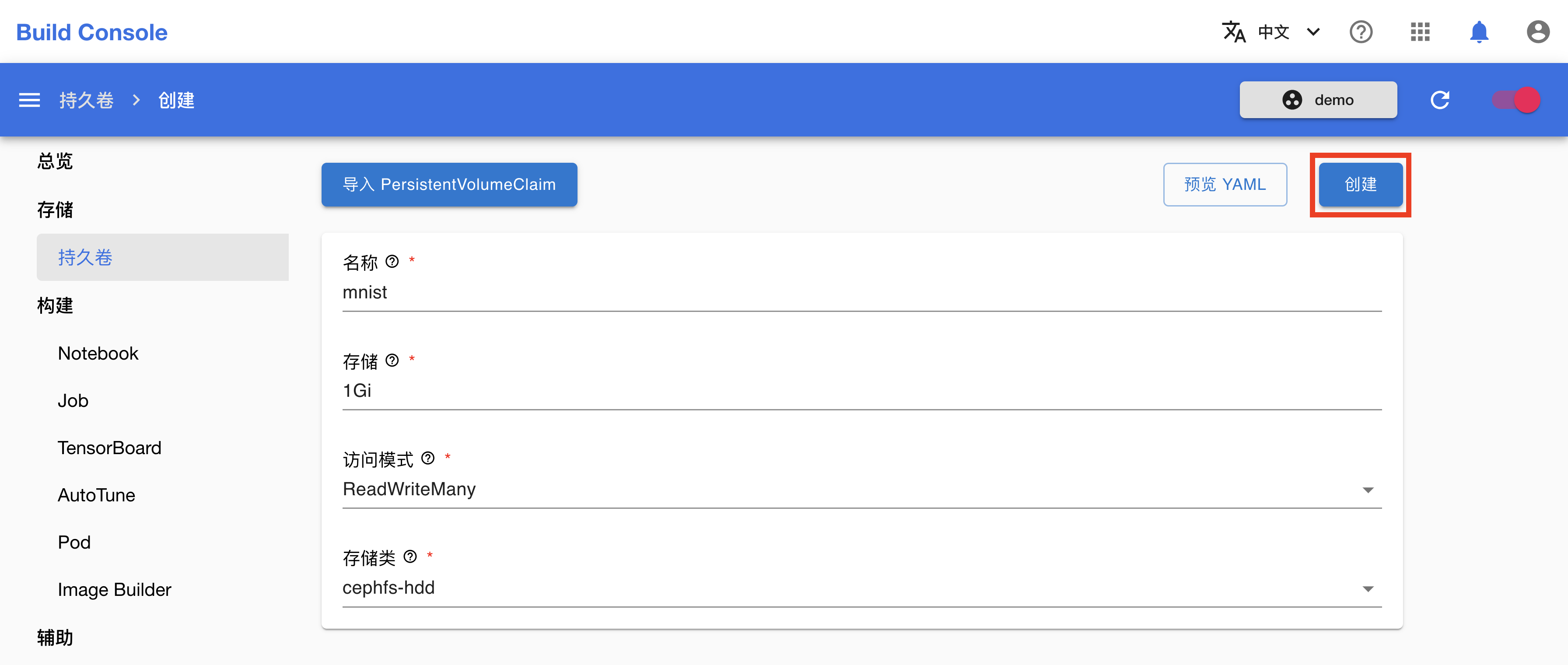

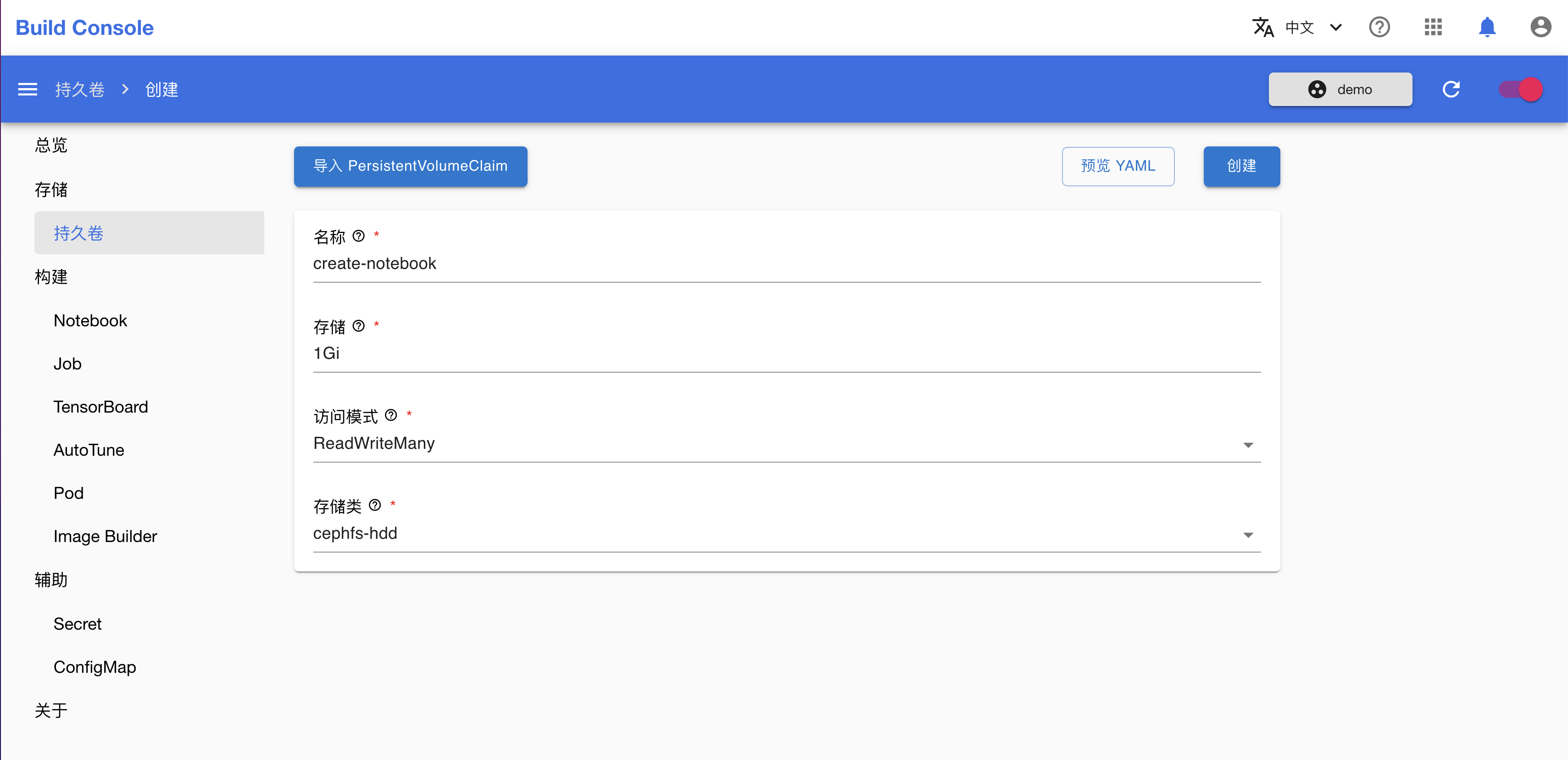

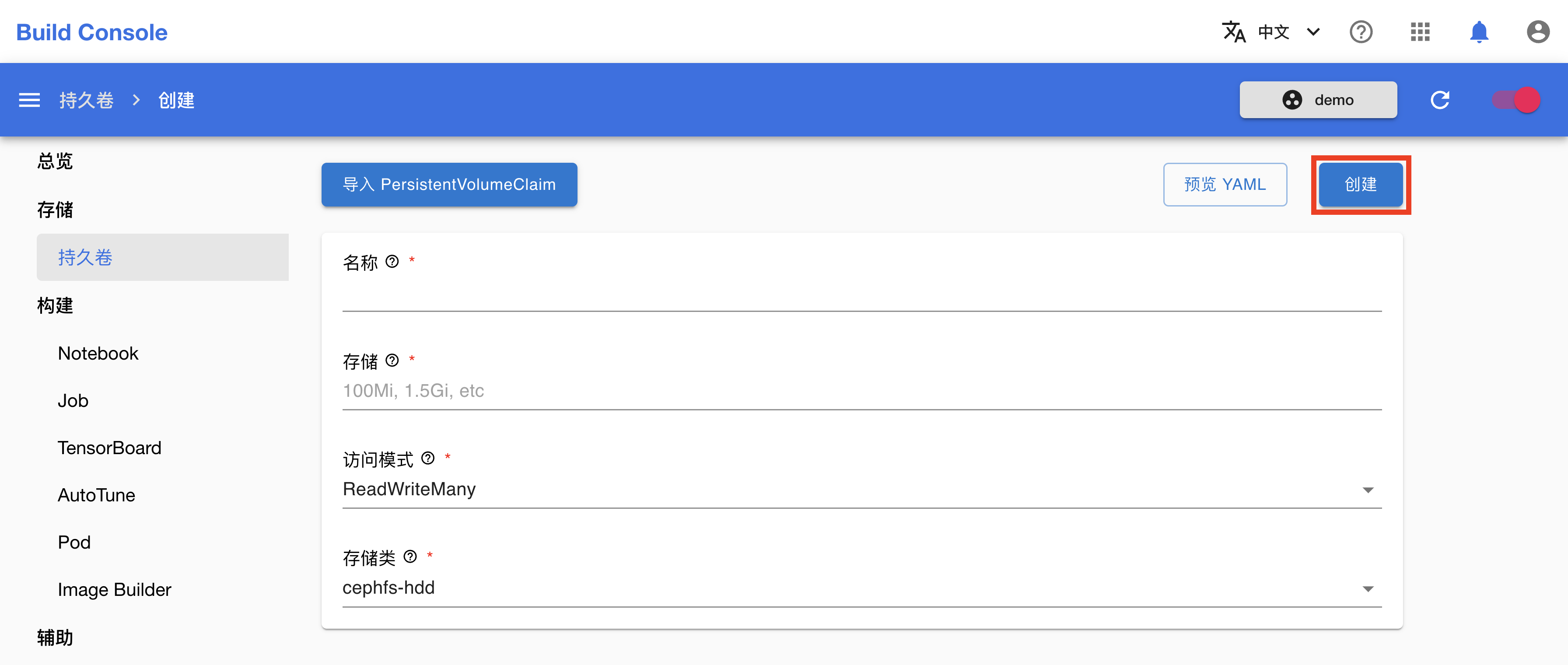

在 PVC 创建页面,如下填写各个参数:

- Name 填写

mnist。 - Size 填写

1Gi。

其他参数保持默认即可。完成之后,点击创建。

在跳转回到 PVC 管理页面之后,可点击右上角的刷新图标来手动刷新 PVC 状态。下图展示 PVC mnist 已经创建完成。

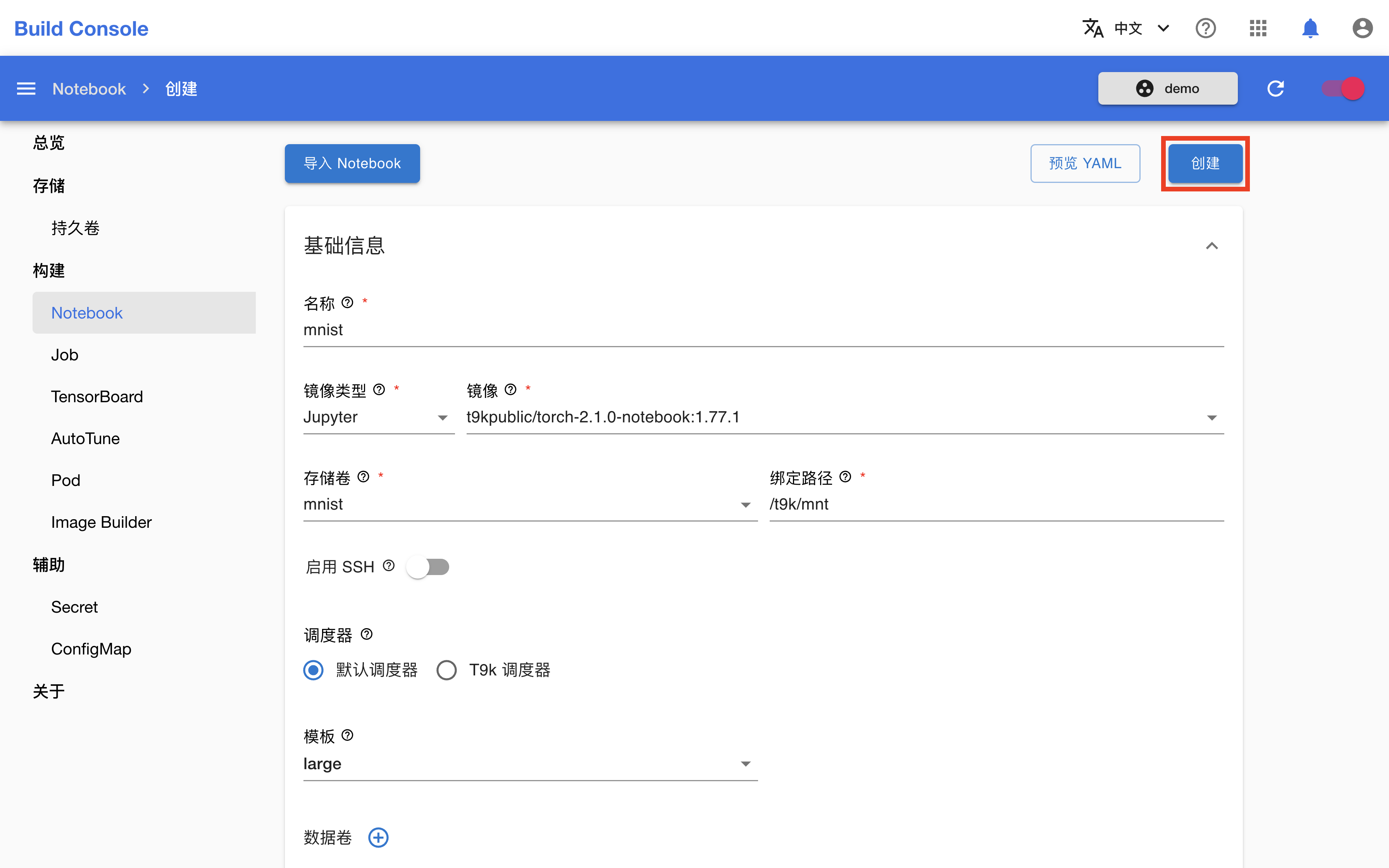

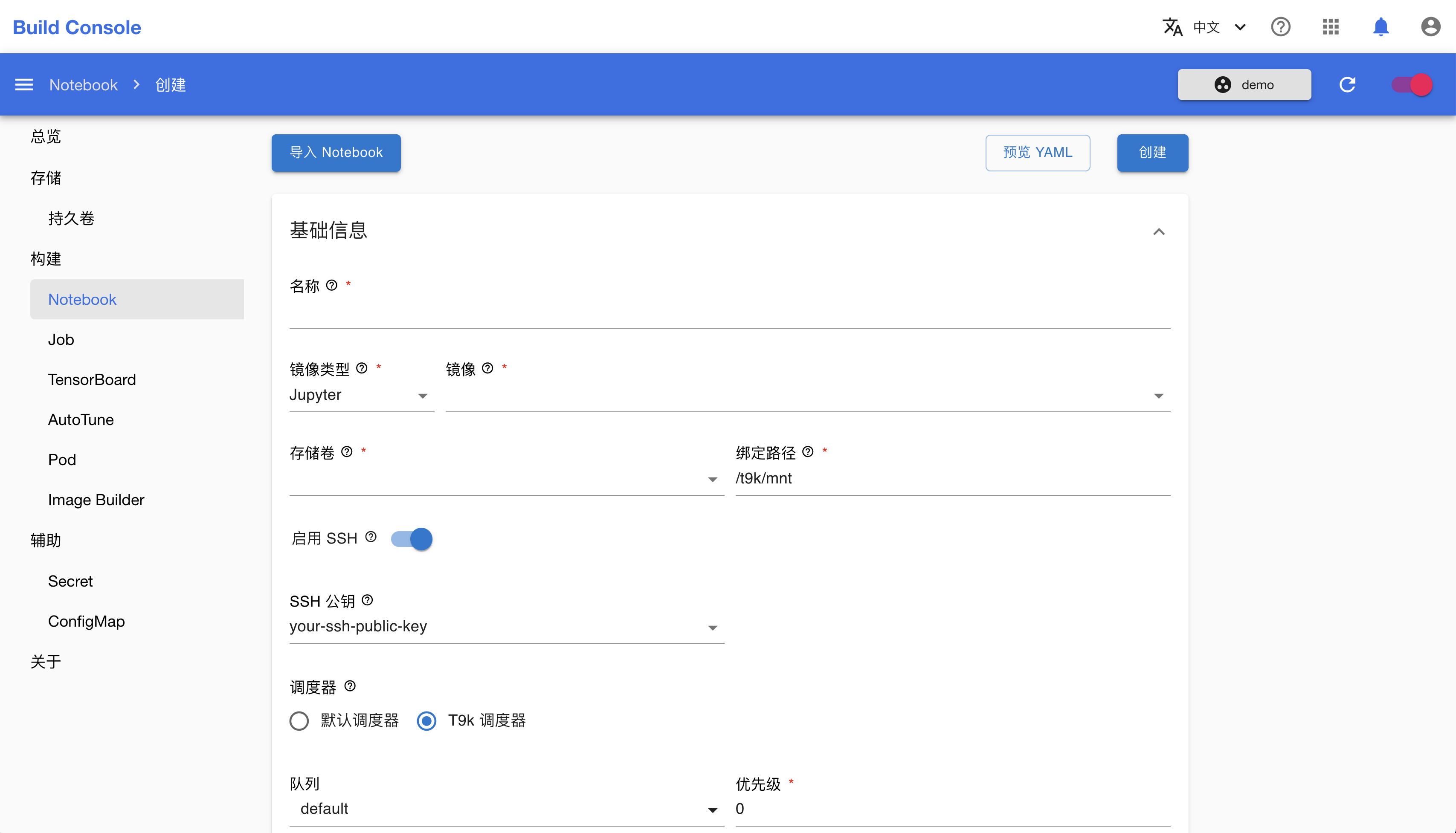

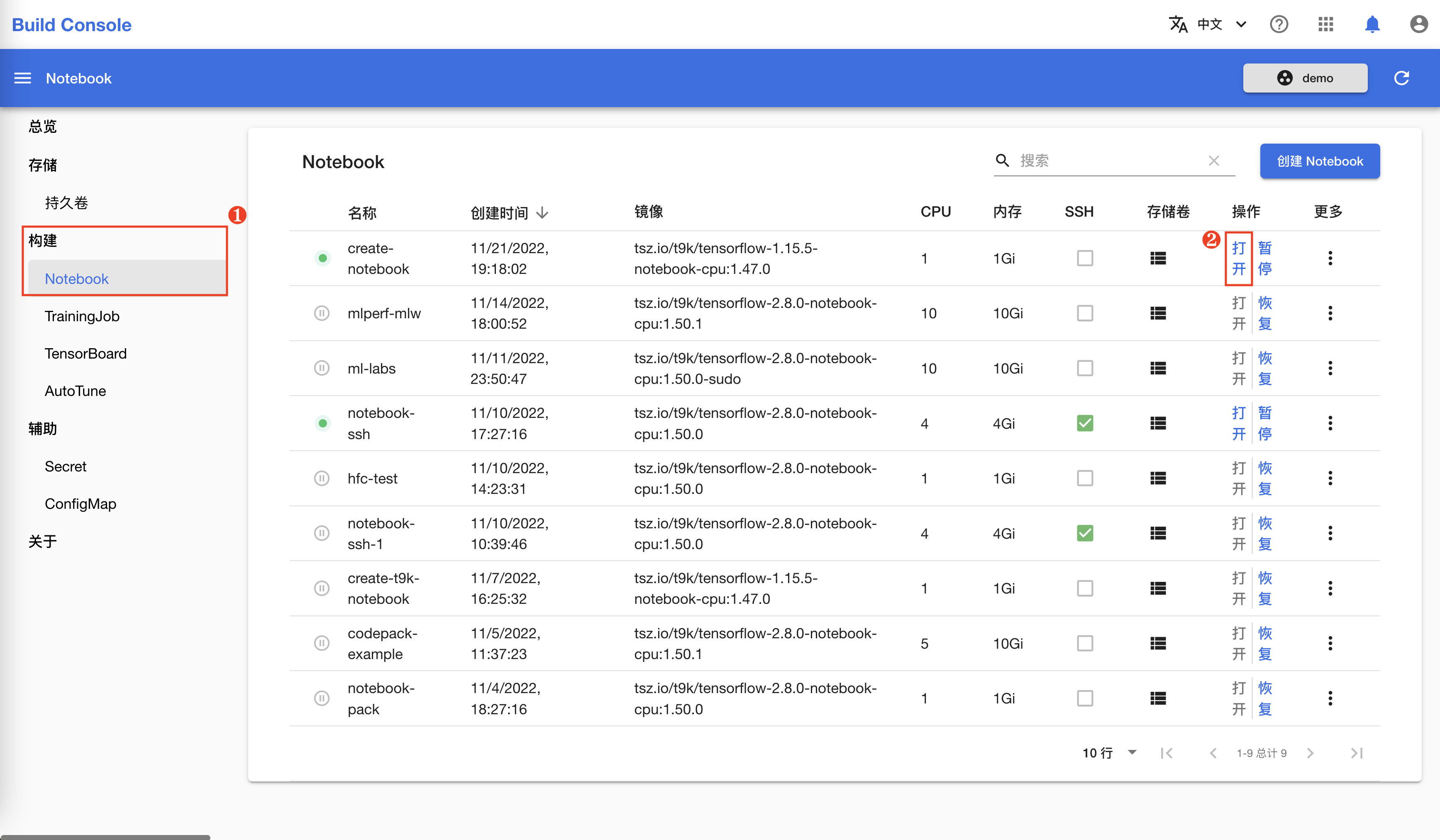

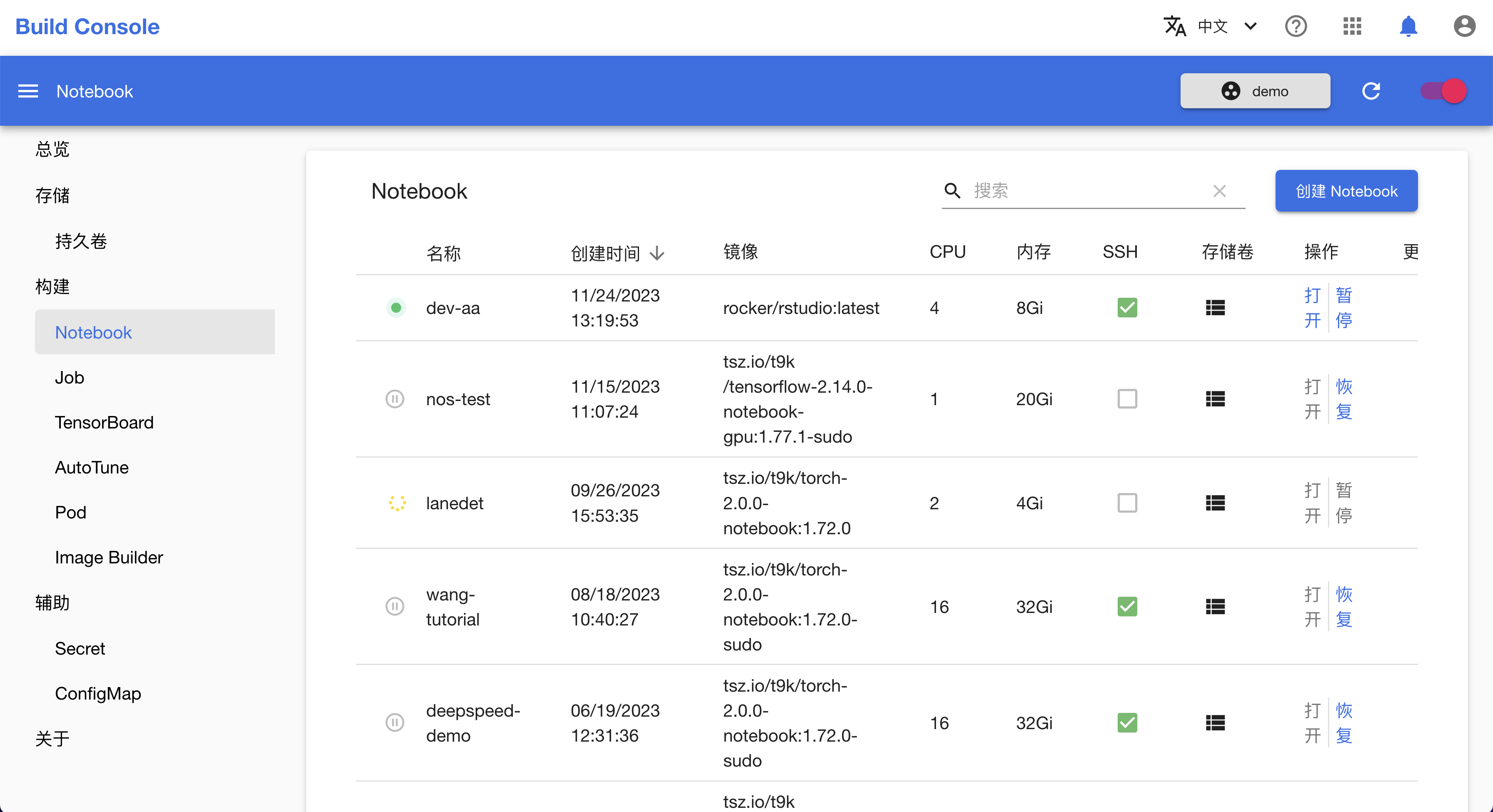

创建 Notebook

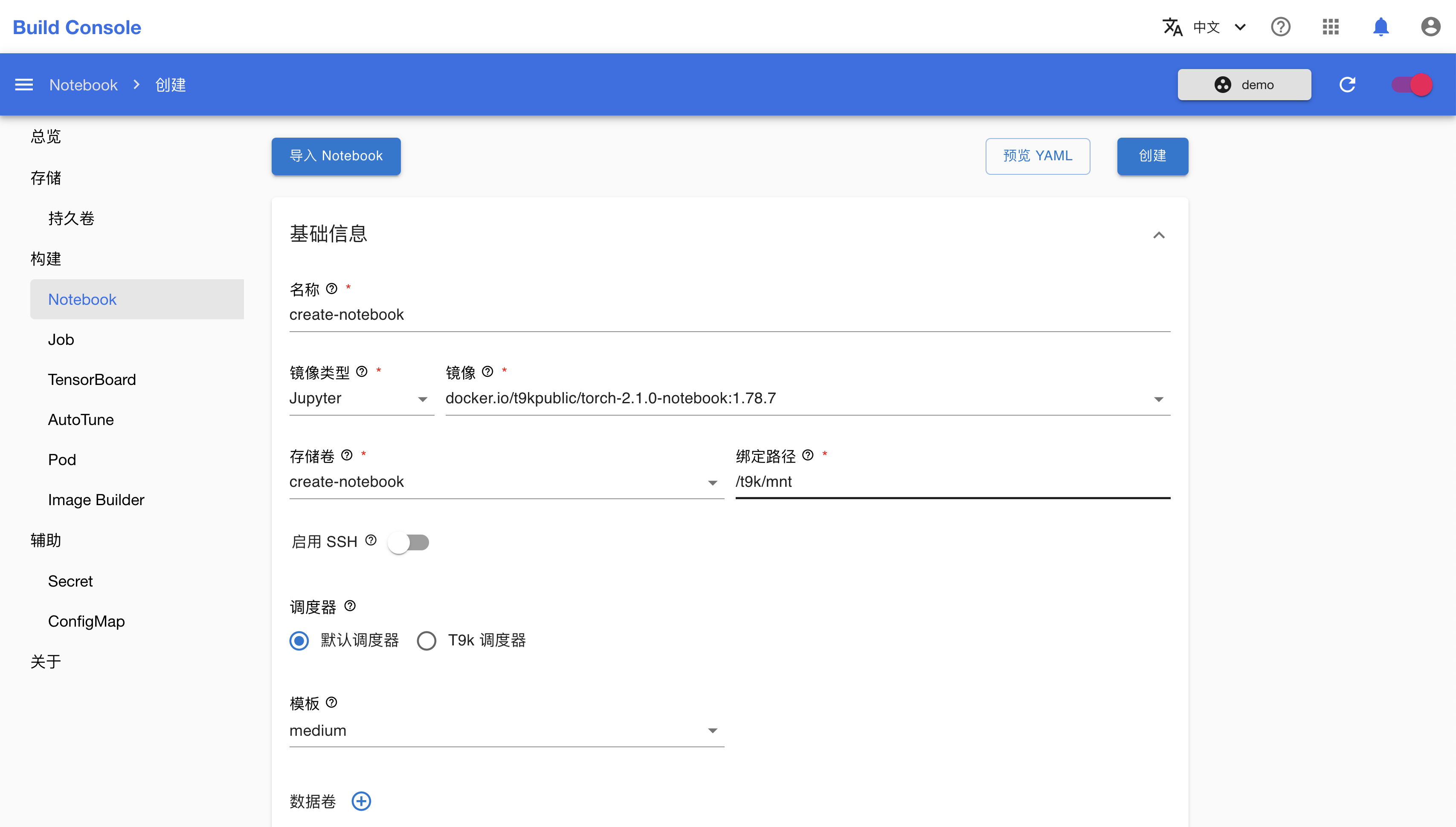

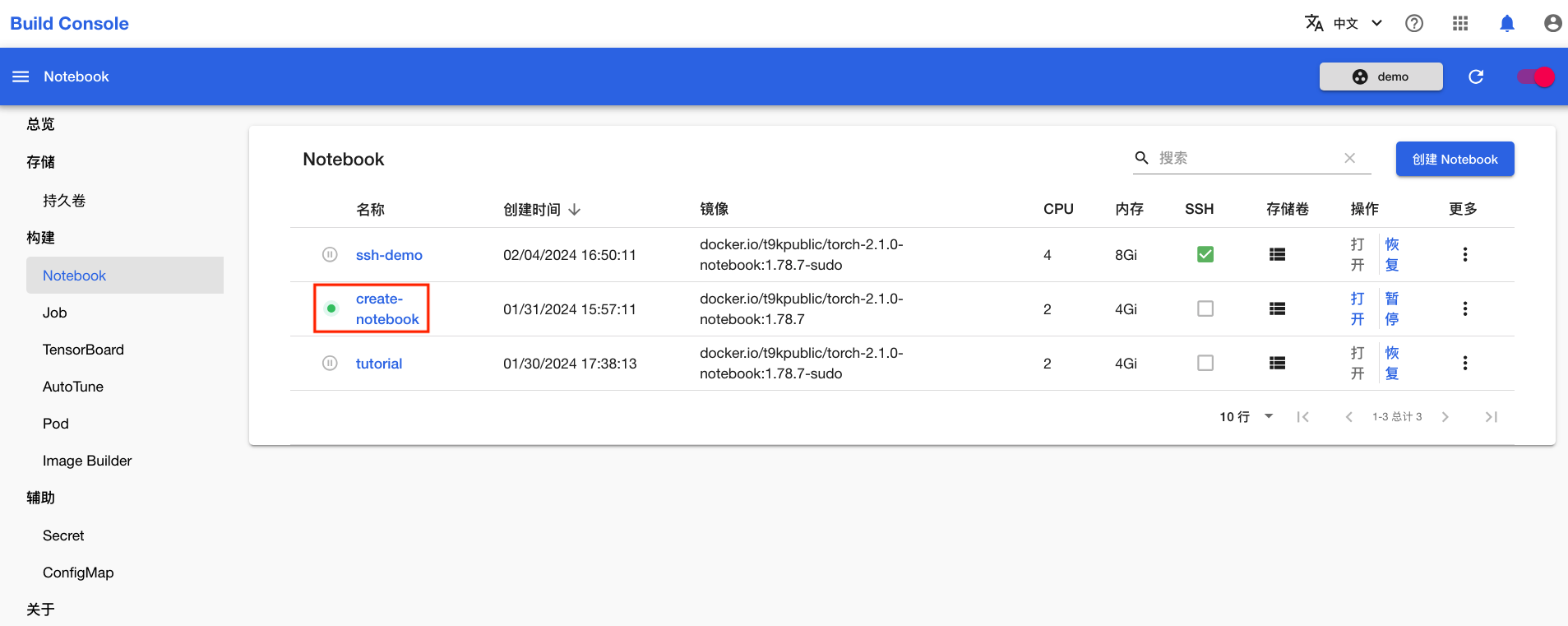

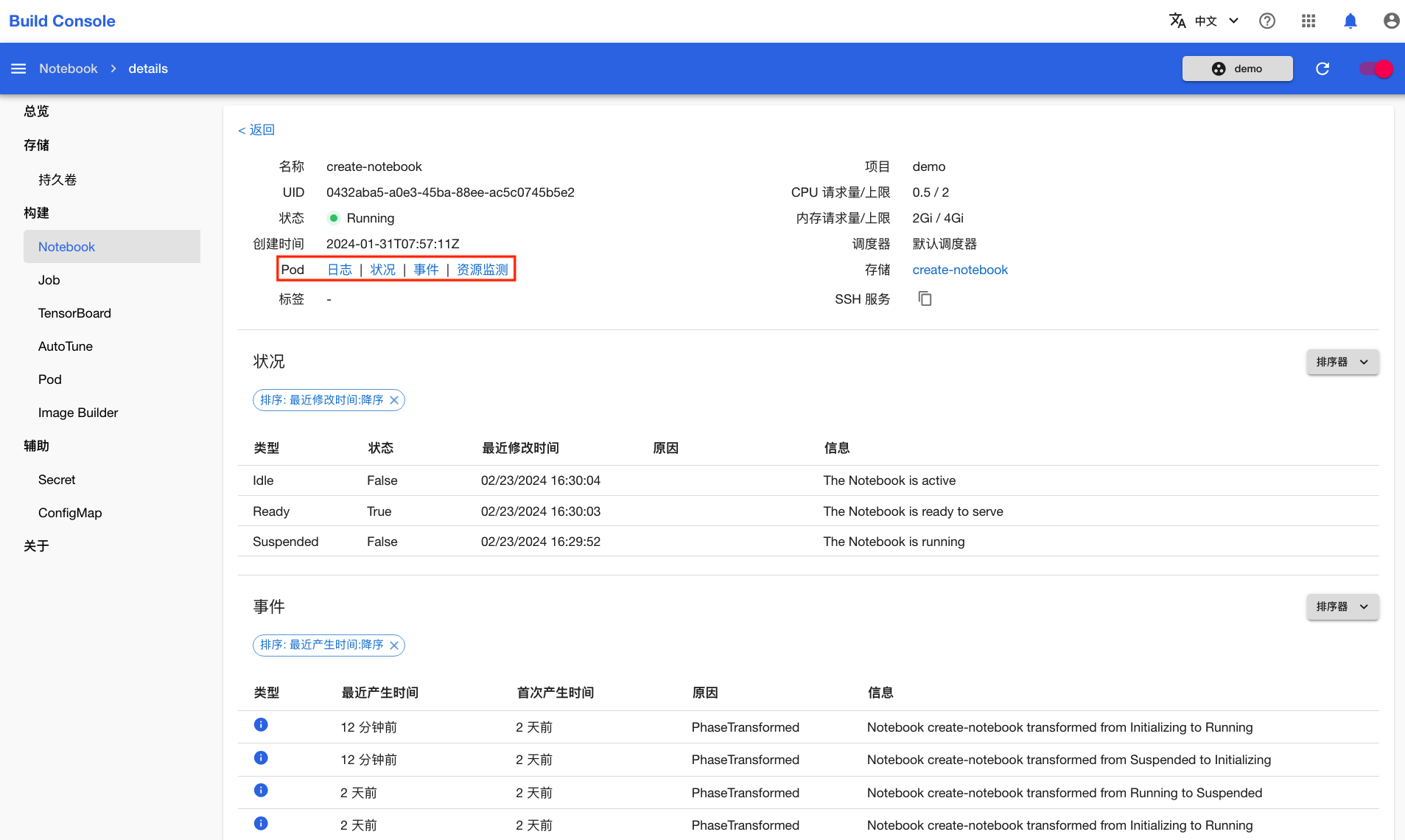

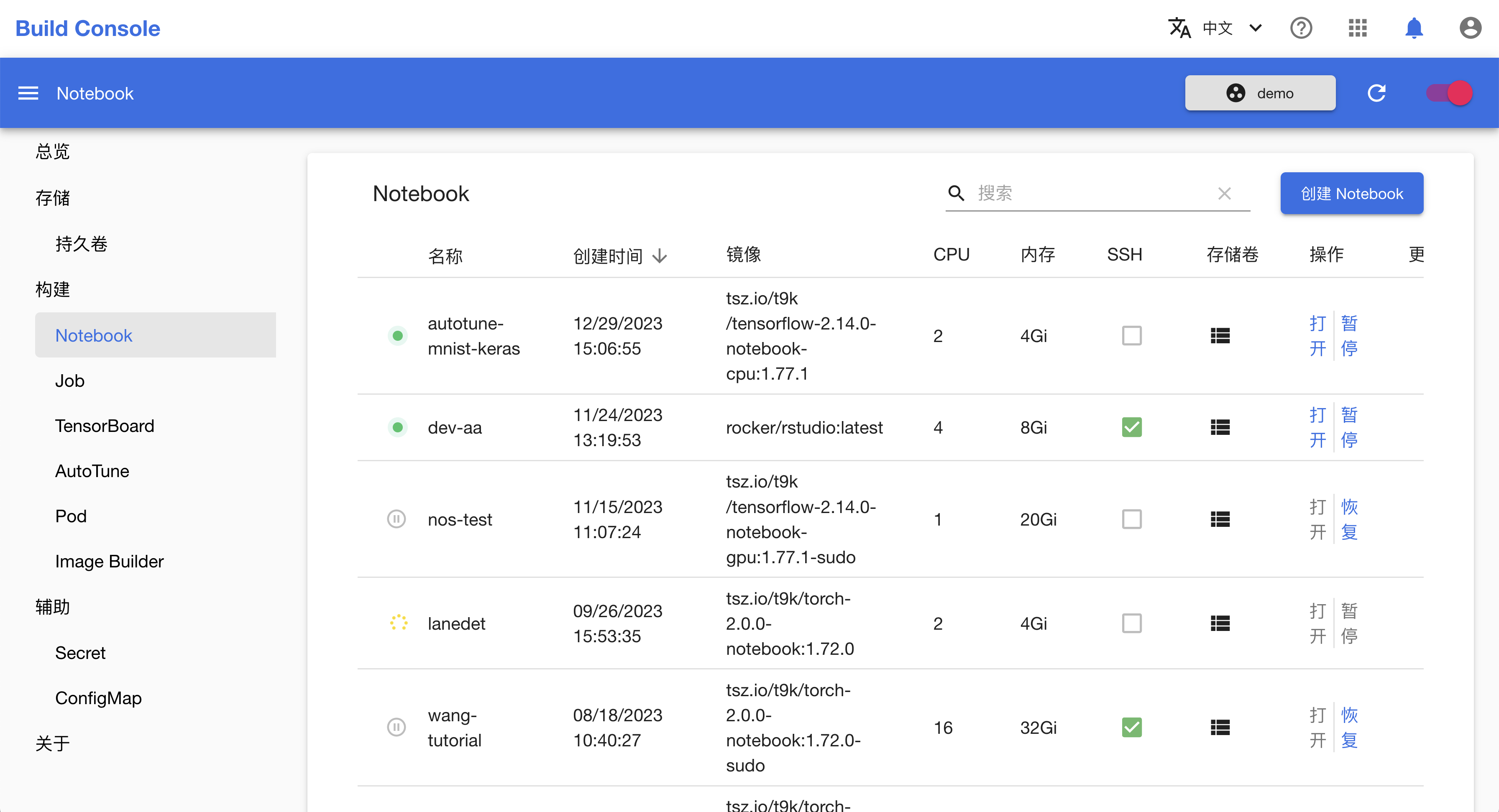

在左侧的导航菜单中点击构建 > Notebook 进入 Notebook 管理页面,然后点击右上角的创建 Notebook。

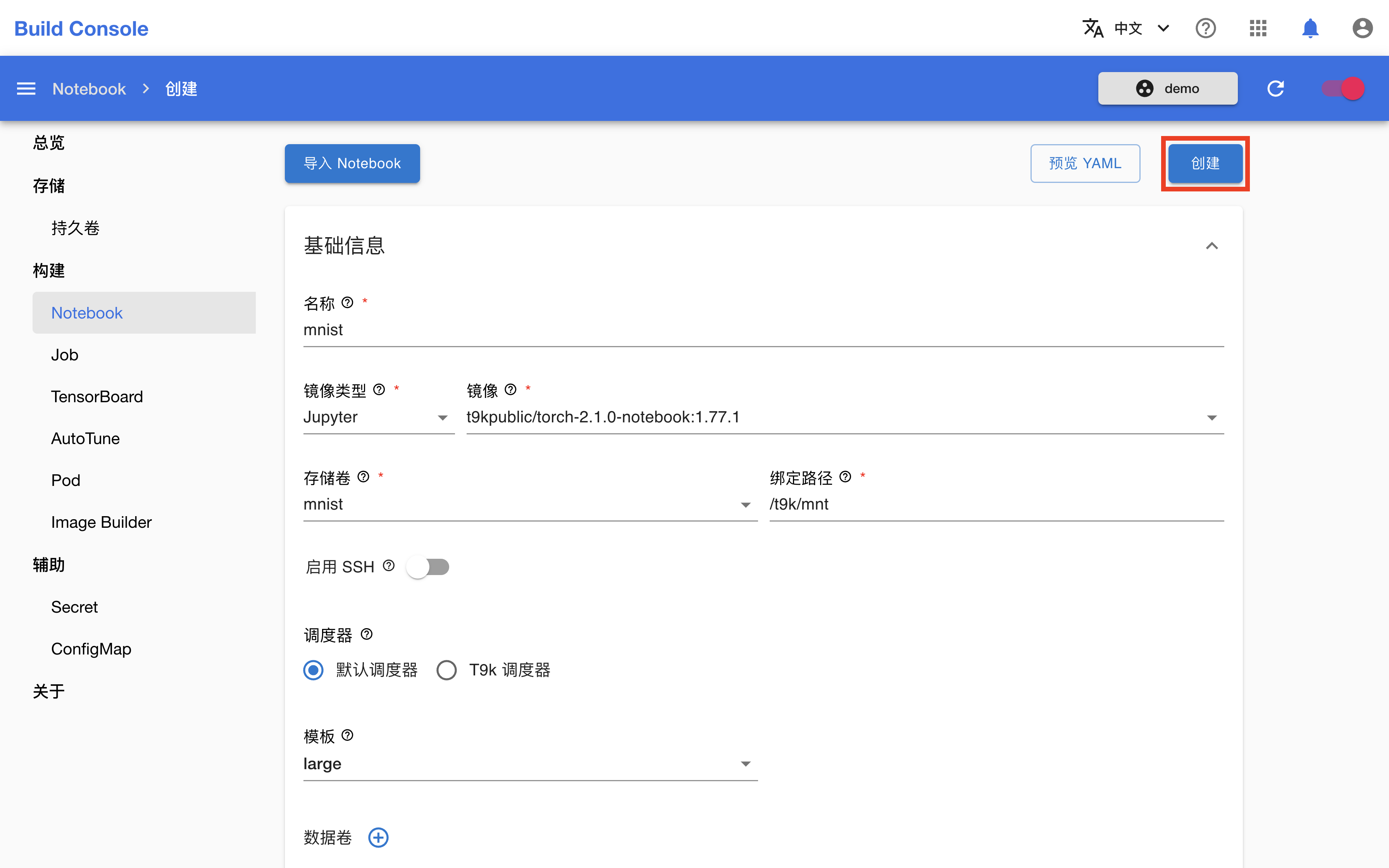

在 Notebook 创建页面,如下填写各个参数:

- 名称填写

mnist。 - 镜像类型选择

Jupyter,镜像选择t9kpublic/torch-2.1.0-notebook:1.77.1。 - 存储卷选择

mnist。 - 调度器选择默认调度器,模板选择 large。

完成之后,点击创建。

在跳转回到 Notebook 管理页面之后,等待刚才创建的 Notebook 准备就绪。第一次拉取镜像可能会花费较长的时间,具体取决于集群的网络状况。点击右上角的刷新图标以手动刷新 Notebook 状态,待 Notebook 开始运行之后,点击右侧的打开进入其前端页面。

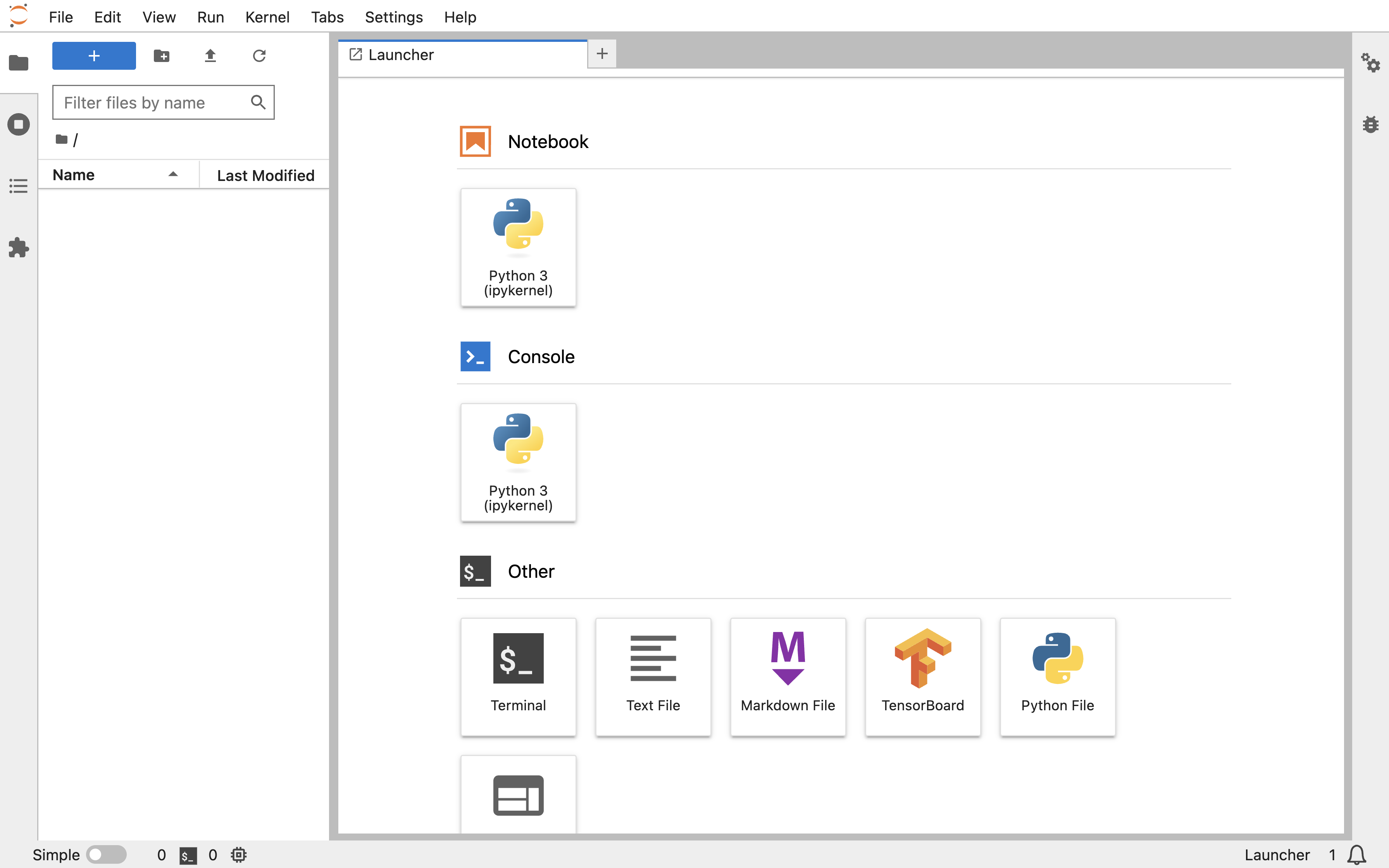

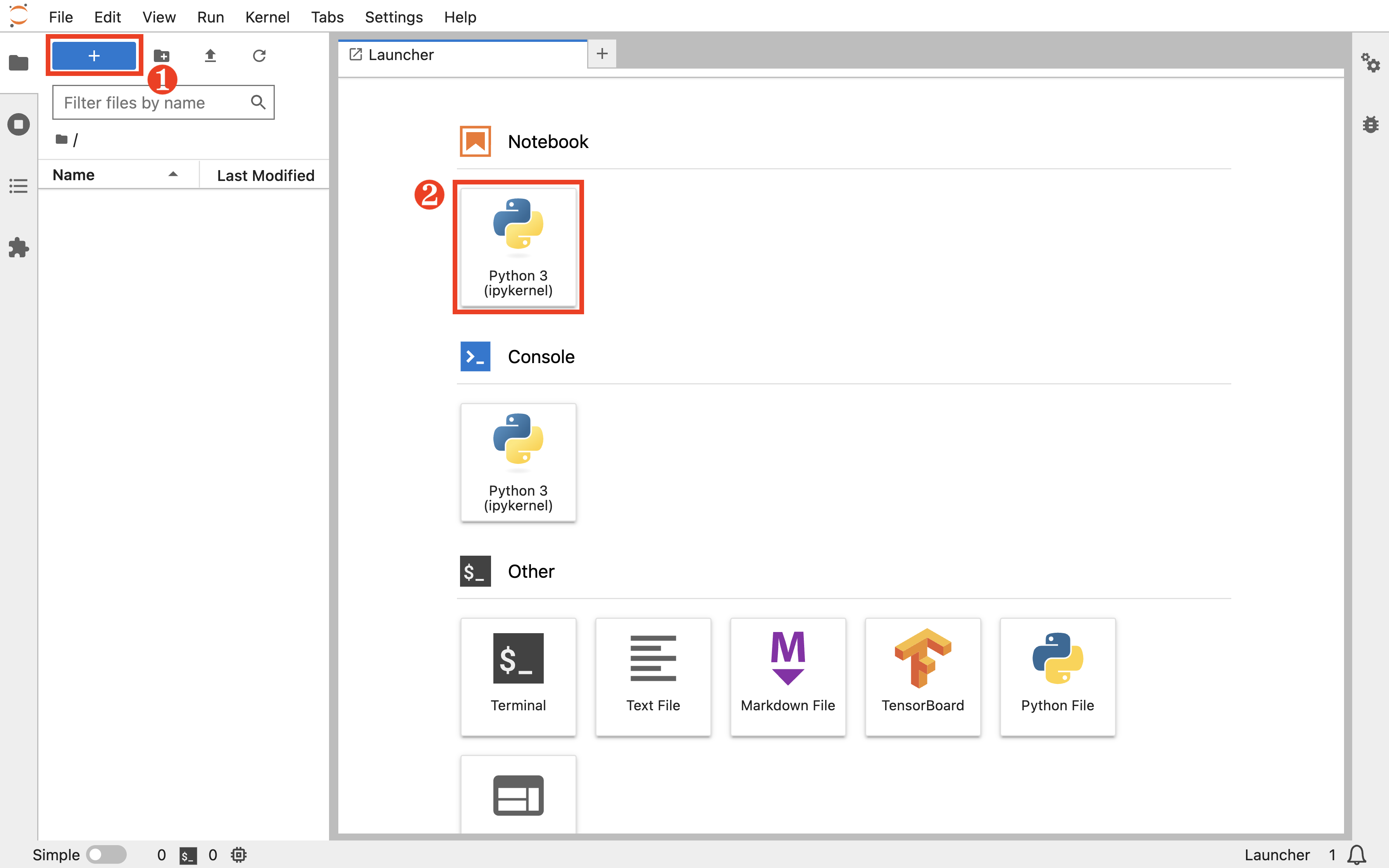

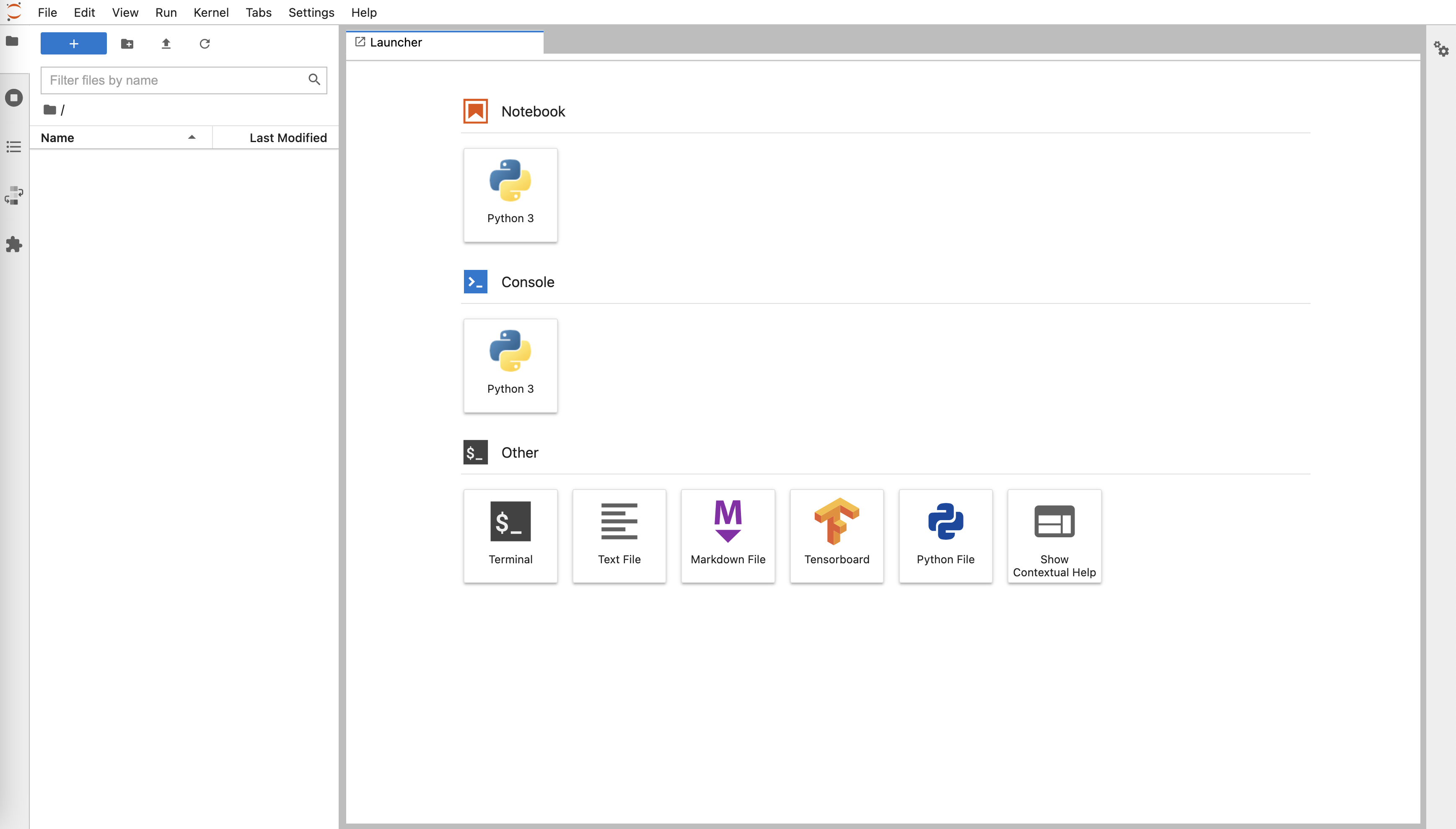

现在 Notebook 已经可以使用了,你可以在这里进行模型的开发与测试。

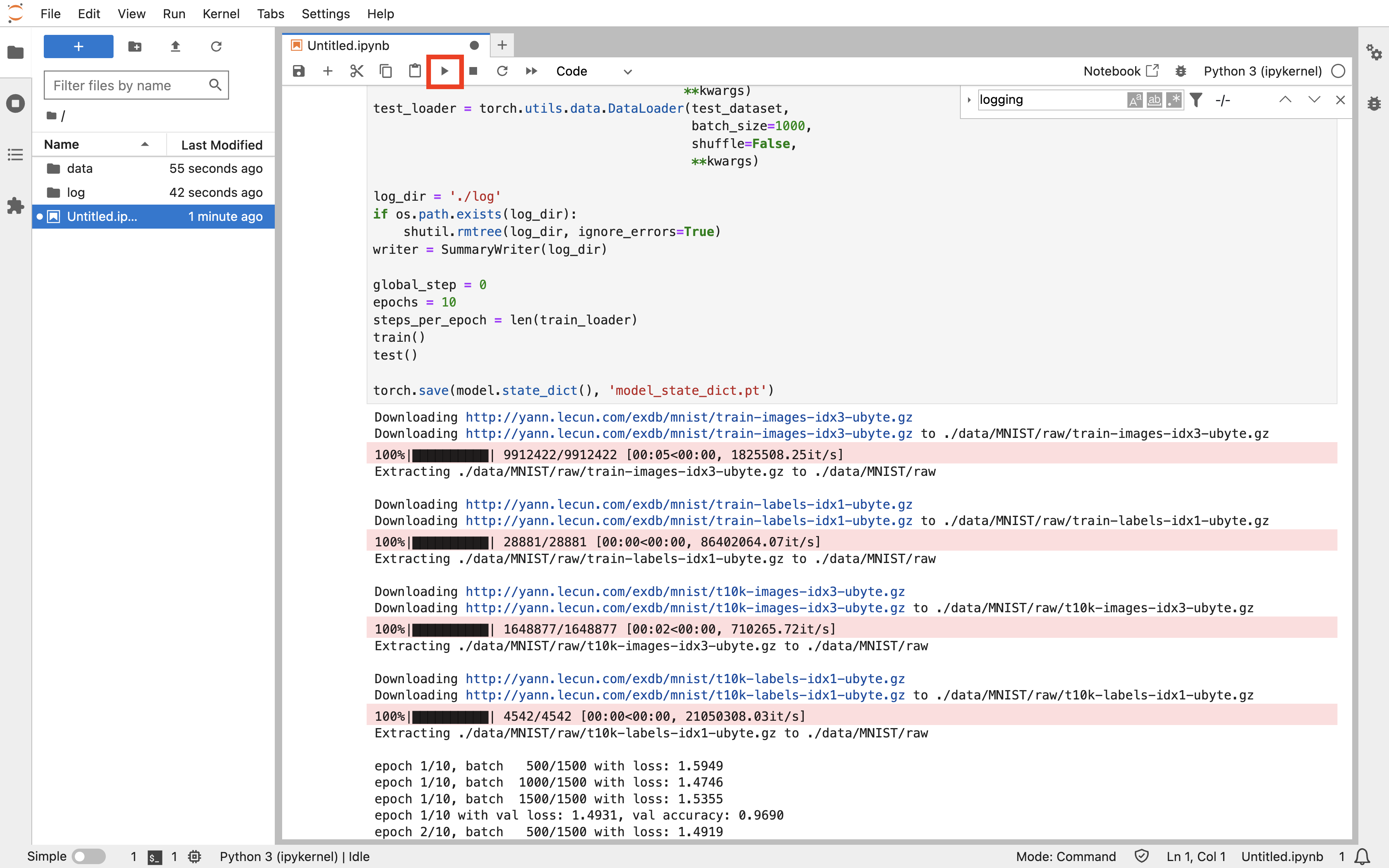

使用 Notebook 训练模型

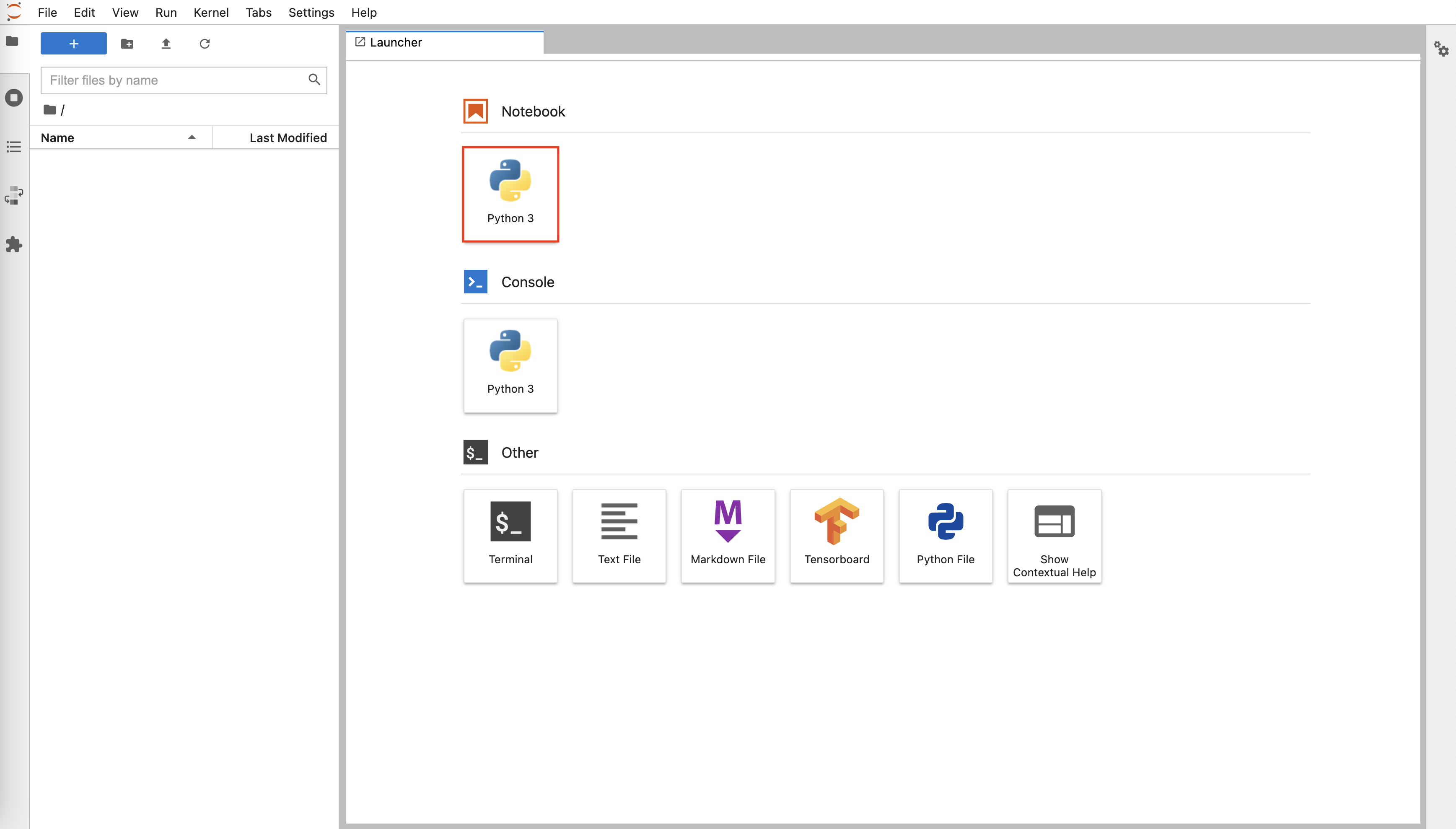

在 Notebook 的前端页面,点击左上角的 +,然后点击 Notebook 下的 Python3 以新建一个 .ipynb 文件。

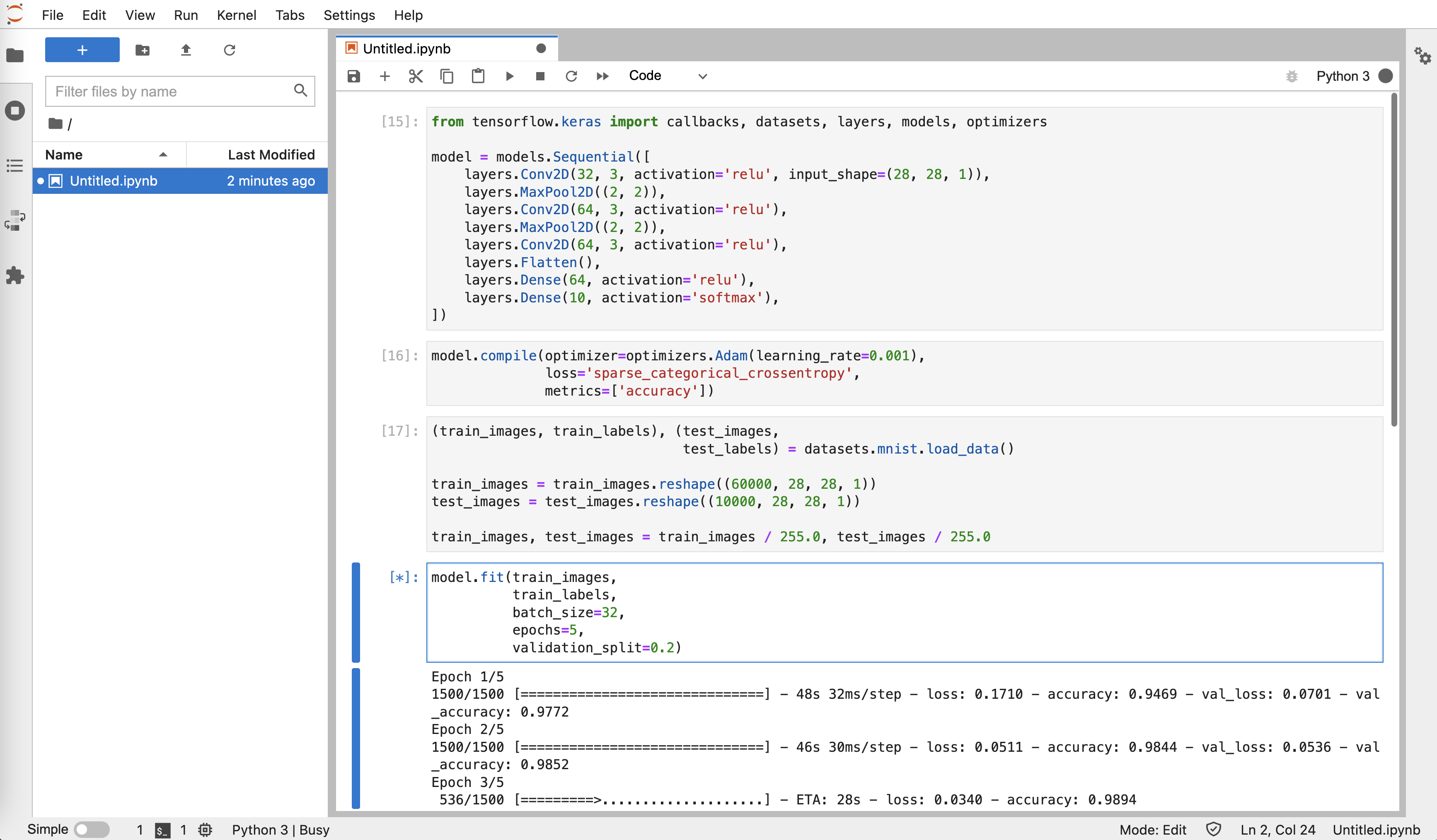

复制下面的训练脚本到该 .ipynb 文件的代码框中。该脚本基于 PyTorch 框架,建立一个简单的卷积神经网络模型,并使用 MNIST 数据集的手写数字图像进行训练和测试。

torch_mnist.py

import os

import shutil

import torch

import torch.nn as nn

import torch.nn.functional as F

import torch.optim as optim

from torch.utils.tensorboard import SummaryWriter

from torchvision import datasets, transforms

class Net(nn.Module):

def __init__(self):

super().__init__()

self.conv1 = nn.Conv2d(1, 32, 3, 1)

self.conv2 = nn.Conv2d(32, 64, 3, 1)

self.conv3 = nn.Conv2d(64, 64, 3, 1)

self.pool = nn.MaxPool2d(2, 2)

self.dense1 = nn.Linear(576, 64)

self.dense2 = nn.Linear(64, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = F.relu(self.conv3(x))

x = torch.flatten(x, 1)

x = F.relu(self.dense1(x))

output = F.softmax(self.dense2(x), dim=1)

return output

def train():

global global_step

for epoch in range(1, epochs + 1):

model.train()

for step, (data, target) in enumerate(train_loader, 1):

data, target = data.to(device), target.to(device)

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

if step % 500 == 0:

train_loss = loss.item()

print('epoch {:d}/{:d}, batch {:5d}/{:d} with loss: {:.4f}'.

format(epoch, epochs, step, steps_per_epoch, train_loss))

global_step = (epoch - 1) * steps_per_epoch + step

writer.add_scalar('train/loss', train_loss, global_step)

scheduler.step()

global_step = epoch * steps_per_epoch

test(val=True, epoch=epoch)

def test(val=False, epoch=None):

label = 'val' if val else 'test'

model.eval()

running_loss = 0.0

correct = 0

with torch.no_grad():

loader = val_loader if val else test_loader

for data, target in loader:

data, target = data.to(device), target.to(device)

output = model(data)

loss = criterion(output, target)

running_loss += loss.item()

prediction = output.max(1)[1]

correct += (prediction == target).sum().item()

test_loss = running_loss / len(loader)

test_accuracy = correct / len(loader.dataset)

msg = '{:s} loss: {:.4f}, {:s} accuracy: {:.4f}'.format(

label, test_loss, label, test_accuracy)

if val:

msg = 'epoch {:d}/{:d} with '.format(epoch, epochs) + msg

print(msg)

writer.add_scalar('{:s}/loss'.format(label), test_loss, global_step)

writer.add_scalar('{:s}/accuracy'.format(label), test_accuracy,

global_step)

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

kwargs = {

'num_workers': 1,

'pin_memory': True

} if torch.cuda.is_available() else {}

torch.manual_seed(1)

model = Net().to(device)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=1, gamma=0.7)

dataset_path = './data'

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5), (0.5))])

train_dataset = datasets.MNIST(root=dataset_path,

train=True,

download=True,

transform=transform)

train_dataset, val_dataset = torch.utils.data.random_split(

train_dataset, [48000, 12000])

test_dataset = datasets.MNIST(root=dataset_path,

train=False,

download=True,

transform=transform)

train_loader = torch.utils.data.DataLoader(train_dataset,

batch_size=32,

shuffle=True,

**kwargs)

val_loader = torch.utils.data.DataLoader(val_dataset,

batch_size=400,

shuffle=False,

**kwargs)

test_loader = torch.utils.data.DataLoader(test_dataset,

batch_size=1000,

shuffle=False,

**kwargs)

log_dir = './log'

if os.path.exists(log_dir):

shutil.rmtree(log_dir, ignore_errors=True)

writer = SummaryWriter(log_dir)

global_step = 0

epochs = 10

steps_per_epoch = len(train_loader)

train()

test()

torch.save(model.state_dict(), 'model_state_dict.pt')

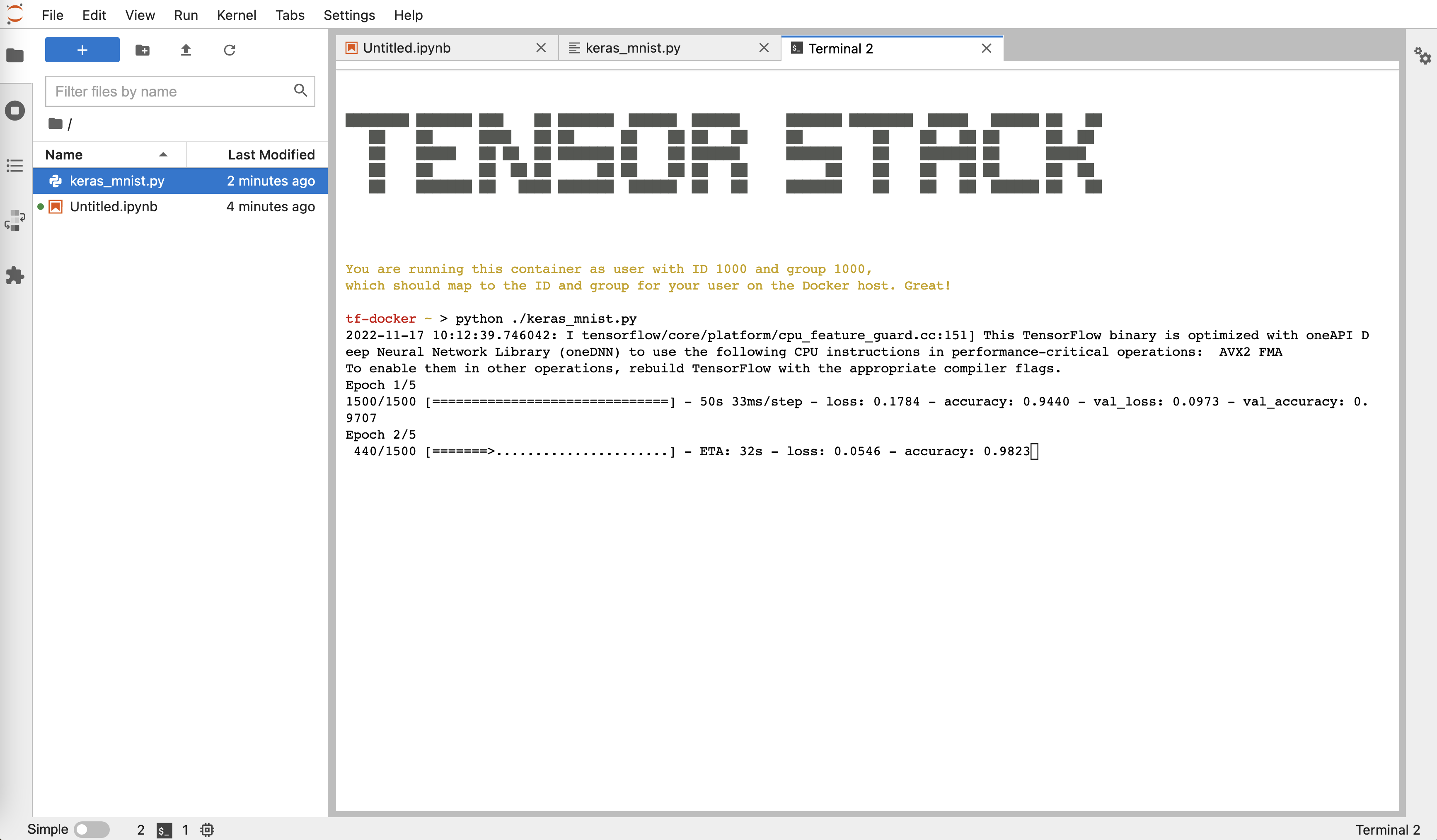

点击上方的运行按钮,可以看到训练开始进行:

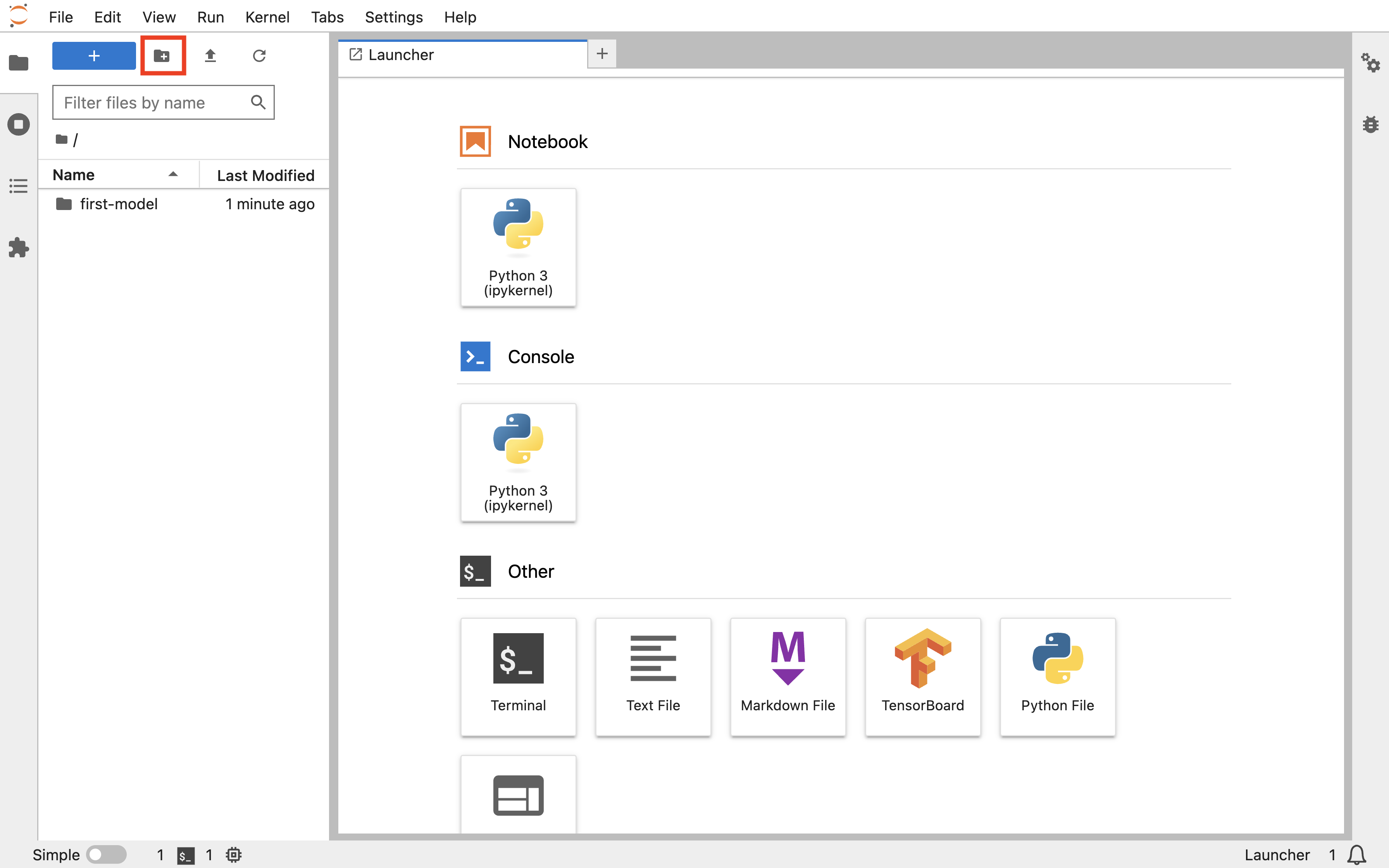

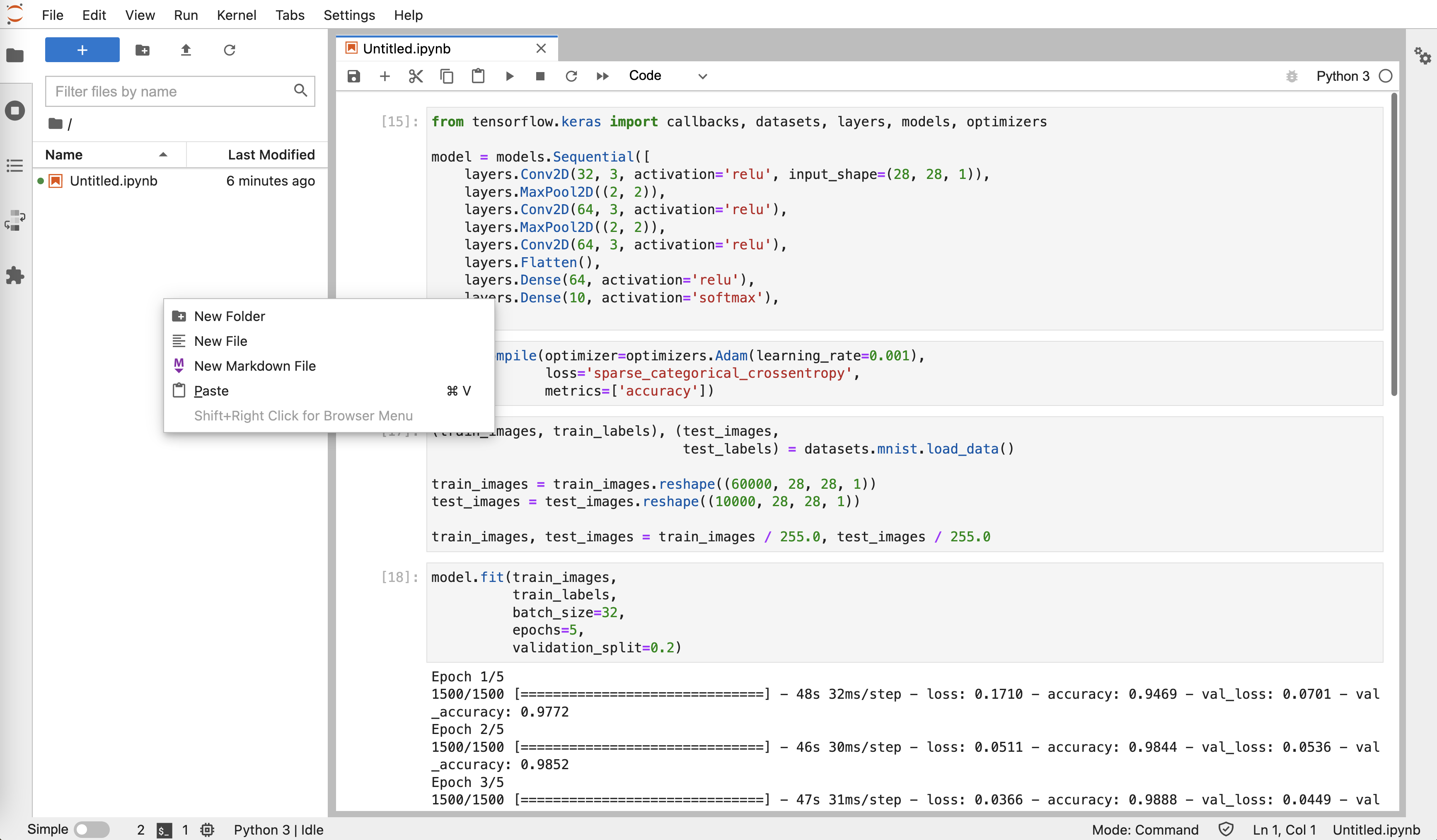

训练结束后,点击左上角的新建文件夹按钮,为新文件夹命名 first-model,并将当前教程产生的所有文件拖拽移动到其中。

下一步

- 针对同样的模型,使用 Job 进行并行训练

- 全面了解模型构建

进行并行训练

本教程带领你使用 PyTorchTrainingJob,将教程训练你的第一个模型中的模型训练改进为使用 GPU 加速的数据并行训练。

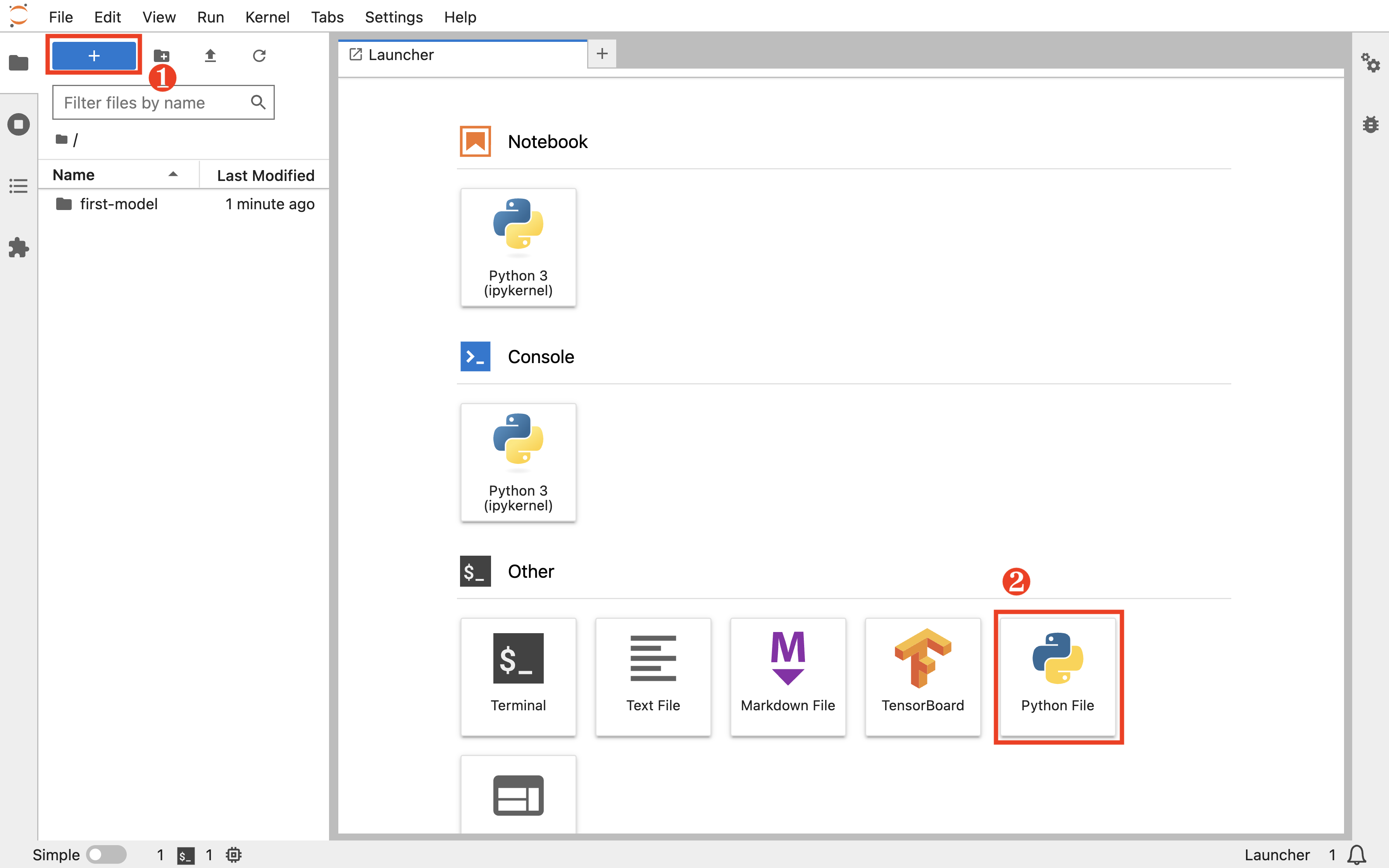

在 Notebook 中准备并行训练

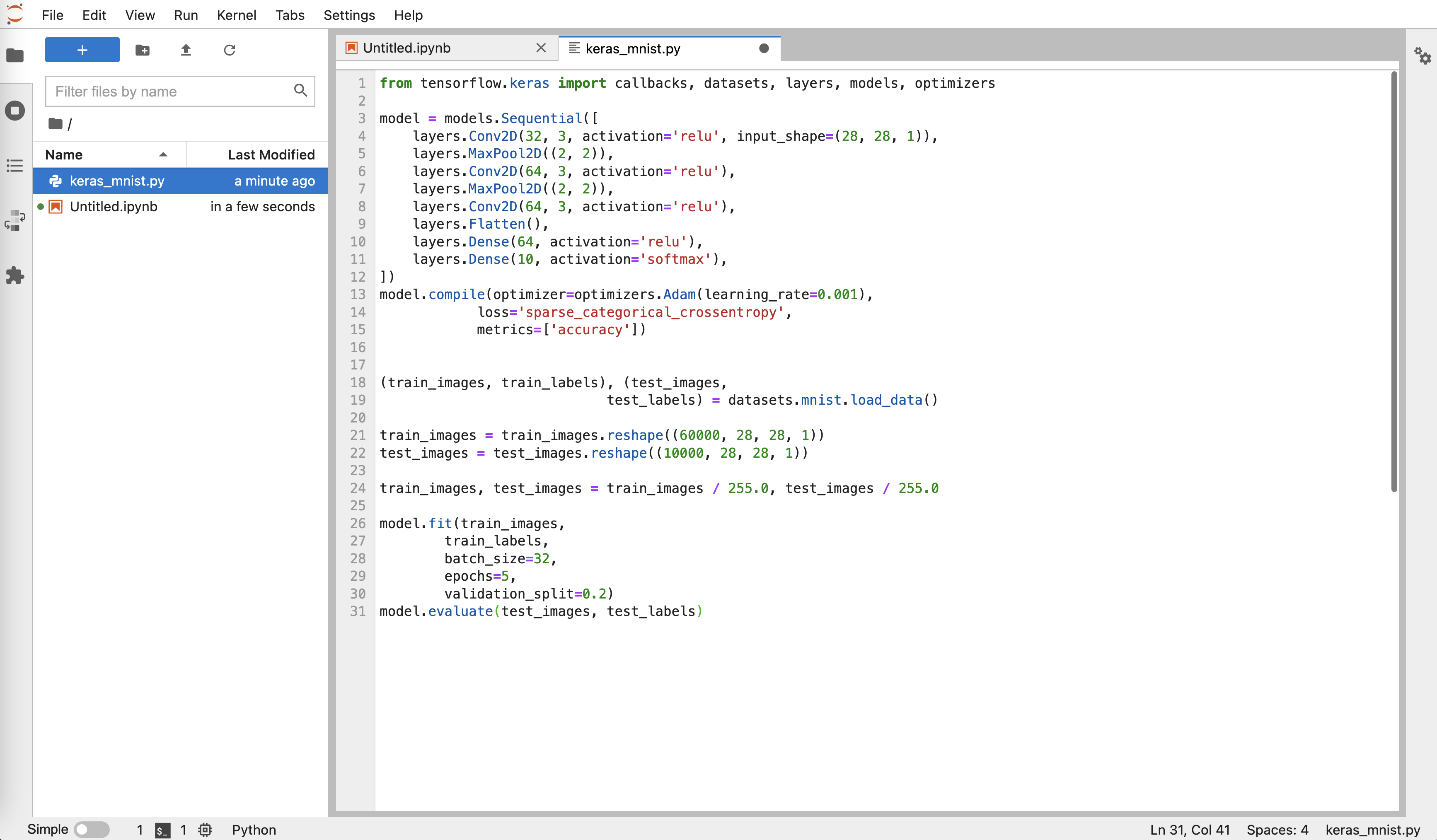

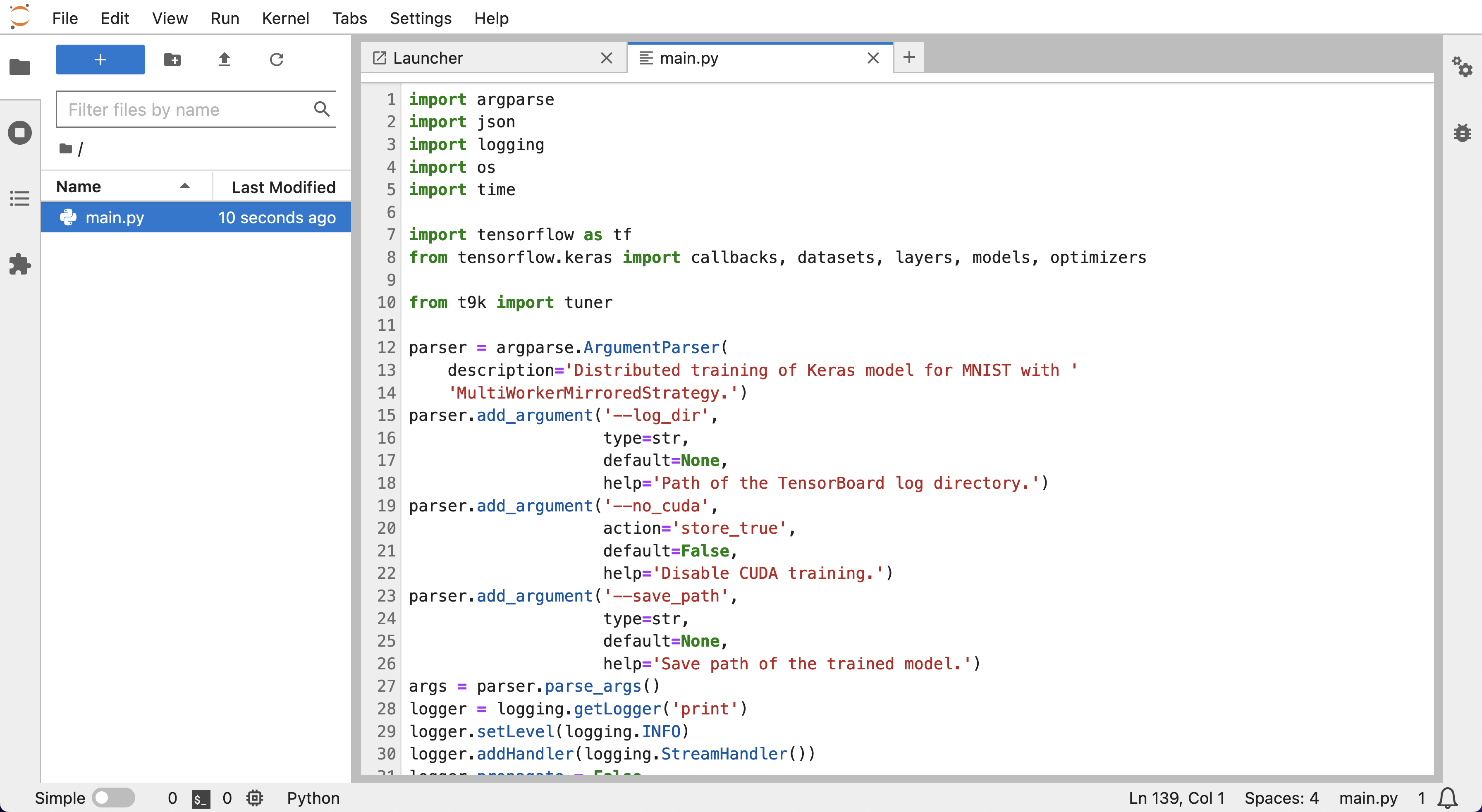

回到 Notebook mnist,在 HOME 目录(即左侧边栏文件浏览器显示的根目录 /)下,点击左上角的 +,然后点击 Other 下的 Python File 以新建一个 Python 脚本文件。

向该文件复制以下代码,并将其命名为 torch_mnist_trainingjob.py。该脚本在上一篇教程的脚本的基础上进行了修改以支持数据并行训练。

torch_mnist_trainingjob.py

import argparse

import logging

import os

import shutil

import torch

import torch.distributed as dist

import torch.nn as nn

import torch.nn.functional as F

from torch.nn.parallel import DistributedDataParallel as DDP

import torch.optim as optim

from torch.utils.tensorboard import SummaryWriter

from torchvision import datasets, transforms

parser = argparse.ArgumentParser(

description='DDP training of PyTorch model for MNIST.')

parser.add_argument(

'--backend',

type=str,

help='Distributed backend',

choices=[dist.Backend.GLOO, dist.Backend.NCCL, dist.Backend.MPI],

default=dist.Backend.GLOO)

parser.add_argument('--log_dir',

type=str,

help='Path of the TensorBoard log directory.')

parser.add_argument('--save_path',

type=str,

help='Path of the saved model.')

parser.add_argument('--no_cuda',

action='store_true',

default=False,

help='Disable CUDA training.')

logging.basicConfig(format='%(message)s', level=logging.INFO)

class Net(nn.Module):

def __init__(self):

super().__init__()

self.conv1 = nn.Conv2d(1, 32, 3, 1)

self.conv2 = nn.Conv2d(32, 64, 3, 1)

self.conv3 = nn.Conv2d(64, 64, 3, 1)

self.pool = nn.MaxPool2d(2, 2)

self.dense1 = nn.Linear(576, 64)

self.dense2 = nn.Linear(64, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = F.relu(self.conv3(x))

x = torch.flatten(x, 1)

x = F.relu(self.dense1(x))

output = F.softmax(self.dense2(x), dim=1)

return output

def train():

global global_step

for epoch in range(1, epochs + 1):

model.train()

for step, (data, target) in enumerate(train_loader, 1):

data, target = data.to(device), target.to(device)

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

if step % (500 // world_size) == 0:

train_loss = loss.item()

logging.info(

'epoch {:d}/{:d}, batch {:5d}/{:d} with loss: {:.4f}'.

format(epoch, epochs, step, steps_per_epoch, train_loss))

global_step = (epoch - 1) * steps_per_epoch + step

if args.log_dir and rank == 0:

writer.add_scalar('train/loss', train_loss, global_step)

scheduler.step()

global_step = epoch * steps_per_epoch

test(val=True, epoch=epoch)

def test(val=False, epoch=None):

label = 'val' if val else 'test'

model.eval()

running_loss = 0.0

correct = 0

with torch.no_grad():

loader = val_loader if val else test_loader

for data, target in loader:

data, target = data.to(device), target.to(device)

output = model(data)

loss = criterion(output, target)

running_loss += loss.item()

prediction = output.max(1)[1]

correct += (prediction == target).sum().item()

test_loss = running_loss / len(loader)

test_accuracy = correct / len(loader.dataset)

msg = '{:s} loss: {:.4f}, {:s} accuracy: {:.4f}'.format(

label, test_loss, label, test_accuracy)

if val:

msg = 'epoch {:d}/{:d} with '.format(epoch, epochs) + msg

logging.info(msg)

if args.log_dir and rank == 0:

writer.add_scalar('{:s}/loss'.format(label), test_loss, global_step)

writer.add_scalar('{:s}/accuracy'.format(label), test_accuracy,

global_step)

if __name__ == '__main__':

args = parser.parse_args()

logging.info('Using distributed PyTorch with %s backend', args.backend)

dist.init_process_group(backend=args.backend)

rank = dist.get_rank()

world_size = dist.get_world_size()

local_rank = int(os.environ['LOCAL_RANK'])

use_cuda = not args.no_cuda and torch.cuda.is_available()

if use_cuda:

logging.info('Using CUDA')

device = torch.device('cuda:{}'.format(local_rank) if use_cuda else 'cpu')

kwargs = {'num_workers': 1, 'pin_memory': True} if use_cuda else {}

torch.manual_seed(1)

dataset_path = os.path.join(os.path.dirname(os.path.realpath(__file__)),

'data')

# rank 0 downloads datasets in advance

if rank == 0:

datasets.MNIST(root=dataset_path, train=True, download=True)

model = Net().to(device)

model = DDP(model)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001 * world_size)

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=1, gamma=0.7)

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5), (0.5))])

train_dataset = datasets.MNIST(root=dataset_path,

train=True,

download=False,

transform=transform)

train_dataset, val_dataset = torch.utils.data.random_split(

train_dataset, [48000, 12000])

test_dataset = datasets.MNIST(root=dataset_path,

train=False,

download=False,

transform=transform)

train_loader = torch.utils.data.DataLoader(train_dataset,

batch_size=32 * world_size,

shuffle=True,

**kwargs)

val_loader = torch.utils.data.DataLoader(val_dataset,

batch_size=400,

shuffle=False,

**kwargs)

test_loader = torch.utils.data.DataLoader(test_dataset,

batch_size=1000,

shuffle=False,

**kwargs)

if args.log_dir and rank == 0:

if os.path.exists(args.log_dir):

shutil.rmtree(args.log_dir, ignore_errors=True)

writer = SummaryWriter(args.log_dir)

global_step = 0

epochs = 10

steps_per_epoch = len(train_loader)

train()

test()

if rank == 0:

torch.save(model.module.state_dict(), args.save_path)

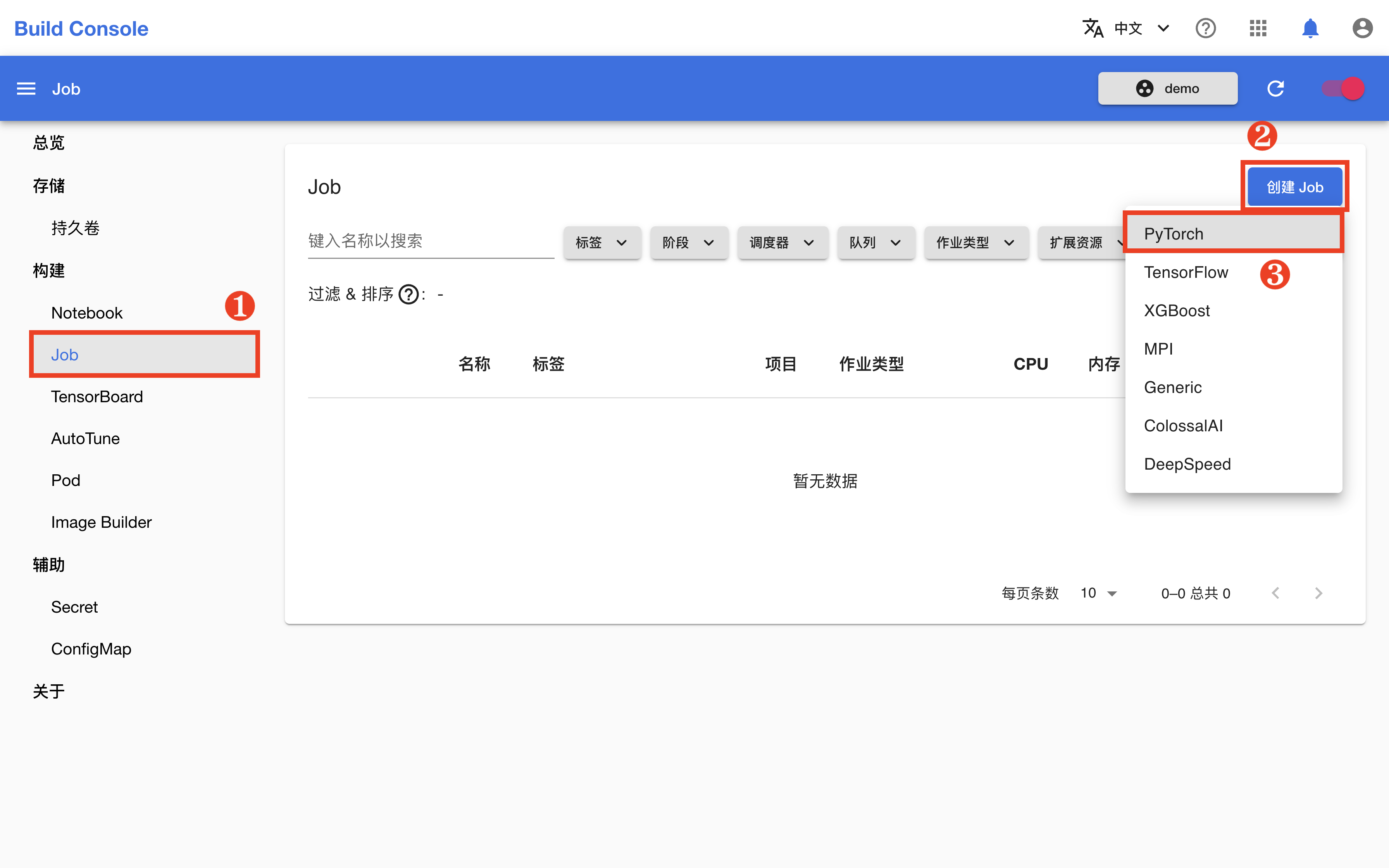

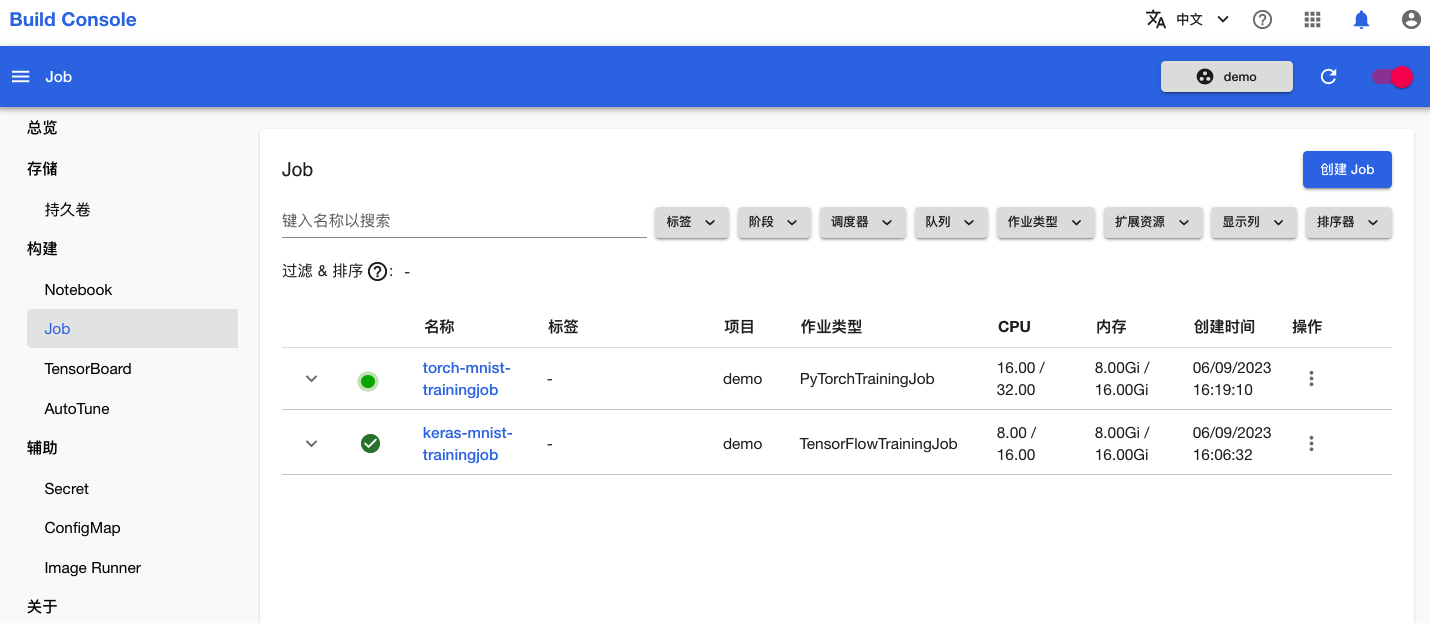

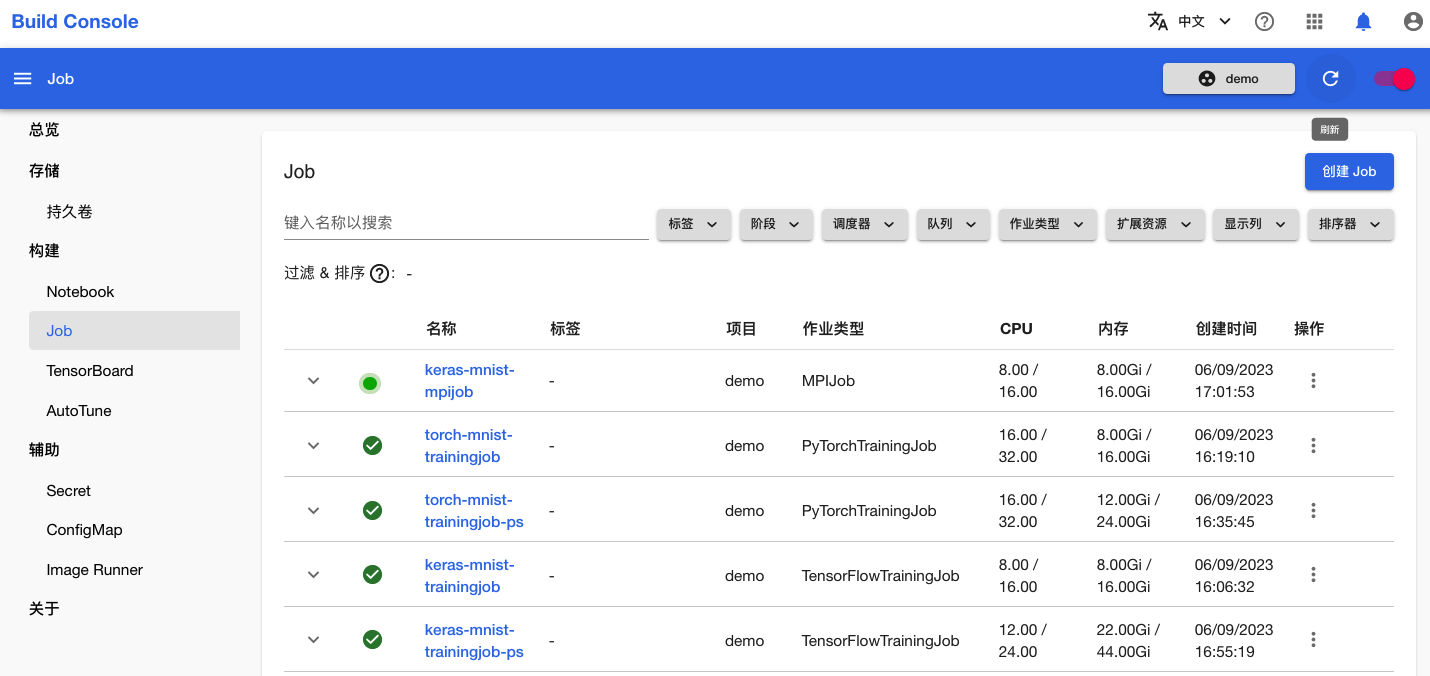

创建 Job 进行并行训练

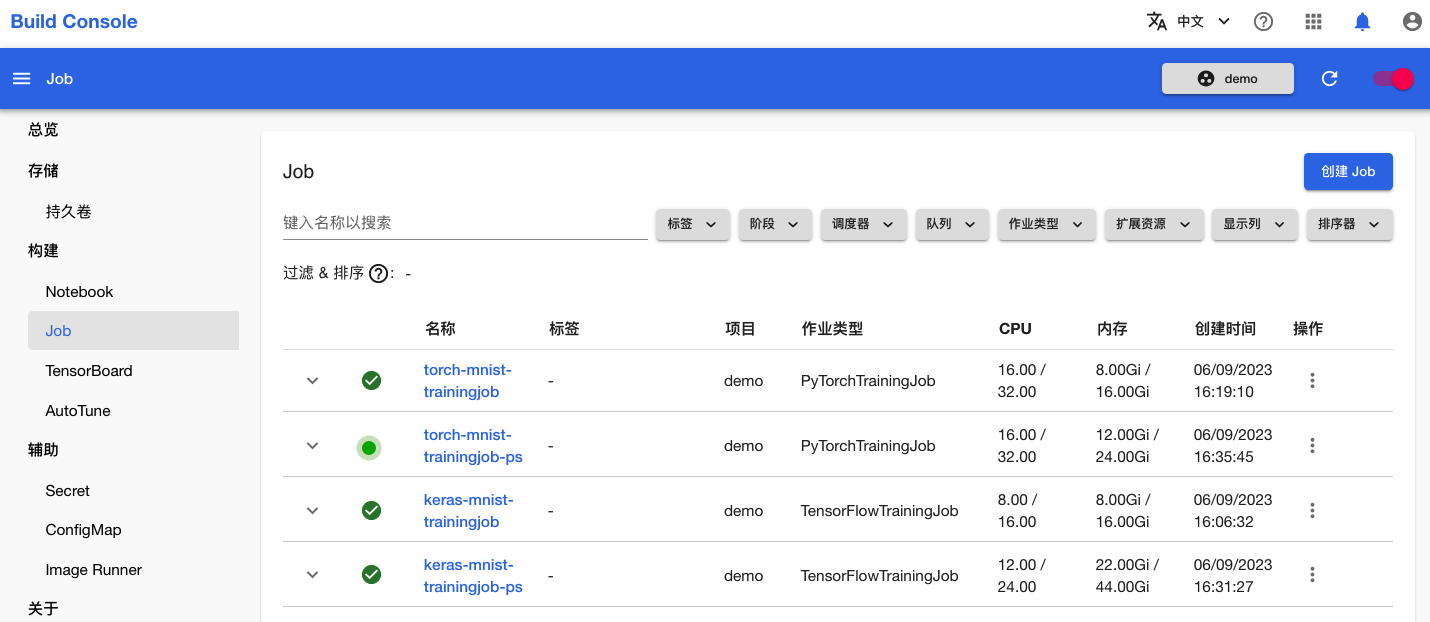

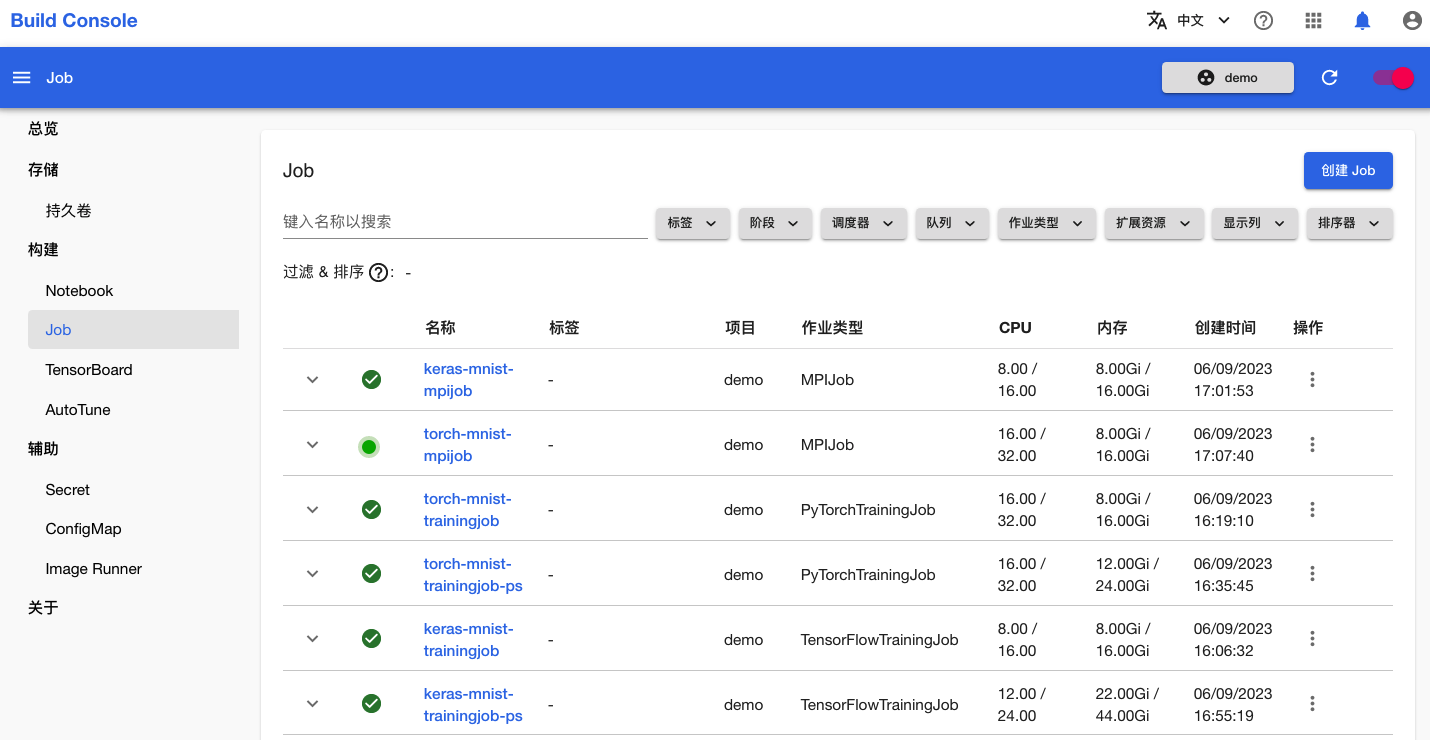

回到模型构建控制台,在左侧的导航菜单中点击构建 > Job 进入 Job 管理页面,然后点击右上角的创建 Job > PyTorch。

为了简化操作,在 Job 创建页面,点击预览 YAML,然后直接复制下面的 YAML 配置文件并粘贴到编辑框中,然后点击创建。

job.yaml

apiVersion: batch.tensorstack.dev/v1beta1

kind: PyTorchTrainingJob

metadata:

name: mnist # Job 名称

spec:

tensorboardSpec: # TensorBoard 服务器规约

resources:

limits:

cpu: 1

memory: 1Gi

logDir:

pvc:

- name: mnist

subPath:

- ./log # 日志文件路径

image: tensorflow/tensorflow:2.14.0

# TensorBoard 服务器使用的镜像

torchrunConfig:

enabled: true # torchrun 启动

maxRestarts: 3

procPerNode: "4" # 每个副本启动的进程数

rdzvBackend: c10d

extraOptions: []

replicaSpecs:

- type: node

replicas: 1 # 副本数

restartPolicy: ExitCode

template:

spec:

securityContext:

runAsUser: 1000

containers:

- name: pytorch

image: t9kpublic/pytorch-1.13.0:sdk-0.5.2

# 容器的镜像

workingDir: /t9k/mnt # 工作路径

args: # `python`命令的参数

- torch_mnist_trainingjob.py

- "--log_dir"

- "log"

- "--save_path"

- "./model_state_dict.pt"

- "--backend"

- "nccl"

resources: # 计算资源

limits: # 限制量

cpu: 8 # CPU

memory: 16Gi # 内存

nvidia.com/gpu: 4 # GPU

requests: # 请求量

cpu: 4

memory: 8Gi

nvidia.com/gpu: 4

volumeMounts:

- name: data

mountPath: /t9k/mnt # 挂载路径

- name: dshm

mountPath: /dev/shm # 挂载共享内存

volumes:

- name: data

persistentVolumeClaim:

claimName: mnist # 要挂载的 PVC

- name: dshm

emptyDir:

medium: Memory

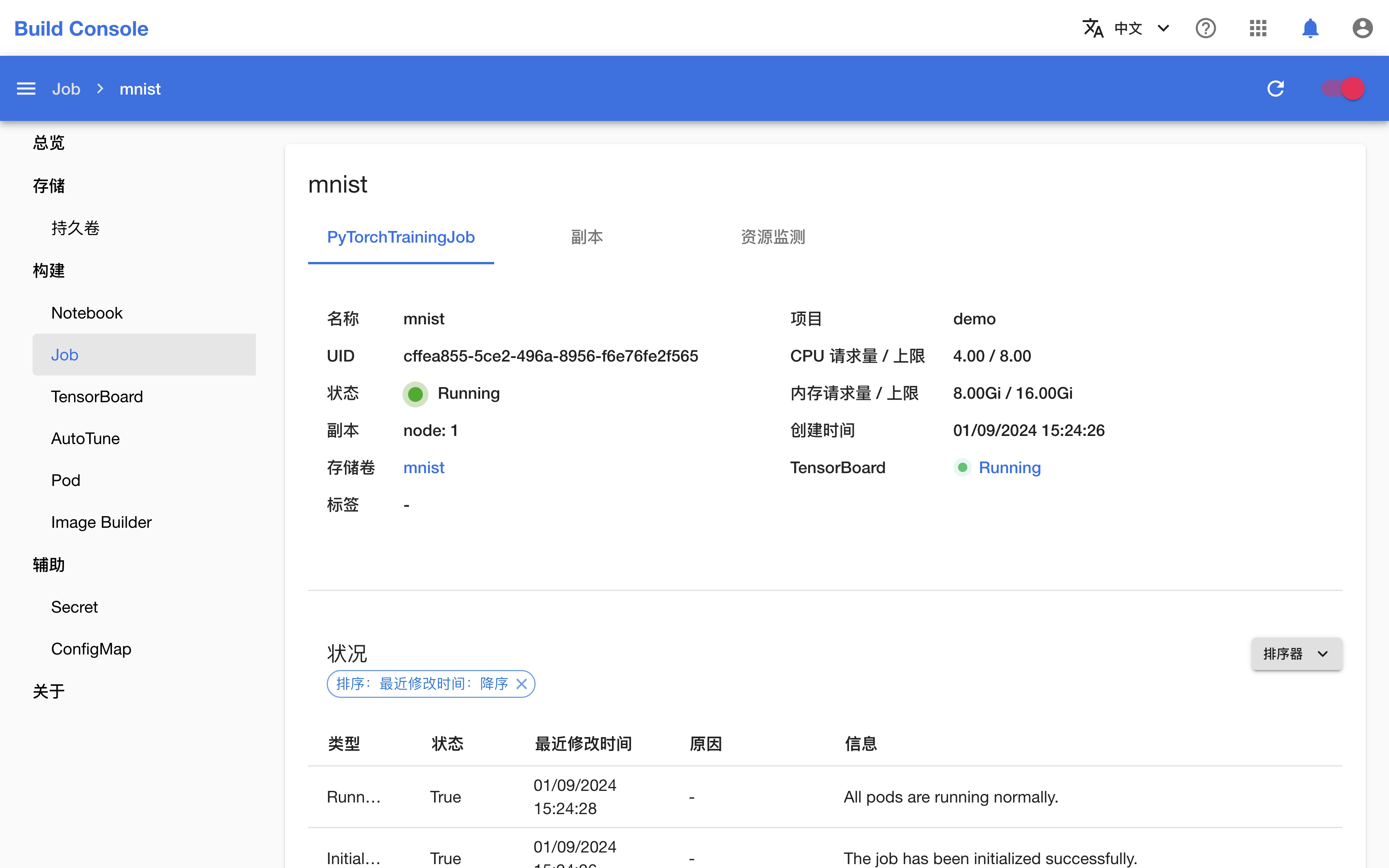

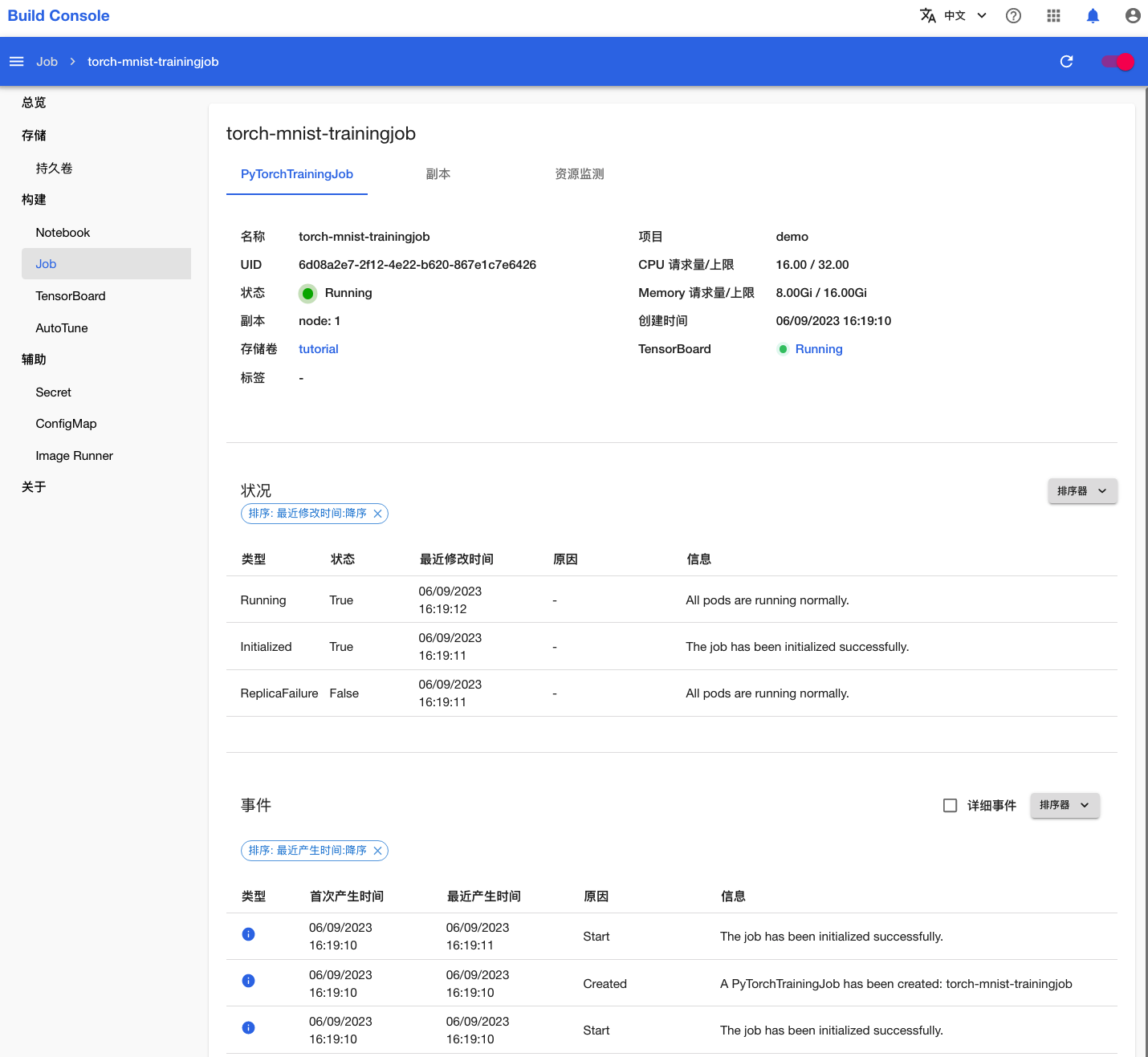

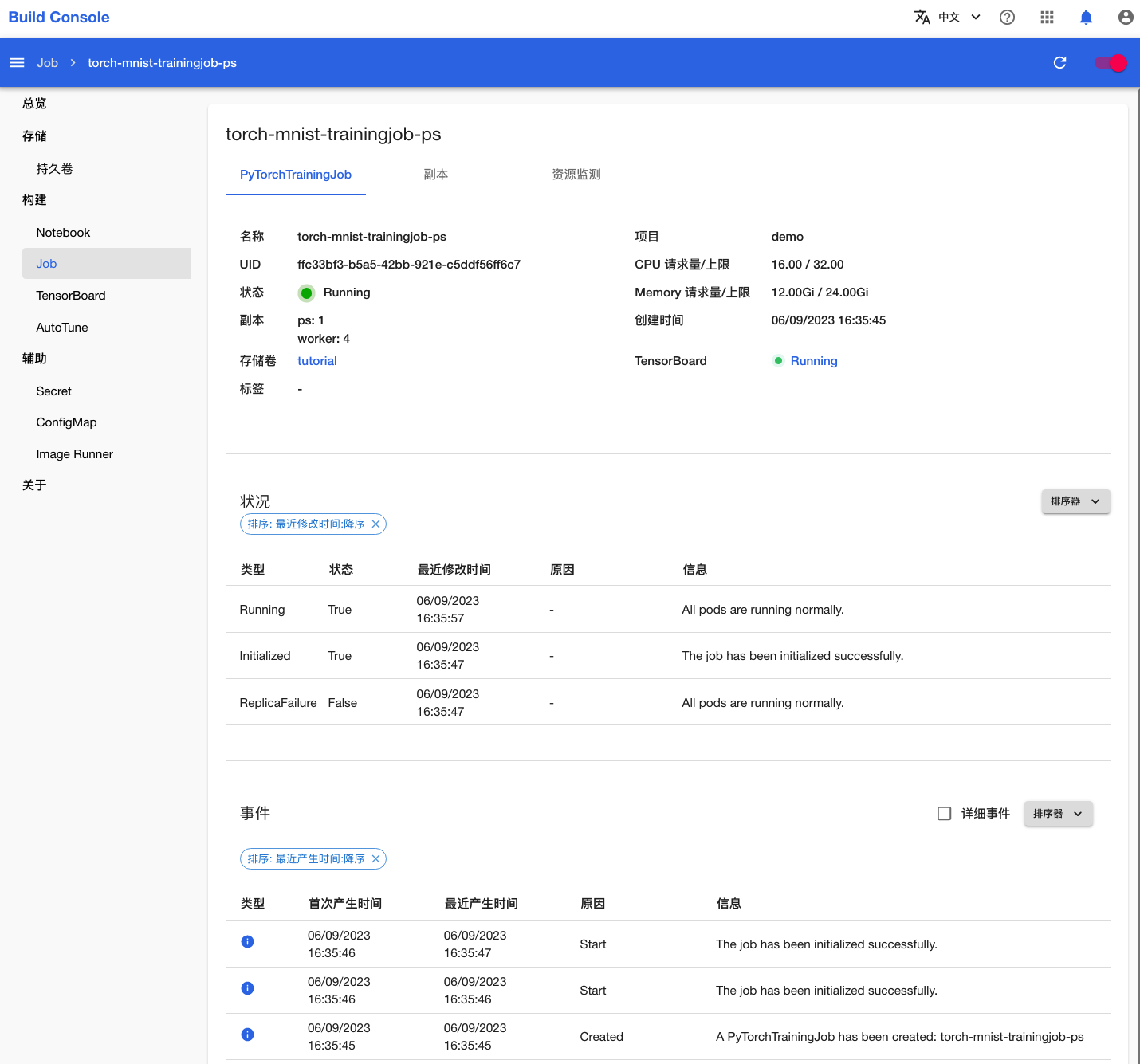

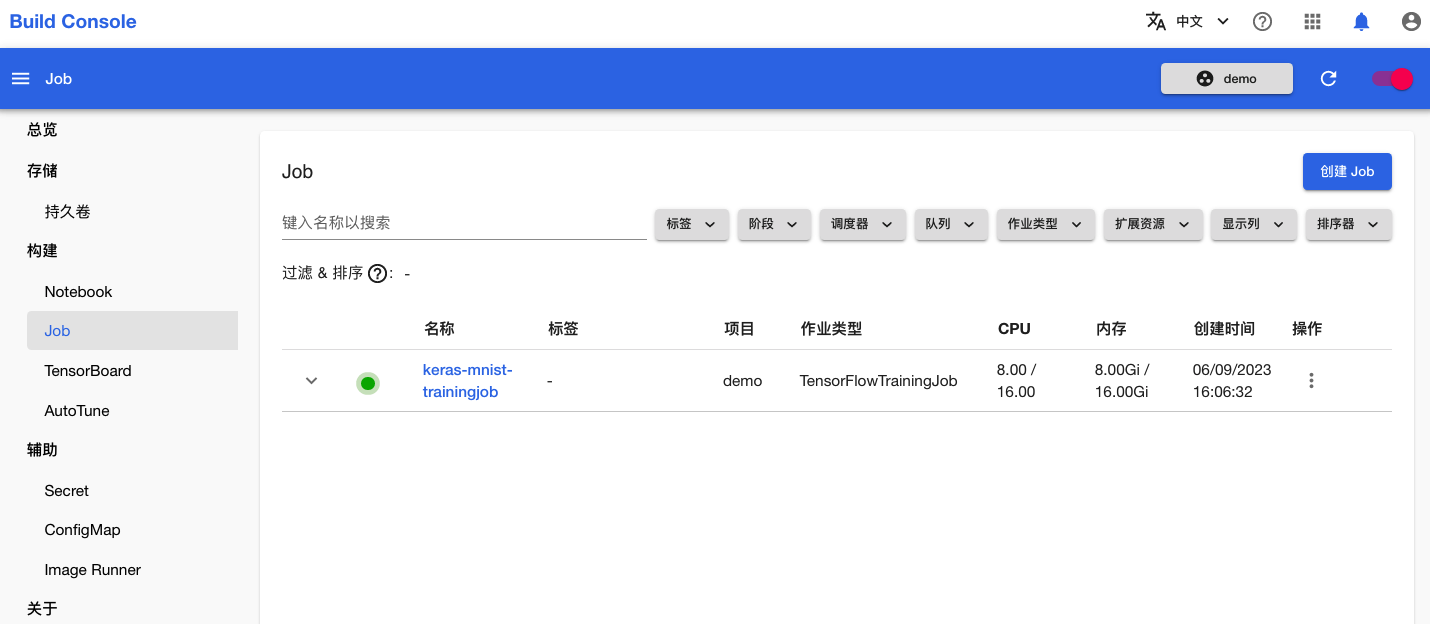

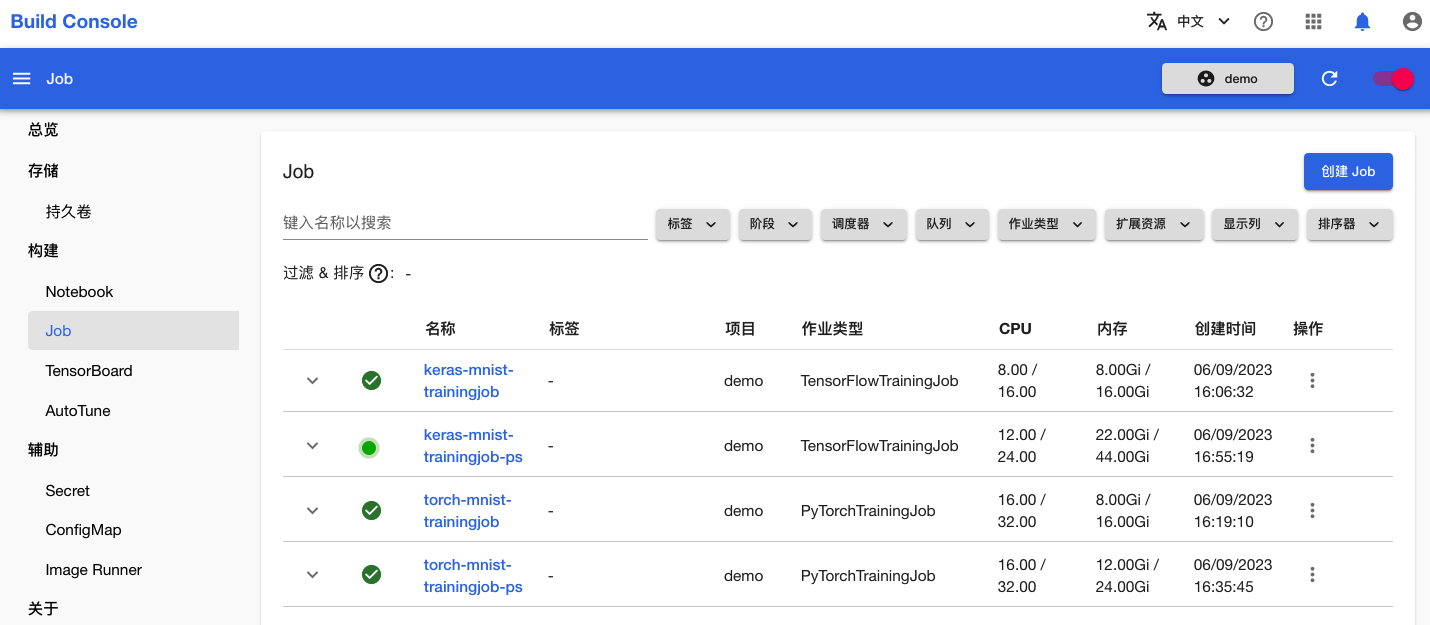

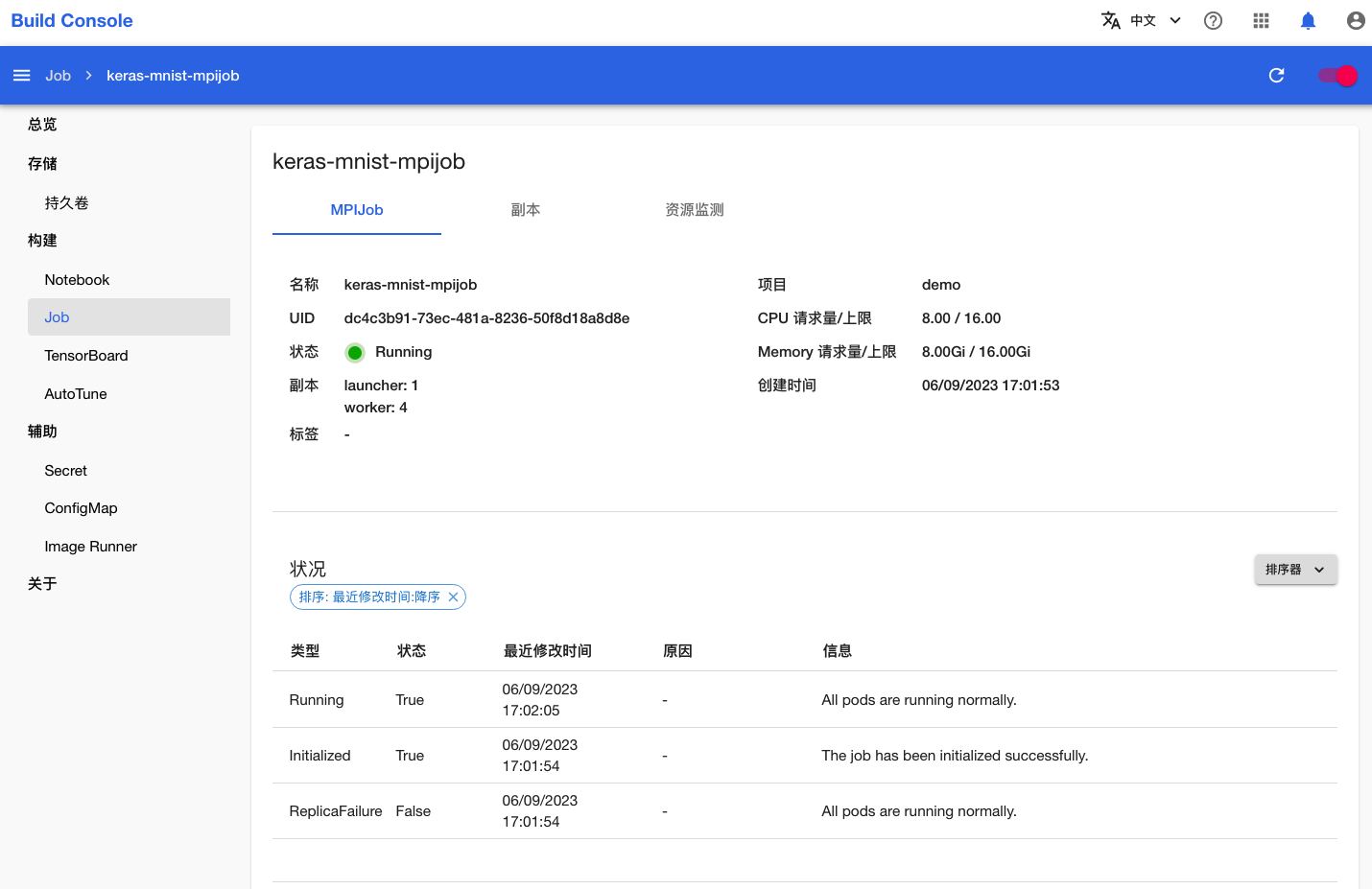

在跳转回到 Job 管理页面之后,等待刚才创建的 Job 就绪。第一次拉取镜像可能会花费较长的时间,具体取决于集群的网络状况。点击右上角的刷新图标来手动刷新 Job 状态,待 Job 开始运行之后,点击其名称进入详情页面。

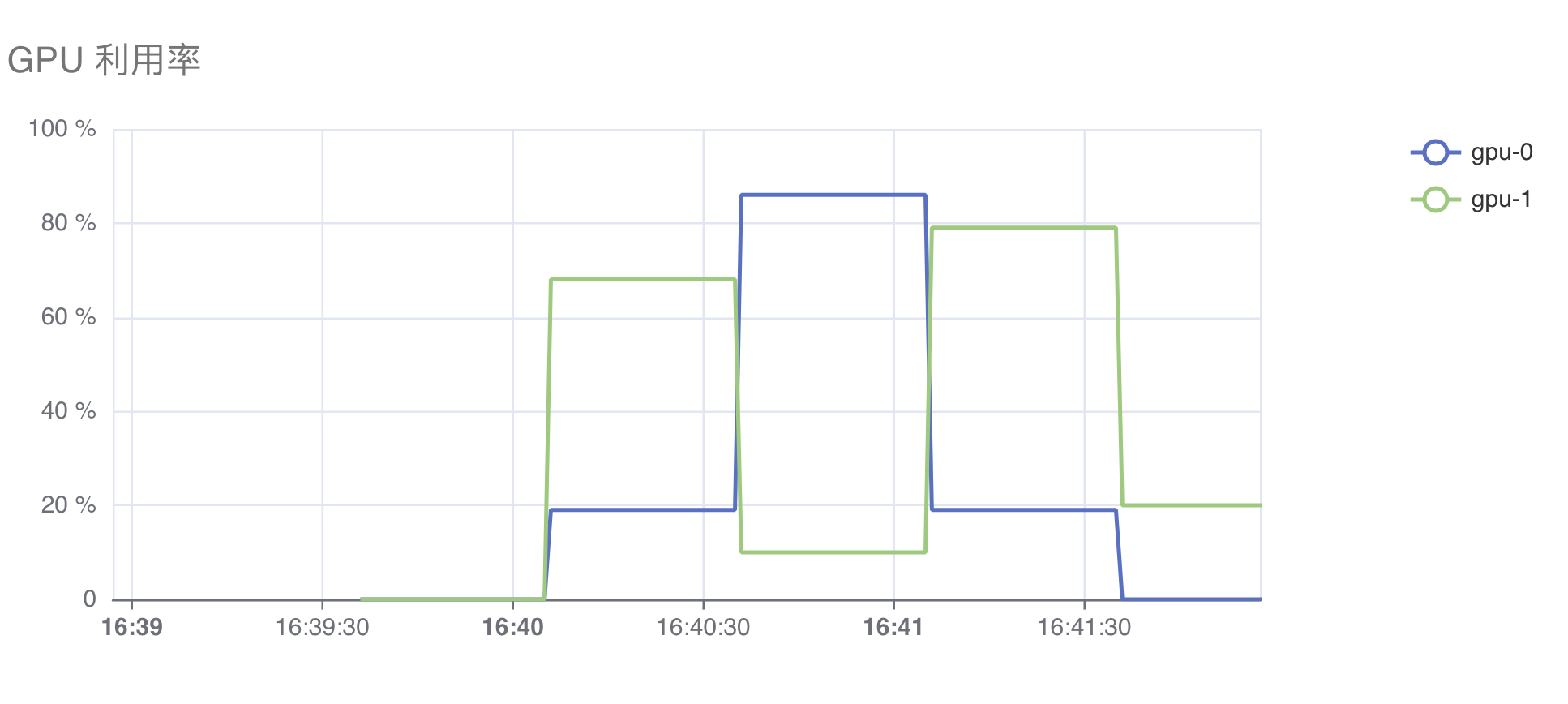

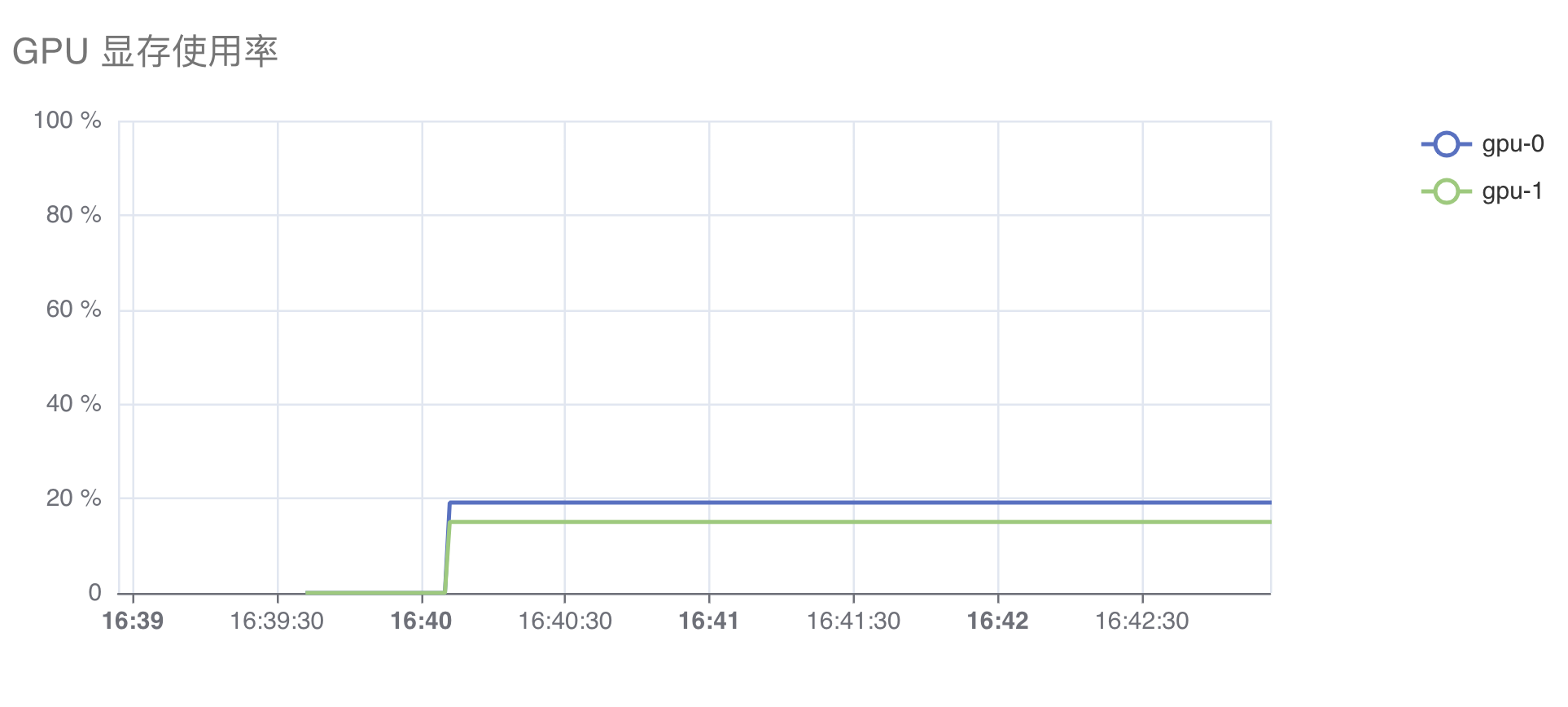

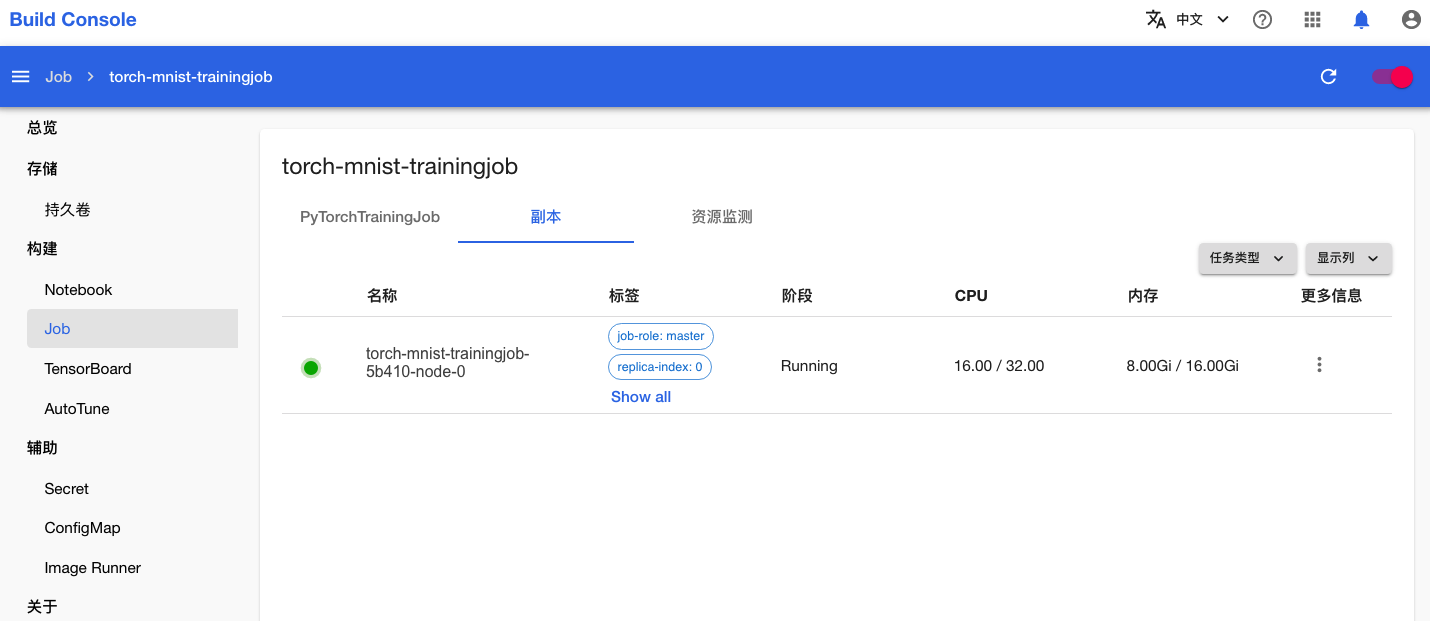

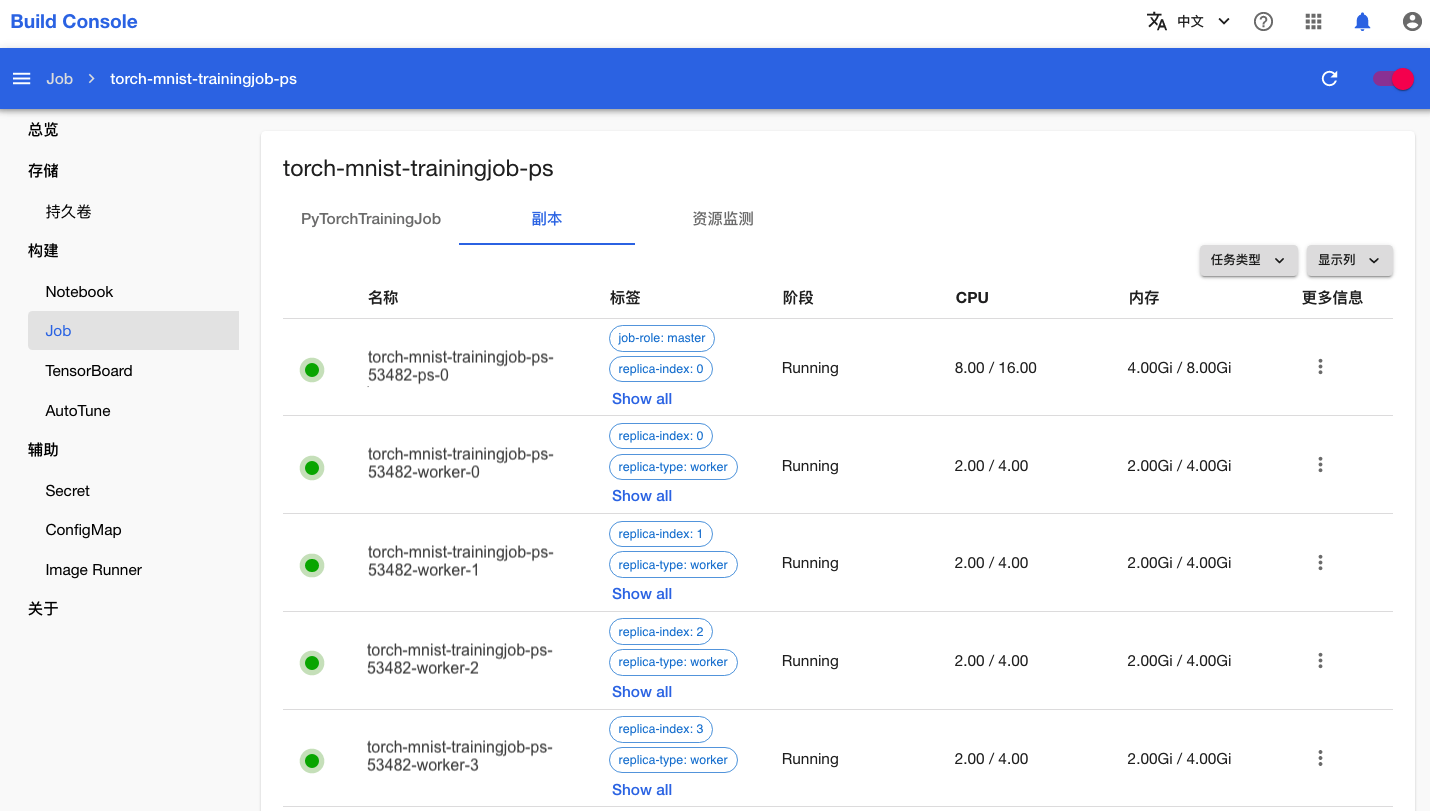

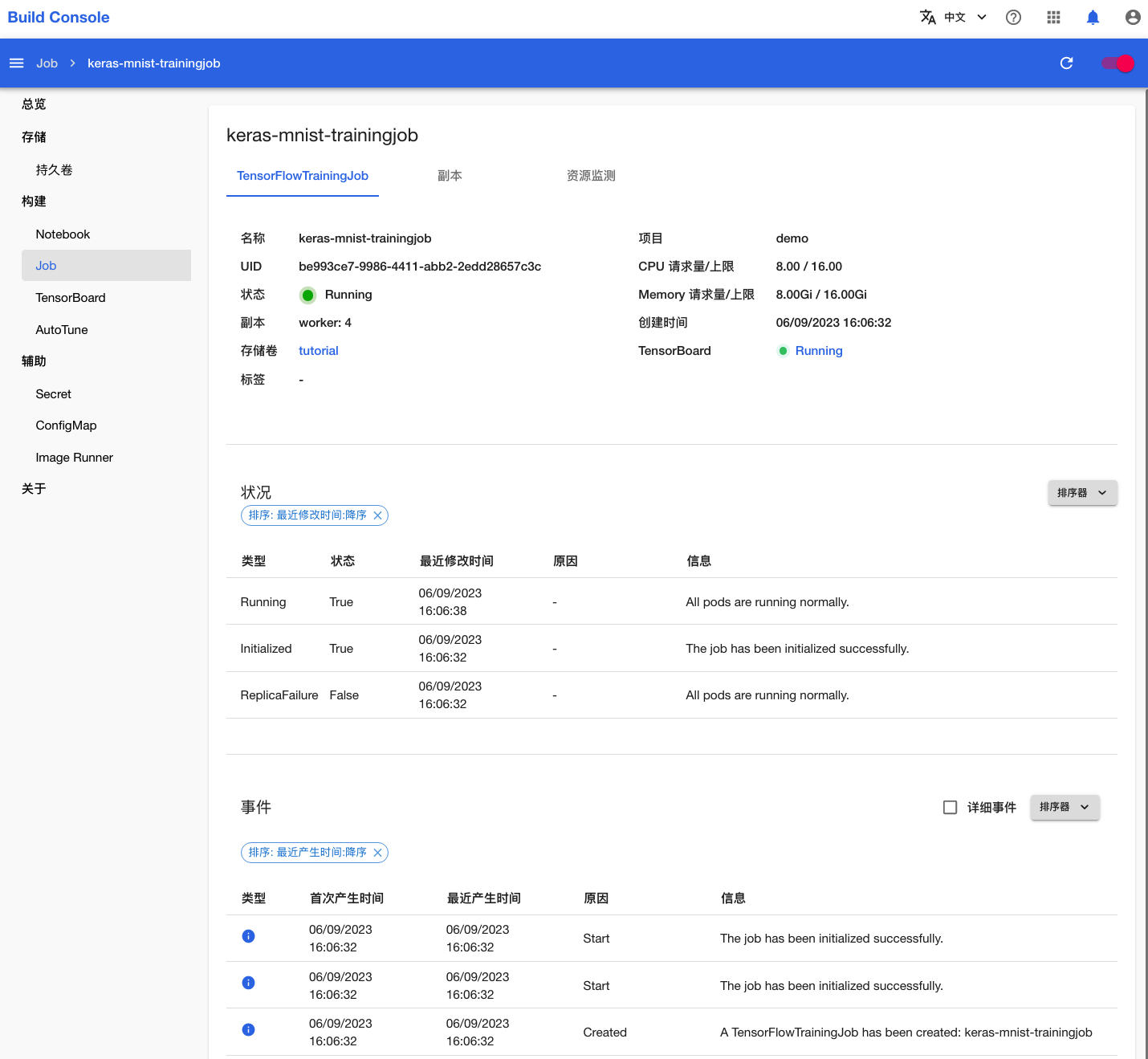

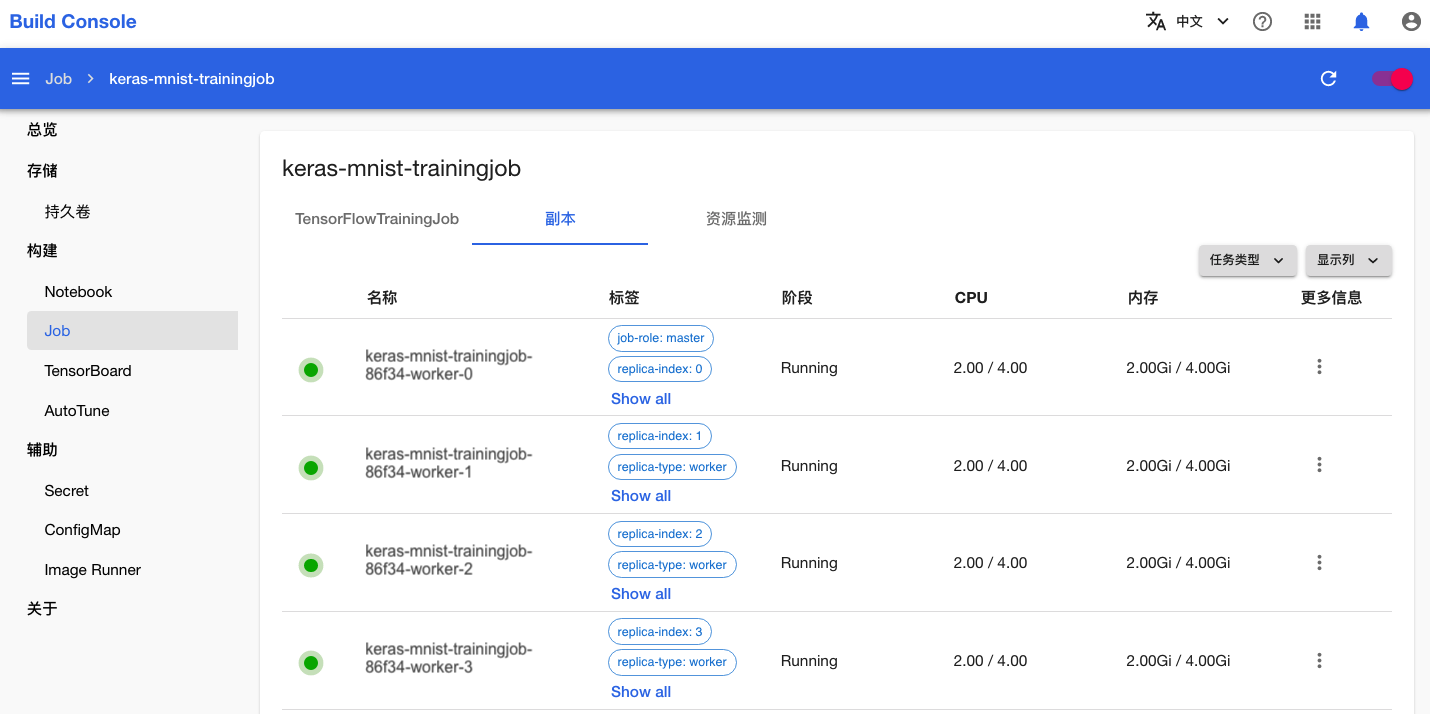

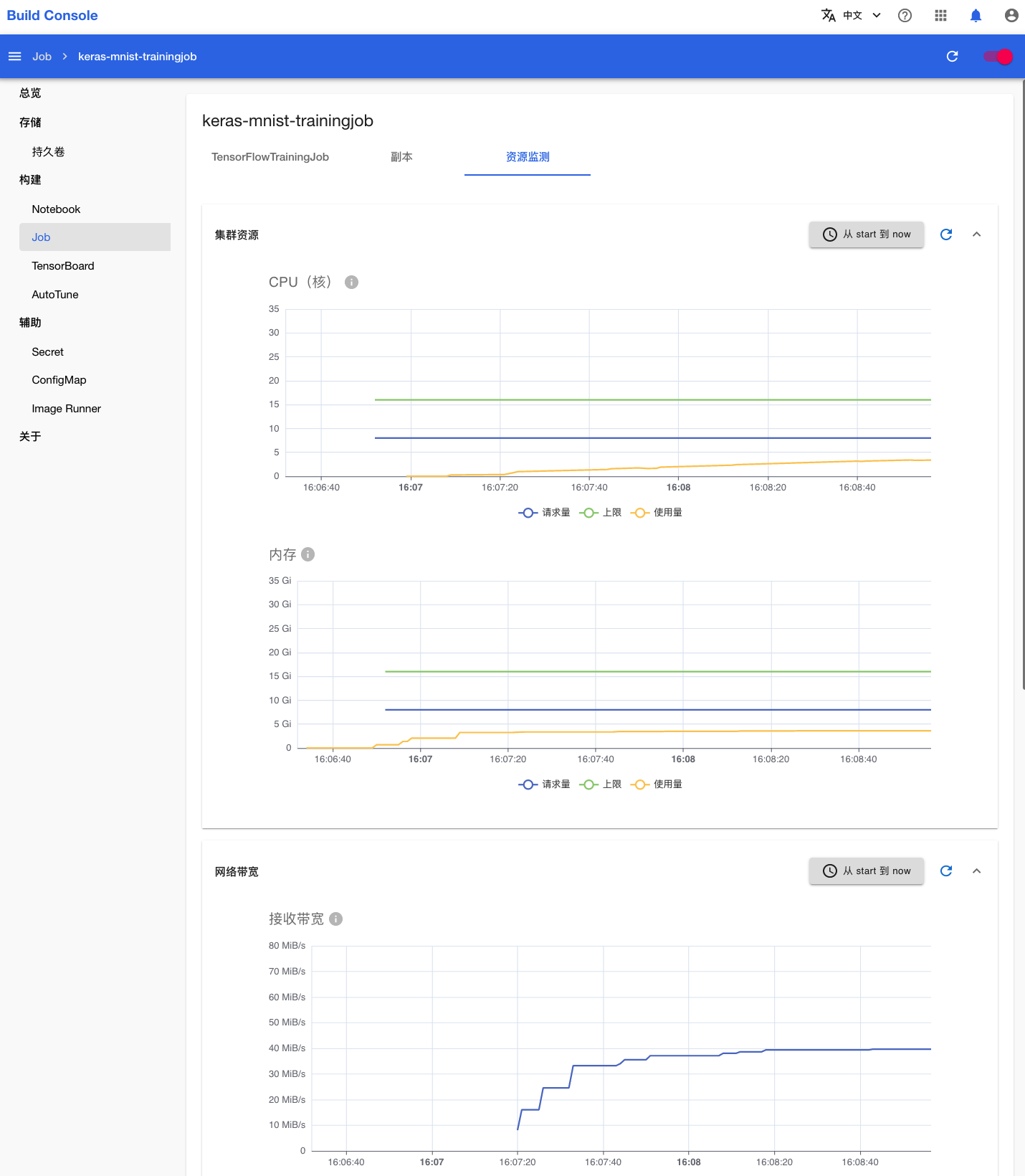

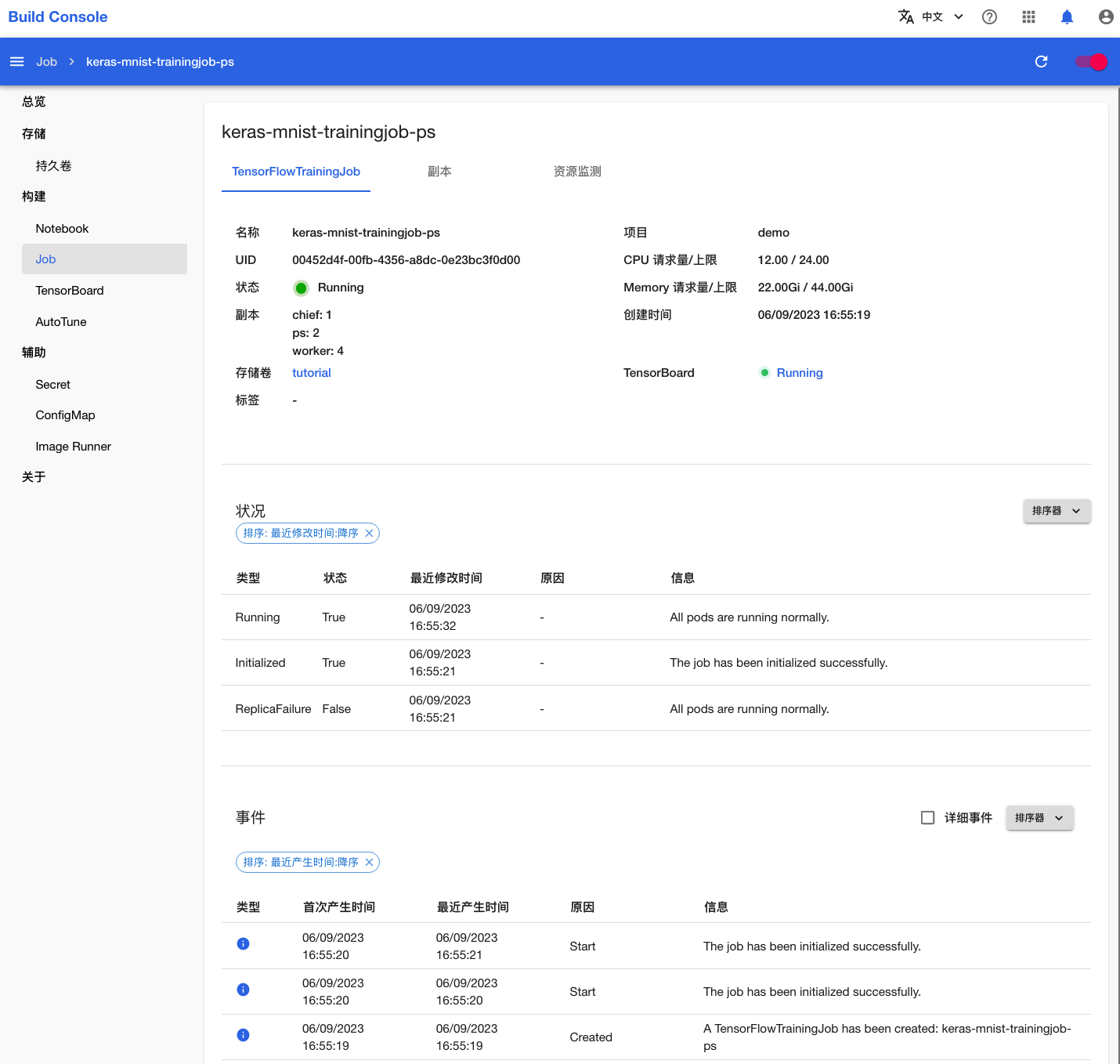

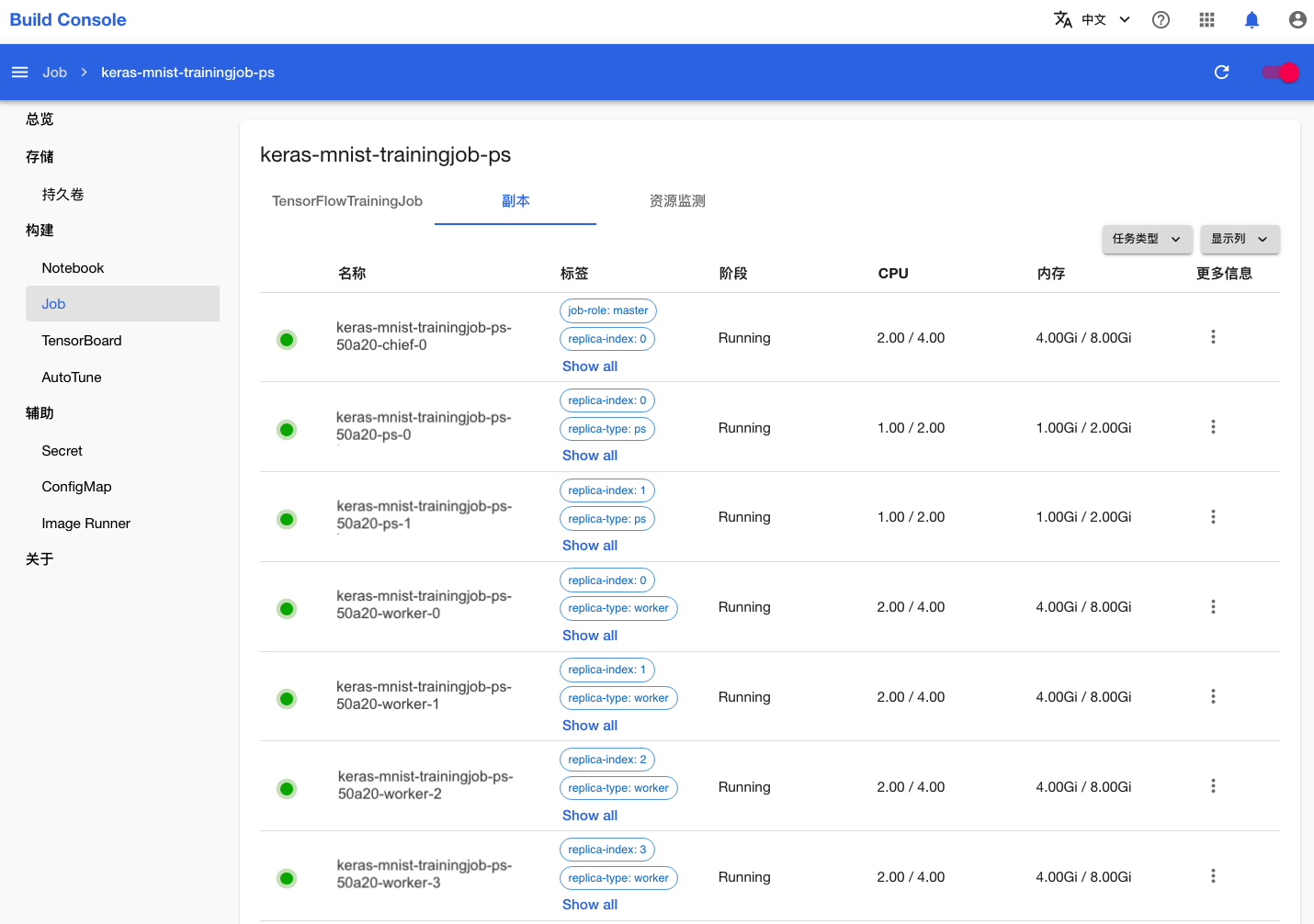

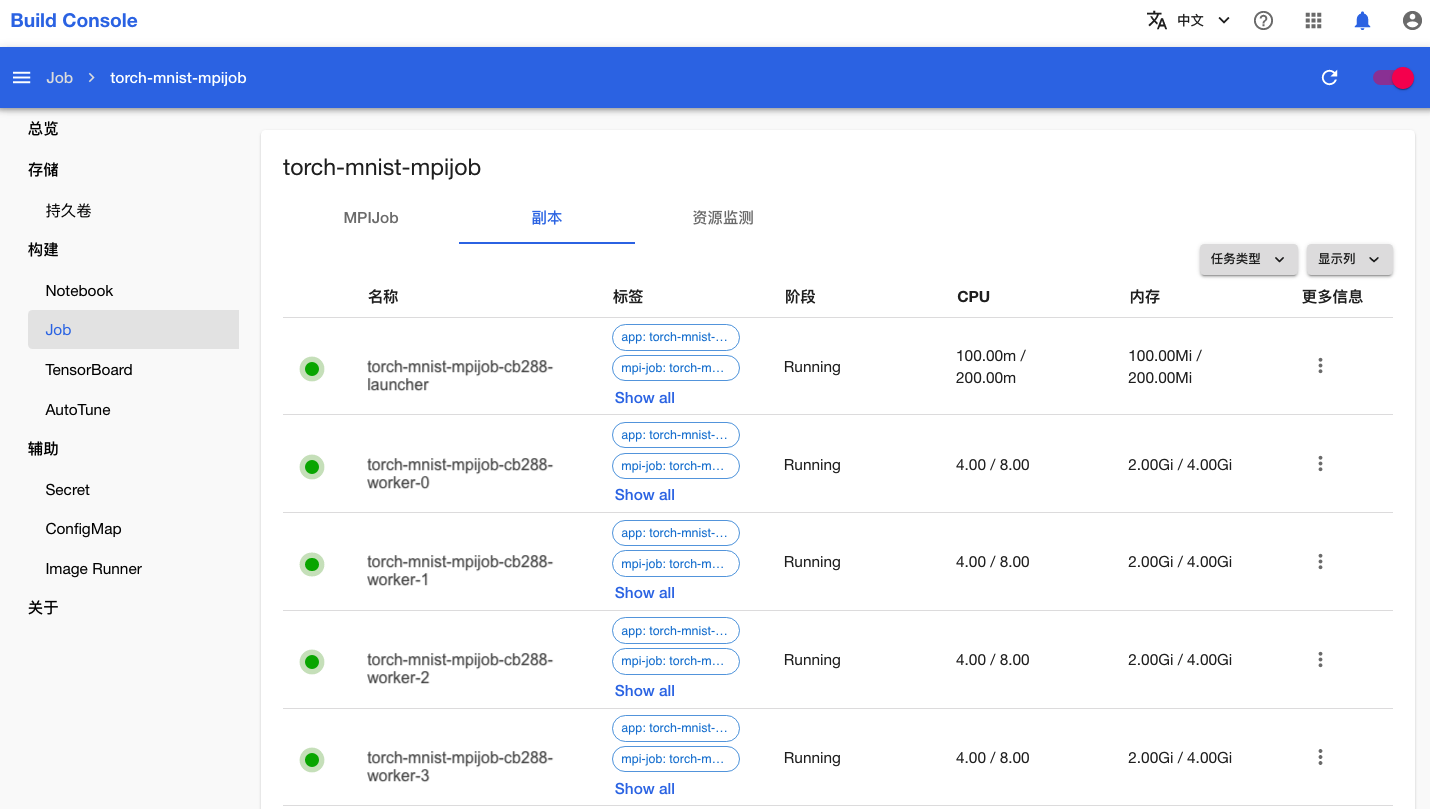

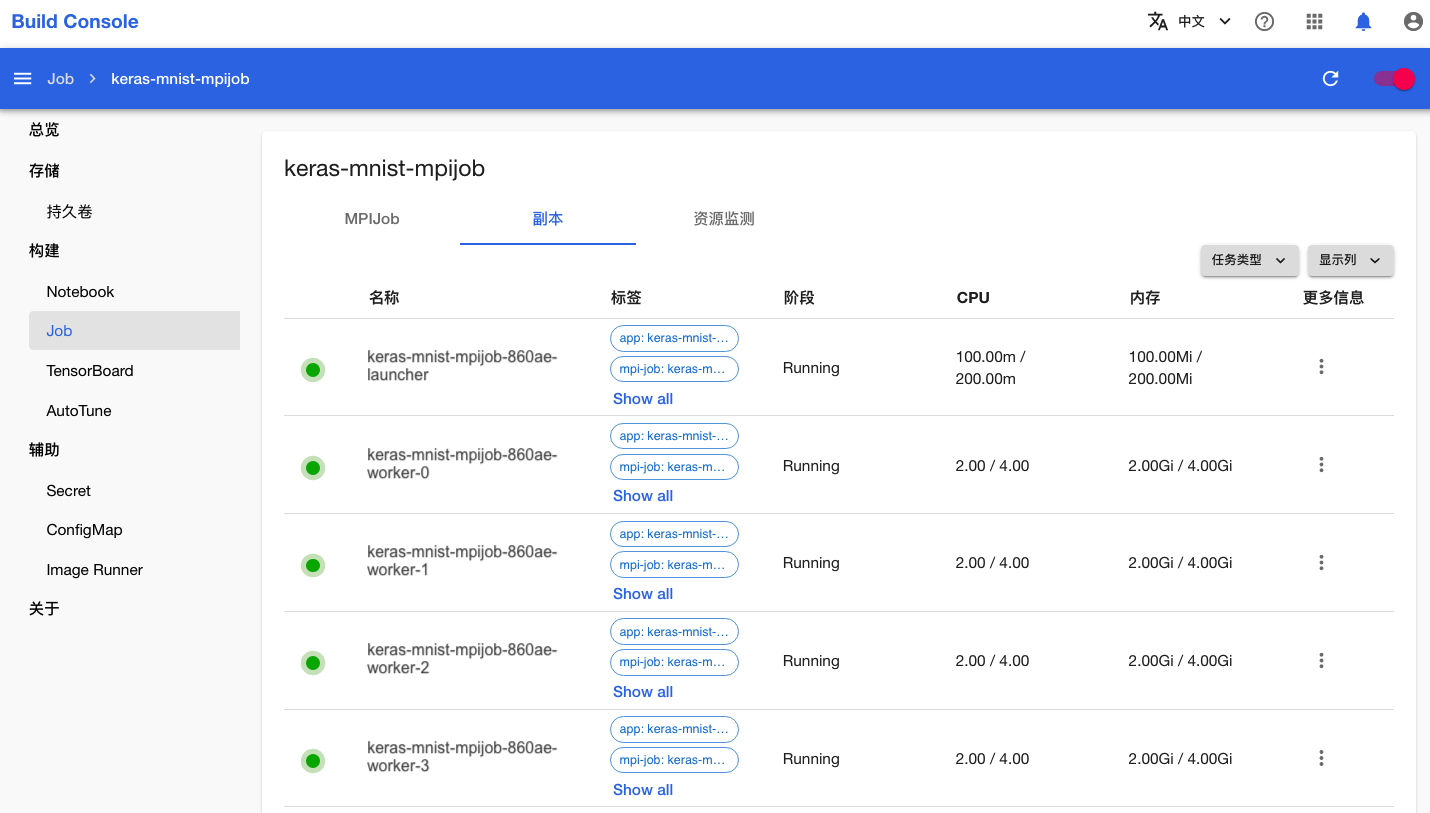

可以看到,Job 及其创建的 4 个 Worker(工作器)正在运行。

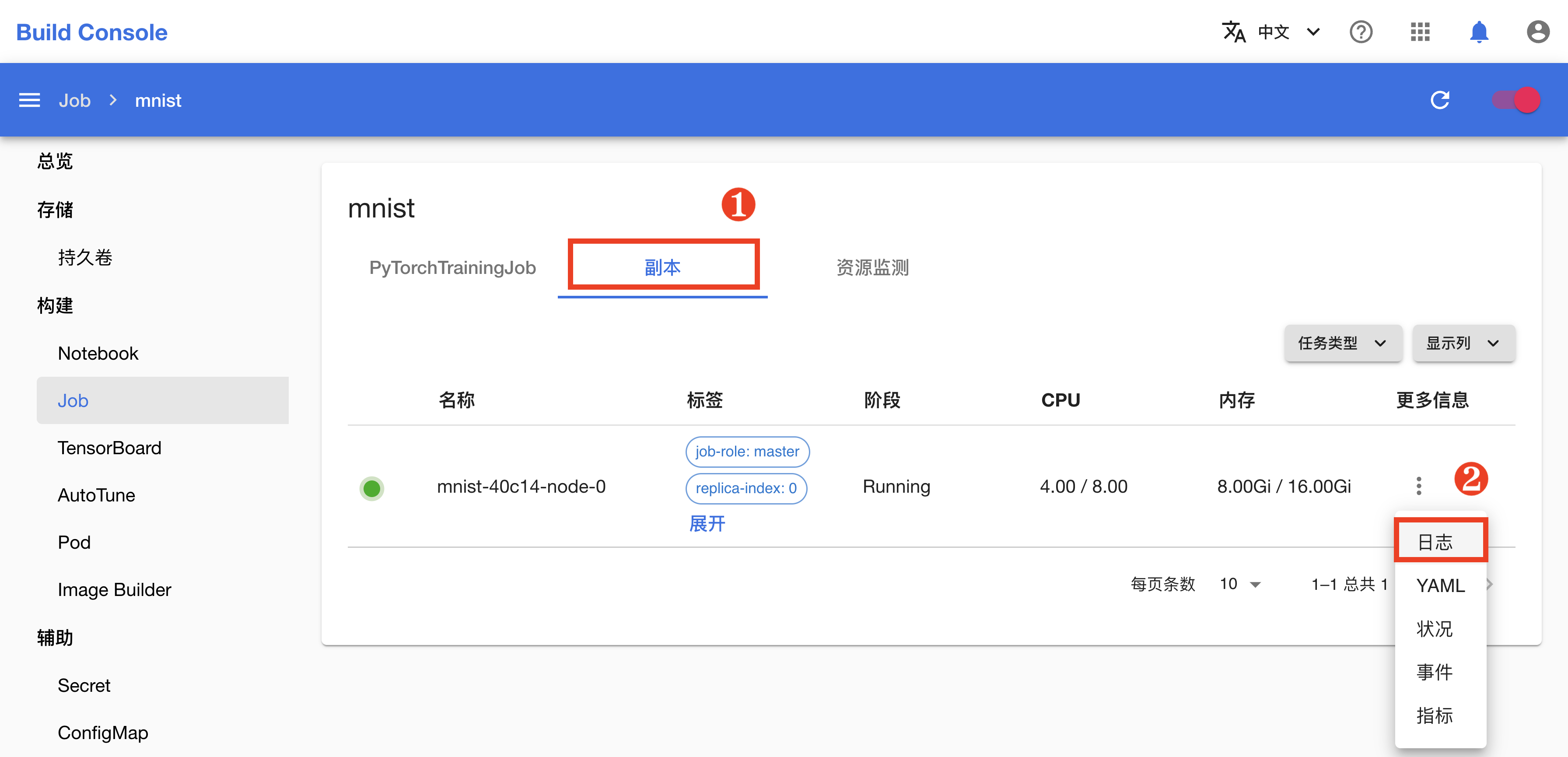

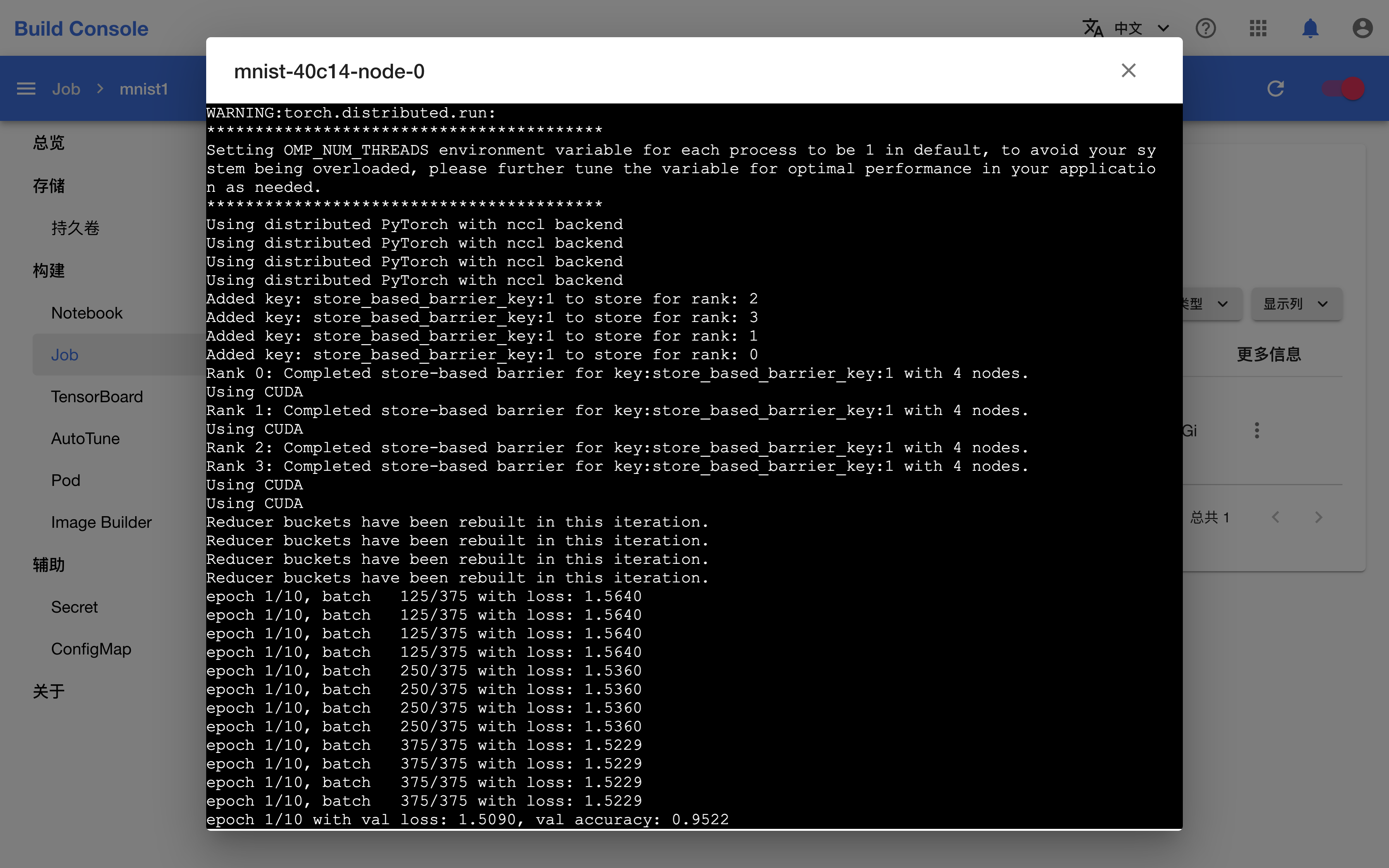

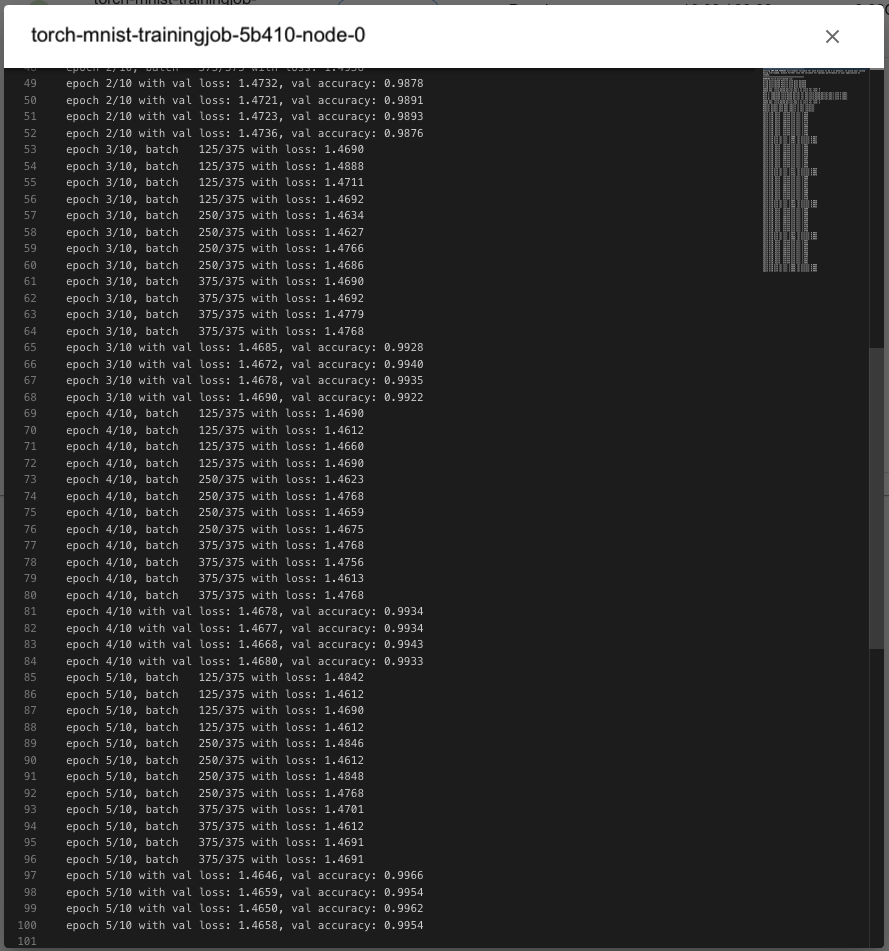

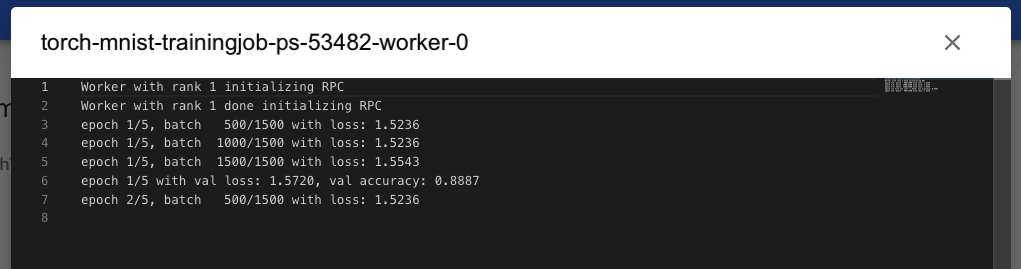

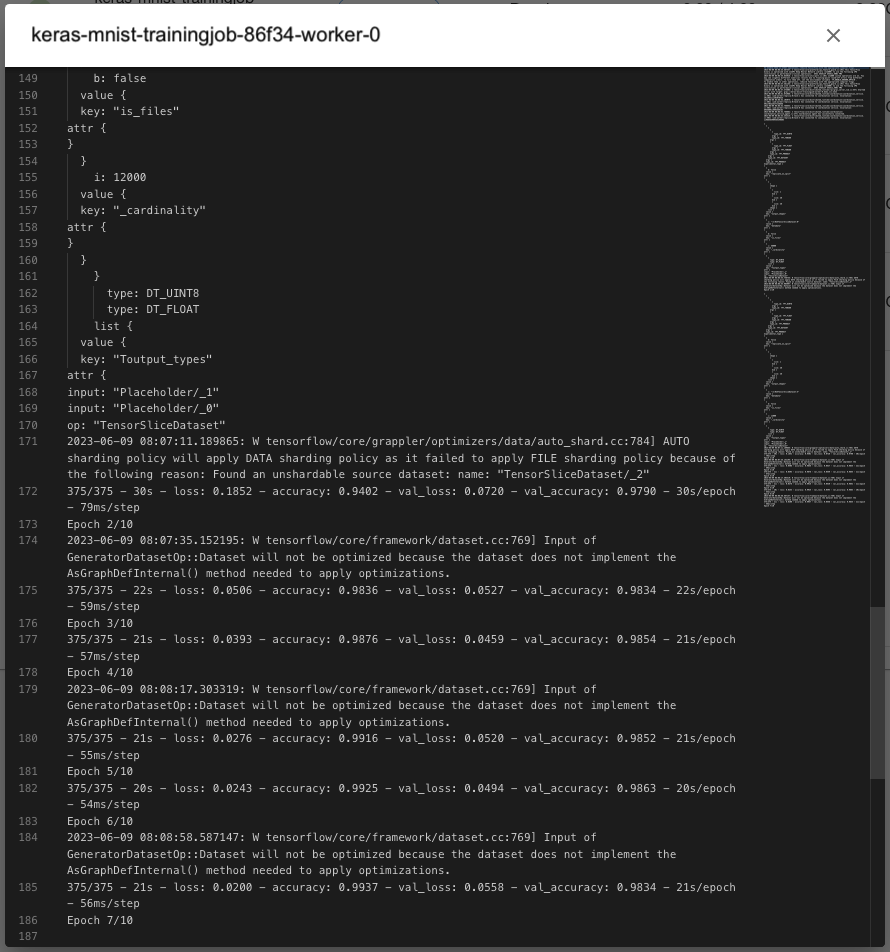

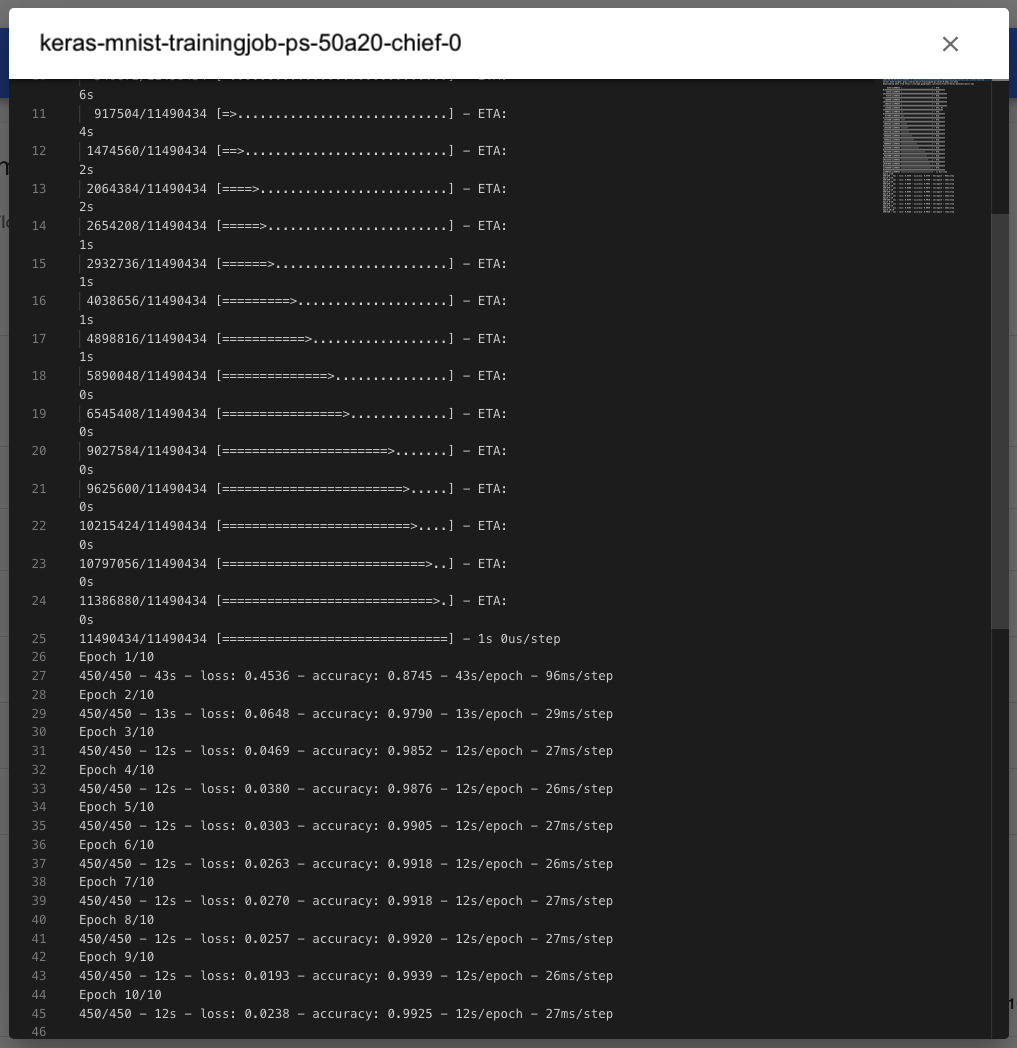

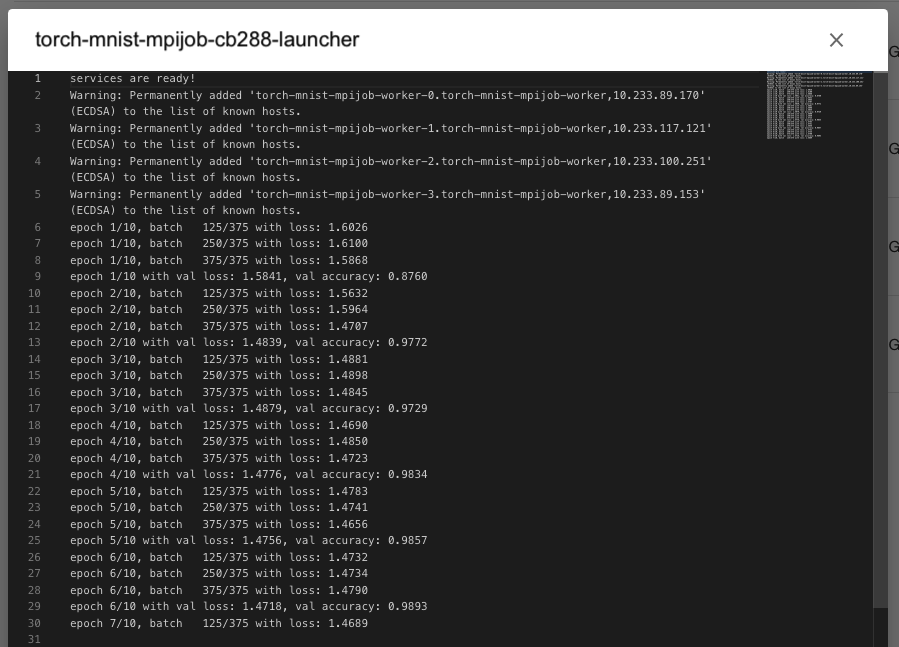

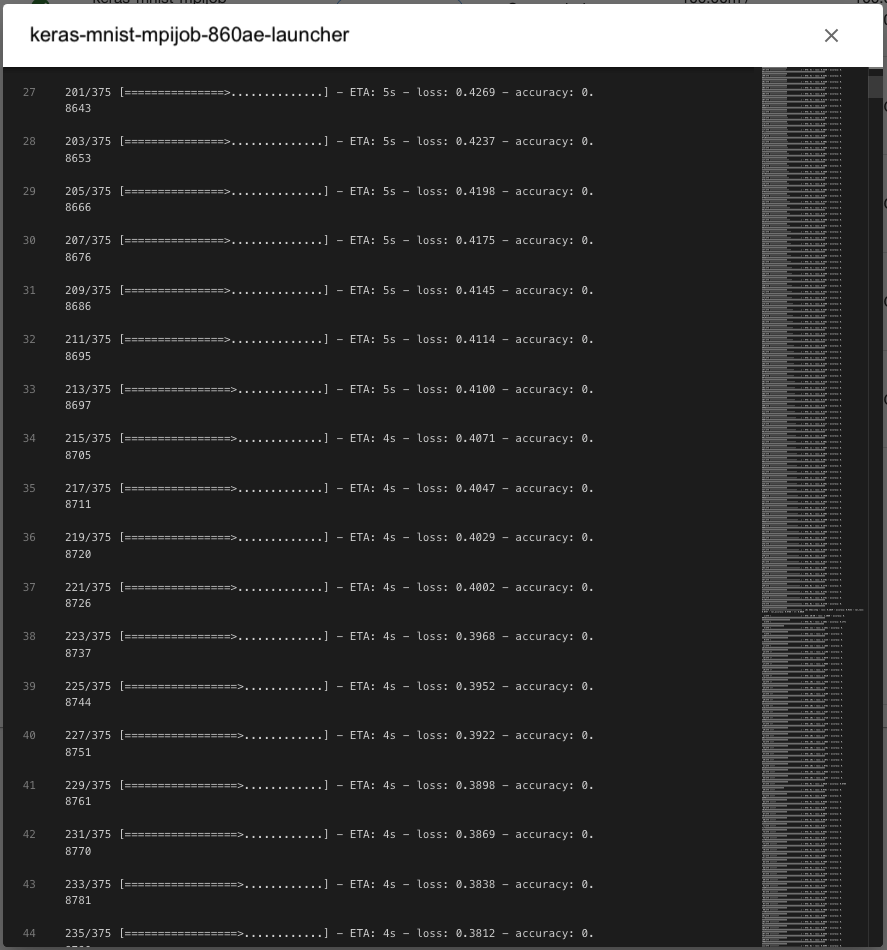

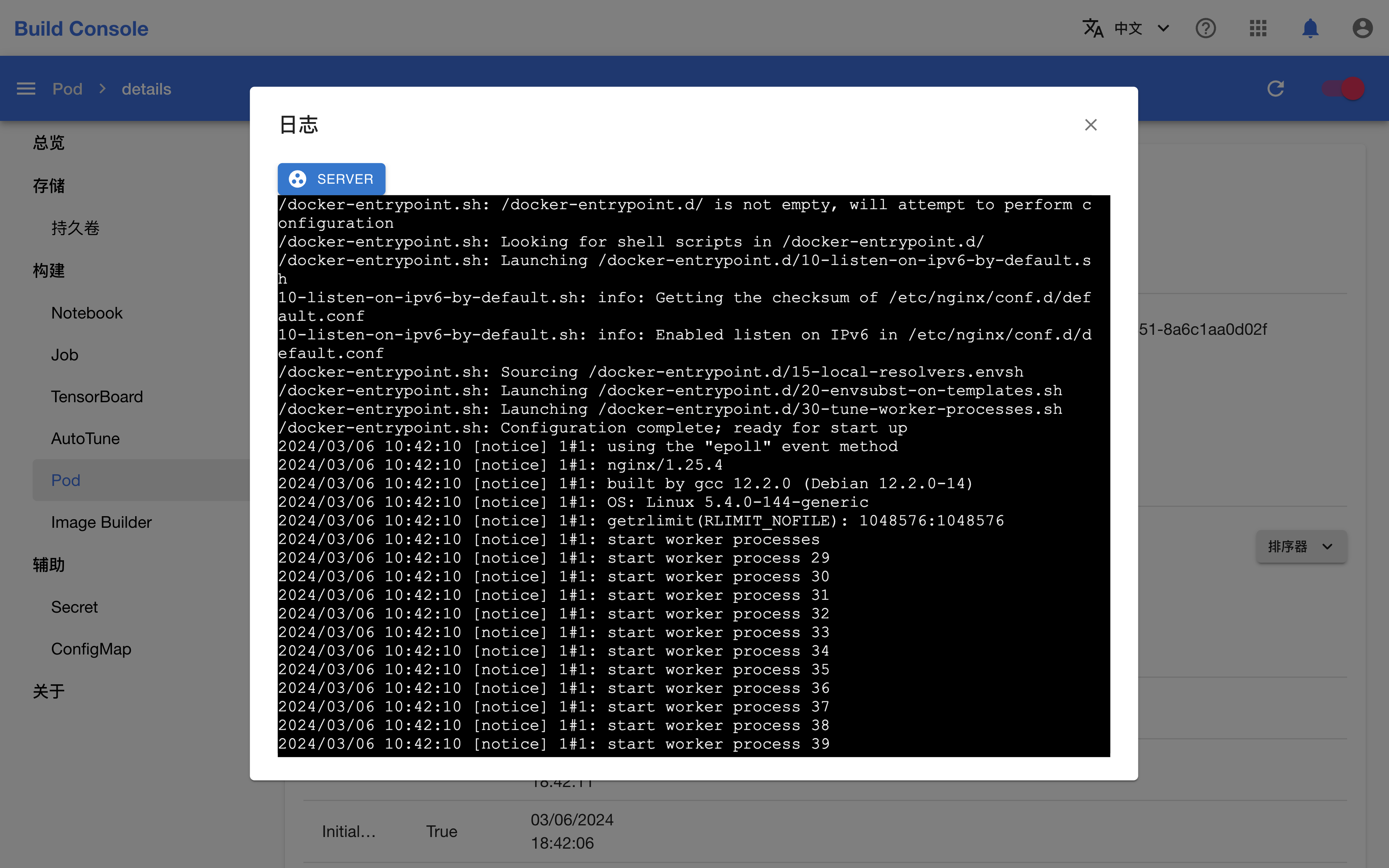

切换到副本标签页,点击副本的日志会显示其命令行输出,可以看到并行训练的当前进度。

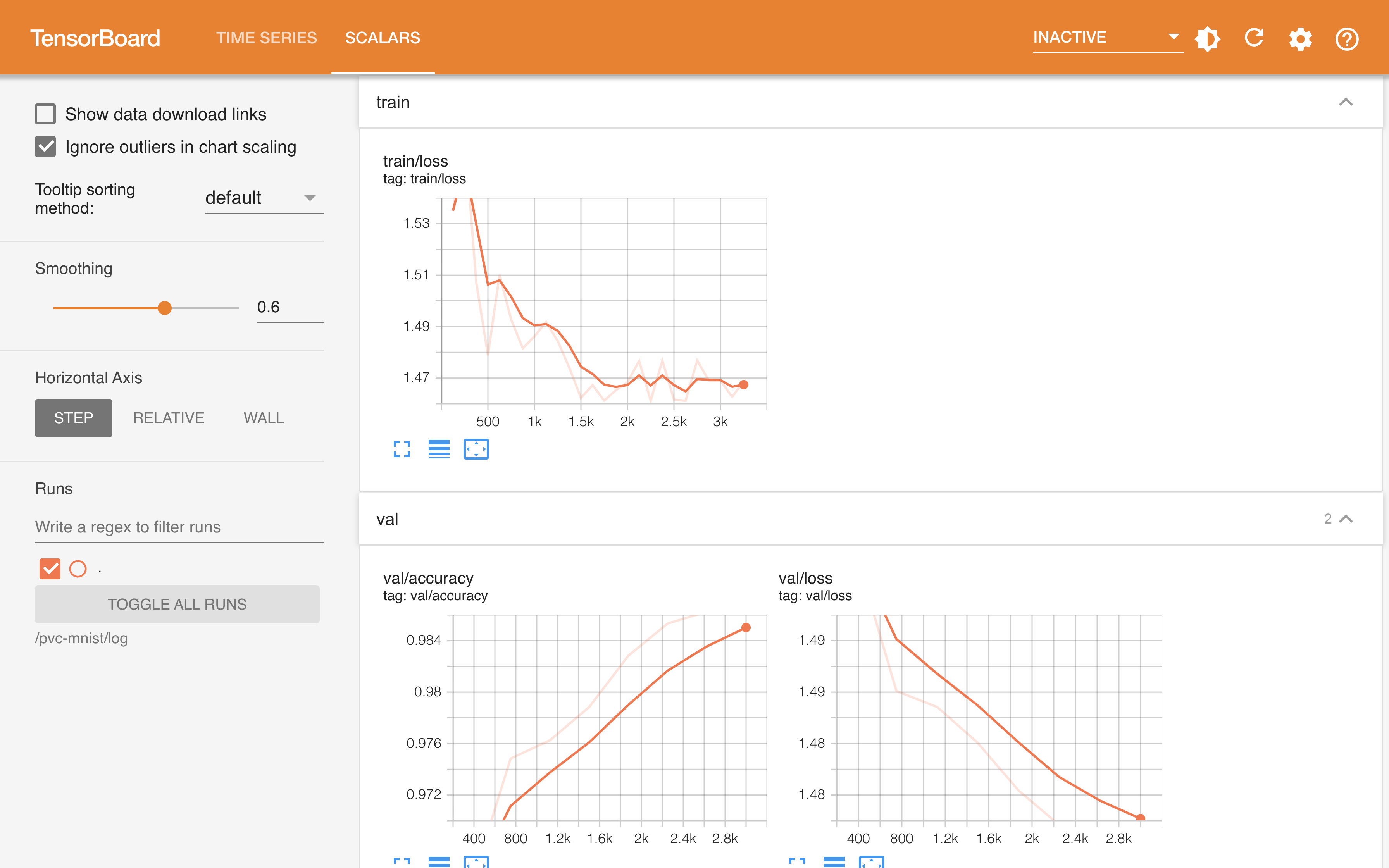

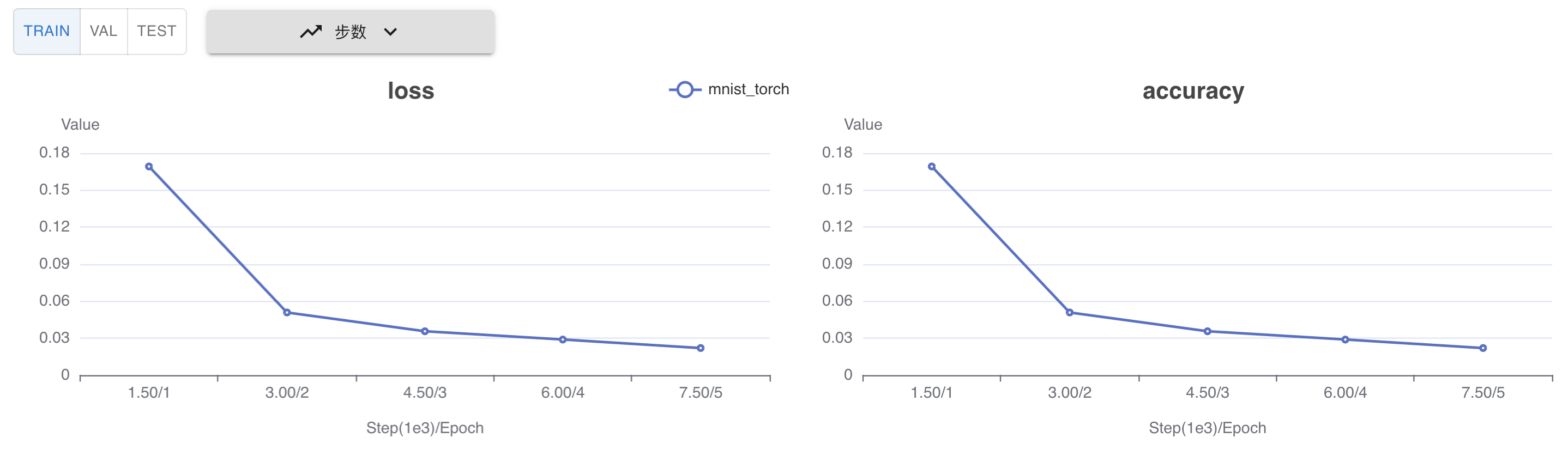

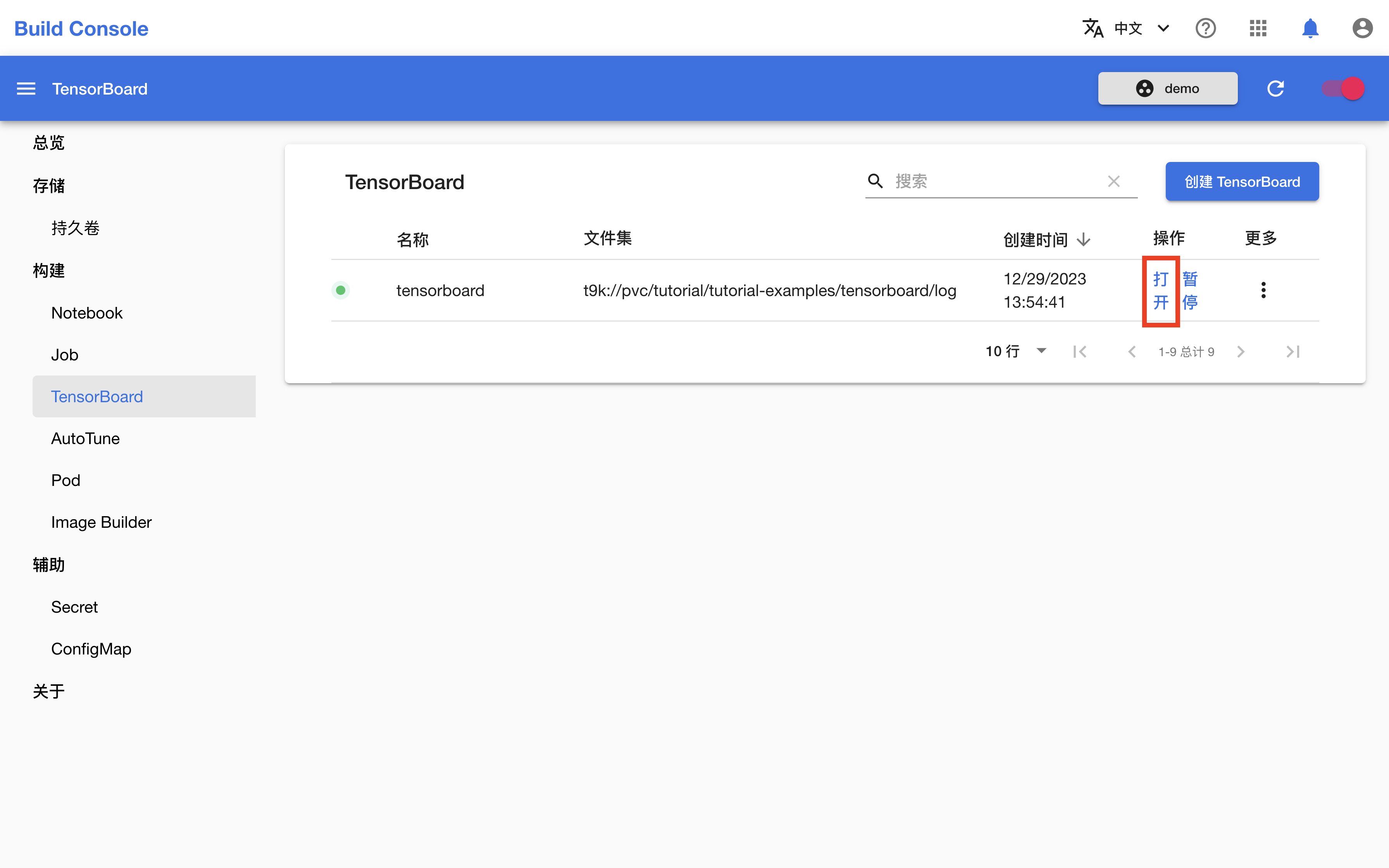

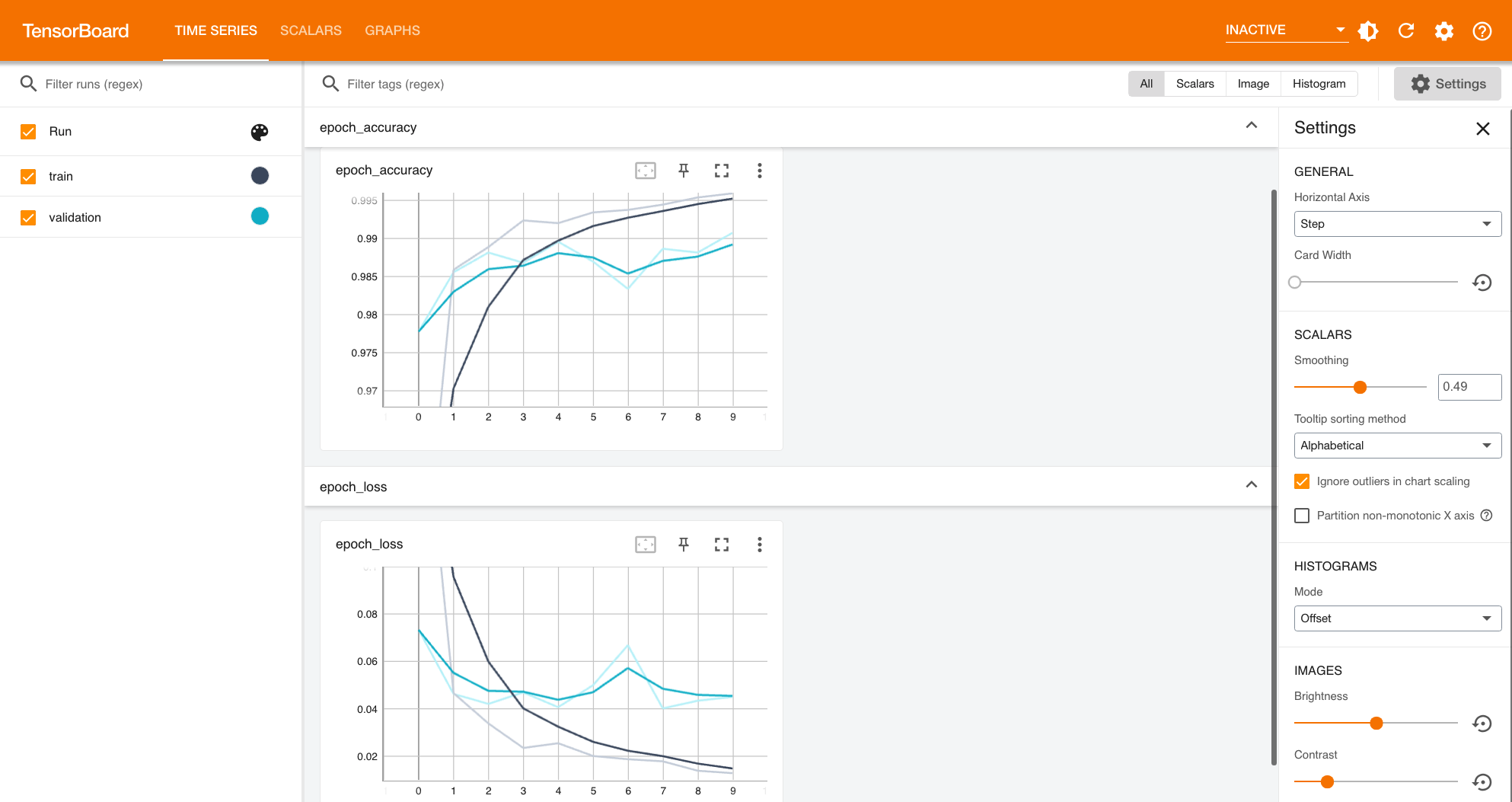

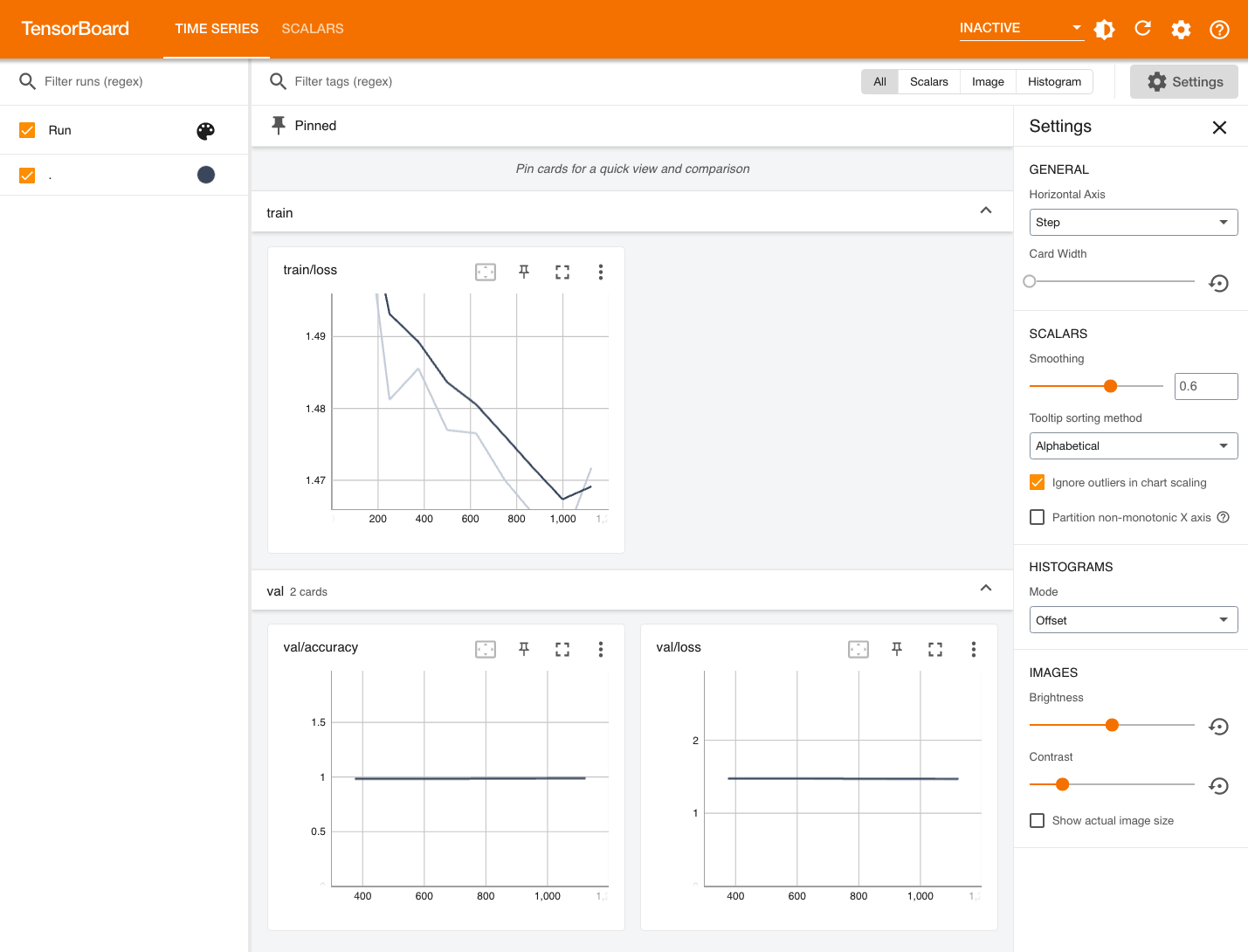

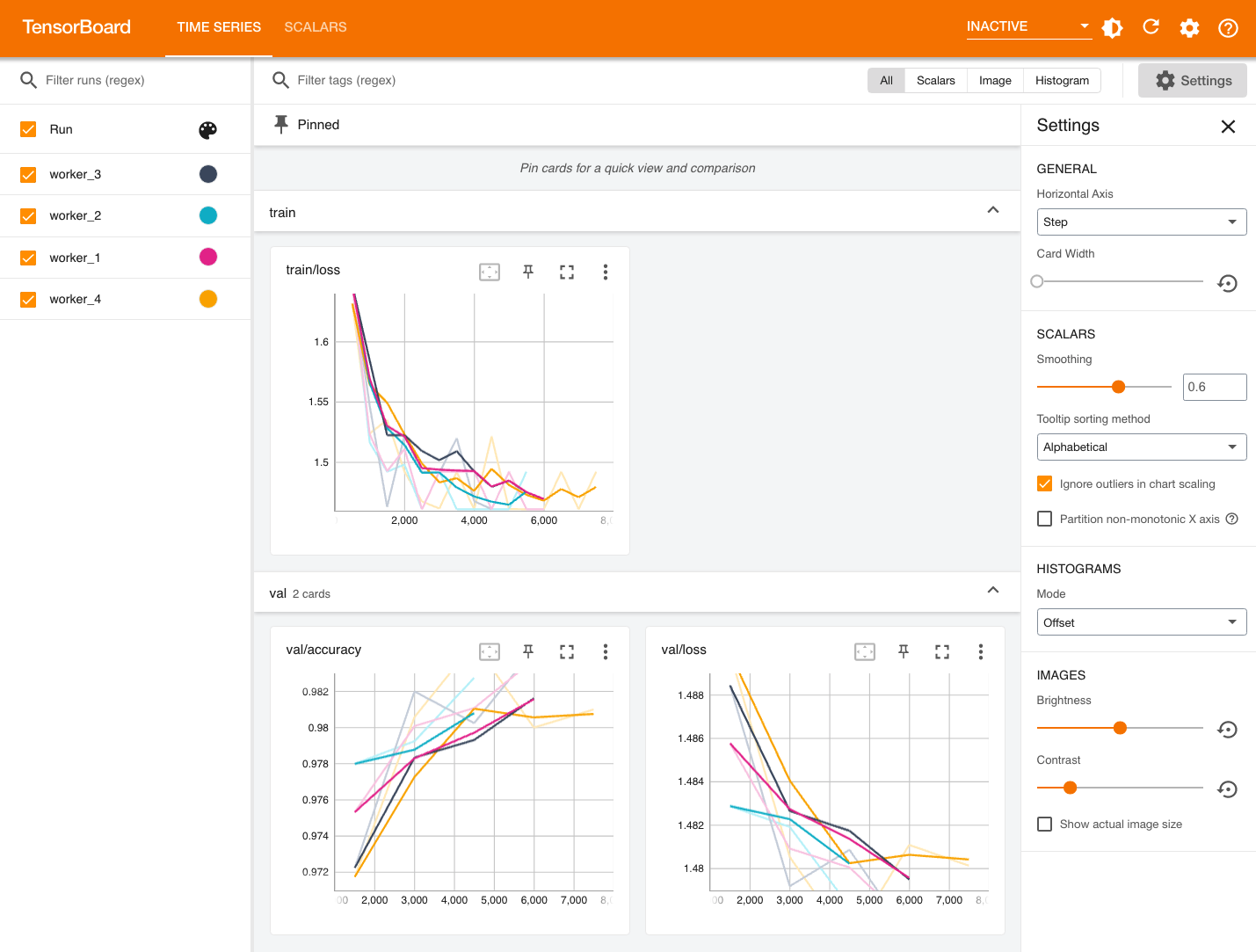

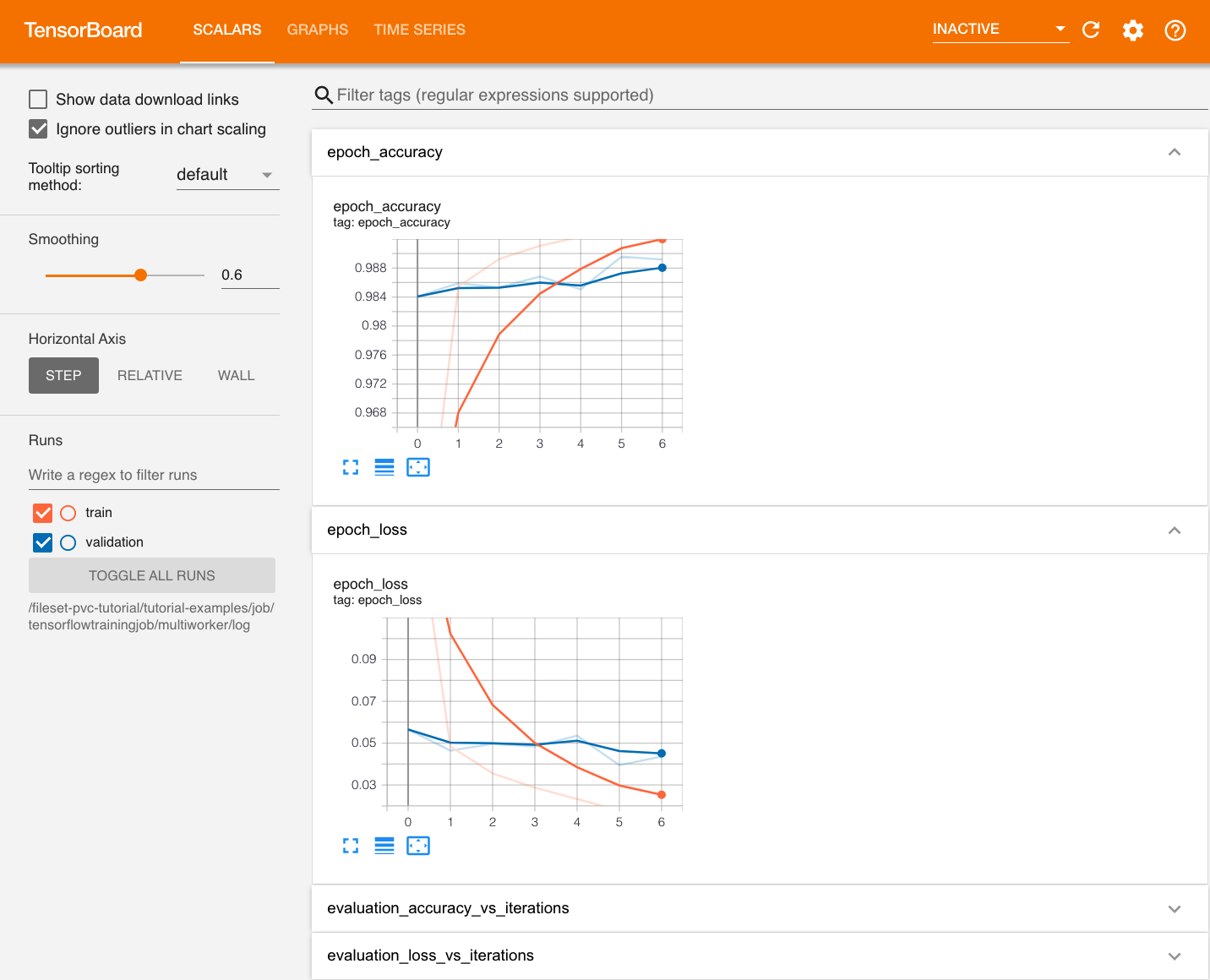

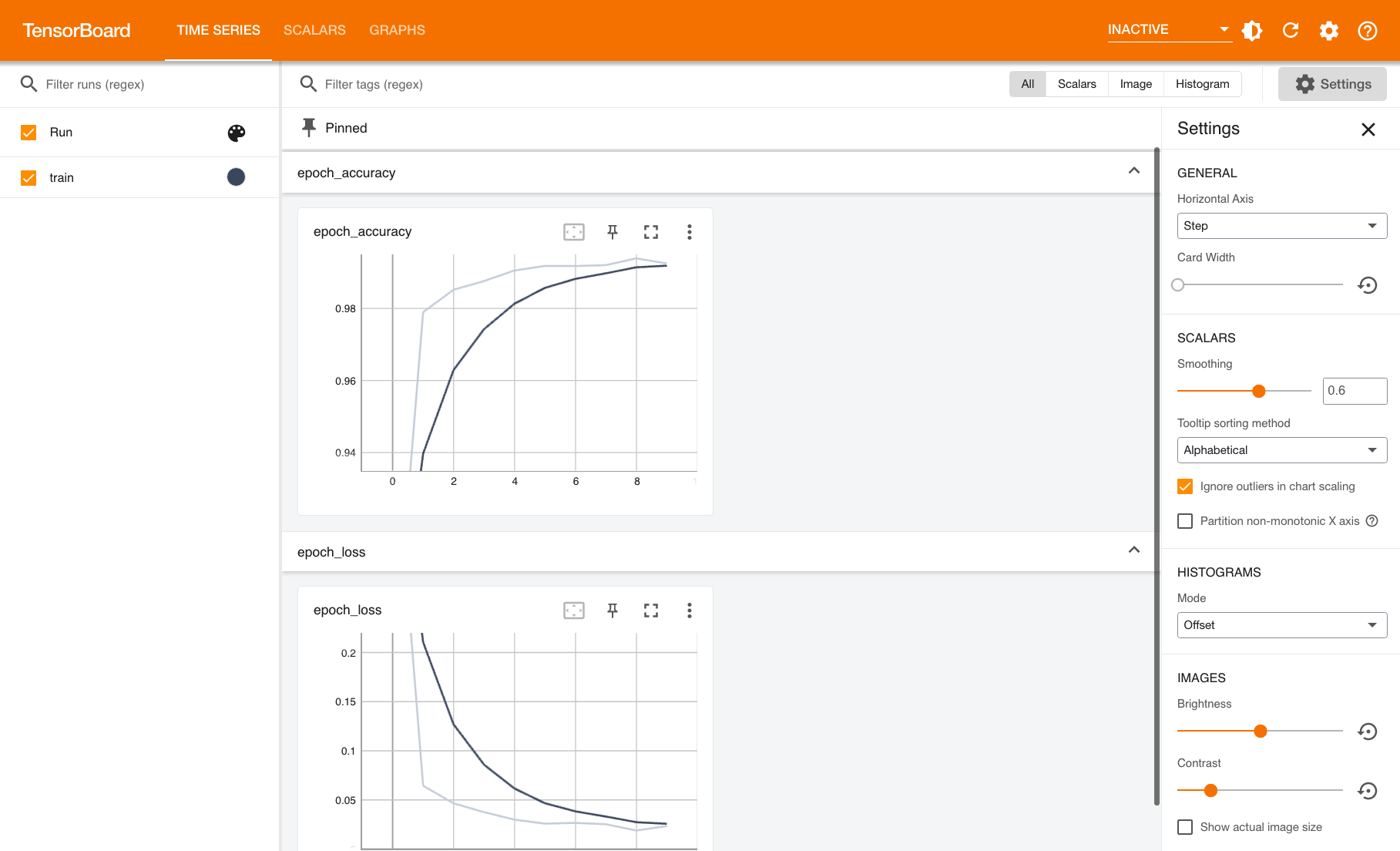

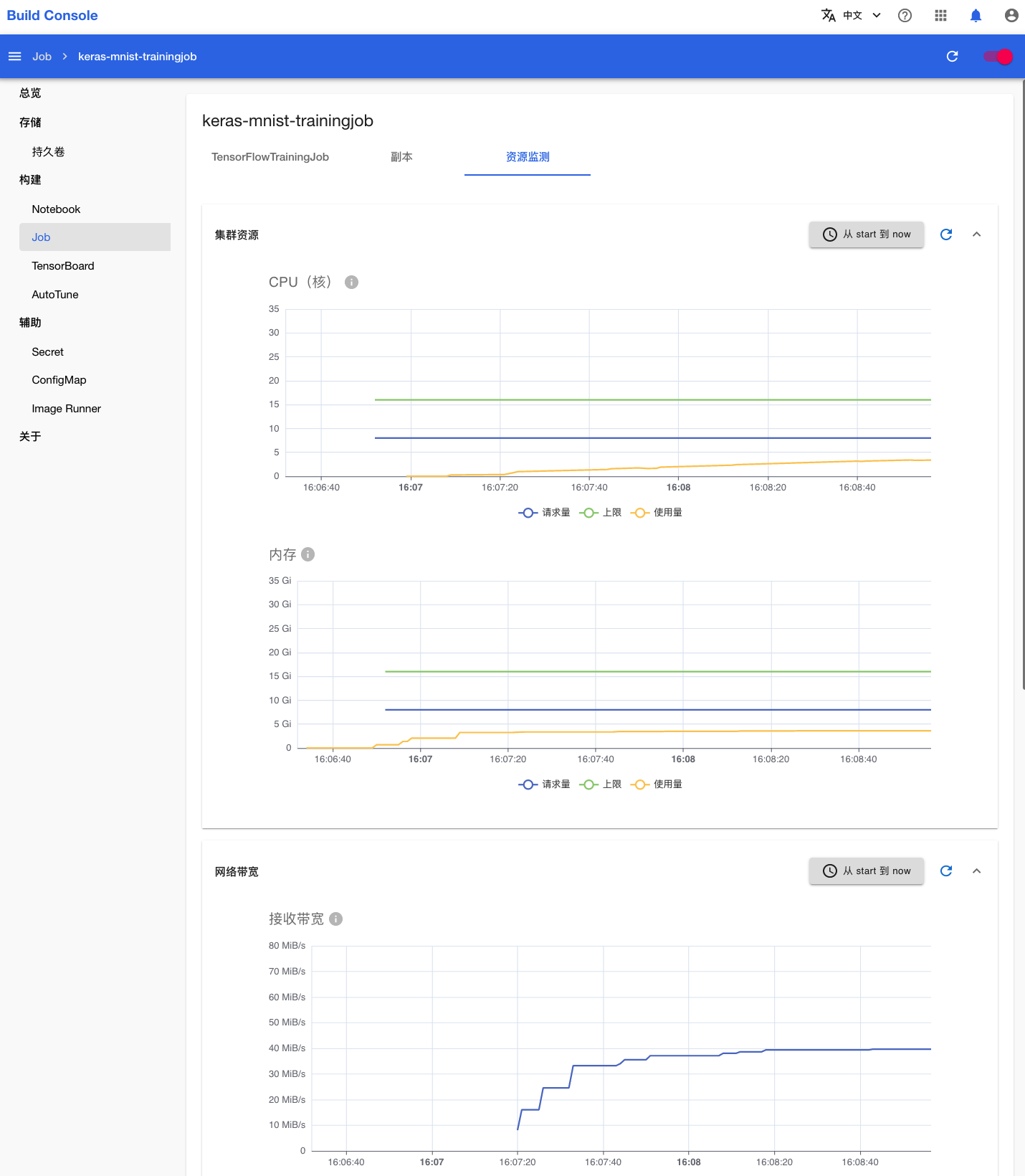

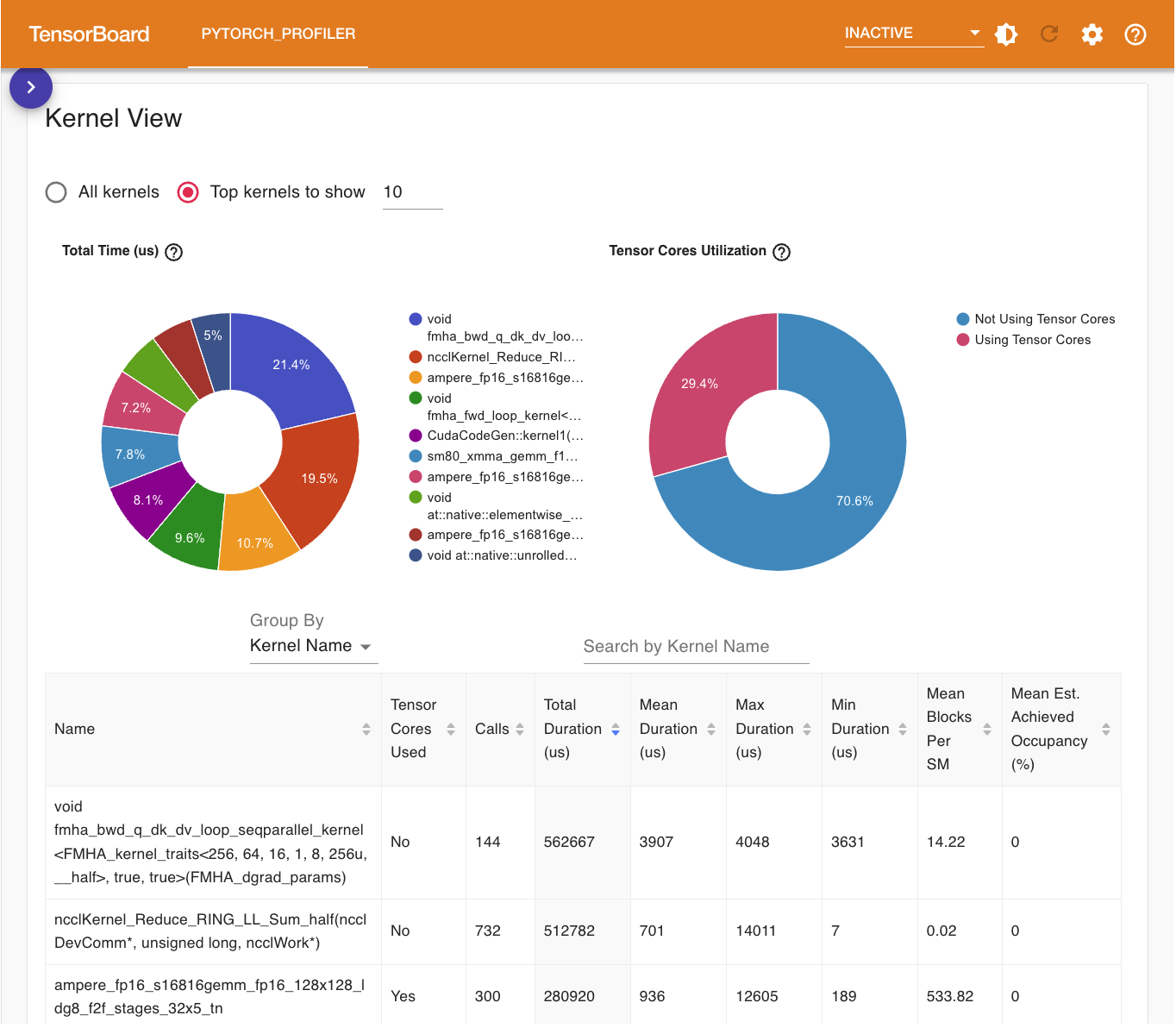

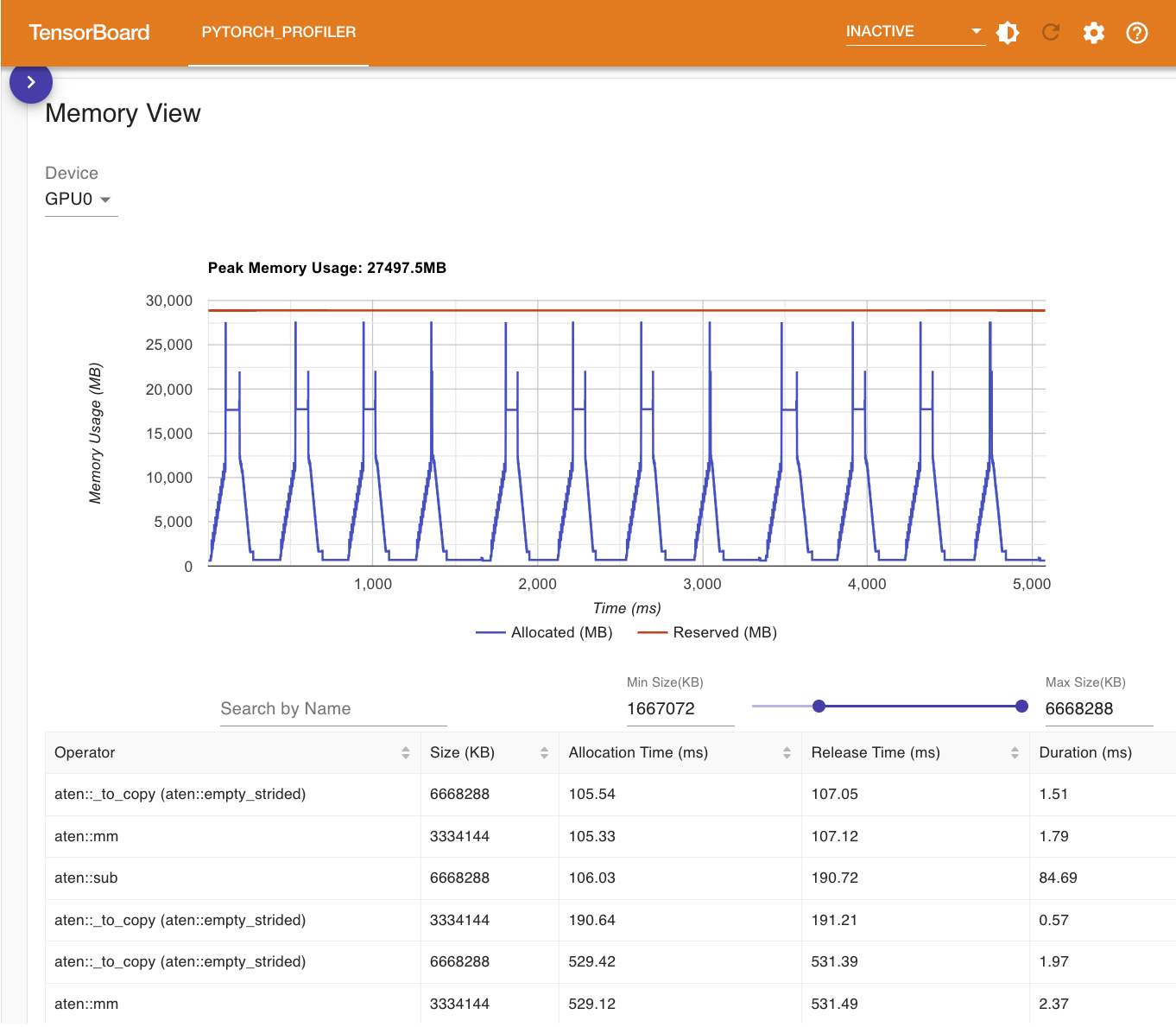

torch_mnist_trainingjob.py 训练脚本在训练过程中添加了 TensorBoard 回调并将日志保存在了 log 目录下,Job 相应地启动了一个 TensorBoard 服务器用于可视化展示这些数据。点击 TensorBoard 右侧的 Running 进入其前端页面。

一段时间之后,Job 的状态变为 Done,表示训练已经成功完成。回到 Notebook mnist,将当前教程产生的所有文件移动到名为 parallel-training 的新文件夹下。

下一步

部署模型

本教程带领你使用 SimpleMLService,部署模型为推理服务。

教程训练你的第一个模型和进行并行训练训练了相同架构的模型,并且都将模型参数保存为文件 model_state_dict.pt。本教程将这两个模型文件中的任意一个部署为推理服务。

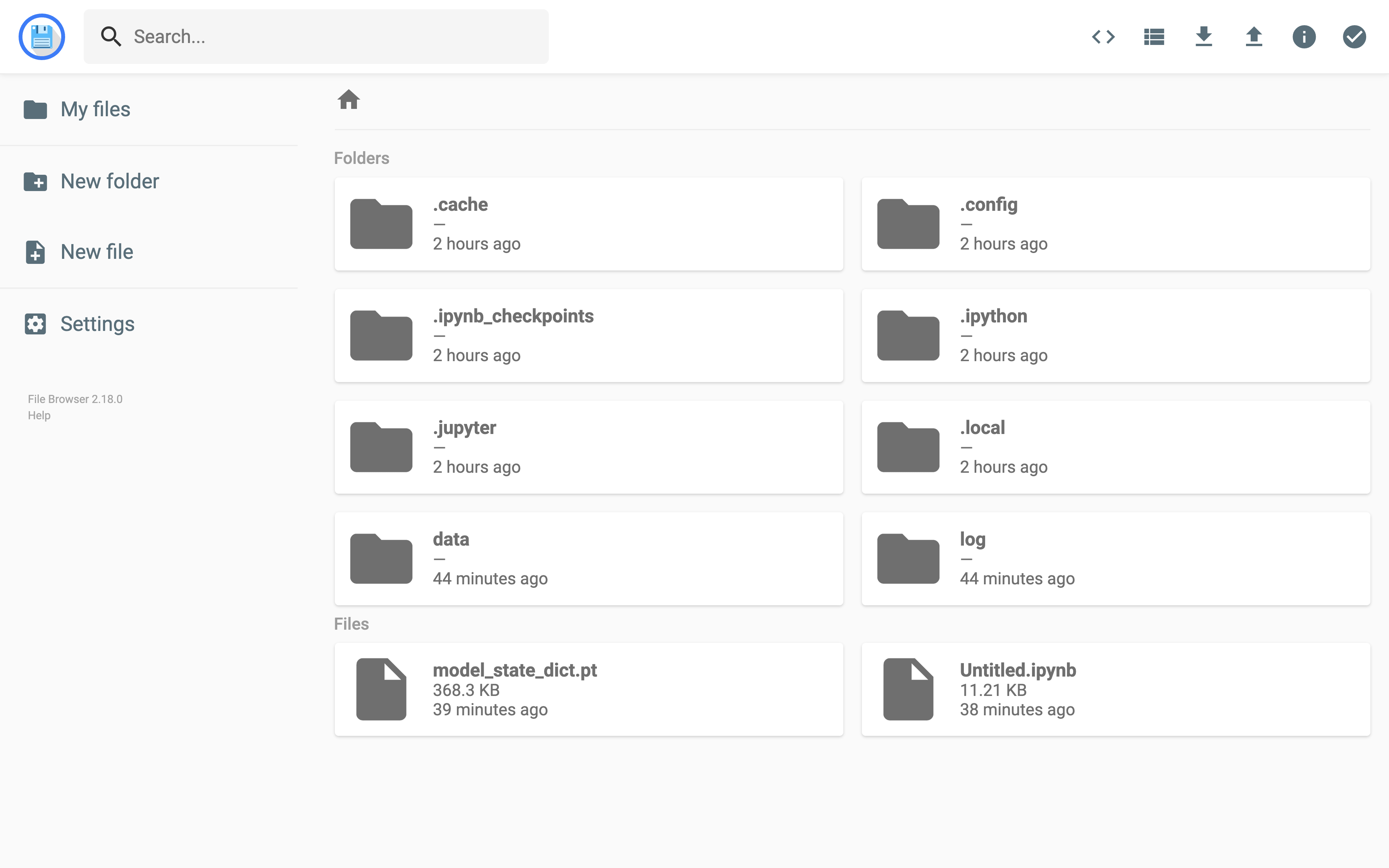

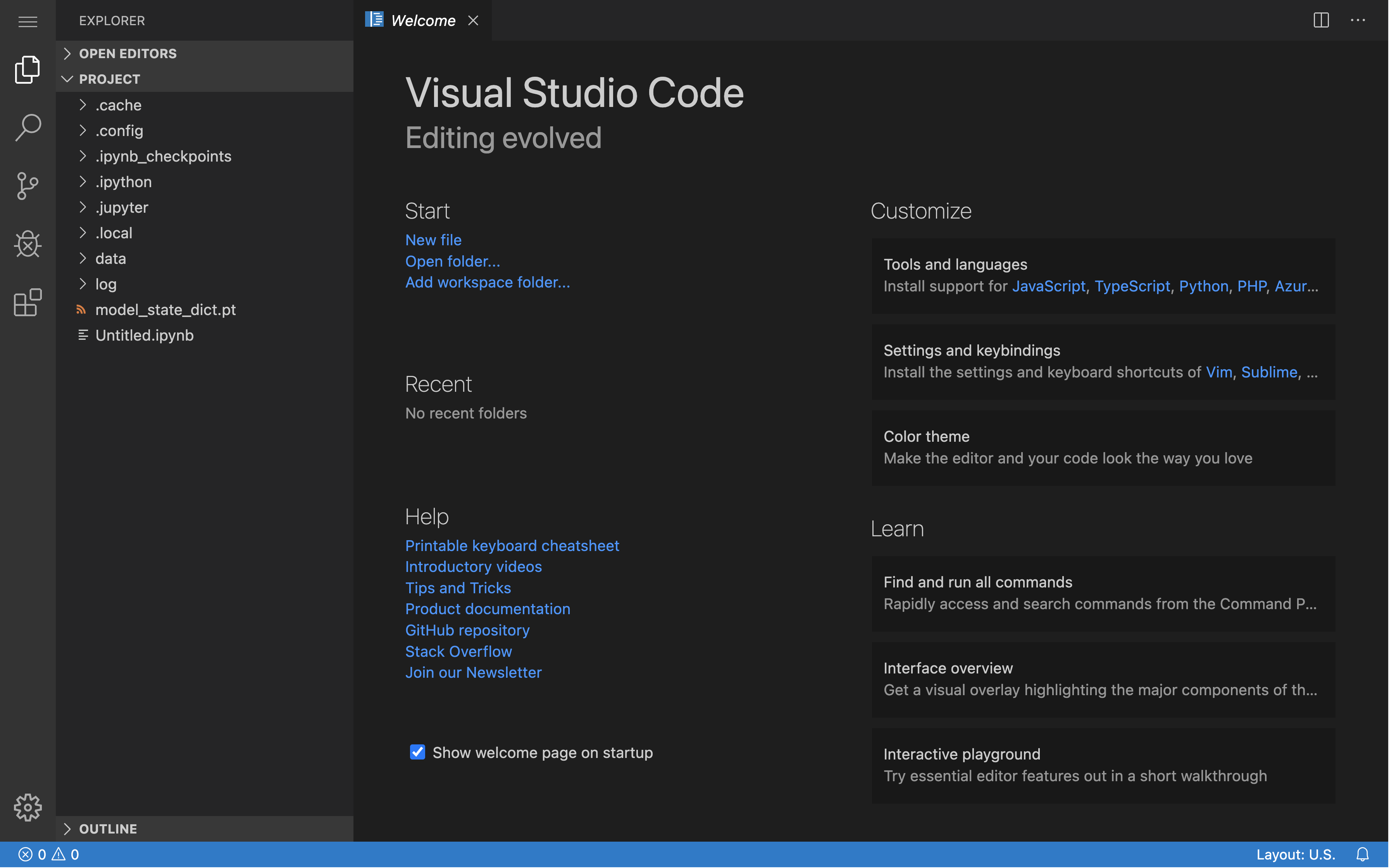

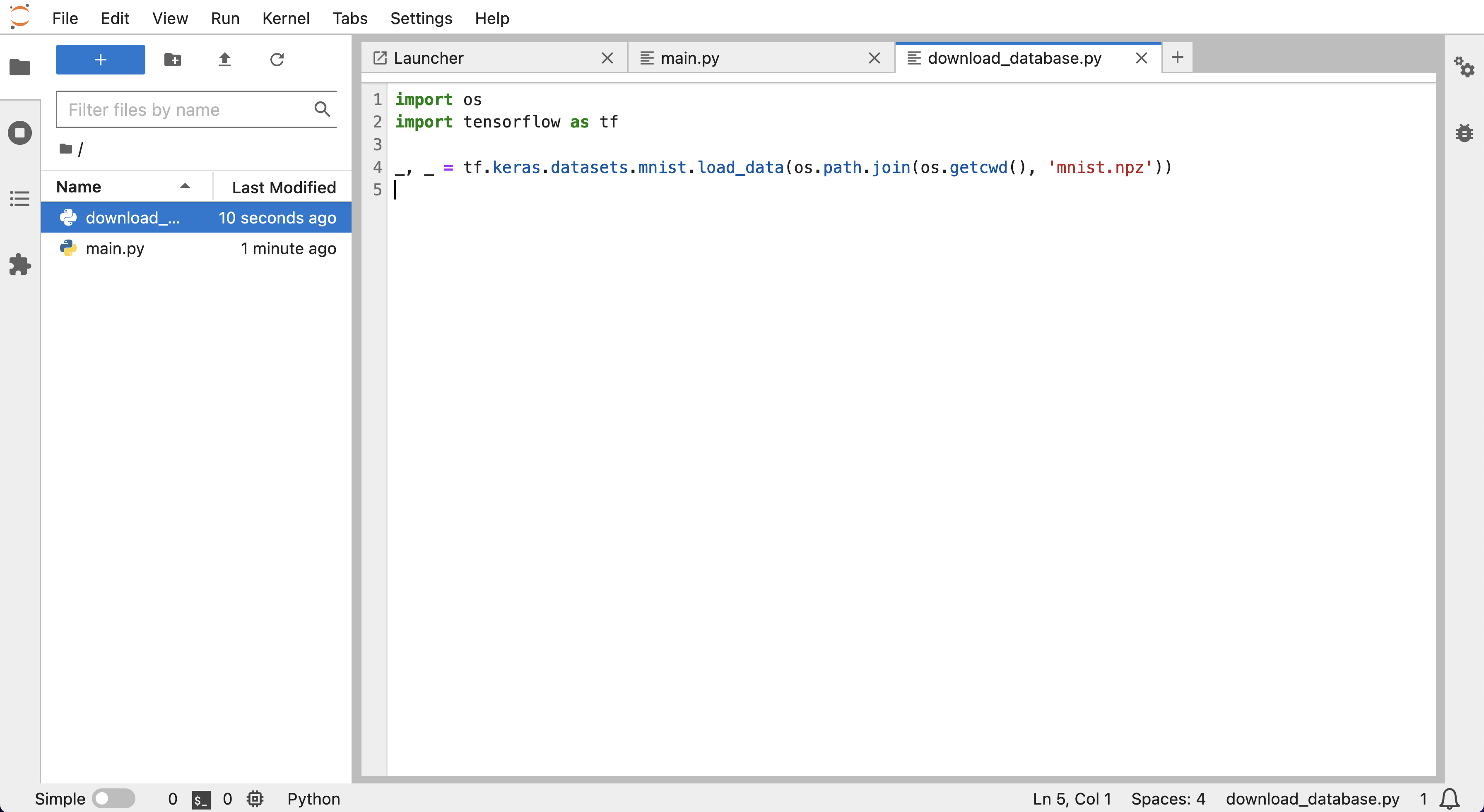

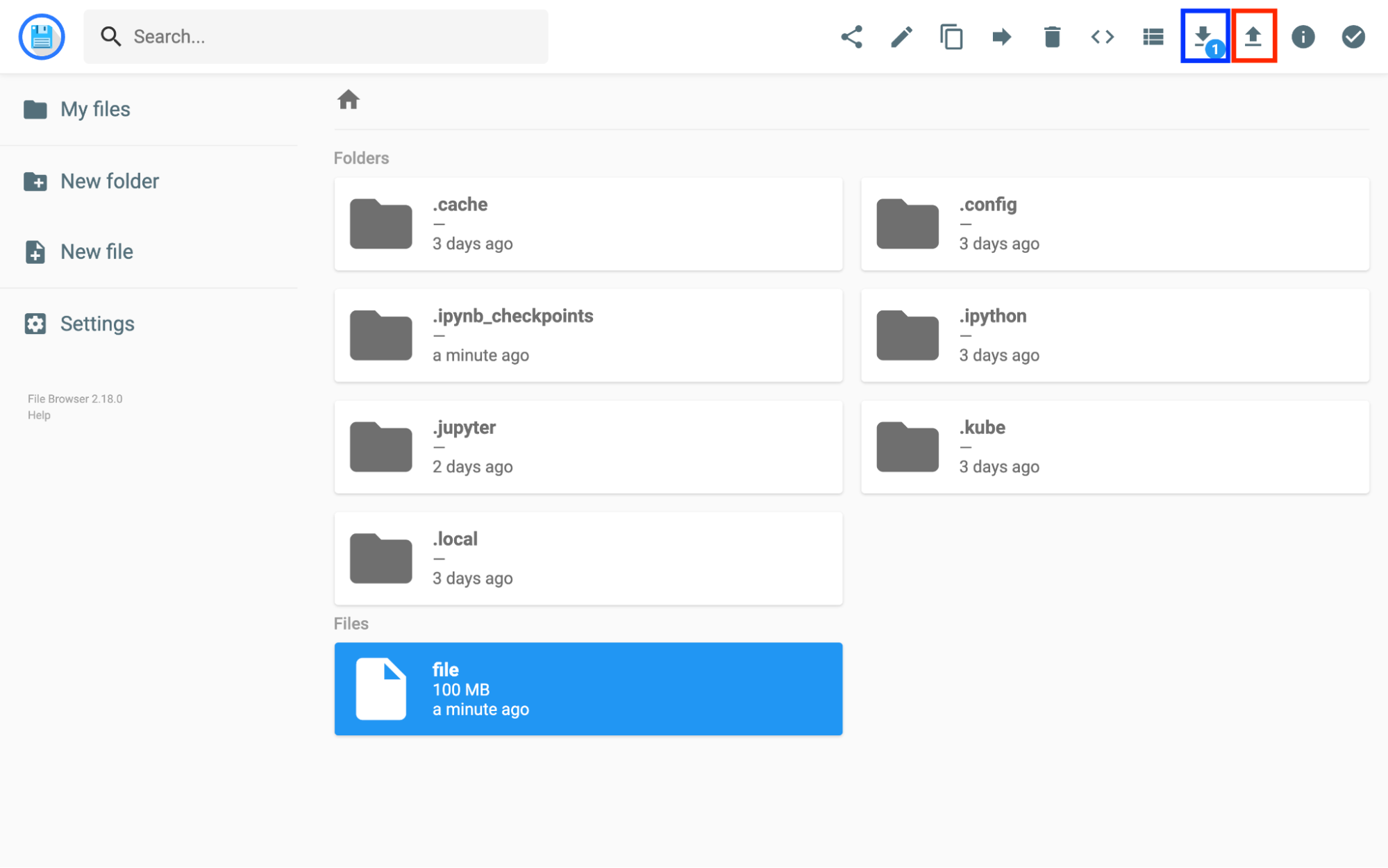

准备模型文件

这里我们使用 TorchServe 部署 PyTorch 模型。回到 Notebook mnist,在 HOME 目录(即左侧边栏文件浏览器显示的根目录 /)下新建以下文件:

model.py

import torch

from torch import nn

import torch.nn.functional as F

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(1, 32, 3, 1)

self.conv2 = nn.Conv2d(32, 64, 3, 1)

self.conv3 = nn.Conv2d(64, 64, 3, 1)

self.pool = nn.MaxPool2d(2, 2)

self.dense1 = nn.Linear(576, 64)

self.dense2 = nn.Linear(64, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = F.relu(self.conv3(x))

x = torch.flatten(x, 1)

x = F.relu(self.dense1(x))

output = F.log_softmax(self.dense2(x), dim=1)

return output

handler.py

from torchvision import transforms

from ts.torch_handler.image_classifier import ImageClassifier

from torch.profiler import ProfilerActivity

class MNISTDigitClassifier(ImageClassifier):

image_processing = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5), (0.5))])

def __init__(self):

super().__init__()

self.profiler_args = {

"activities": [ProfilerActivity.CPU],

"record_shapes": True,

}

# def postprocess(self, data):

# return data.argmax(1).tolist()

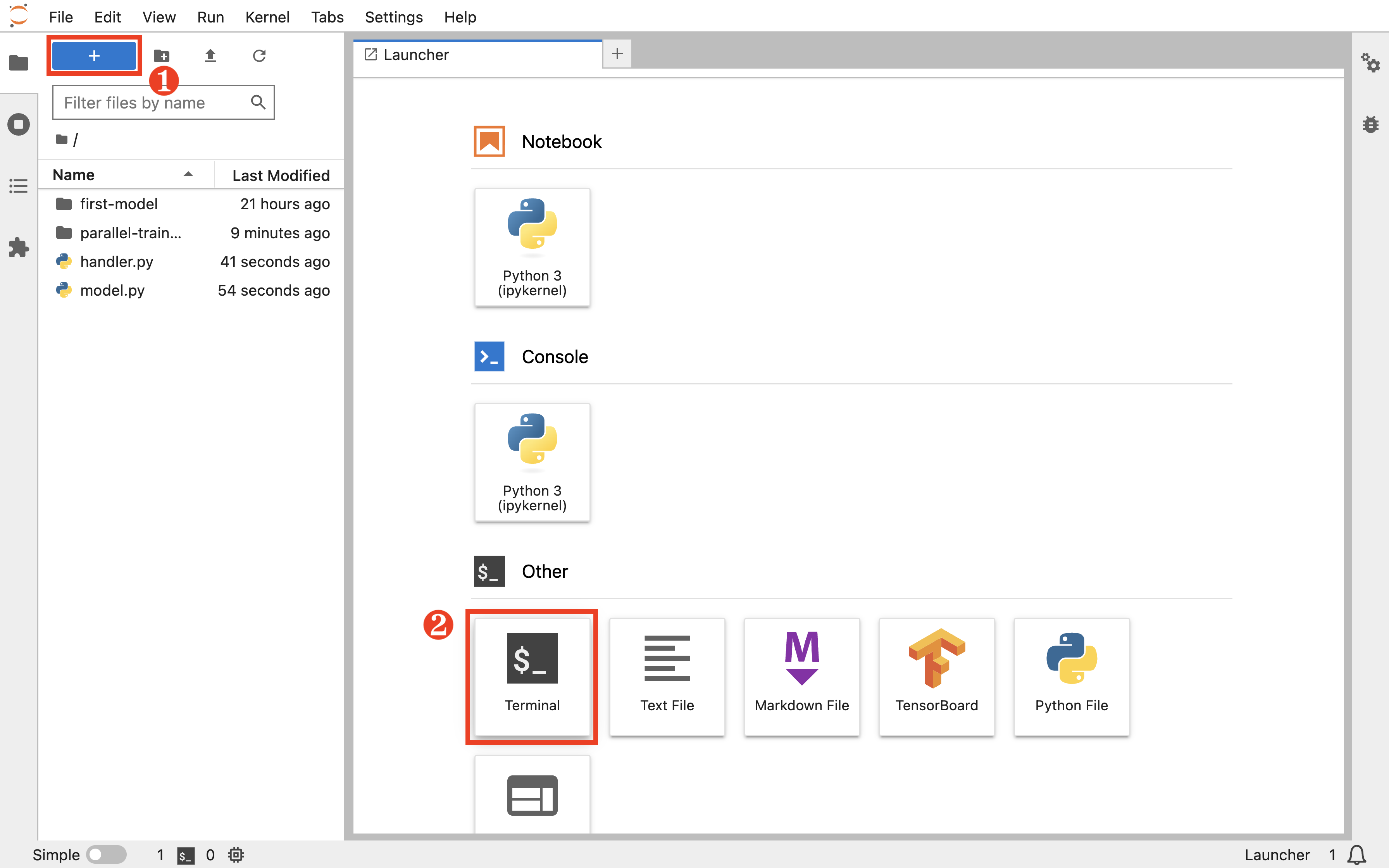

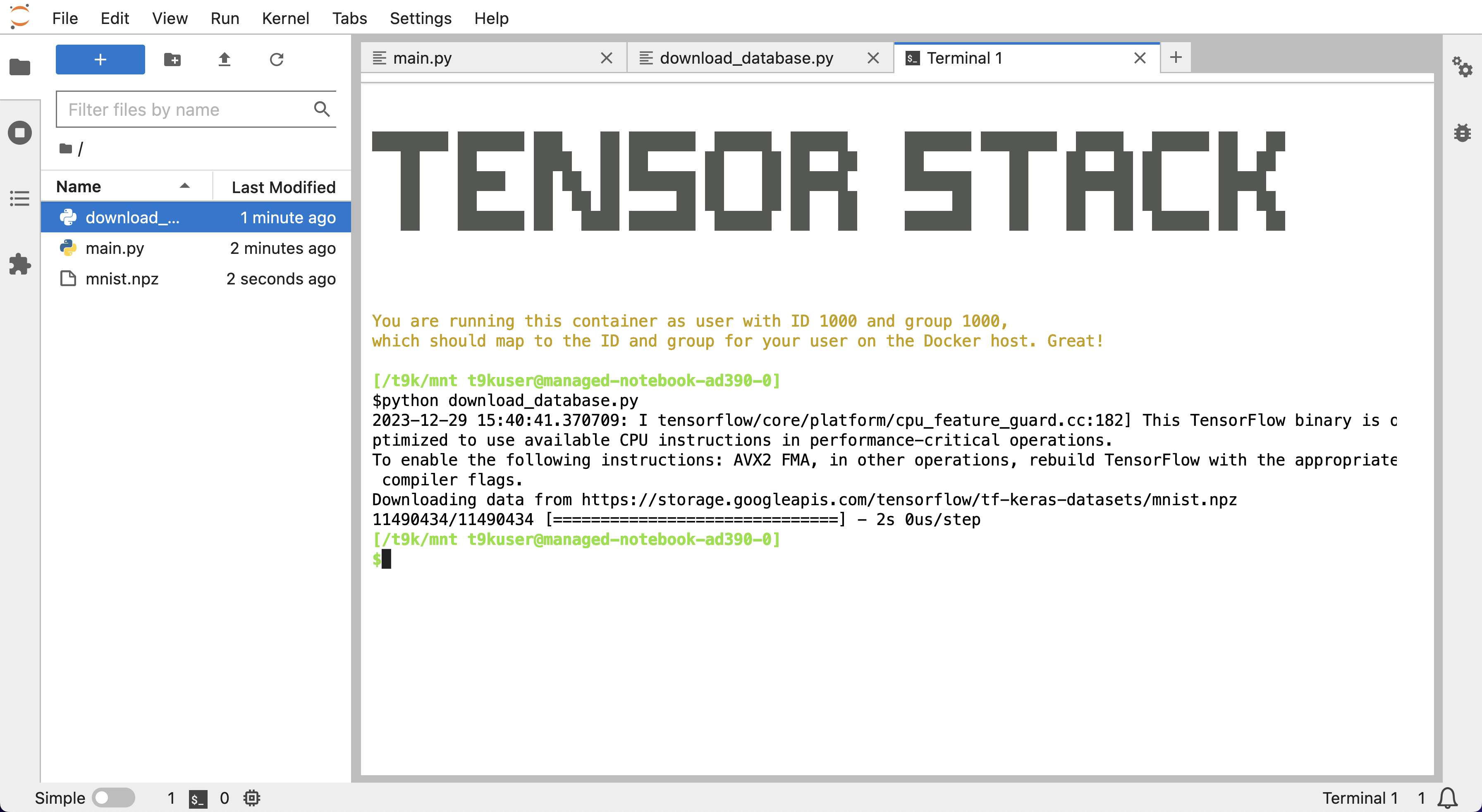

点击左上角的 +,然后点击 Other 下的 Terminal 以新建一个终端。

执行以下命令以打包一个 torch 的模型包(model archive):

# 使用 Notebook 中训练的模型

torch-model-archiver --model-name mnist \

--version 1.0 \

--model-file model.py \

--handler handler.py \

--serialized-file first-model/model_state_dict.pt

# 如果使用 Job 中训练的模型,切换参数

# --serialized-file parallel-training/model_state_dict.pt

部署推理服务

在 TensorStack AI 平台首页,点击Deploy进入模型部署控制台。

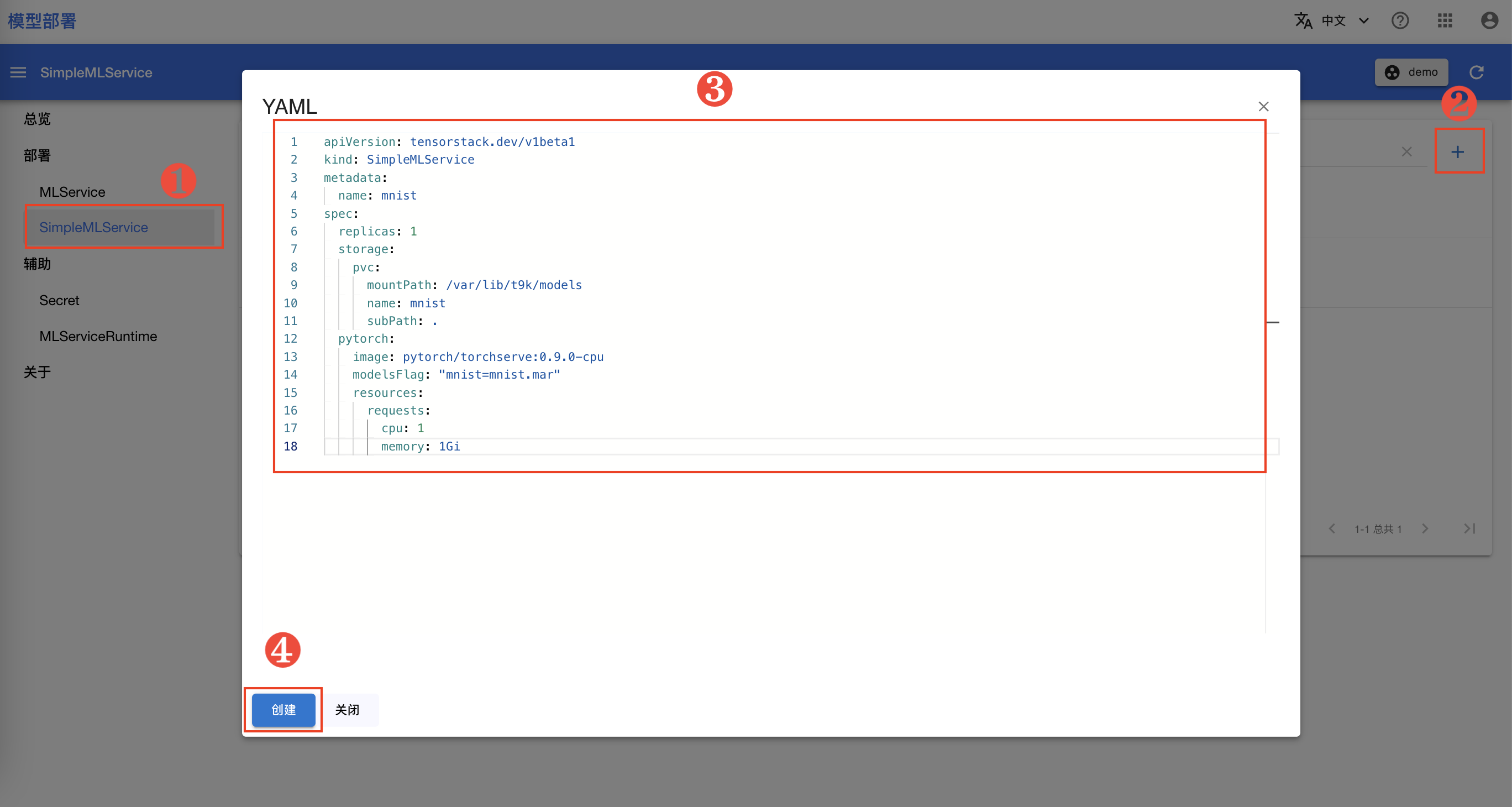

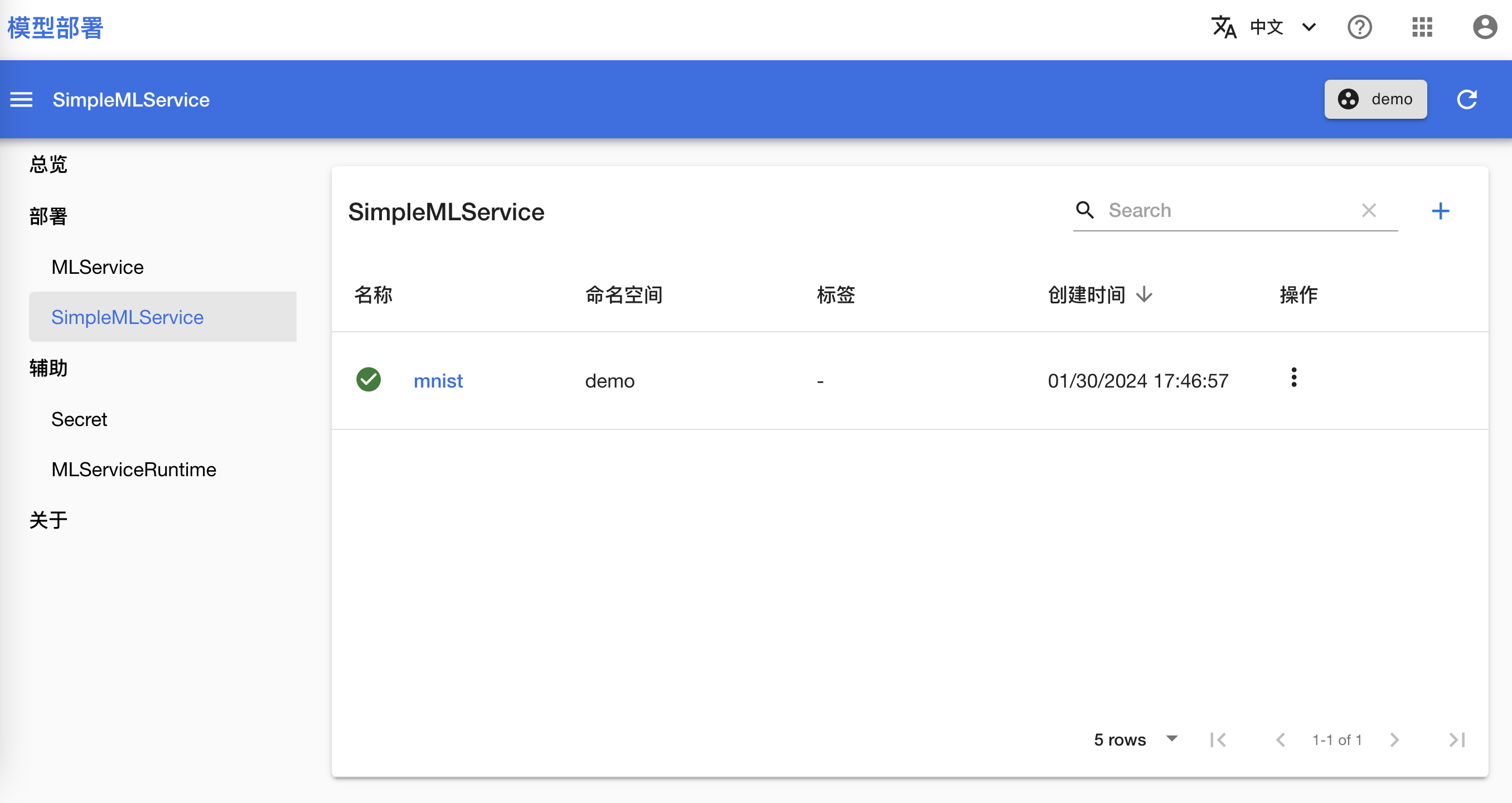

模型部署控制台的总览页面展示了当前部署服务的数量以及资源使用情况。在左侧的导航菜单中点击部署 > SimpleMLService,点击右上角的 + 弹出创建对话框,然后复制下面的 YAML 配置文件并粘贴到编辑框中,最后点击创建。

apiVersion: tensorstack.dev/v1beta1

kind: SimpleMLService

metadata:

name: mnist

spec:

replicas: 1

storage:

pvc:

mountPath: /var/lib/t9k/models

name: mnist

subPath: .

pytorch:

image: pytorch/torchserve:0.9.0-cpu

modelsFlag: "mnist=mnist.mar"

resources:

requests:

cpu: 1

memory: 1Gi

在跳转回到 SimpleMLService 管理页面之后,等待刚才创建的 SimpleMLService 准备就绪。

- 第一次拉取镜像可能会花费较长的时间,具体取决于集群的网络状况。

- 点击右上角的刷新按钮以手动刷新 SimpleMLService 状态。

使用推理服务

查看推理服务地址

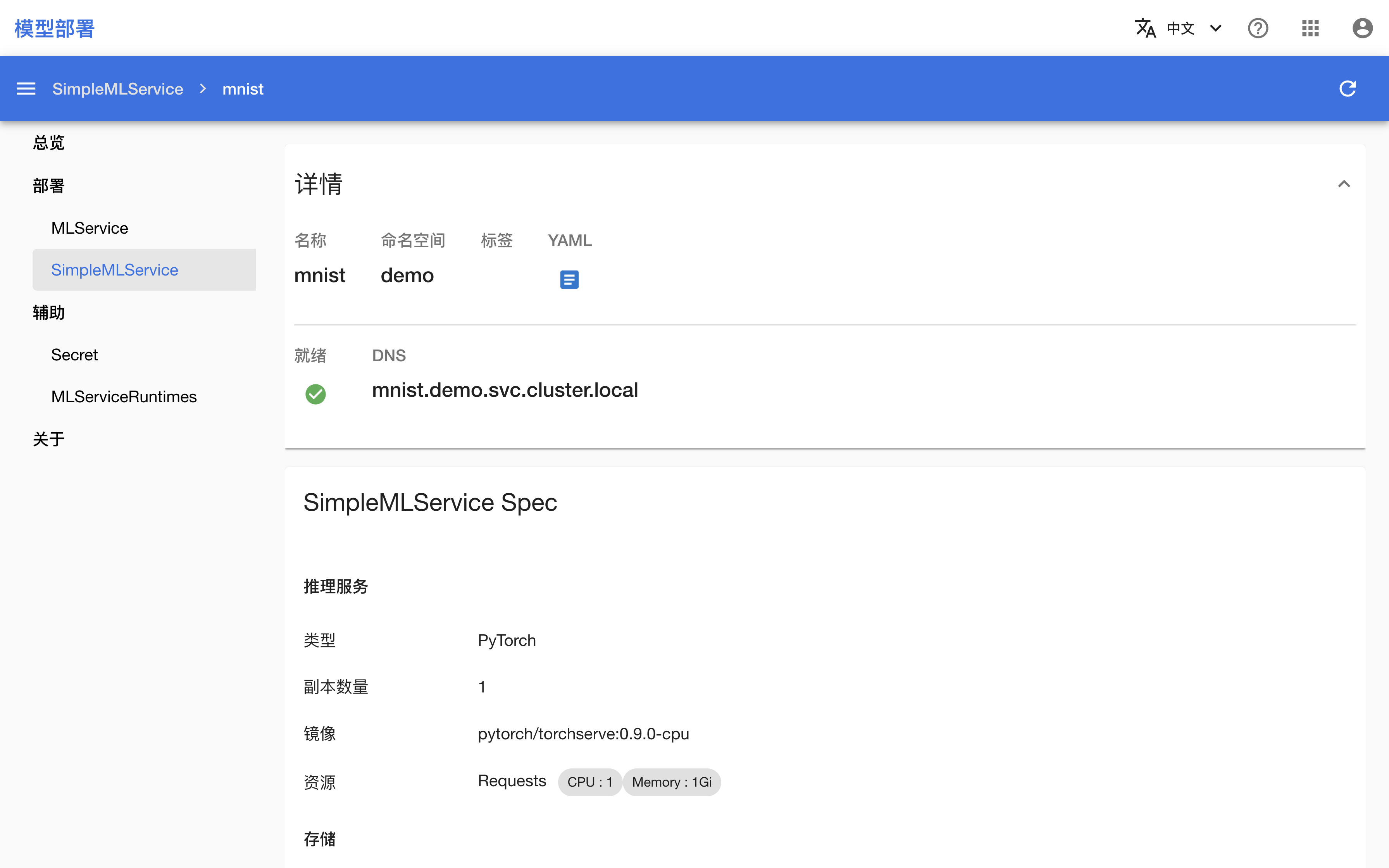

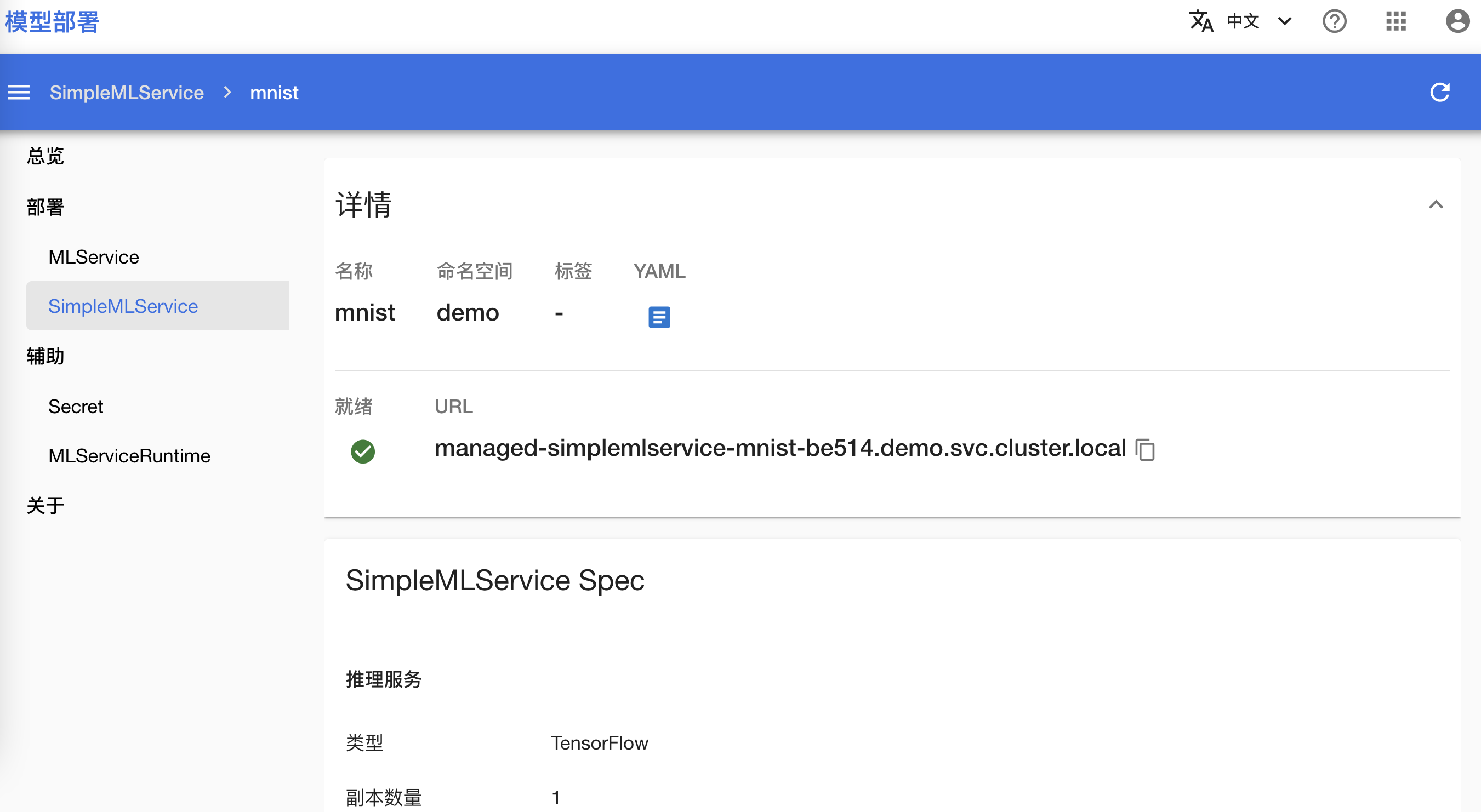

在 SimpleMLService 就绪之后,点击其名称进入详情页面。

页面中展示的 DNS 即为推理服务地址,注意该地址只能从集群内部访问。

访问推理服务

回到 Notebook mnist,在终端中执行以下命令以下载测试数据,并向推理服务发送请求。注意变量 URL 的值需要修改为实际部署的推理服务的地址。

# 下载测试图像文件

wget https://t9k.github.io/user-manuals/latest/assets/get-started/deployment/{0,1,2}.png

# 注意:此 URL 只适合在集群内当前项目(Project)内部(例如当前项目的 Notebook 中)访问使用

URL="http://mnist.demo.svc.cluster.local/v1/models/mnist:predict"

curl -T 0.png $URL # 或使用 `1.png`, `2.png`

响应体应是一个类似于下面的 JSON,其预测了图片最有可能是的 5 个数字以及相应的概率:

{

"0": 1.0,

"2": 1.7797361302828807e-16,

"9": 6.094195260341553e-19,

"6": 1.5410183526346253e-19,

"5": 7.889719768364669e-20

}

清理

体验结束后,可将当前教程产生的所有文件移动到名为 deployment 的新文件夹下。

也可以将部署的推理服务删除:

# optional, delete service if desired.

kubectl delete SimpleMLService mnist

下一步

- 了解模型部署

- 进一步学习如何部署简单推理服务

- 进一步学习如何部署用于生产环境的模型推理服务

AI 开发和应用

TensorStack AI 平台提供了一套完整、全面的工具和服务,对 AI 模型的构建、训练和部署提供全流程的支持,从而助力研究人员轻松、高效地实现 AI 项目,加速 AI 模型的研究、开发和应用。

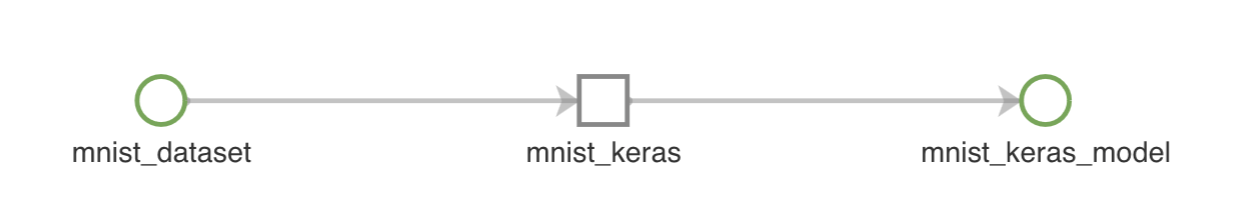

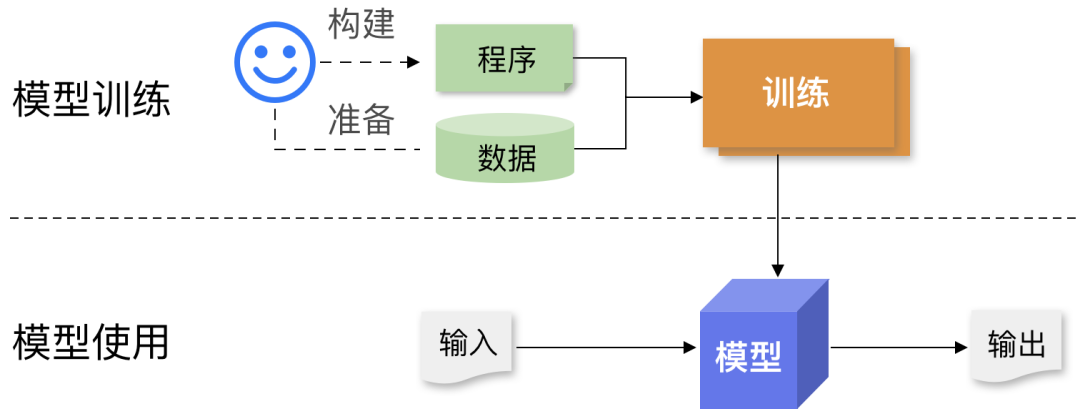

下图展示了在平台上开发并应用一个深度学习模型的完整流程,以及各个模块发挥的功能:

下一步

- 开发机器学习算法:模型构建

- 部署模型推理服务:模型部署

- 在集群中运行大规模计算:Job、工作流

- 创建并使用虚拟机:VirtualServer

模型构建

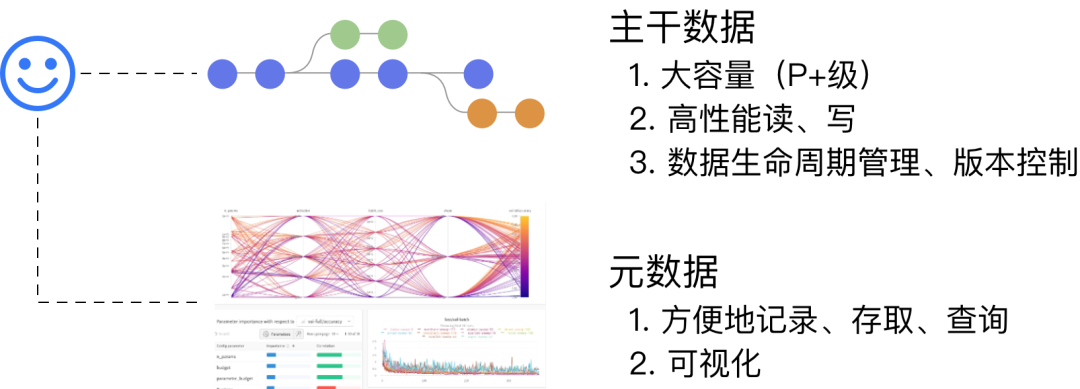

一次完整的模型构建实验由许多步骤组成,包括准备实验数据、开发机器学习算法、选择训练超参数和执行训练等等。

TensorStack AI 平台的模型构建模块可以帮助你在分布式集群中快速方便地完成上述工作。模型构建模块的功能包括:

- Notebook:在线机器学习开发工具,你可以使用此模块直接在平台上开发机器学习脚本。

- TensorBoard:机器学习可视化工具,实现训练过程可视化、模型可视化。

- Job:一类任务型资源,其中包括 TensorFlowTrainingJob、MPIJob 等多种资源,使用各种机器学习框架、通信协议来进行分布式计算。其中 TensorFlowTrainingJob 和 PyTorchTrainingJob 集成了 TensorBoard 的创建功能,可以监控训练进程和查看训练结果。

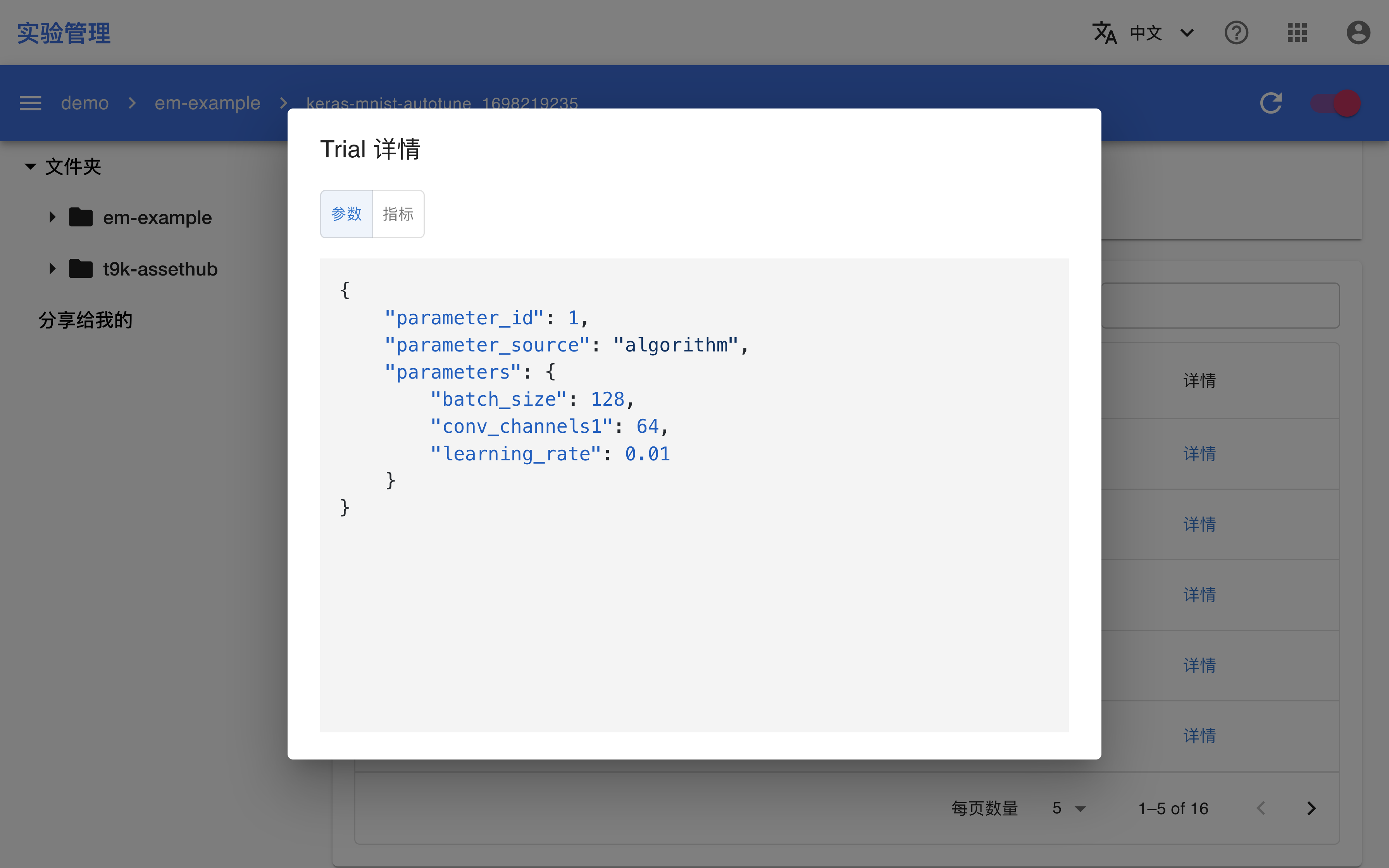

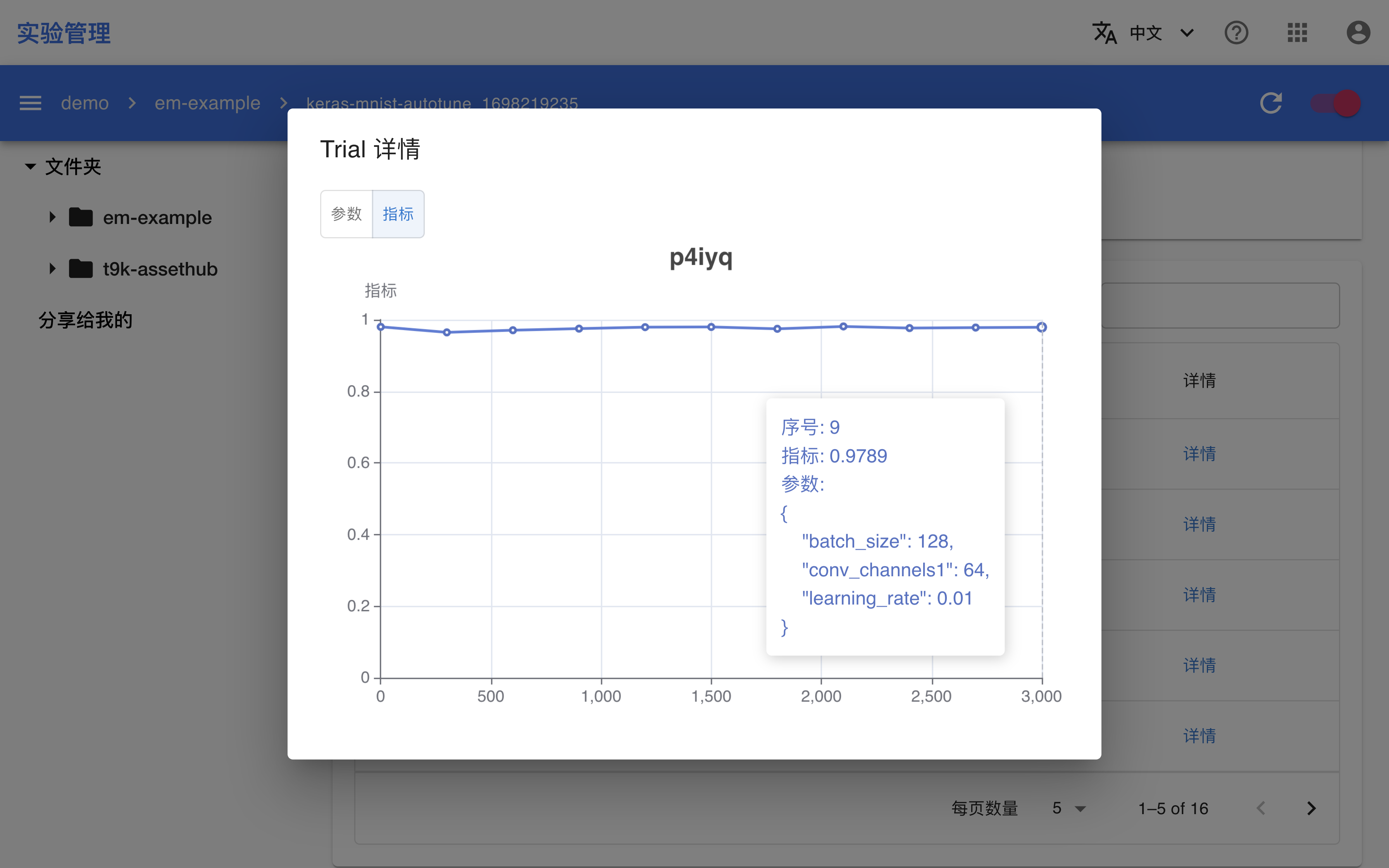

- AutoTune:超参数调优实验,在给定的搜索空间中查找最优的超参数组合以及机器学习网络结构。AutoTune 在进行超参数调优的过程中需要使用 TrainingJob(根据训练框架选用 TensorFlowTrainingJob、PyTorchTrainingJob 或 XGBoostTrainingJob)对超参数的效果进行验证。

架构

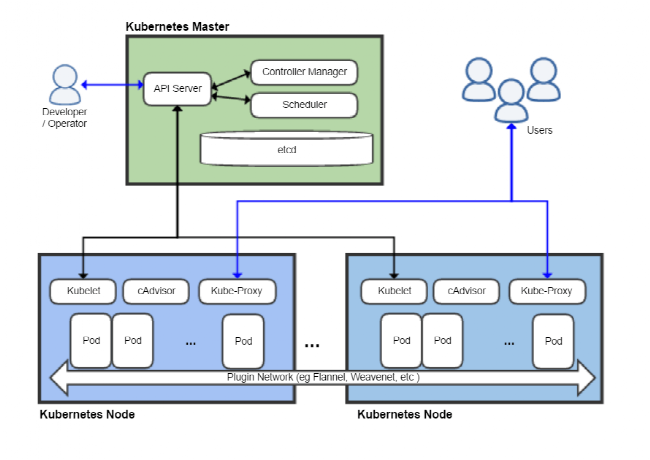

如上图所示:

- TensorStack CLI 是 TensorStack AI 平台所使用的命令行工具,可以用于操作几乎所有 TensorStack AI 平台的模块,包括模型构建。

- Kubernetes API Server 是 Kubernetes 的重要组成部分,负责对外提供接口,接受对集群的操作请求。在此框架中,Kubernetes API Server 需要向模型构建模块提供集群中的资源信息,同时接收资源的创建、删除等请求。

- 红框中的内容为模型构建模块的组成部分:

- 控制台(Console):模块的交互界面,你可以通过此界面使用模块的全部功能。

- 服务器(Server):模块功能的提供者,为你提供查看、创建、修改和删除资源的接口。

- 控制器(Controller):资源控制器,用于处理资源的创建和修改请求。

下一步

- 学习使用 Notebook

- 学习使用 TensorBoard

- 学习使用 T9k Job

- 学习使用 AutoTune

Notebook

JupyterLab 是一款非常流行的机器学习开发工具,它通过友好易用的 Web 界面提供交互式计算环境,支持多种编程语言和执行环境,在机器学习、AI、数据处理、数值模拟、统计建模、数据可视化等领域被广泛使用。

用户可以使用 Notebook CRD 在集群中快速部署一个 JupyterLab 服务,同时本产品还提供 GPU 支持、SSH 访问支持等功能。

创建 Notebook

下面是一个基本的 Notebook 示例:

# notebook-tutorial.yaml

apiVersion: tensorstack.dev/v1beta1

kind: Notebook

metadata:

name: tutorial

spec:

type: jupyter

template:

spec:

containers:

- name: notebook

image: t9kpublic/torch-2.1.0-notebook:1.77.1

volumeMounts:

- name: workingdir

mountPath: /t9k/mnt

resources:

requests:

cpu: '8'

memory: 16Gi

nvidia.com/gpu: 1

limits:

cpu: '16'

memory: 32Gi

nvidia.com/gpu: 1

volumes:

- name: workingdir

persistentVolumeClaim:

claimName: tutorial

在该例中,spec.template.spec 字段定义所要创建的 Pod 的规约:

- 指示 Pod 运行一个

notebook容器(spec.template.containers),该容器运行的镜像是t9kpublic/torch-2.1.0-notebook:1.77.1,这是一个 Notebook 镜像; - 通过

spec.template.spec.volumes,spec.template.containers[].volumeMounts指示挂载网络文件系统 PVCtutorial到/t9k/mnt; - 通过

spec.template.spec.containers[].resources指定使用的 CPU、memory、GPU 资源 。

使用 GPU

Notebook 支持通过申请使用 GPU 资源,例如:

apiVersion: tensorstack.dev/v1beta1

kind: Notebook

metadata:

name: tutorial

spec:

type: jupyter

template:

spec:

containers:

- name: notebook

image: t9kpublic/torch-2.1.0-notebook:1.77.1

volumeMounts:

- name: workingdir

mountPath: /t9k/mnt

resources:

limits:

cpu: '16'

memory: 32Gi

nvidia.com/gpu: 1

command: []

volumes:

- name: workingdir

persistentVolumeClaim:

claimName: tutorial

在该例中:

- 申请使用 16 个 CPU、32Gi 内存以及一个 NVIDIA GPU;系统会自动将 Notebook 调度到集群中某个能提供这些资源的节点上。

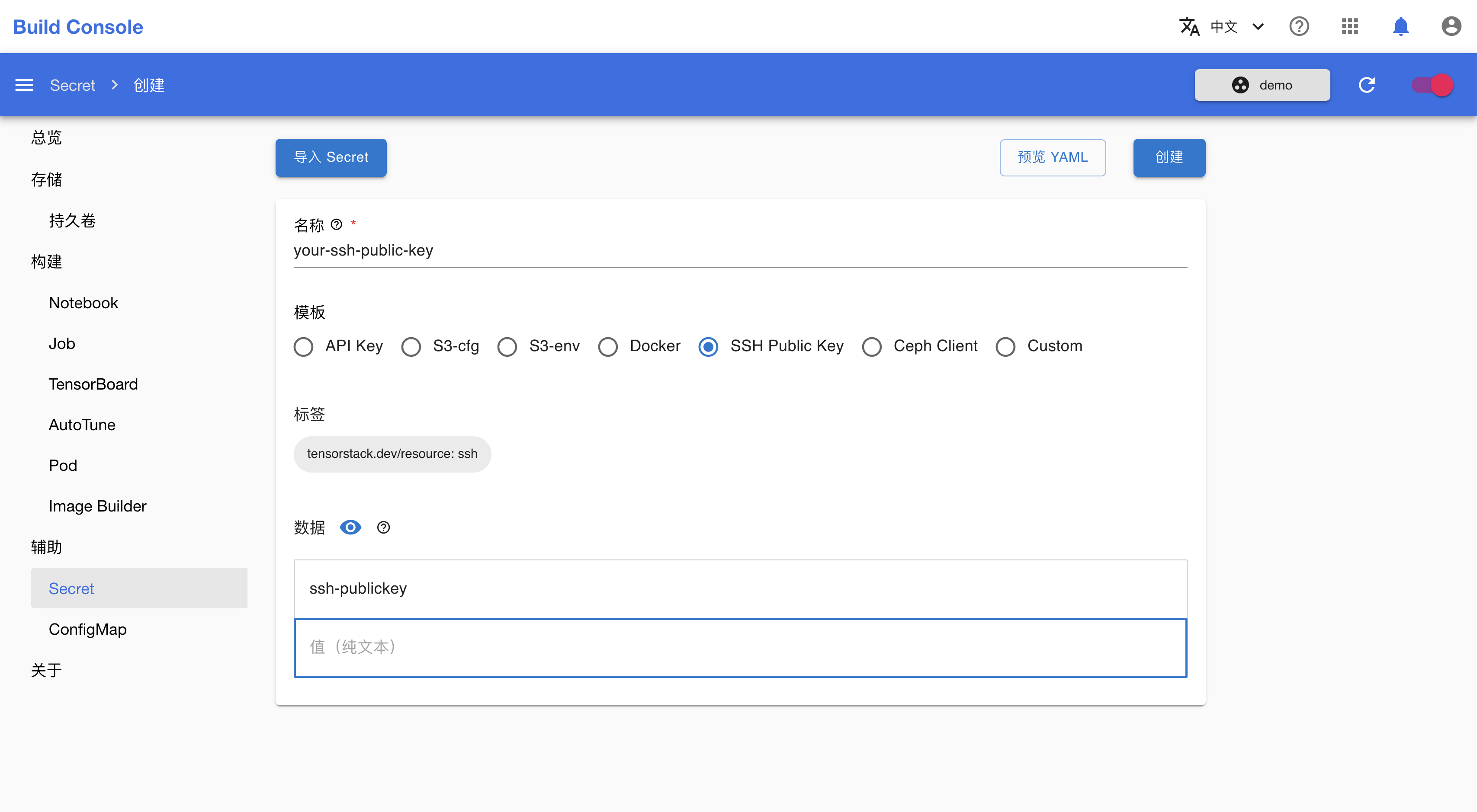

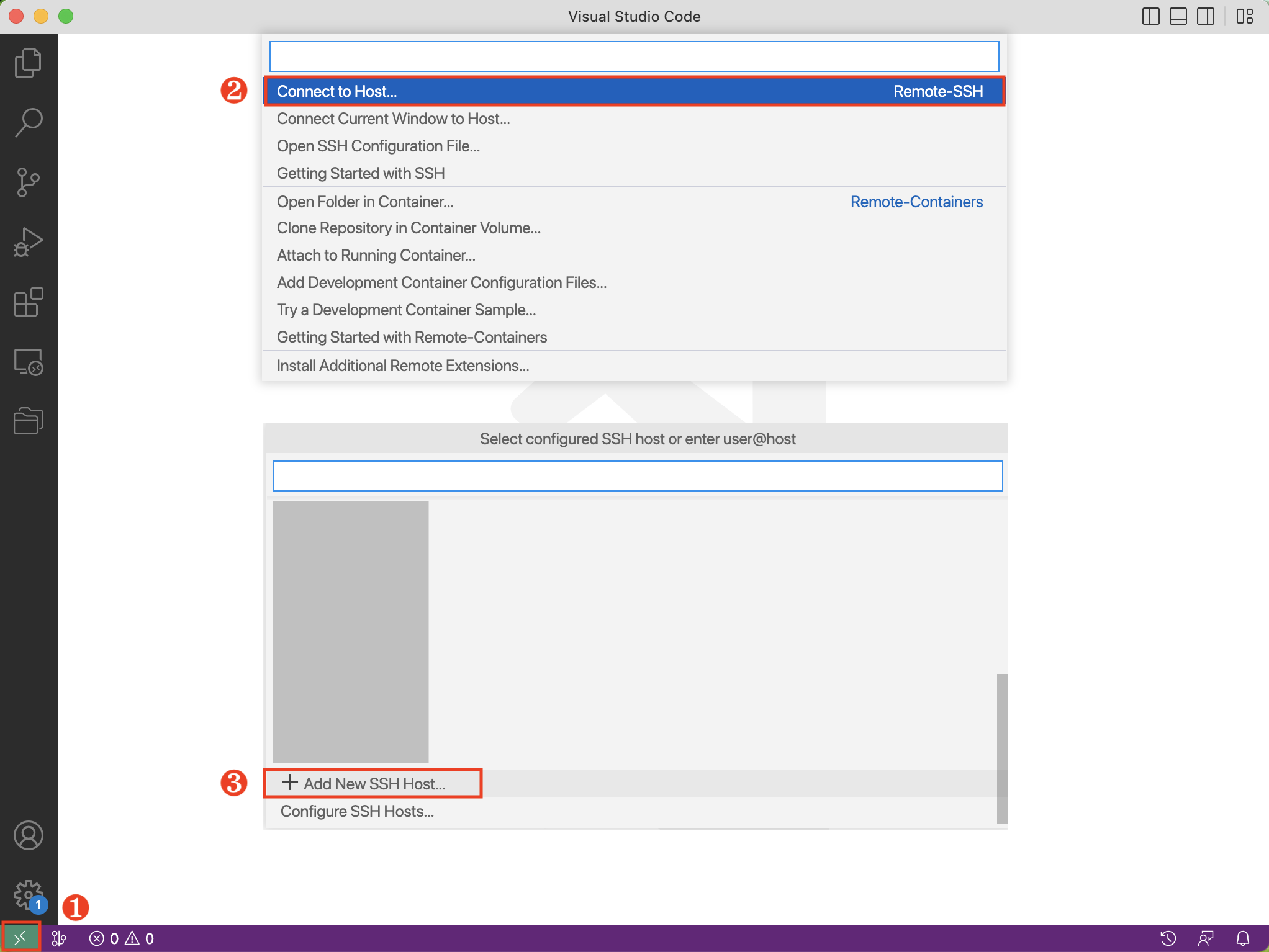

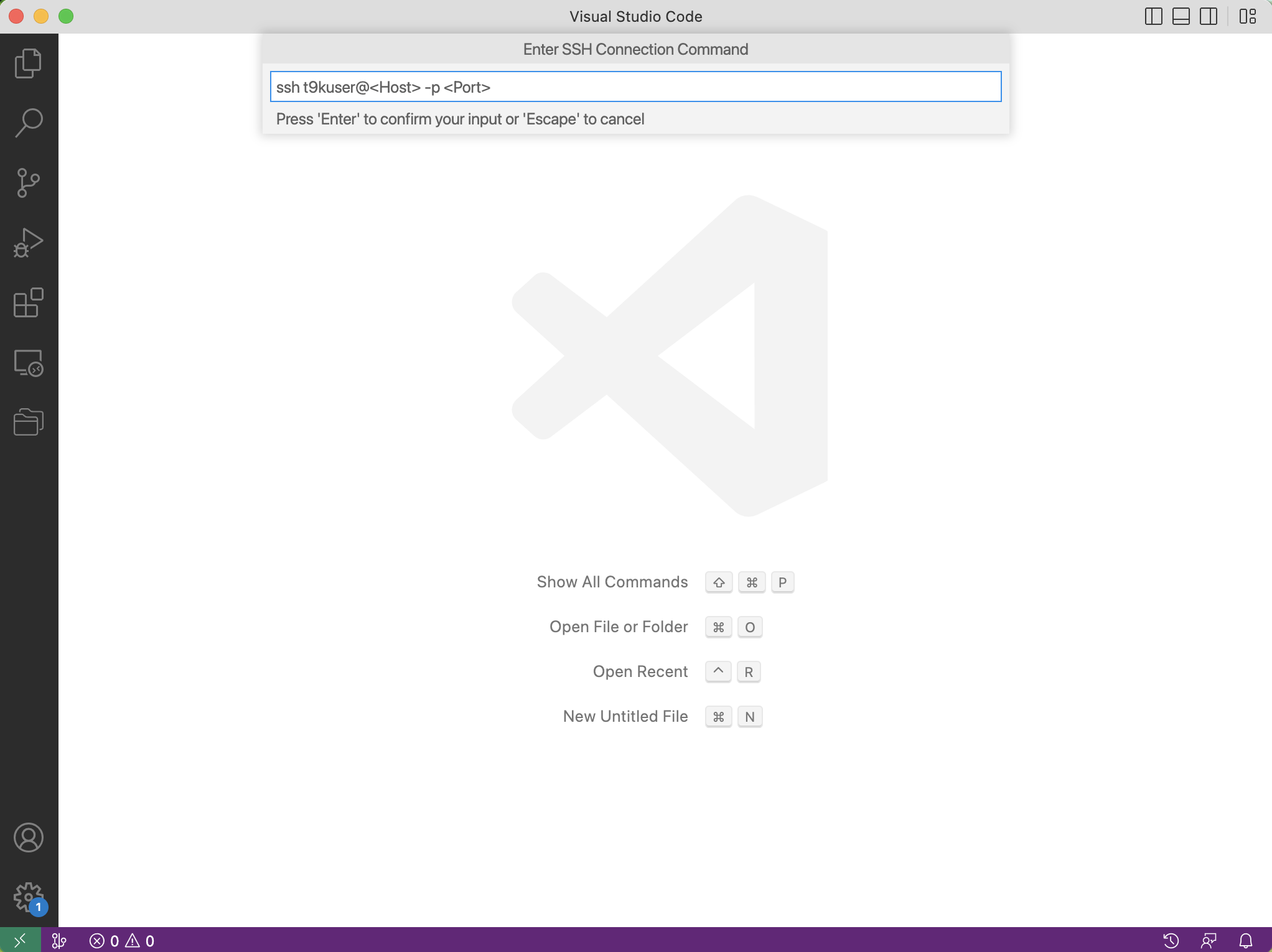

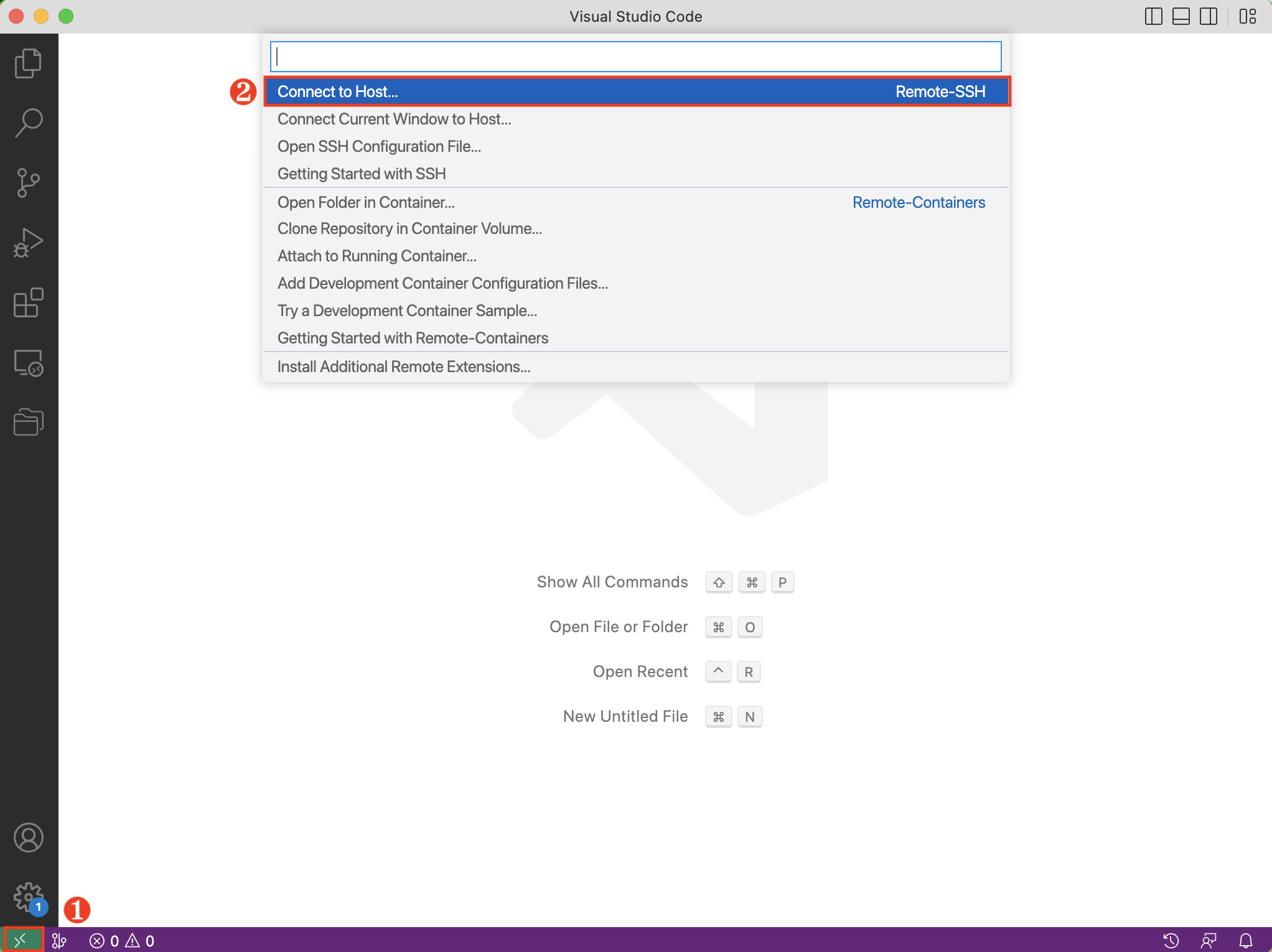

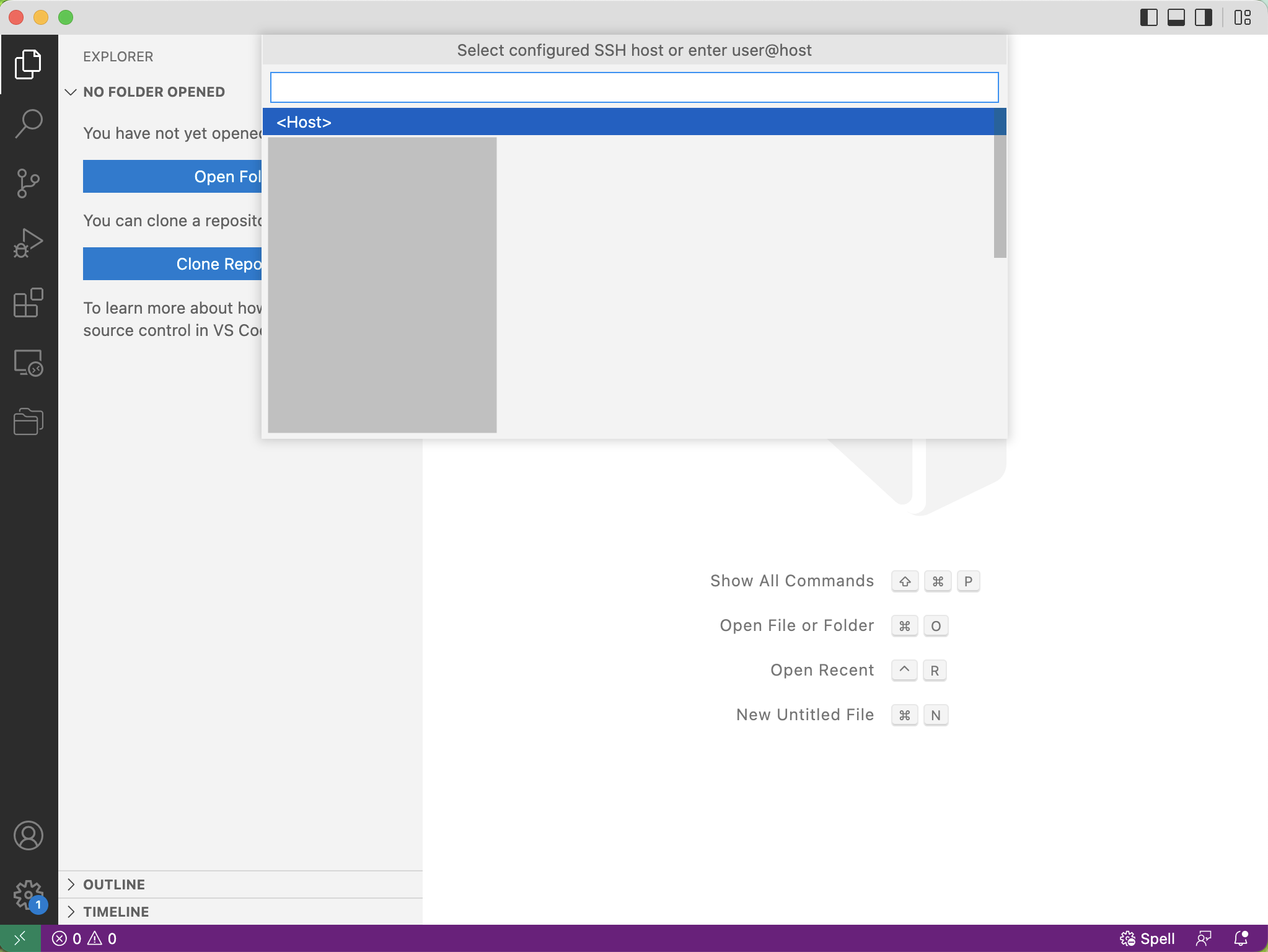

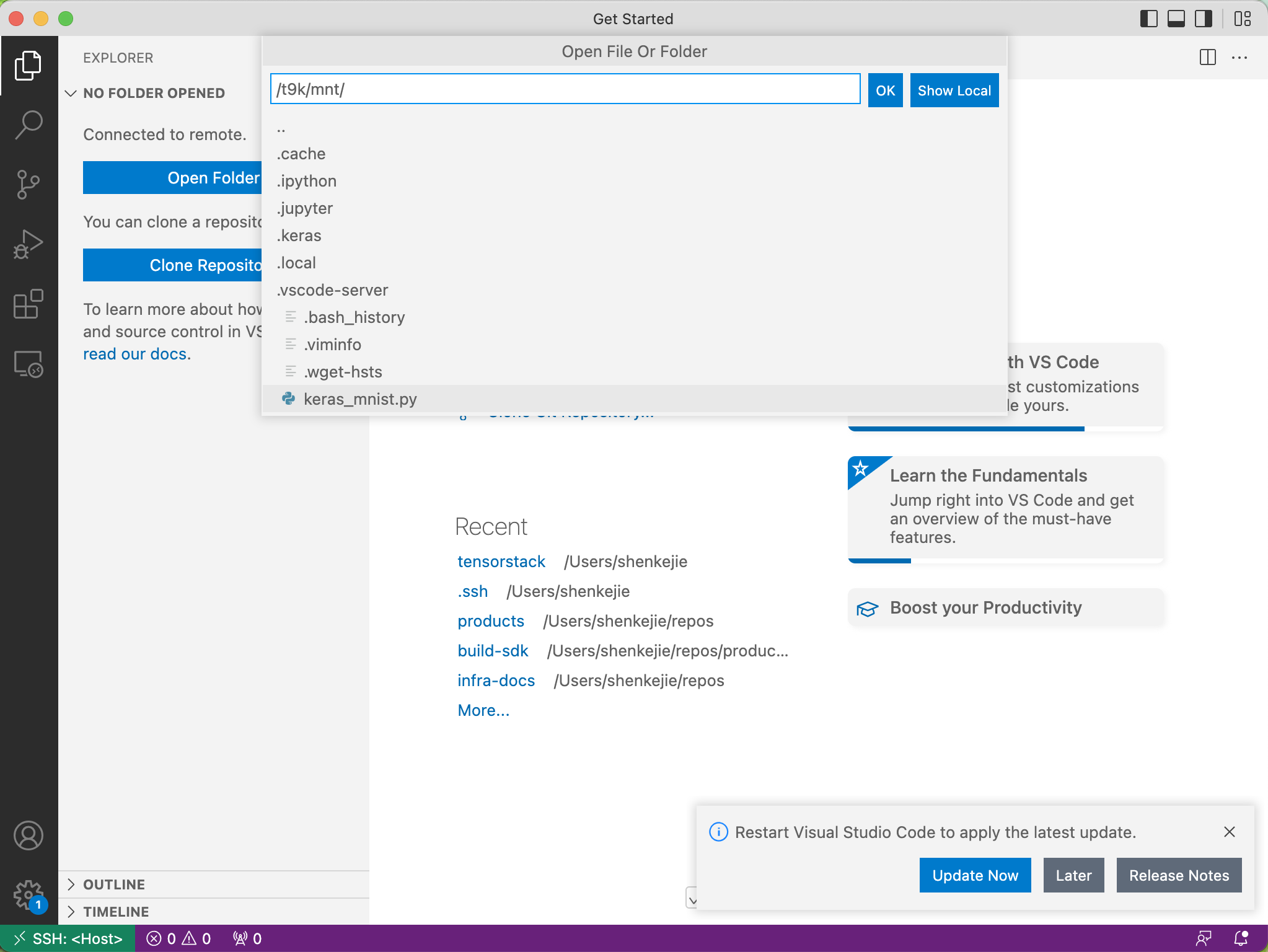

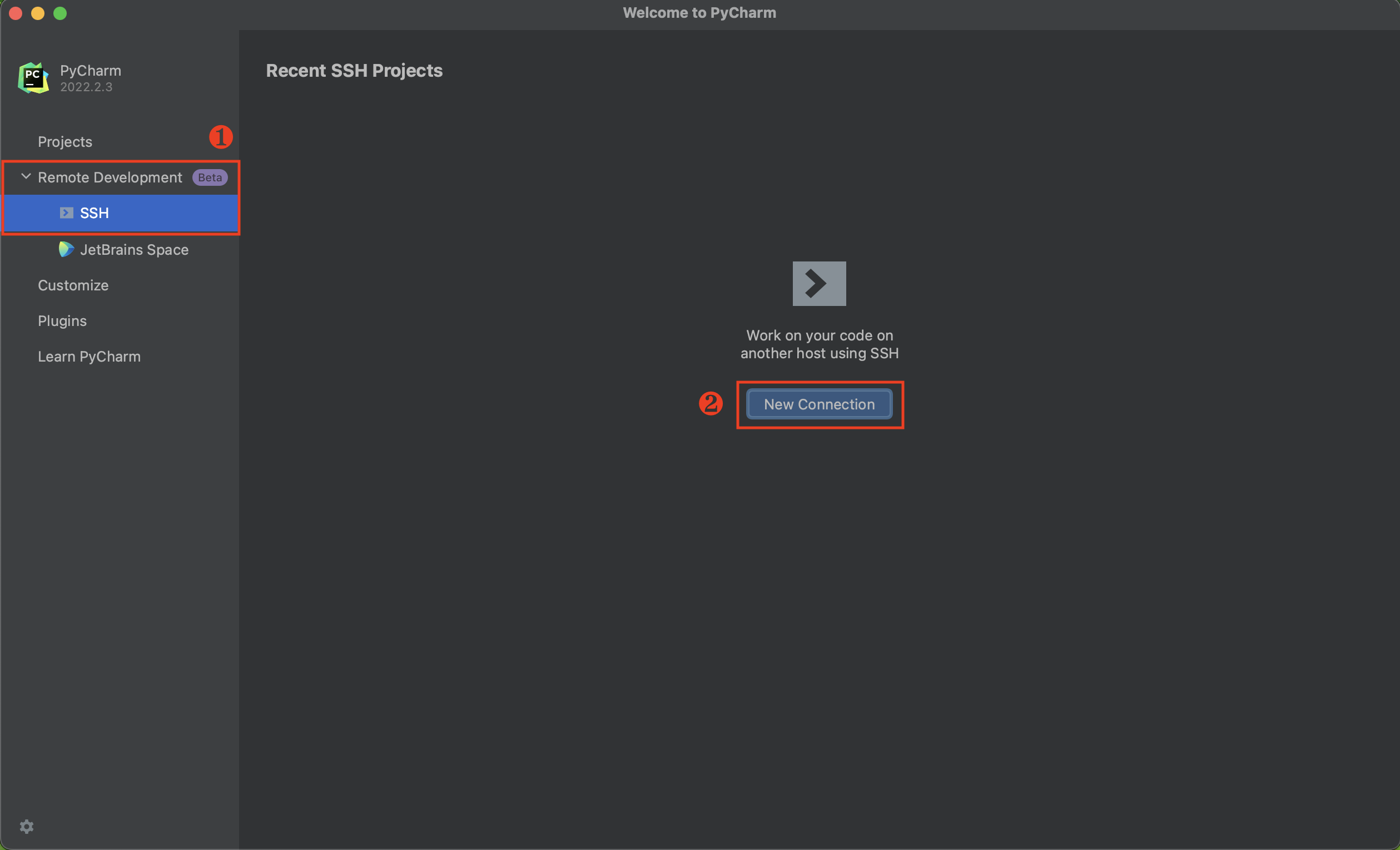

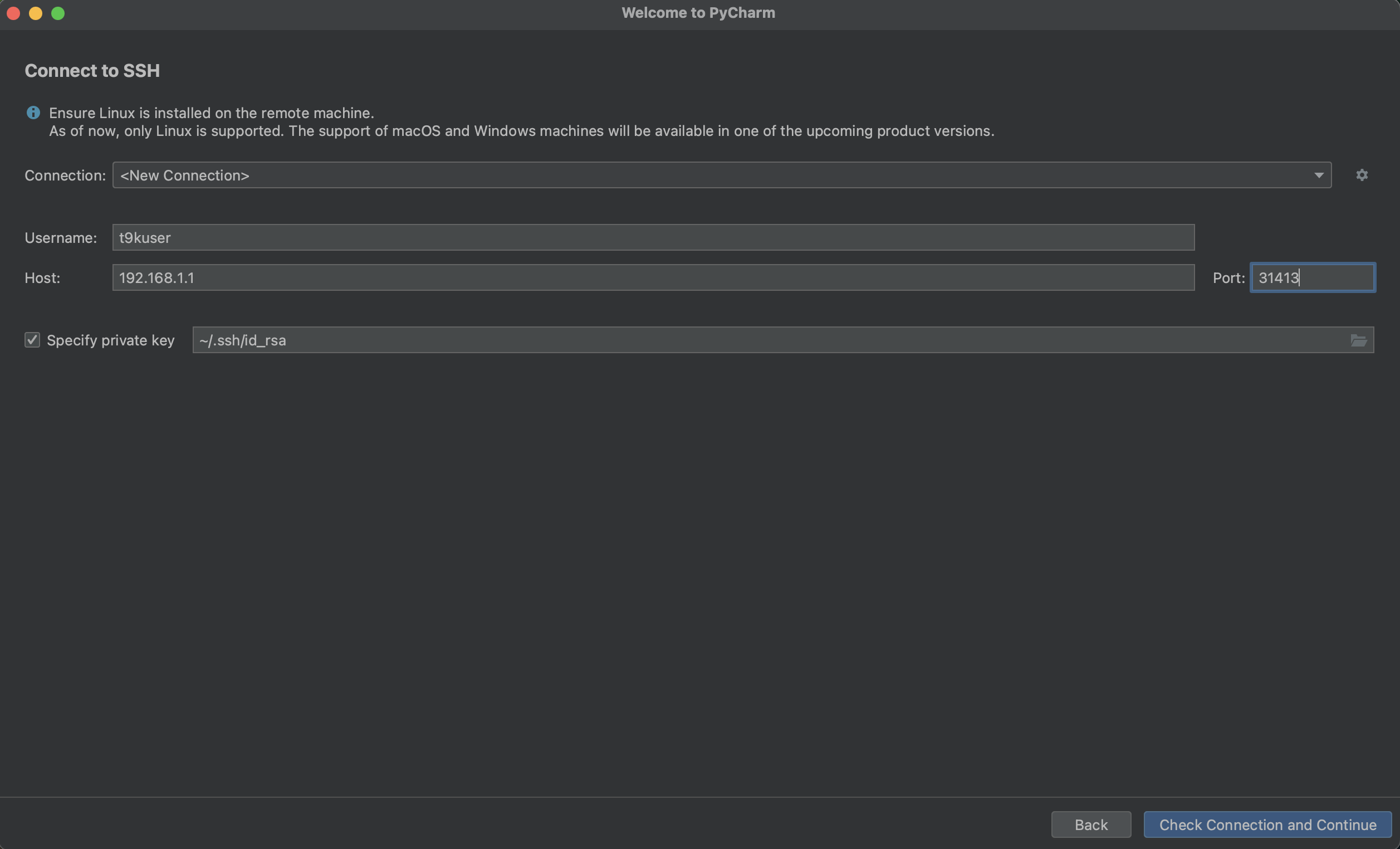

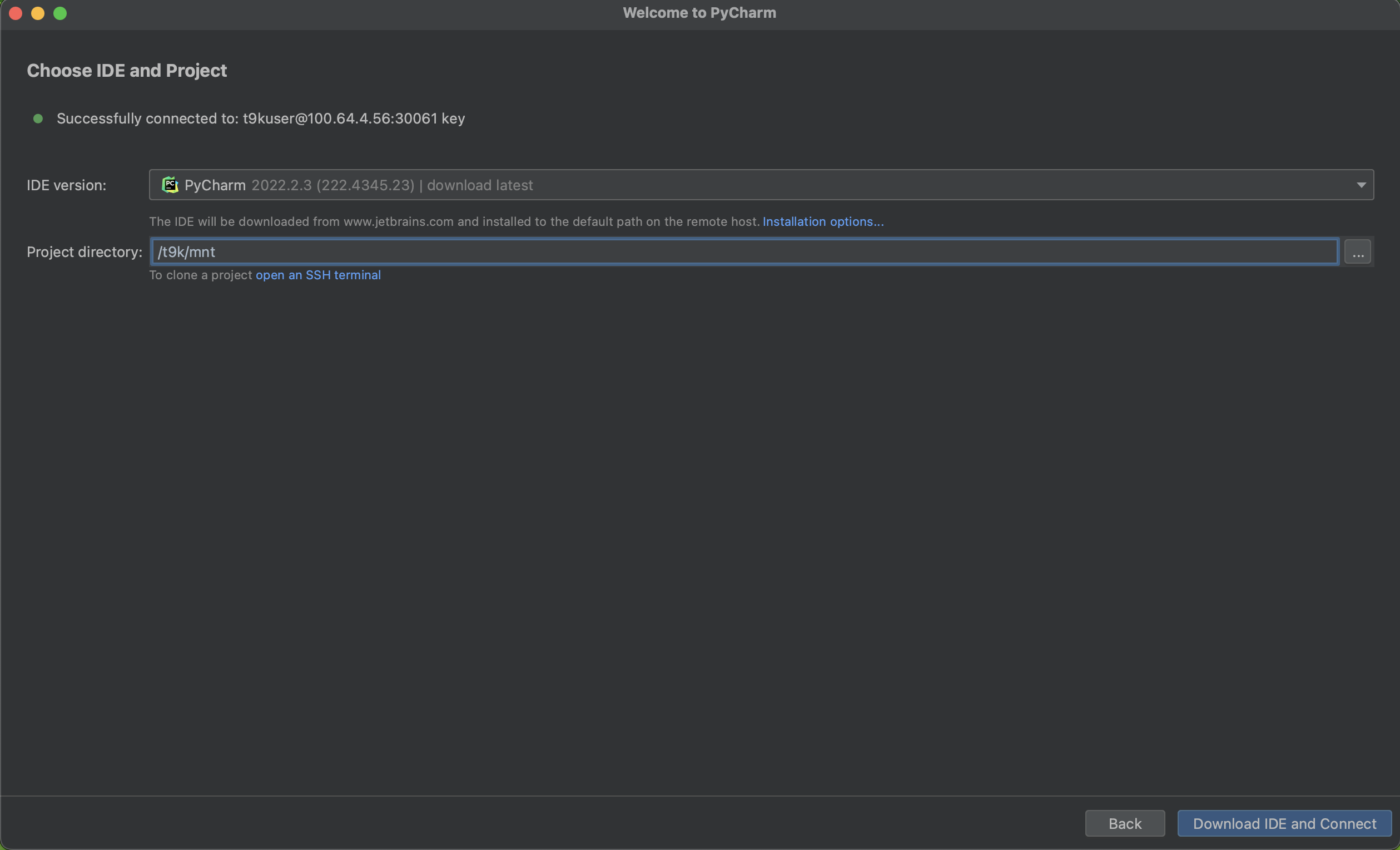

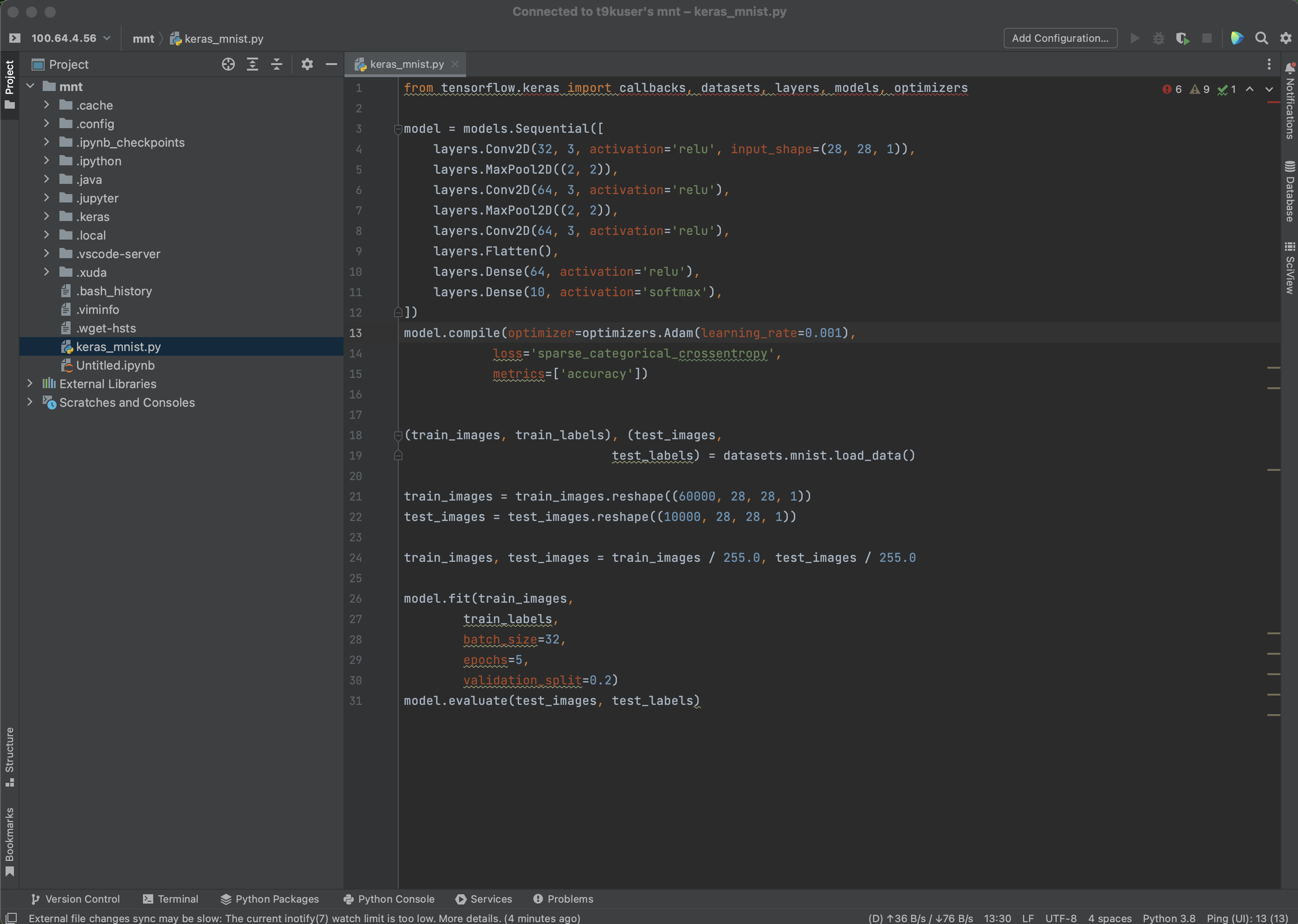

SSH 访问

Notebook 提供运行 SSH Server 的支持。下面的 Notebook 示例运行一个支持 SSH 连接的 JupyterLab 镜像:

apiVersion: tensorstack.dev/v1beta1

kind: Notebook

metadata:

name: tutorial

spec:

type: jupyter

template:

spec:

containers:

- name: notebook

image: t9kpublic/torch-2.1.0-notebook:1.77.1

volumeMounts:

- name: workingdir

mountPath: /t9k/mnt

resources:

limits:

cpu: '16'

memory: 32Gi

nvidia.com/gpu: 1

volumes:

- name: workingdir

persistentVolumeClaim:

claimName: tutorial

ssh:

authorized_keys:

- example-user

enabled: true

serviceType: ClusterIP

在该例中,用户:

- 设置

spec.ssh.enabled字段的值为true,T9k 系统将会自动创建一个处理 SSH 请求的Service; - 通过

spec.ssh.serviceType字段指定服务类型为ClusterIP; - 设置自动挂载存放在

Secret/example-user中的用户 SSH key;

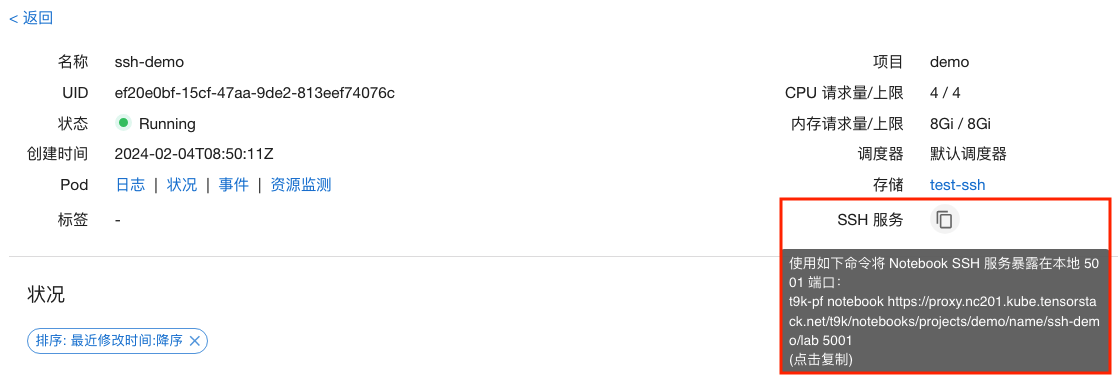

使用此 SSH 服务需要通过 t9k-pf 工具进行端口转发。

资源回收

T9k 系统提供空闲 Notebook 资源回收的支持。系统在检测到 Notebook 处于空闲状态并超过一定时长时,就会自动删除工作负载以释放计算资源。目前,资源回收仅针对 Jupyter 类型的 Notebook,其他类型(例如 RStudio)的 Notebook 不会被回收。

管理员可设置回收策略,使得:

- Notebook 没有活跃运行超过 1h(管理员可修改此时长)后,标记该 Notebook 为

Idle。 - Notebook 进入

Idle状态超过 24h(管理员可修改此时长)后,删除该 Notebook 底层工作负载。

如果需要再次使用该 Notebook,你可以在模型构建控制台中手动点击恢复按钮。

Notebook 镜像

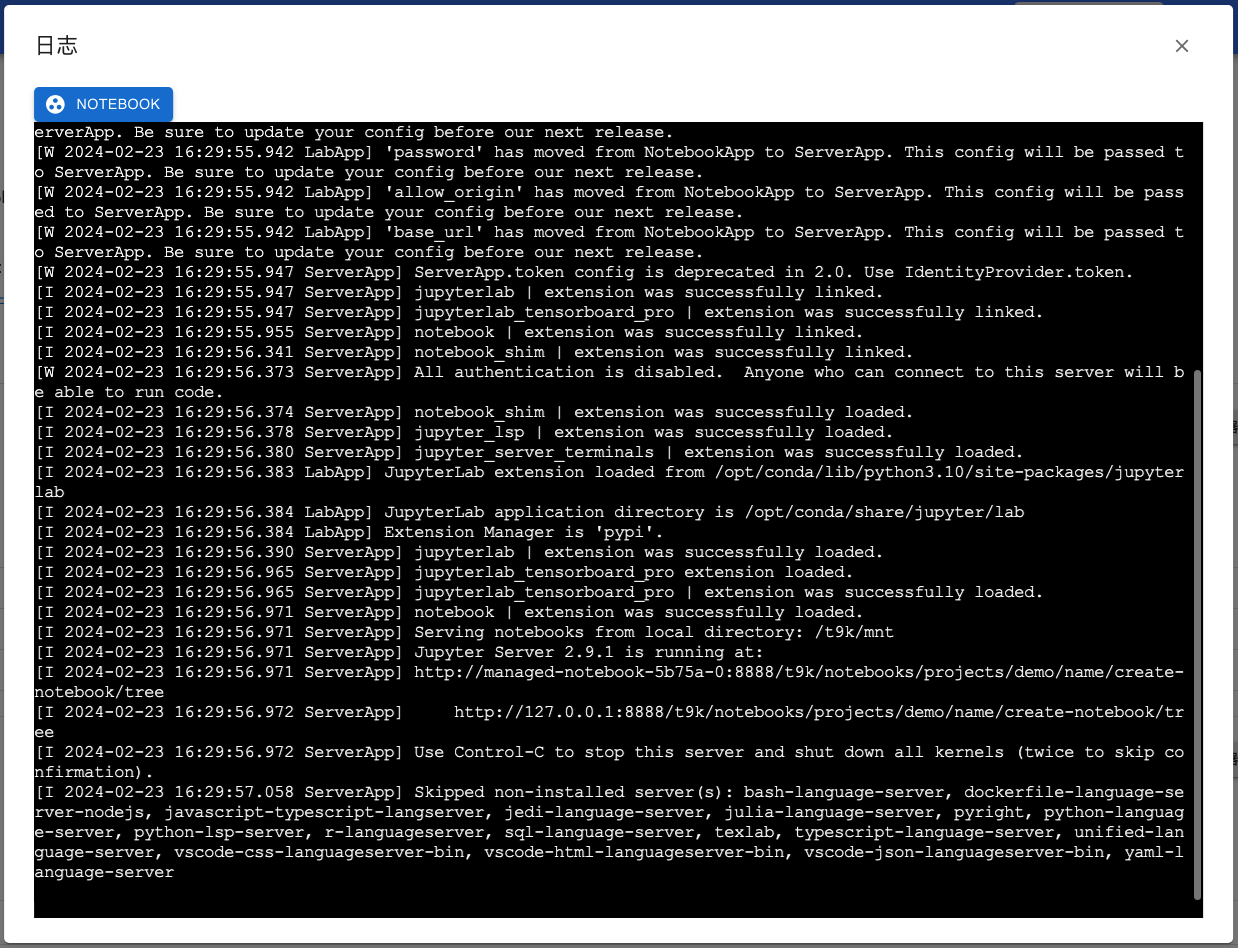

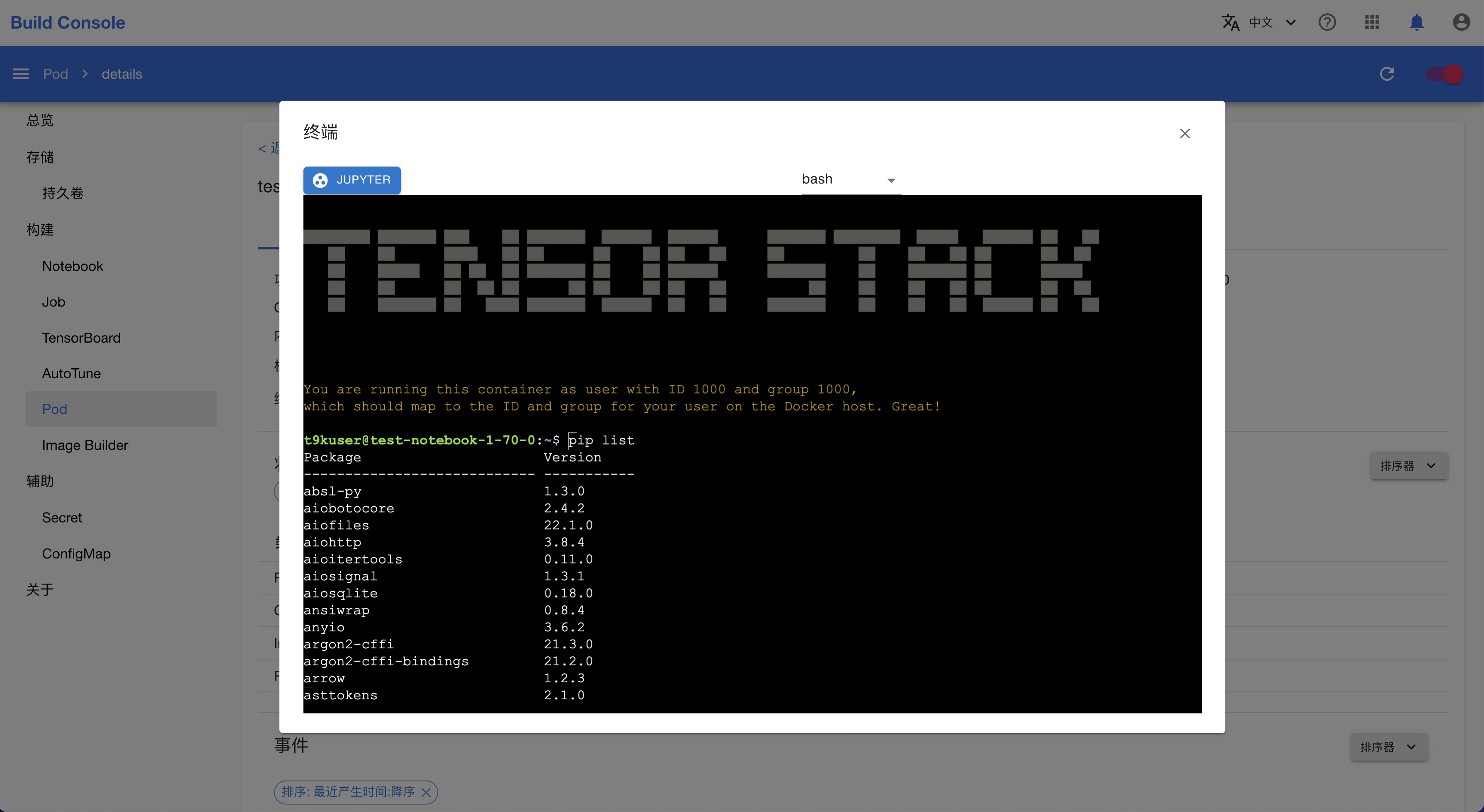

T9k 提供了一些预先构建的镜像,与 JupyterLab 原生镜像相比内置了更丰富的工具包,请参阅 Notebook 标准镜像列表。

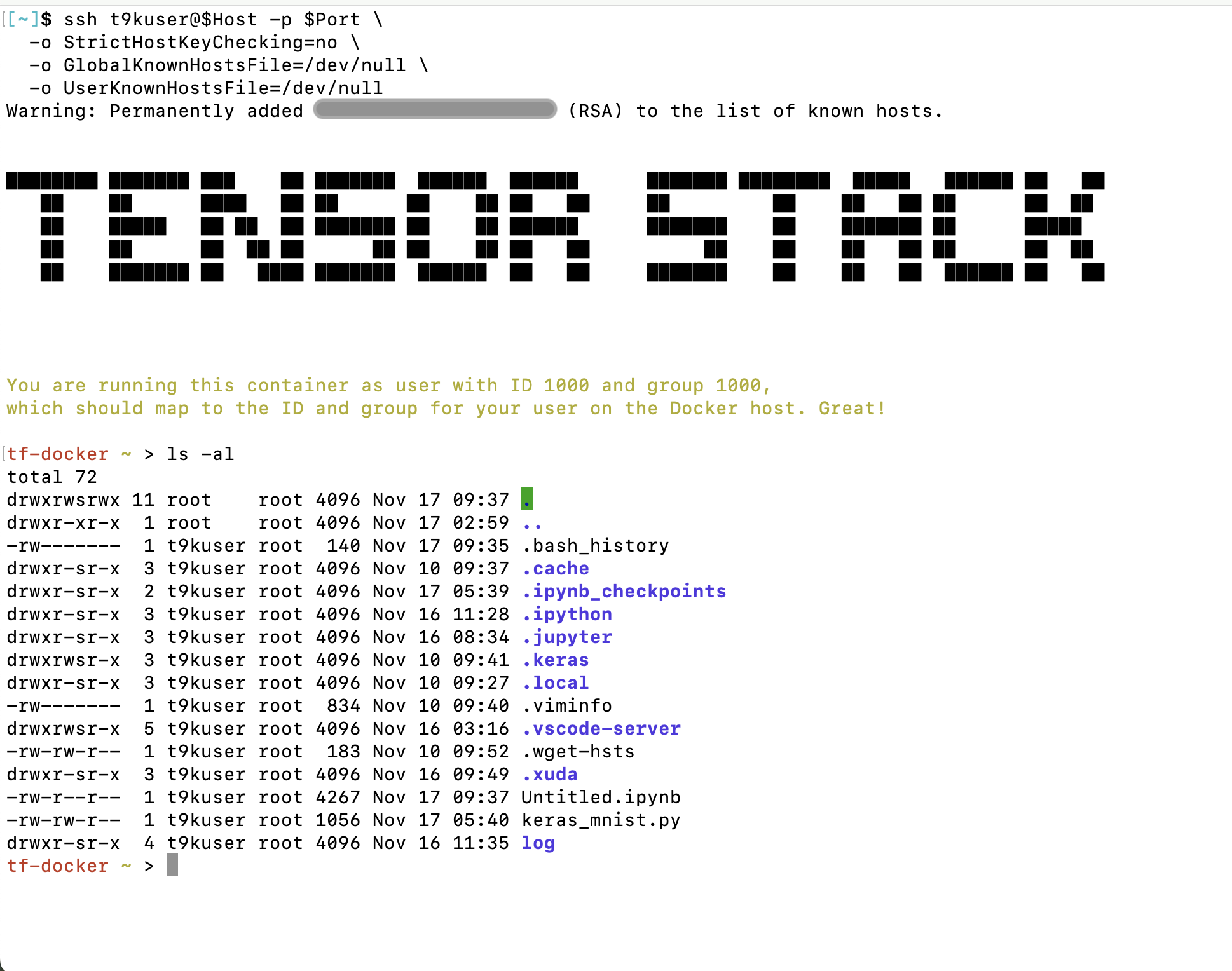

在这些镜像中:

- 默认启动一个 JupyterLab 服务。

- 预装了 Python3 以及

tensorflow、pytorch、keras、pandas、scikit-learn等常用 Python 包。 - 身份是一个名为

t9kuser的非root用户(用户 ID 为 1000,组 ID 为 1000),$HOME目录为/t9k/mnt。 - 预装了

tensorboard插件,你可以在网页中创建 TensorBoard 以可视化数据。

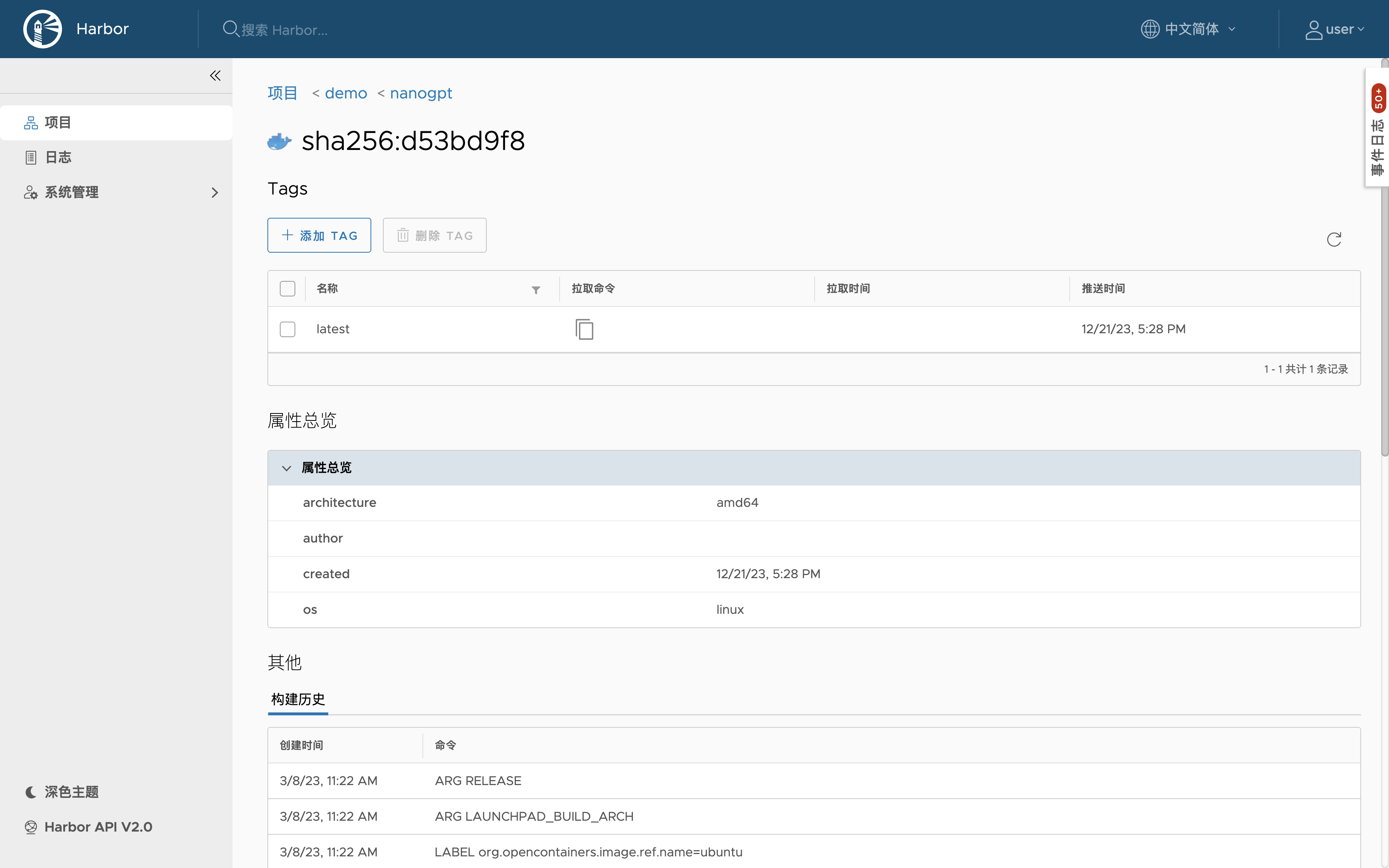

用户也可以自行构建镜像,并上载到镜像 registry 中供使用。

常见高级配置

Notebook 底层启动了一个 Pod 来运行 JupyterLab,因此 Pod 相关的配置均可填写到 Notebook 中,详见 PodSpec。

下面介绍如何填写一些常见的高级配置。

环境变量

下面的 Notebook 示例设置了一些环境变量:

apiVersion: tensorstack.dev/v1beta1

kind: Notebook

metadata:

name: tutorial

spec:

type: jupyter

template:

spec:

containers:

- name: notebook

image: t9kpublic/torch-2.1.0-notebook:1.77.1

env:

- name: HTTP_PROXY

value: <host>:<port>

- name: HTTPS_PROXY

value: <host>:<port>

- name: LOCALE

value: zh-cn

volumeMounts:

- name: workingdir

mountPath: /t9k/mnt

resources:

requests:

cpu: '8'

memory: 16Gi

nvidia.com/gpu: 1

limits:

cpu: '16'

memory: 32Gi

nvidia.com/gpu: 1

volumes:

- name: workingdir

persistentVolumeClaim:

claimName: tutorial

在该例中,spec.template.spec.containers[*].env 定义了 Pod 中对应容器的环境变量。环境变量常被用于:

- 设置网络代理:

HTTP_PROXY和HTTPS_PROXY; - 设置额外的 Python 包和模块路径:

PYTHONPATH; - 设置 C 语言静态库和共享库路径:

LIBRARY_PATH和LD_LIBRARY_PATH; - ...

用户可直接在 Notebook 的终端中使用这些环境变量,例如:

# 自动使用,curl 可以自动使用 HTTPS_PROXY 等环境变量

curl https://ifconfig.io

# 通过命令行参数指定 --proxy 指定环境变量的值

curl --proxy $HTTPS_PROXY https://ifconfig.io

用户也可以在 Python 程序中读取并使用这些环境变量,例如:

import os

os.getenv('LOCALE')

共享内存

一些程序的运行可能要求使用共享内存,下面的 Notebook 示例展示了如何设置共享内存:

apiVersion: tensorstack.dev/v1beta1

kind: Notebook

metadata:

name: tutorial

spec:

type: jupyter

template:

spec:

containers:

- name: notebook

image: t9kpublic/torch-2.1.0-notebook:1.77.1

volumeMounts:

- name: workingdir

mountPath: /t9k/mnt

- name: dshm

mountPath: /dev/shm

resources:

requests:

cpu: '8'

memory: 16Gi

nvidia.com/gpu: 1

limits:

cpu: '16'

memory: 32Gi

nvidia.com/gpu: 1

volumes:

- name: workingdir

persistentVolumeClaim:

claimName: tutorial

- name: dshm

emptyDir:

medium: Memory

sizeLimit: "1Gi"

在该例中:

- 在

spec.template.spec.volumes中增加一项,名称为dshm,其中限制共享内存最大为1Gi; - 在

spec.template.spec.containers[*].volumeMounts中增加一项,将上述dshm绑定到/dev/shm路径。

设置网络代理

在 Notebook(或者 Job 等其它工作负载)中运行程序时,例如下载训练数据,如果用户需要设置网络代理,可采用如下方式:

全局设置

请按照环境变量一节为 Notebook(或者 Job 等其它工作负载)设置 HTTP_PROXY 和 HTTPS_PROXY 两个环境变量(或者其它更多相关变量)。

无论是通过终端运行 curl、wget 等命令或通过 Python 代码来下载训练数据,下载程序一般都会尊重环境变量 HTTP_PROXY 和 HTTPS_PROXY 的设置,使用这两个环境的值作为网络代理。

临时设置

如果仅在运行特定程序时需要使用代理,可通过临时设置环境变量。例如,curl 支持如下方式设置网络代理:

- 命令行参数

curl --proxy <proxy-address> https://ifconfig.io

- 环境变量

# 为单个命令设置环境变量

HTTPS_PROXY=<proxy-address> curl https://ifconfig.io

# 或者,为当前 shell 及子进程设置

export HTTPS_PROXY=<proxy-address>

curl https://ifconfig.io

在程序里设置

很多网络通讯库支持在调用时设置额外的参数,例如 Python 的 request 库,支持如下使用方法:

import requests

proxies = {

'http': 'http://1.2.3.4:8080',

'https': 'https://1.2.3.4:3128'

}

response = requests.get(url, proxies=proxies)

下一步

用户可尝试如下功能:

参考

- T9k 提供的 Notebook 标准镜像列表

- JupyterLab 文档

TensorBoard

TensorBoard 是 TensorFlow 提供的一种可视化机器学习过程和结果的工具,功能强大且广泛应用于多种框架。

你可以使用本产品在集群中一键部署 TensorBoard,可视化训练模型。

创建 TensorBoard

下面是一个基本的 TensorBoard 示例:

# tensorboard-example.yaml

apiVersion: tensorstack.dev/v1beta1

kind: TensorBoard

metadata:

name: pytorchtrainingjob-tensorboard

namespace: t9k-example

spec:

image: docker.mirrors.ustc.edu.cn/tensorflow/serving:2.6.0-gpu

trainingLogFilesets:

- t9k://pvc/pytorchtrainingjob-tensorboard-pvc/log

在该例中,TensorBoard 使用 docker.mirrors.ustc.edu.cn/tensorflow/serving:2.6.0-gpu 镜像,对名为 pytorchtrainingjob-tensorboard-pvc 的 PVC 中 /log 路径下的模型数据进行可视化。

FileSet

FileSet 是一种特殊的资源定位符(URI),是一种用于定位多种存储技术中的资源的字符串。

FileSet 的格式为 t9k://storage-type/storage-identity/path,由下列四部分构成:

- 协议:

t9k://。 - 存储器类型:当前 FileSet 支持 PVC(在 FileSet 中写作

pvc) 和 MinIO(在 FileSet 中写作minio) 两种存储器。 - 存储器定位方式:FileSet 使用 PVC 的名称来定位 PVC 存储器,使用记录了 MinIO 地址、用户名和密码的 Secret 来定位 MinIO 存储器。

- 数据在存储器中的路径:模型在存储器中的准确位置。

下面是两个 FileSet 示例:

t9k://pvc/pytorchtrainingjob-tensorboard-pvc/log/model表示:所指向的资源被存储在名为pytorchtrainingjob-tensorboard-pvc的 PVC 中的log/model路径下。t9k://minio/secret-name/bucket1/log/model表示:所指向的资源被存储在一个 MinIO 中名为bucket1的 Bucket 中的log/model路径下,该 MinIO 的地址、用户名和密码被存储在名为secret-name的 Secret 中。

TrainingJob 自动创建 TensorBoard

我们在 TensorFlowTrainingJob 和 PyTorchTrainingJob 中集成了 TensorBoard 的创建,你可以在创建 TrainingJob 后直接进入 TensorBoard 监控训练进程和查看训练结果。

资源回收

TensorBoard 提供空闲资源回收的支持,在检测到 TensorBoard 处于空闲状态并超过一定时长时,删除工作负载以释放计算资源。默认情况下(管理员可修改配置):

- TensorBoard 无人使用超过 1h 后,标记该 TensorBoard 为

Idle。 - TensorBoard 进入

Idle状态超过 24h 后,删除该 TensorBoard 底层工作负载。

如果需要再次使用该 TensorBoard,你可以在模型构建控制台中手动点击恢复按钮。

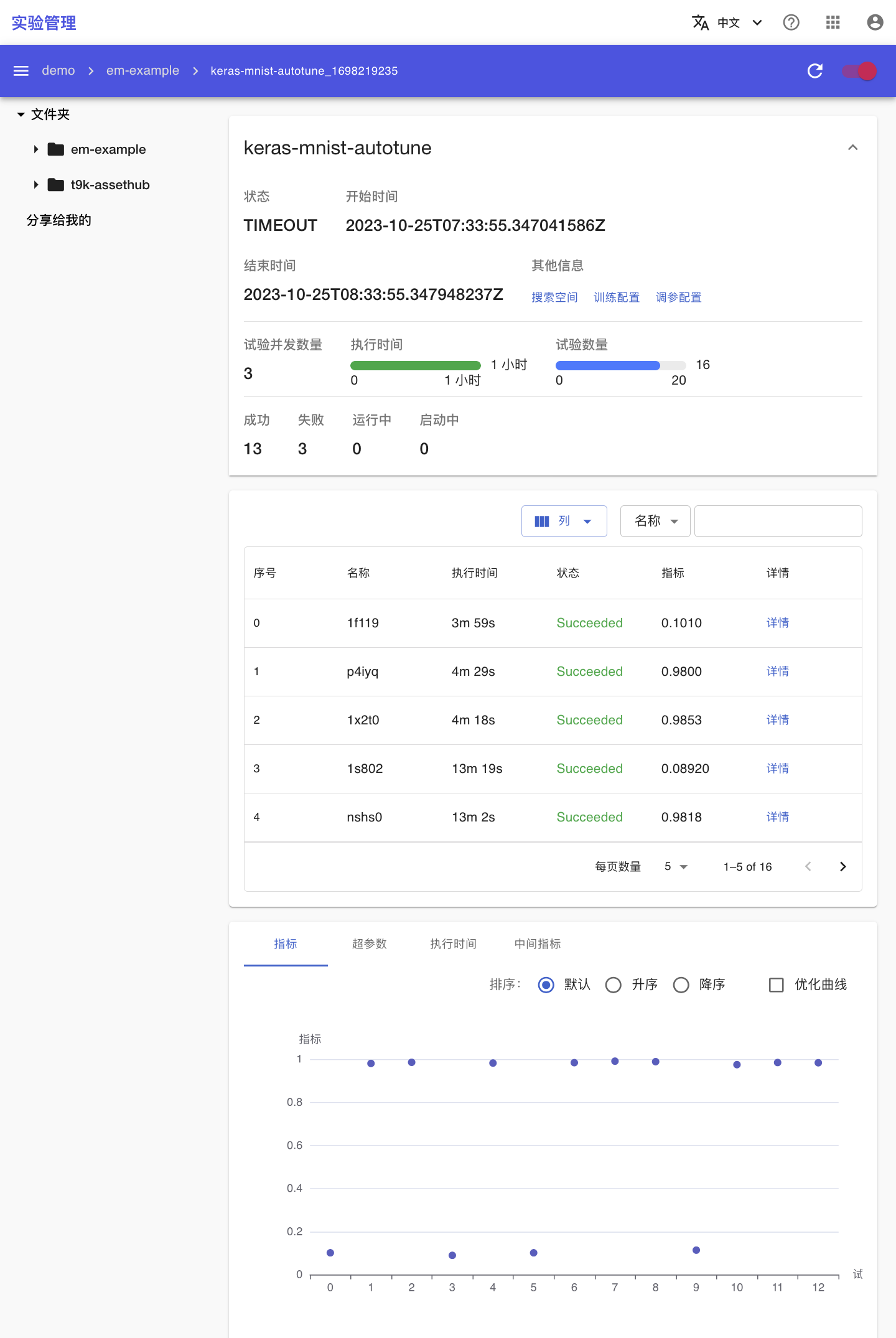

AutoTune

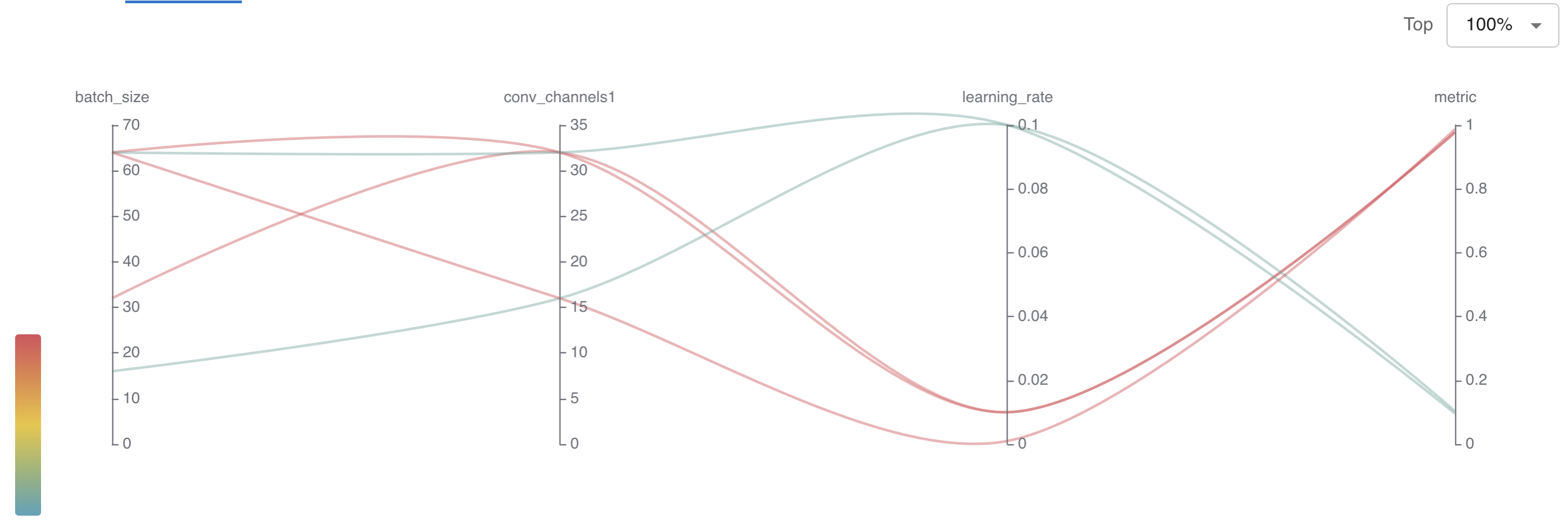

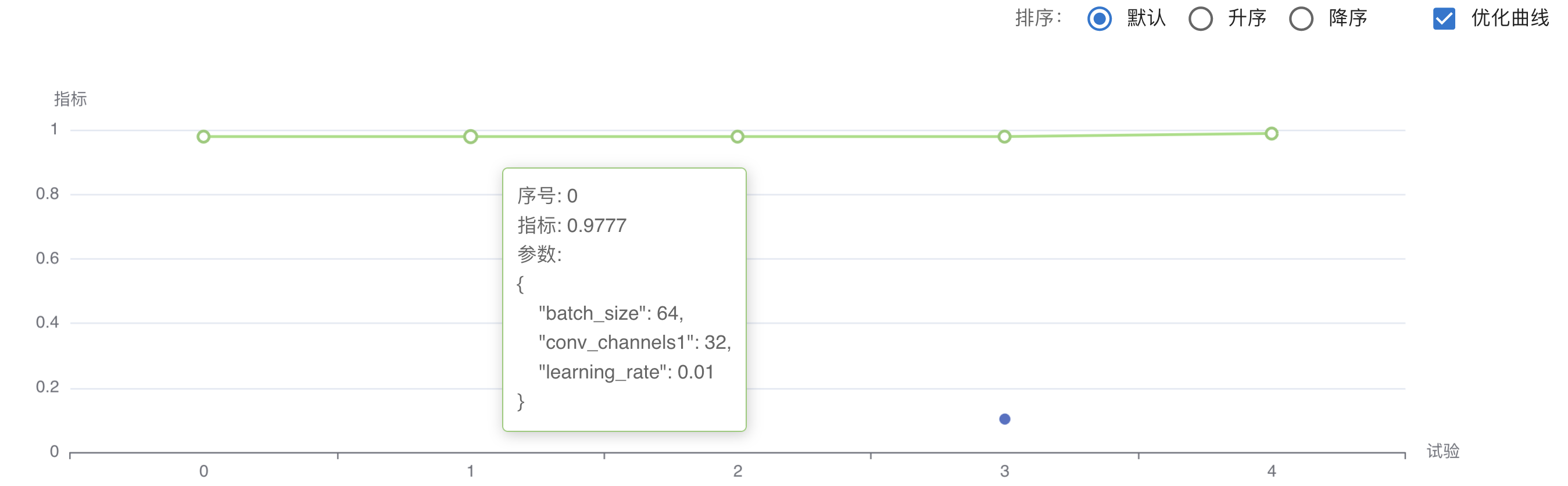

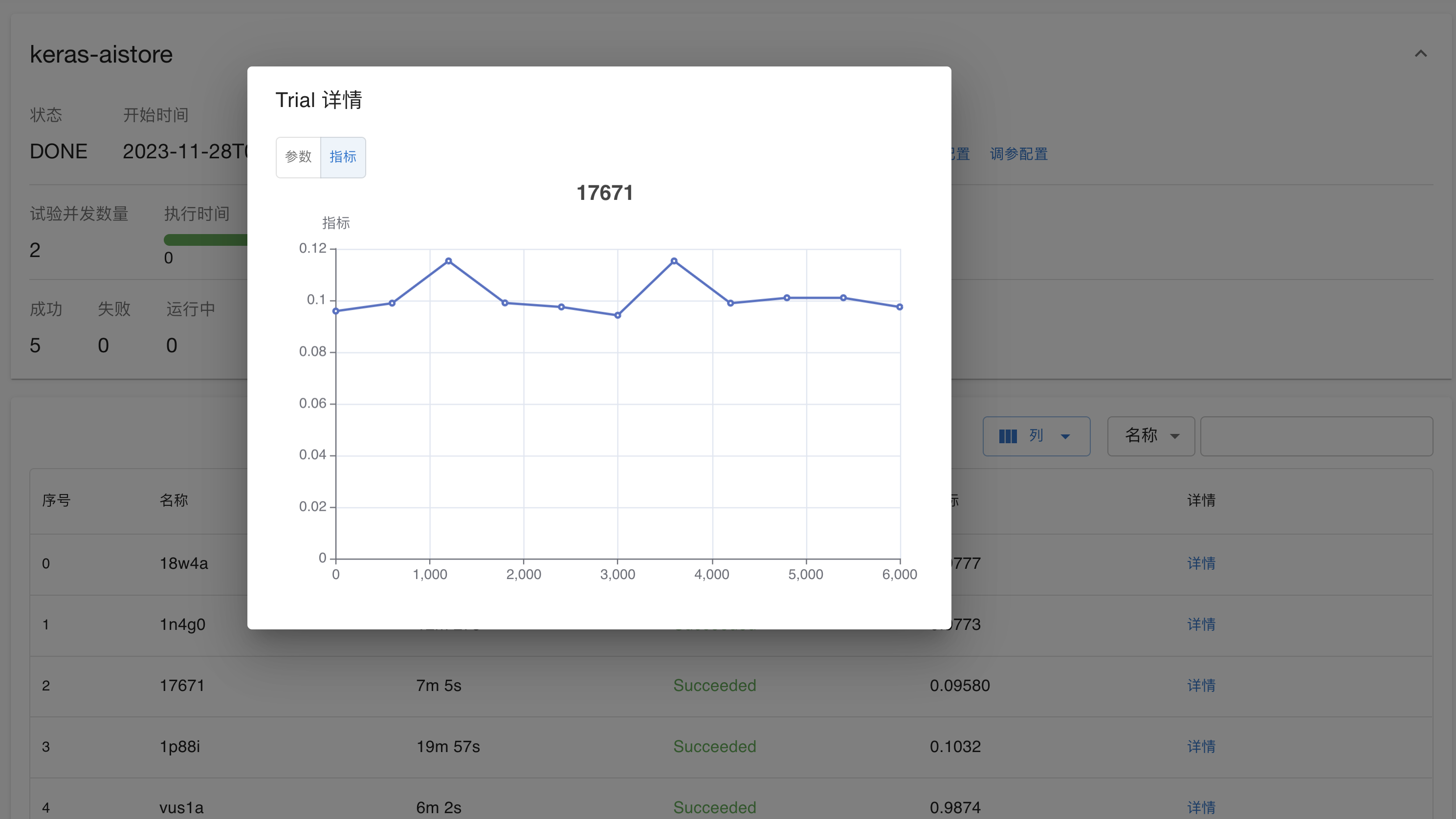

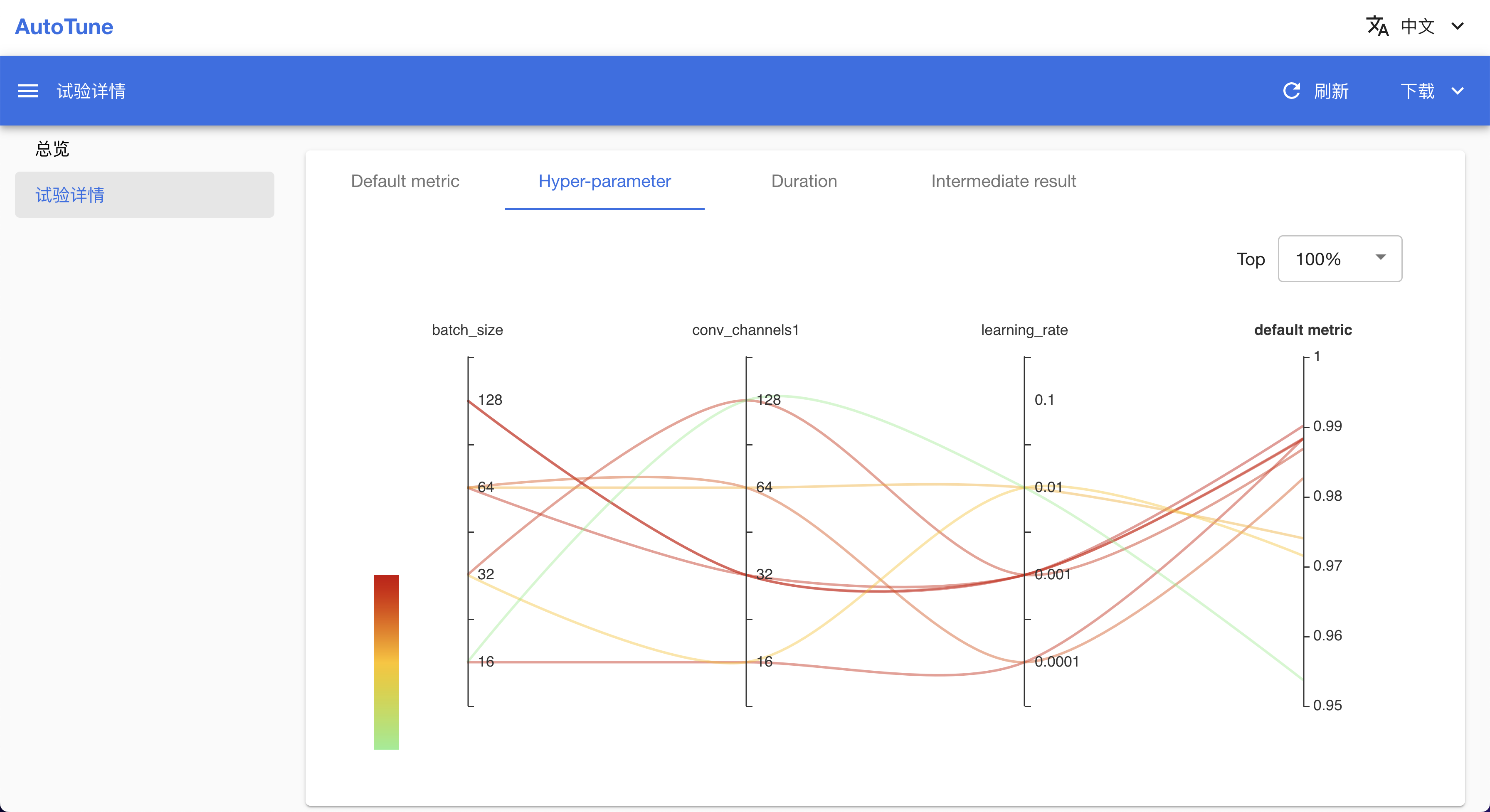

为了降低 AI 开发门槛和逐渐实现机器学习自动化,TensorStack AI 平台提供了自动化机器学习(AutoML)工具 AutoTune。AutoTune 具有以下特点:

- 内置最新的自动机器学习算法,为用户自动地进行特征工程、神经网络架构搜索、超参调优和模型压缩。

- 提供可视化展示平台,实时跟踪超参数训练过程,以交互式图形和表格的形式刻画多个不同维度的信息,用户可以借此更好地比较、分析、决策出最优参数。

- 持海量实验数据的存储,让用户轻松地实现任意实验结果之间的比较。

- 融合领先的 AI 最佳实践,提供自动化、准确性和协作水平,提高企业 AI 生产效率。

基本结构

在上述结构图中:

- AutoTune Controller 是 AutoTuneExperiment 的控制器,可以看做是 AutoTune 实验的入口。用户在集群中创建 AutoTuneExperiment 资源后,由控制器创建 AutoTune Server 和 Web 来执行 AutoTune 实验。

- AutoTune Server 是执行实验的主体,其中包括:

- Optimizer:超参数调优器,在限定的搜索空间内用特定的调优算法选择合适的超参数组合。

- Training Manager:训练任务管理器,使用 Optimizer 产生的超参数,创建 TrainingJob 进行训练,并将训练结果反馈给 Optimizer 用于下一次超参数选择。AutoTune 可以同时创建多组 TrainingJob 来测试不同的超参数组合以加快训练效率。目前 AutoTune 支持使用 TensorFlowTrainingJob、PyTorchTrainingJob 和 XGBoostTrainingJob 进行训练。

- AutoTune Web 是 AutoTune 的可视化界面,你可以通过此界面实时查看实验状态,对比各组超参数对实验产生的影响。

AutoTuneExperiment

你可以通过创建 AutoTuneExperiment 来实现自动优化模型超参数。

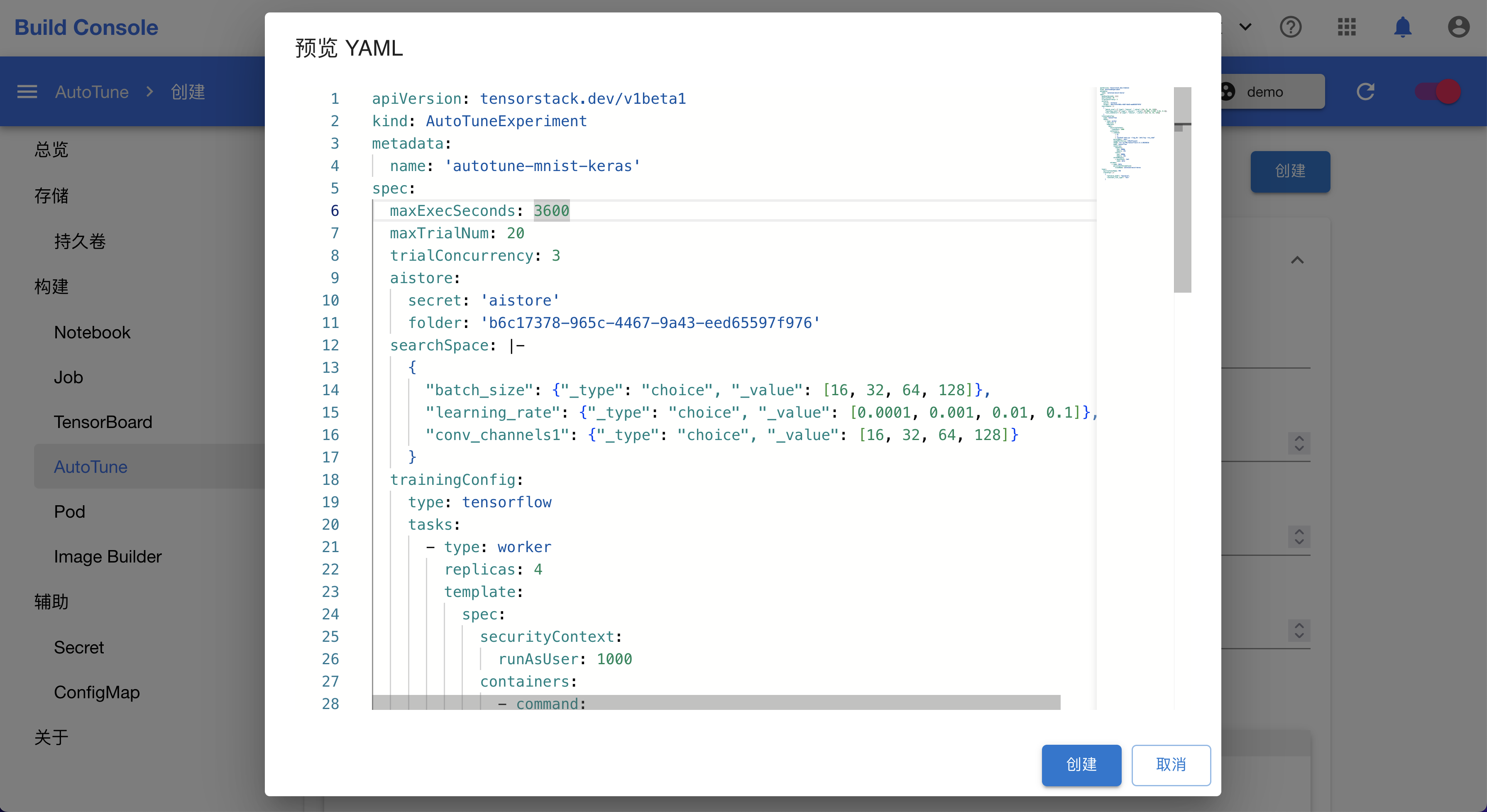

创建 AutoTuneExperiment

下面是一个基本的 AutoTuneExperiment 示例:

apiVersion: tensorstack.dev/v1beta1

kind: AutoTuneExperiment

metadata:

name: experiment-sample

spec:

maxExecSeconds: 7200

maxTrialNum: 50

trialConcurrency: 3

searchSpace: |-

{

"batch_size": {"_type": "choice", "_value": [512, 1024, 2048, 4096, 8092]},

"learning_rate": {"_type": "choice", "_value": [0.0001, 0.001, 0.01, 0.1]}

}

trainingConfig:

type: tensorflow

tasks:

- type: worker

replicas: 1

template:

spec:

securityContext:

runAsUser: 1000

containers:

- command:

- python3

- dist_mnist.py

workingDir: /mnt/mnist-distributed

imagePullPolicy: IfNotPresent

image: t9kpublic/tensorflow-1.15.2:tuner-2.23

name: tensorflow

tuner:

builtinTunerName: TPE

classArgs: |-

{

"optimize_mode": "minimize",

"constant_liar_type": "min"

}

在该例中:

- 使用 TensorFlowTrainingJob 进行训练(由

trainingConfig字段指定,详细配置方法请参阅训练框架支持)。 - 使用 TPE 算法进行超参数调优,算法的参数为

{"optimize_mode": "minimize", "constant_liar_type": "min"}(由tuner字段指定,更多参数请参阅超参数调优算法)。 - 超参数的搜索空间为

{"batch_size": {"_type": "choice", "_value": [512, 1024, 2048, 4096, 8092]},"learning_rate": {"_type": "choice", "_value": [0.0001, 0.001, 0.01, 0.1]}}(由searchSpace字段指定,搜索空间的格式及含义请参阅搜索空间)。 - 可以同时测试 3 组超参数,最大测试次数为 50(分别由

trialConcurrency和maxTrialNum字段指定),实验的最大执行时间为 2 小时(7200 秒,由maxExecSeconds字段指定),如果时间超出,实验进入TIMEOUT状态。

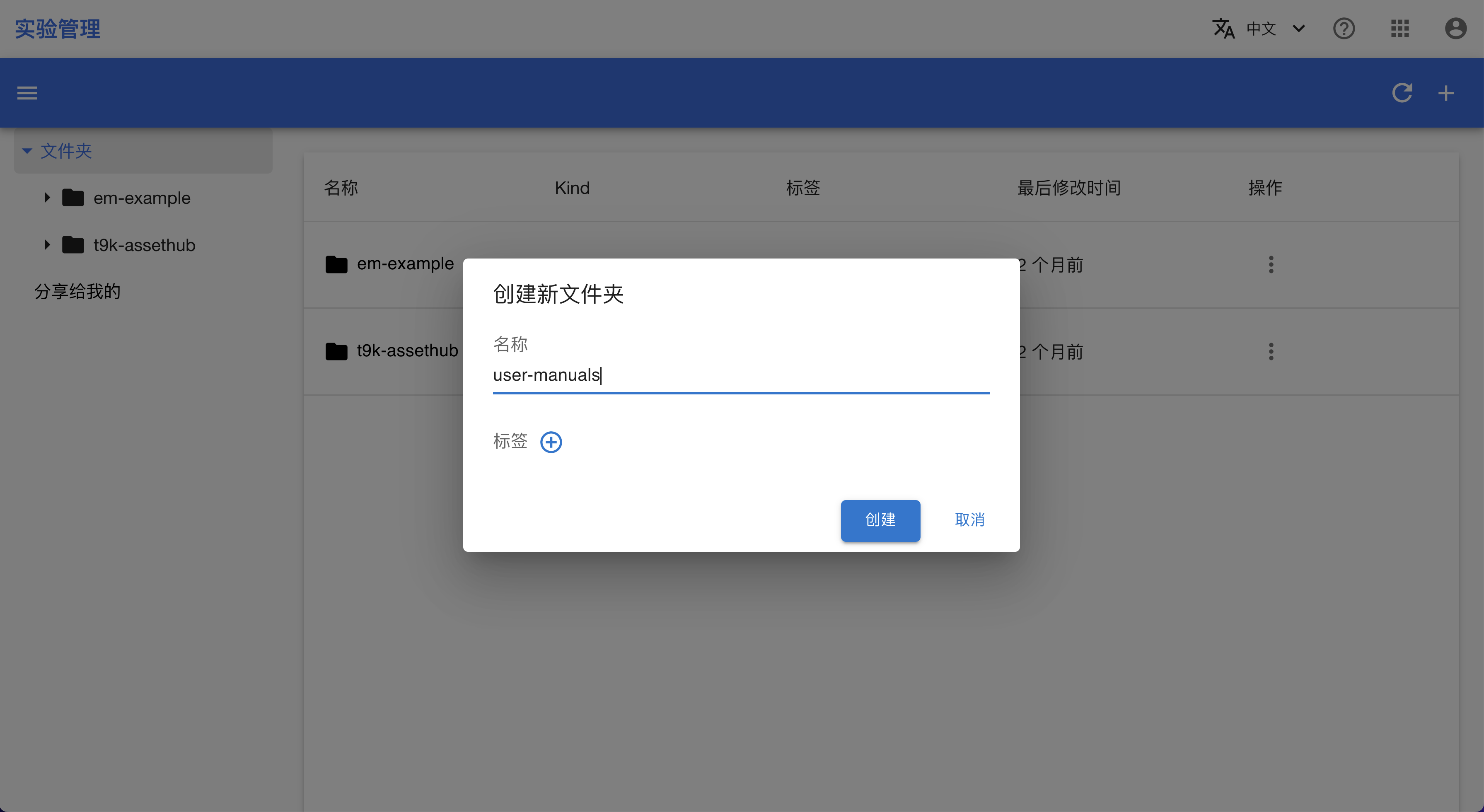

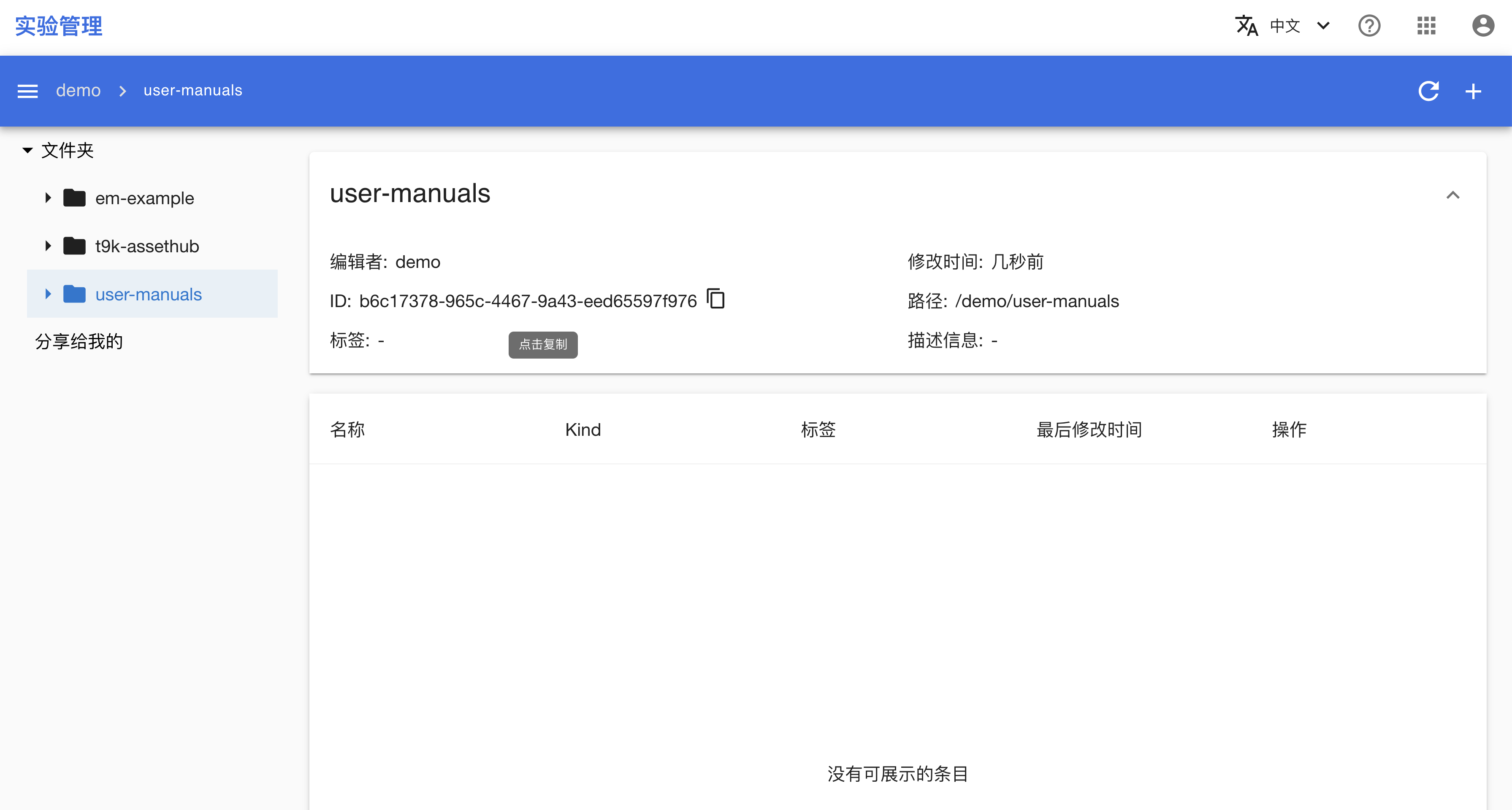

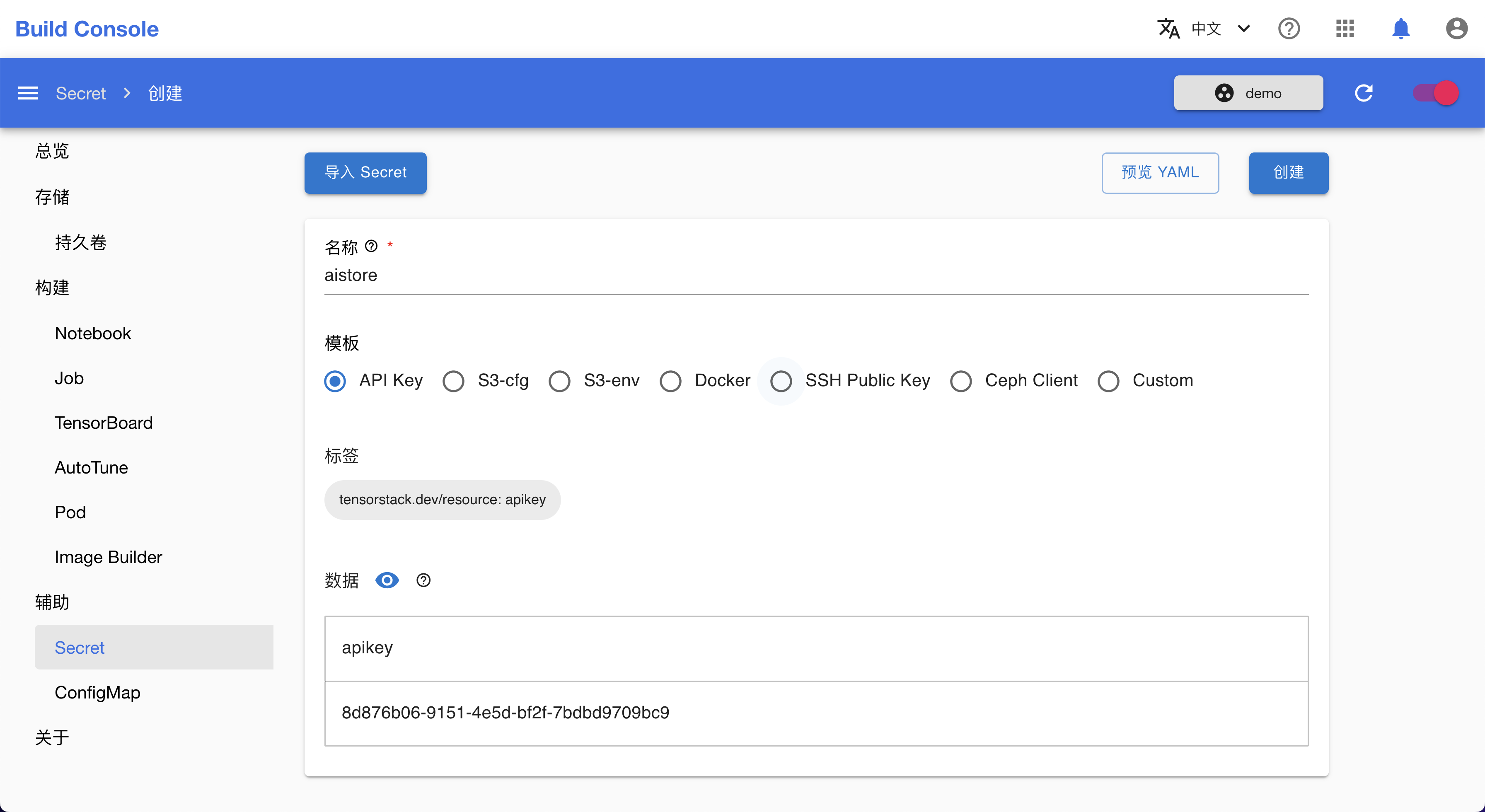

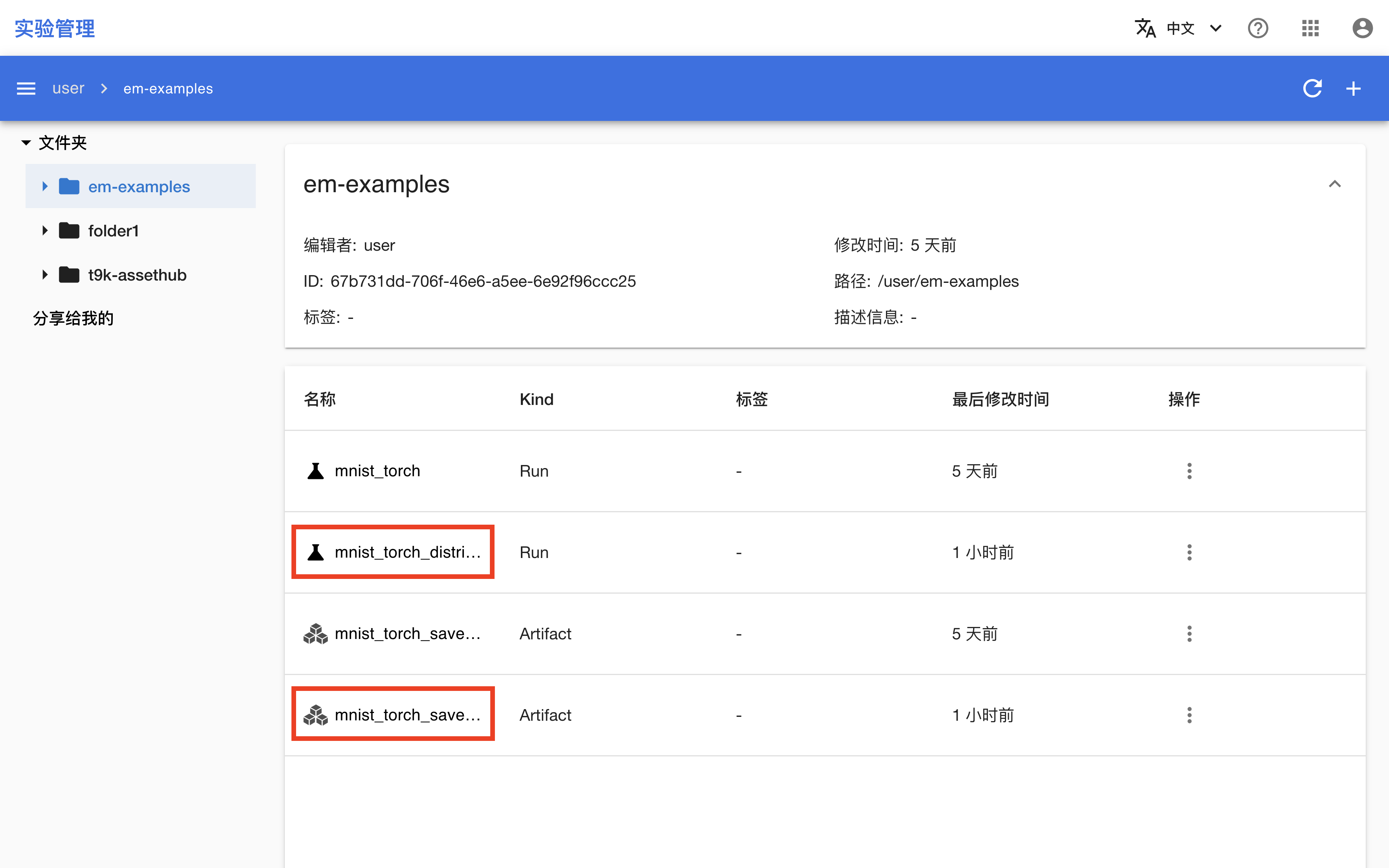

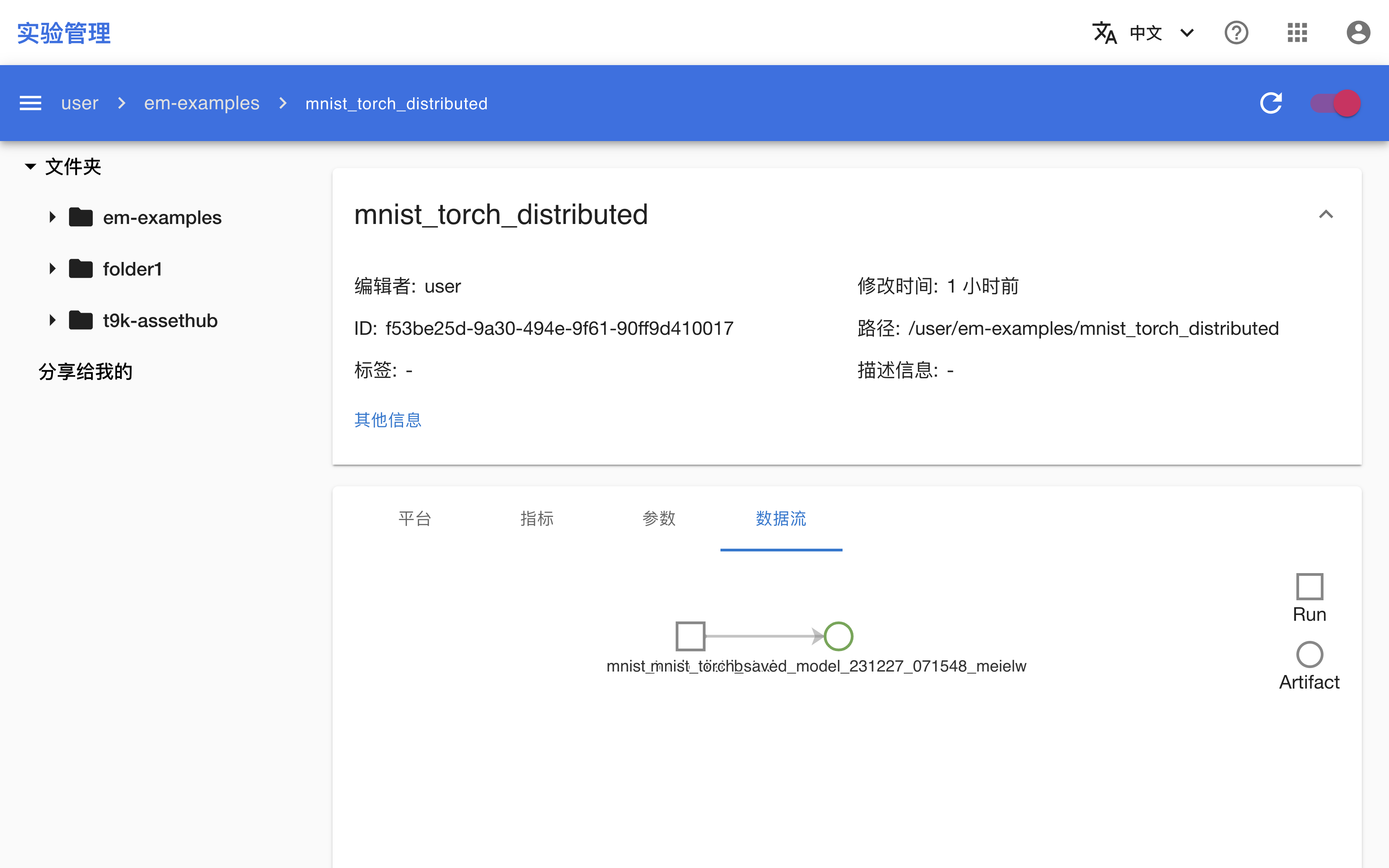

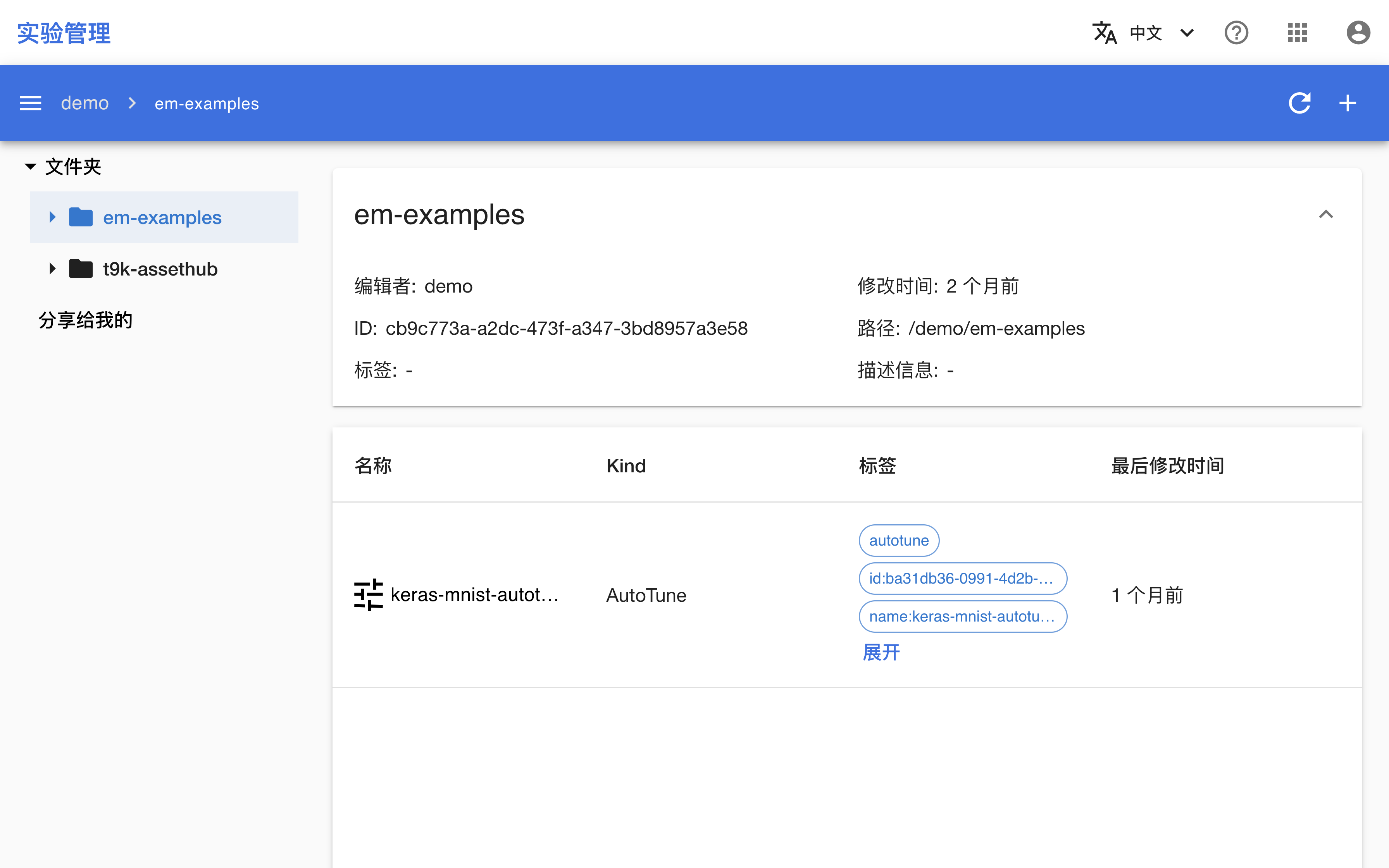

AIStore 的使用

AutoTuneExperiment 支持将实验数据存储在 AIStore 中,通过设置 spec.aistore 字段以使用 AIStore 数据库,其中:

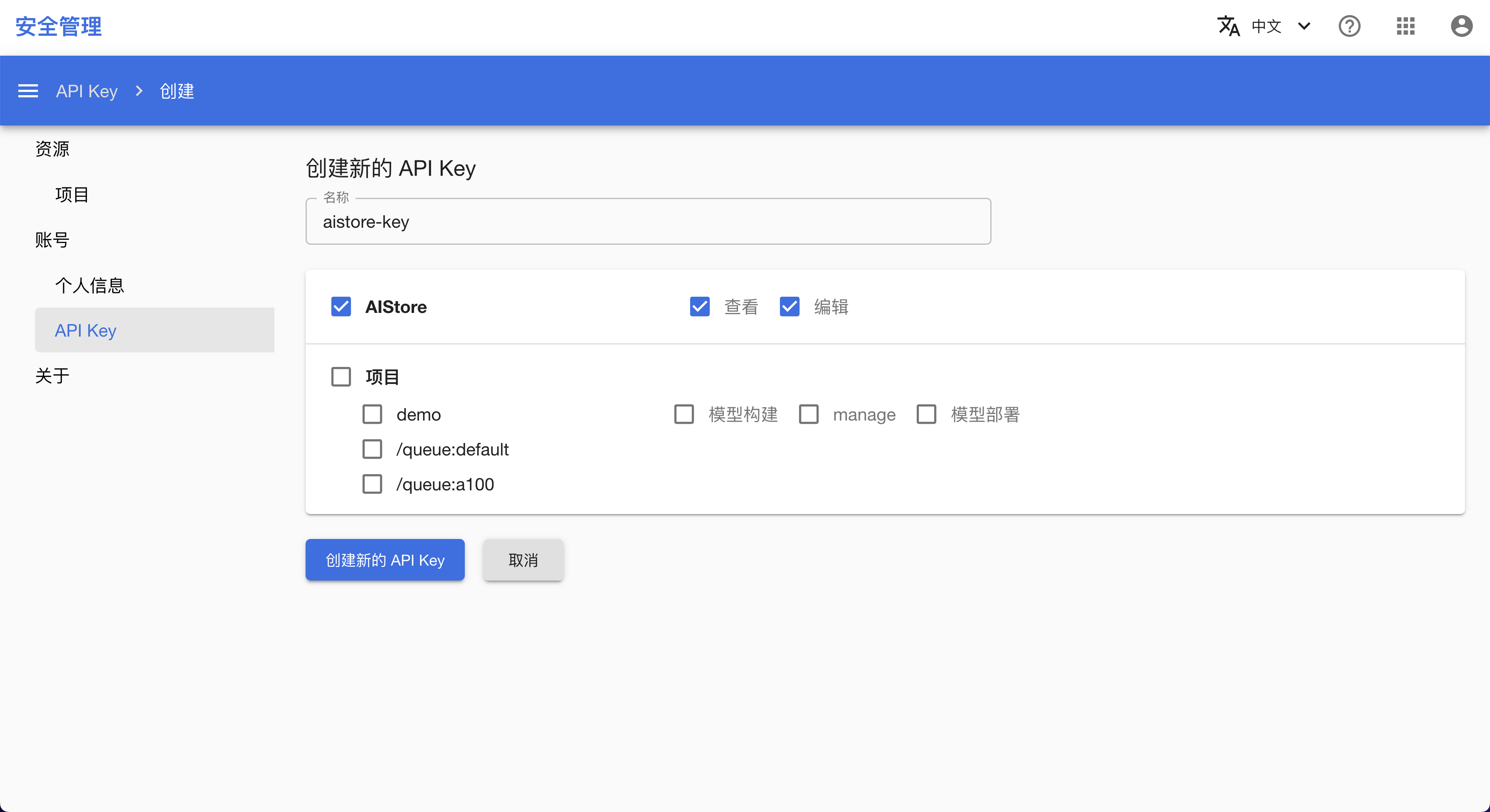

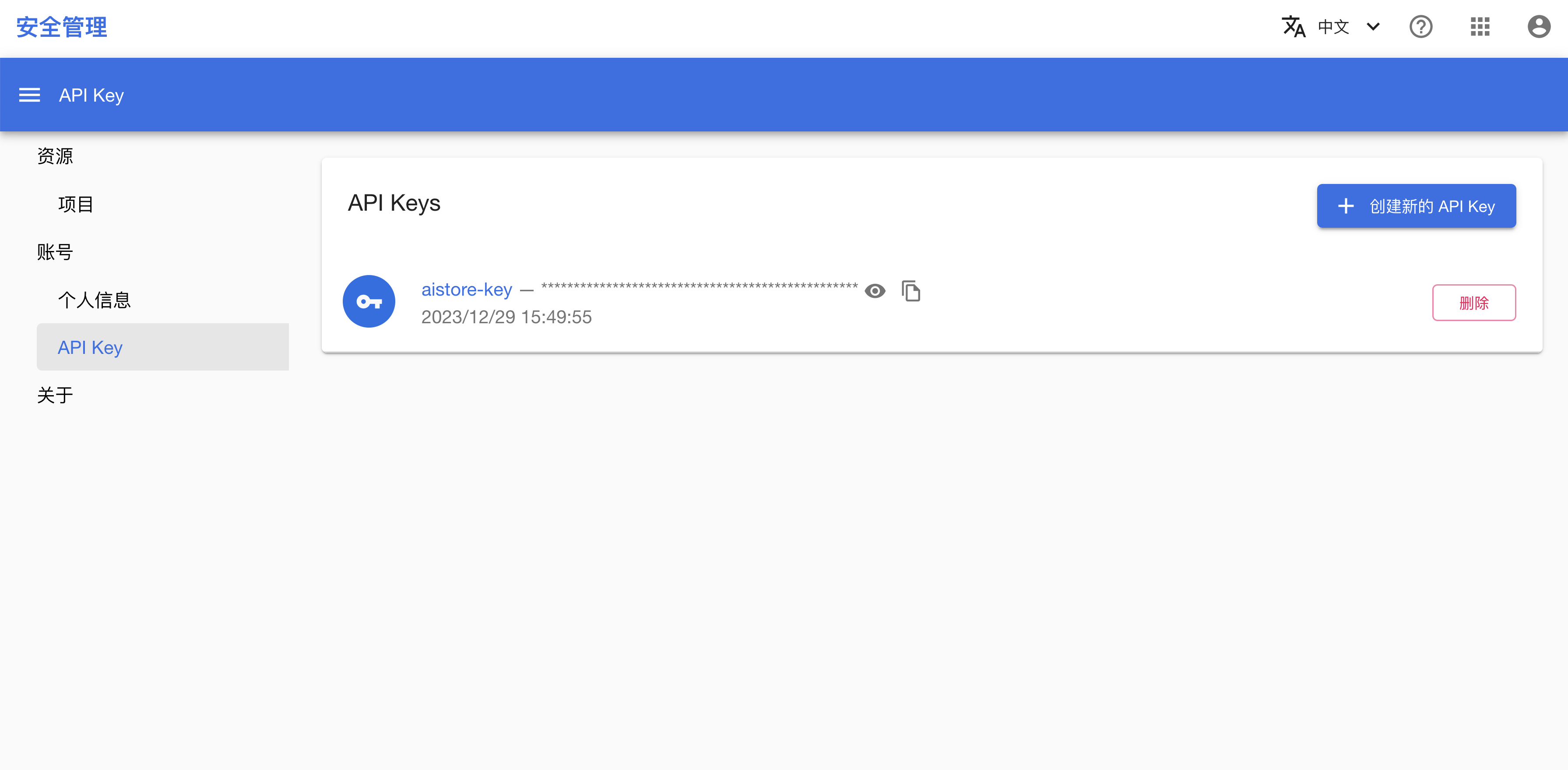

spec.aistore.folder声明实验数据存储在哪个 AIStore 文件夹中,内容应填写文件夹的 ID。spec.aistore.secret引用一个 K8s Secret,其中应记录 API Key,用于上传数据时进行身份验证。

下面是一个存储 APIKey 的 Secret 示例:

apiVersion: v1

data:

apikey: ZDQyMjJjZjUtMmI0Ni00Mjk2LWFiMzYtYWI4NmVhZGUwZjQx

kind: Secret

metadata:

name: aistore-secret

type: Opaque

搜索空间

搜索空间是实验过程中超参数的设置范围,AutoTuneExperiment 会在此范围中选择超参数进行训练,最后找出最优的超参数组合。

搜索空间是一个 JSON 结构,具体格式请参阅搜索空间。

训练框架支持

AutoTuneExperiment 支持对多种训练框架进行超参数的调优,包括 TensorFlow、PyTorch 和 XGBoost。

AutoTuneExperiment 通过设置 spec.trainingConfig 字段实现对上述框架的支持。其中:

spec.trainingConfig.type可设置为tensorflow、pytorch和xgboost,分别表示使用 TensorFlow、PyTorch 和 XGBoost 框架进行训练。spec.trainingConfig.tasks字段的设置请根据所使用的框架种类分别参阅 TensorFlowTrainingJob、PyTorchTrainingJob 和 XGBoostTrainingJob。

超参数调优算法

AutoTuneExperiment 在调参过程中需要使用超参数调优算法对超参数进行选择,对于不同的训练框架和不同的超参数种类,超参数调优算法的效率和效果也是不一样的。

算法根据功能和定义分为两类:

- Tuner 算法:超参数调优算法,用于选取合适的超参数组合。

- Assessor 算法:训练评估算法,用于判断当前训练是否符合预期,如果不符合则终止训练。

算法的详细介绍以及参数配置请参阅超参数调优算法。

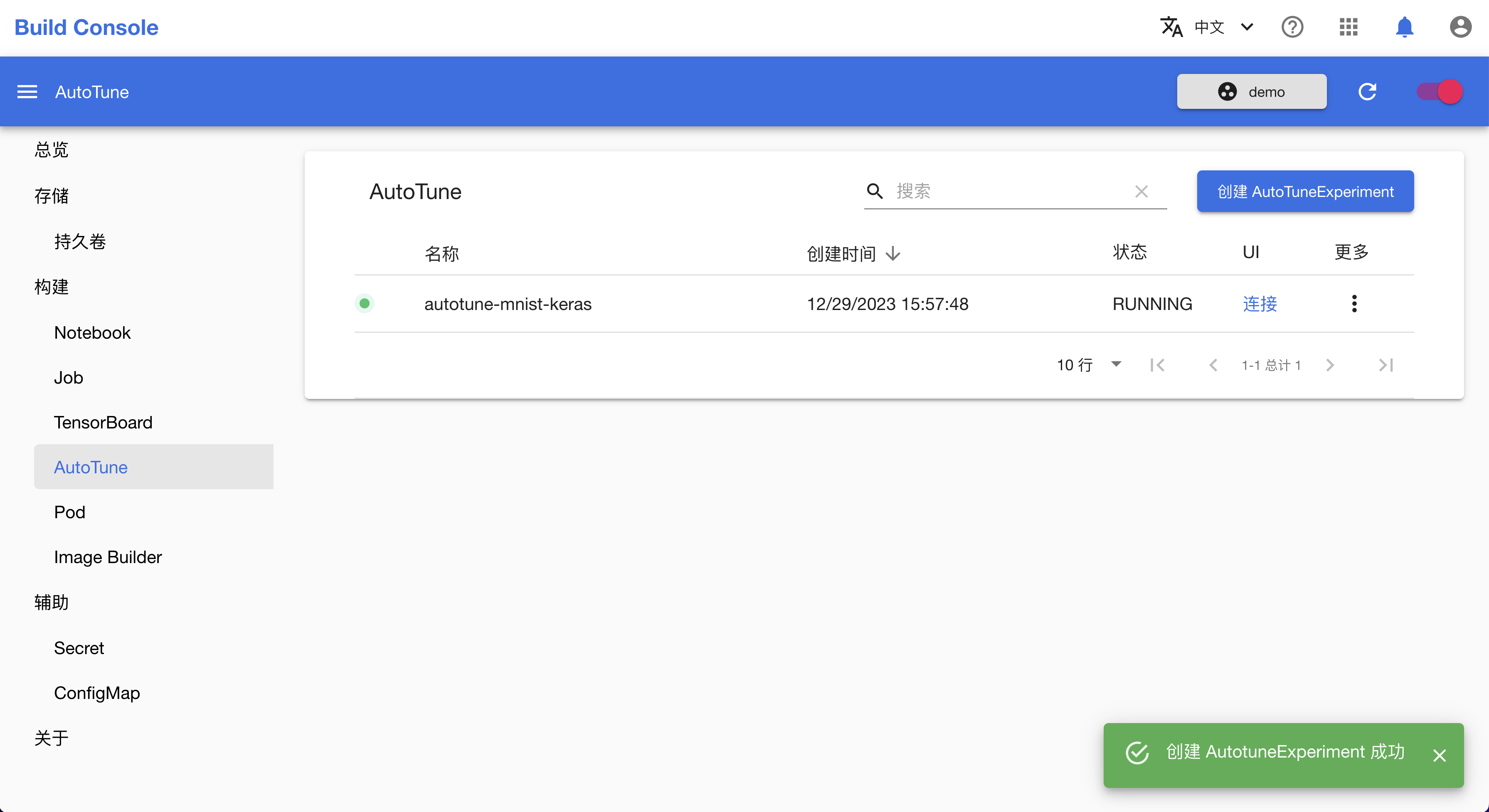

实验状态

AutoTuneExperiment 的生命周期包括以下五个阶段:

PENDING:AutoTune 的相关组件(包括 AutoTune Server 和 AutoTune Web)已经创建成功,等待控制器启动 AutoTuneExperiment。RUNNING:AutoTuneExperiment 运行中。TIMEOUT:如果达到最大执行时间(由spec.maxExecSeconds字段指定)后,实验仍未完成(实际训练次数小于maxTrialNum字段指定的训练次数),则实验超时,不再创建新的训练。DONE:AutoTuneExperiment 在最大执行时间内完成了maxTrialNum字段指定的训练次数(无论成功或失败),则实验完成。ERROR:AutoTuneExperiment 初始化阶段或运行阶段出现错误。

下一步

搜索空间

搜索空间用于定义超参数的范围,AutoTune 会在这一范围内对超参数进行组合并测试,最后得到效果最好的一组训练。

格式

{

"parameter1": {"_type": "choice", "_value":[1, 2, 3, 4]},

"parameter2": {"_type": "randint", "_value":[1, 10]},

...

}

在上述结构中:

- 每一个条目都记录了一个超参数的名称和搜索方式:

- 每一个条目的键值(例如

parameter1和parameter2)表示超参数的名称。 _type是超参数搜索方法。_value表示搜索方法所使用的参数。

- 每一个条目的键值(例如

choice和randint表示超参数的搜索方法,其具体含义请参阅搜索方法。

搜索方法

| _type | _value 格式 | 详细描述 |

|---|---|---|

choice | 数组(数字或字符串) | 每次训练选取数组 _value 中一个值作为超参数。例:{"learning_rate":{"_type": "choice", "_value": [0.01, 0.02, 0.1, 0.2]}},进行超参数调优时,每一组训练会从四个值中选取一个。 |

randint | [lower, upper] | 每次训练选取 lower 和 upper 之间中的一个随机整数(不包括 upper)作为超参数。例:{"learning_rate":{"_type": "randint", "_value": [1, 10]}},进行超参数调优时,每一组训练可能取到的值有 [1, 2, 3, 4, 5, 6, 7, 8, 9]。 |

uniform | [low, high] | 每次训练从 lower 到 upper 区间内均匀采样作为超参数。 |

quniform | [low, high, q] | 取值方法为 clip(round(uniform(low, high) / q) * q, low, high),此公式含义为:从 low 到 high 区间内均匀采样,然后将取值除以 q,并四舍五入为整数,然后将超出 [low, high] 区间的值舍弃,加上 low 和 upper 两个值,构成选值区间。例:_value 为 [0, 10, 2.5],表示超参数的选值范围时 [0, 2.5, 5, 7.5, 10];_value 为 [2, 10, 5],表示超参数的选值范围时 [2, 5, 10]。 |

loguniform | [low, high] | 取值方法为 exp(uniform(log(low), log(high))),此公式含义为:从 log(low) 到 log(high) 区间内均匀采样得到样本 x,然后计算 exp(x) 得到超参数。 |

qloguniform | [low, high, q] | 取值方法为 clip(round(loguniform(low, high) / q) * q, low, high)(其中 loguniform(low, high) 表示 exp(uniform(log(low), log(high)))),此公式含义参考 quniform 和 loguniform 条目。 |

normal | [mu, sigma] | 超参数的取值满足正态分布 N(mu, sigma^2)。 |

qnormal | [mu, sigma, q] | 取值方法为 round(normal(mu, sigma) / q) * q,此公式含义参考 quniform 条目。 |

lognormal | [mu, sigma] | 取值方法为 exp(normal(mu, sigma)),此公式含义参考 loguniform 条目。 |

qlognoraml | [mu, sigma, q] | 取值方法为 round(exp(normal(mu, sigma)) / q) * q,此公式含义参考 quniform 和 loguniform 条目。 |

超参数调优算法

AutoTuneExperiment 在调参过程中需要使用超参数调优算法对超参数进行选择,对于不同的训练框架和不同的超参数种类,超参数调优算法的效率和效果也是不一样的。

算法根据功能和定义分为两类:

- Tuner 算法:超参数调优算法,用于选取合适的超参数组合。

- Assessor 算法:训练评估算法,用于判断当前超参数的训练中间结果是否符合预期,如果不符合则终止训练。

Tuner 算法

HyperOpt 类算法

HyperOpt 是一个用于超参数调优的 Python 库,其中主要包含三种超参数调优算法:Random、Anneal 和 TPE。三种算法之间的区别以及算法的使用方法请参阅 HyperOpt 文档。

算法支持使用的搜索方法有:choice、randint、loguniform 和 qloguniform。

下面是 AutoTuneExperiment 使用此算法的一个示例(示例中的 classArgs 字段包含当前算法所有参数,有些参数在实际使用中可以选择不指定):

{

"tuner": {

"builtinTunerName": "Anneal",

"classArgs": {

"optimize_mode": "minimize",

"constant_liar_type": "min"

}

}

}

Evolution

进化算法(Evolution)是受生物进化启发得到的一种优化算法。进化算法的详细介绍请参阅 Evolutionary algorithm WIKI 文档。

下面是 AutoTuneExperiment 使用此算法的一个示例(示例中的 classArgs 字段包含当前算法所有参数,有些参数在实际使用中可以选择不指定):

{

"tuner": {

"builtinTunerName": "Evolution",

"classArgs": {

"optimize_mode": "minimize",

"population_size": 32

}

}

}

Batch

Batch 是一种最简单的选参算法,此算法只支持一种超参数的优化(搜索空间中只能有一个条目)且仅支持 choice 搜索方法。

下面是 AutoTuneExperiment 使用此算法的一个示例(Batch 算法不需要填写参数):

{

"searchSpace": {

"learning_rate": {"_type": "choice", "_value": [0.0001, 0.001, 0.01, 0.1]}

},

"tuner": {

"builtinTunerName": "Batch"

}

}

上述示例中,搜索空间中只有一个超参数,且 _type 为 choice;Batch 算法不需要传入参数,所以没有填写 tuner.classArgs 字段。

GridSearch

一种基本的选参算法,根据搜索空间中的参数和范围,枚举所有可能的超参数组合,一一测试。

算法支持使用的搜索方法有:choice、randint 和 quniform。

下面是 AutoTuneExperiment 使用此算法的一个示例(GridSearch 算法不需要填写参数):

{

"tuner": {

"builtinTunerName": "GridSearch"

}

}

MetisTuner

Metis 算法的详细介绍请参阅论文 Metis: Robustly Optimizing Tail Latencies of Cloud Systems。

算法支持使用的搜索方法有:choice、randint、uniform 和 quniform。

下面是 AutoTuneExperiment 使用此算法的一个示例(示例中的 classArgs 字段包含当前算法所有参数,有些参数在实际使用中可以选择不指定):

{

"tuner": {

"builtinTunerName": "MetisTuner",

"classArgs": {

"optimize_mode": "maximize",

"no_resampling": true,

"no_candidates": false,

"selection_num_starting_points": 600,

"cold_start_num": 10,

"exploration_probability": 0.9

}

}

}

GPTuner

GPT 是一种能够极大减少超参数优化步骤的贝叶斯优化算法。算法的详细介绍请参阅 NNI GPTuner 文档。

算法支持使用的搜索方法有:randint、uniform、quniform、loguniform、qloguniform 和数字形式的 choice。

下面是 AutoTuneExperiment 使用此算法的一个示例(示例中的 classArgs 字段包含当前算法所有参数,有些参数在实际使用中可以选择不指定):

{

"tuner": {

"builtinTunerName": "GPTuner",

"classArgs": {

"optimize_mode": "maximize",

"utility": "ei",

"kappa": 5,

"xi": 0,

"nu": 2.5,

"alpha": 1e-6,

"cold_start_num": 10,

"selection_num_warm_up": 100000,

"selection_num_starting_points": 250

}

}

}

PPOTuner

PPO 算法继承了 OpenAI 中 ppo2 的主要逻辑,并适应 NAS 场景。

算法支持使用的搜索方法有:layer_choice 和 input_choice。下面是一个搜索空间设置的示例:

{

"first_conv": {"_type": "layer_choice", "_value": ["conv5x5", "conv3x3"]},

"mid_conv": {"_type": "layer_choice", "_value": ["0", "1"]},

"skip": {

"_type": "input_choice",

"_value": {"candidates": ["", ""], "n_chosen": 1}

}

}

下面是 AutoTuneExperiment 使用此算法的一个示例(示例中的 classArgs 字段包含当前算法所有参数,有些参数在实际使用中可以选择不指定):

{

"tuner": {

"builtinTunerName": "PPOTuner",

"classArgs": {

"optimize_mode": "maximize",

"trials_per_update": 20,

"epochs_per_update": 4,

"minibatch_size": 4,

"ent_coef": 0.0,

"lr": 3e-4,

"vf_coef": 0.5,

"max_grad_norm": 0.5,

"gamma": 0.99,

"lam": 0.95,

"cliprange": 0.2

}

}

}

PBTTuner

PBT 算法得自 Population Based Training of Neural Networks。

下面是 AutoTuneExperiment 使用此算法的一个示例(示例中的 classArgs 字段包含当前算法所有参数,有些参数在实际使用中可以选择不指定):

{

"tuner": {

"builtinTunerName": "PBTTuner",

"classArgs": {

"optimize_mode": "maximize",

"population_size": 10,

"factor": 0.2,

"resample_probability": 0.25,

"fraction": 0.2

}

}

}

Assessor 算法

Medianstop

Medianstop 算法的逻辑是:如果在某一步 S,当前运行的实验的最佳观测值比所有已经完成的训练的第 S 步前的观测值的中位数差,则停止此次训练。此策略出自论文 Google Vizier: A Service for Black-Box Optimization 。

下面是 AutoTuneExperiment 使用此算法的一个示例(示例中的 classArgs 字段包含当前算法所有参数,有些参数在实际使用中可以选择不指定):

{

"assessor": {

"builtinAssessorName": "Medianstop",

"classArgs": {

"optimize_mode": "maximize",

"start_step": 0

}

}

}

在上述示例中,start_step 表示从第几步开始上传观测值(过早上传观测值,可能会错误的停止一些刚开始表现较差的训练)。

Curvefitting

Curvefitting 算法使用学习曲线拟合算法来预测未来的学习曲线性能。其逻辑是:如果在某一步,当前训练的预测结果是收敛的并且比历史上的最佳结果差,则停止此次训练。Curvefitting 算法的详细介绍请参阅 NNI Curvefitting 文档。

下面是 AutoTuneExperiment 使用此算法的一个示例(示例中的 classArgs 字段包含当前算法所有参数,有些参数在实际使用中可以选择不指定):

{

"assessor": {

"builtinAssessorName": "Curvefitting",

"classArgs": {

"optimize_mode": "minimize",

"epoch_num": 20,

"start_step": 6,

"threshold": 0.95,

"gap": 1

}

}

}

模型部署

TensorStack AI 平台的模型部署模块可以帮助你快速地将训练完成的 AI 模型部署为推理服务。

针对不同的应用场景,有以下两种 TensorStack API可供使用:

- MLService 是完善的模型推理服务,可用于生产环境,具有以下特性:

- 基于 Serverless 架构,服务容量(serving capacity)可根据负载自动伸缩;

- 自动暴露服务到集群外部,快速上线。

- SimpleMLService 是精简的模型推理服务,可用于快速测试、固定容量部署等场景。具有以下特性:

- 服务副本数目(replica)固定;

- 集群外部访问需要额外配置 Ingress 等资源。

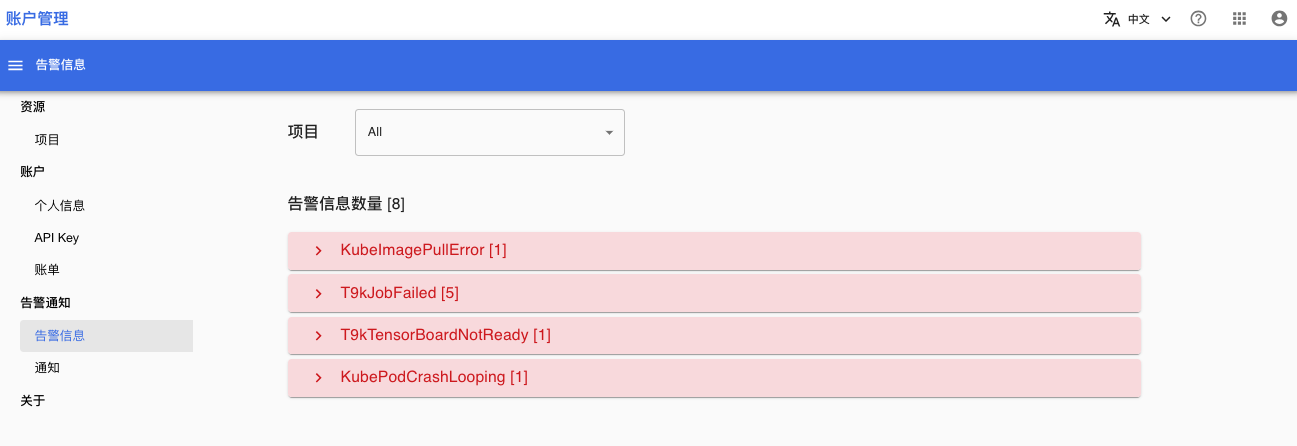

同时,TensorStack AI 平台对模型部署提供自动化的运维支持,包括性能和资源的监控告警以及故障检测,以保障推理服务长期可靠运行。

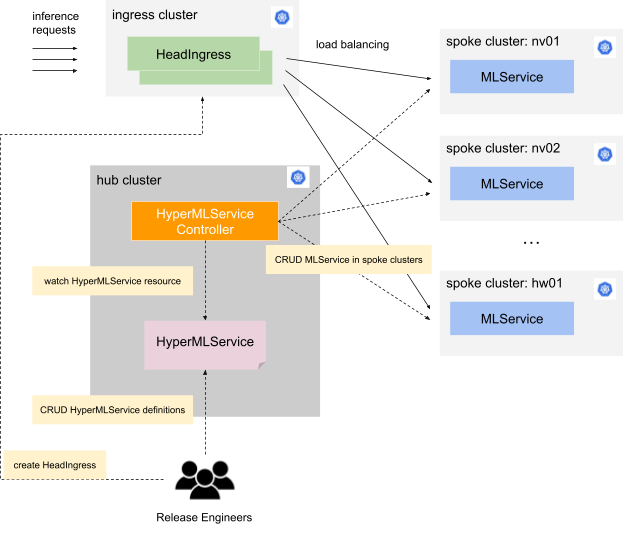

架构

模型部署模块的架构如下图:

根据用户提供的模型存储位置和 AI 框架等设置,模型部署模块的控制器(controller)协调模型下载并启动模型推理服务。

下一步

- 了解 SimpleMLService

- 了解 MLService

- 了解 模型存储

SimpleMLService

SimpleMLService 用于在 TensorStack AI 平台上简单、快捷地部署 AI 模型推理服务,可用于小规模模型部署,快速测试等场景。

SimpleMLService 具有以下特性:

- 直接支持 TensorFlow、PyTorch 框架,并允许用户自定义框架,具有良好的可扩展性。

- 支持 PVC、S3 模型存储方式。

- 直接支持从集群内部访问推理服务;集群外访问需要用户进行额外配置。

- 服务容量固定,不支持自动伸缩。

创建 SimpleMLService

下面是一个基本的 SimpleMLService 示例:

apiVersion: tensorstack.dev/v1beta1

kind: SimpleMLService

metadata:

name: mnist

spec:

replicas: 1

storage:

s3:

secretRef:

name: s3-secret

uri: s3://models/mnist/

mountPath: /var/lib/t9k/model

tensorflow:

image: t9kpublic/tensorflow-serving:2.6.0

resources:

requests:

cpu: 1

memory: 1Gi

本示例的 spec 字段的子字段释义如下:

replicas: 定义运行推理服务的副本数量是 1。storage.s3: 设定使用 S3 存储模型,子字段的释义如下:secretRef.name: Secrets3-secret中存储 S3 配置信息,其详情参见:创建 S3 Secret。uri: 模型在 S3 中的存储标识是s3://models/mnist/。mountPath: 模型被加载后,在容器中存储模型的文件系统路径是/var/lib/t9k/model。

tensorflow: 设定使用tensorflow推理框架,子字段释义如下:image: 指定推理服务容器镜像t9kpublic/tensorflow-serving:2.6.0。resources: 这顶一个副本 Pod 使用的资源量。

直接支持的 AI 框架

SimpleMLService 目前直接支持 TensorFlow、PyTorch 两种框架。

TensorFlow

可以通过设置 spec.tensorflow 字段来部署 TensorFlow 框架,参考示例:创建 SimpleMLService。

当使用 TensorFlow 时,控制器会在容器中设置下列启动命令:

/usr/bin/tensorflow_model_server \

--port=9090 \

--rest_api_port=8080 \

--model_name=<SimpleMLService name> \

--model_base_path=<model-dir-in-container>

PyTorch

可以通过设置 spec.pytorch 字段来部署 PyTorch 框架,示例如下:

spec:

pytroch:

image: <pytorch-image>

modelsFlag: "resnet-18=resnet-18.mar"

resources:

requests:

cpu: 1

memory: 1Gi

当使用 PyTorch 时,控制器会在容器中设置下列启动命令:

torchserve \

--start \

--model-store=<mode-dir> \

--models <spec.pytorch.modelsFlag>

自定义框架

如果需要使用 PyTorch, TensorFlow 之外的框架,可以通过设置 spec.custom 字段来自定义框架。

用户可在 spec.custom.spec 字段中定义一个完整的 PodSpec,并需要满足下列要求:

- 至少设置一个

containers成员。 - 启动推理服务运行命令时,指定正确的模型路径。

- 未设置 spec.service 时,推理服务的服务端口应该使用 8080。

示例如下:

apiVersion: tensorstack.dev/v1beta1

kind: SimpleMLService

metadata:

name: pvc-custom

spec:

replicas: 1

storage:

s3:

secretRef:

name: s3-secret

uri: s3://models/mnist/

mountPath: /custom/path

custom:

spec:

containers:

- name: user-container

args:

- --port=9000

- --rest_api_port=8080

- --model_name=mnist

- --model_base_path=/custom/path

command:

- /usr/bin/tensorflow_model_server

image: "t9kpublic/tensorflow-serving:2.6.0"

副本数量

副本数量通过字段 spec.replicas 设置,用于定义 SimpleMLService 的 Pod 数量,默认值是 1。

暴露服务

通过设置 spec.service 字段来选择将服务的哪个端口暴露出来。未设置时,默认将 Pod 的 8080 端口映射到 Service 的 80 端口。

下面是一个示例:

spec:

service:

ports:

- name: http

port: 80

targetPort: 8080

protocol: TCP

type: ClusterIP

在该例中:

- 将 Pod 的 8080 端口映射到 Service 的 80 端口,协议是 TCP。

- Service 的 Type 是 ClusterIP。

调度器

SimpleMLService 支持使用两种调度器:

通过 spec.scheduler 字段可以设置欲使用的调度器:

- 不设置

spec.scheduler字段,默认使用 Kubernetes 调度器。 - 设置

spec.scheduler.t9kScheduler字段,使用 T9k Scheduler 调度器。

在下面的示例中,SimpleMLService 使用 T9k Scheduler 调度器,并申请使用 队列 default 中的资源。

spec:

scheduler:

t9kScheduler:

queue: default

模型存储

通过 spec.storage 字段可以设置 SimpleMLService 的模型存储信息,详情请见模型存储。

服务状态

SimpleMLService 的状态记录在 status 字段中。

status.address 字段记录了推理服务在集群内的访问地址,子字段如下:

url: 推理服务在集群内的访问地址ports: 推理服务可供访问的服务端口

status.conditions 字段表明了当前 SimpleMLService 的状态,包括下列 2 种类型:

ModelDownloaded: 模型是否成功地被下载到本地。Ready: 推理服务是否就绪。

在下面的示例中:

- 访问推理服务的地址是

sample.demo.svc.cluster.local - 模型已经下载到容器本地

- 推理服务处于就绪状态

status:

address:

url: sample.demo.svc.cluster.local

ports:

- port: 80

protocol: TCP

conditions:

- lastTransitionTime: "2023-12-27T06:52:39Z"

status: "True"

type: ModelDownloaded

- lastTransitionTime: "2023-12-27T06:52:41Z"

message: Deployment has minimum availability.

reason: MinimumReplicasAvailable

status: "True"

type: Ready

下一步

- 学习如何部署一个简单推理服务

- API 参考:SimpleMLService

MLService

MLService 用于在 TensorStack AI 平台上部署 AI 推理服务,其功能全面,可用于生产环境。

概述

MLService 是推理服务的核心 API,由 releases 和 transformer 两部分构成:

spec.releases定义一个或多个releases,以提供多版本模型推理服务的支持。- 可选的

transformer定义前处理(pre-processing)和后处理(post-processing)计算。

MLService 的主要特性包括:

- 支持定义多个版本(

release)的推理服务,每个release包含一个predictor,其定义了:- 模型存储(

storage) - 模型规约(

model),包括parameters,runtime(引用MLServiceRuntime定义运行推理服务Pod的模板) - 计算资源(

containersResources) - 其他部署参数(

minReplicas, maxRelicas, logger ...)

- 模型存储(

- 每个

release服务的容量可独立自动伸缩,可通过minReplicas、maxReplicas设置容量的上下限。 - 支持金丝雀(canary release)发布模式。

- 用户可定制

transformer组件,以在调用推理服务时进行前处理(pre-processing),以及获得推理结果后进行后处理(post-processing)。 transformer的容量也可独立自动伸缩,可通过minReplicas、maxReplicas设置容量的上下限。

示例

下面是一个基本的 MLService 示例:

apiVersion: tensorstack.dev/v1beta1

kind: MLService

metadata:

name: torch-mnist

spec:

default: version1

releases:

- name: version1

predictor:

minReplicas: 1

maxReplicas: 3

model:

parameters:

"MODEL_PATH": "mnist=model.mar"

runtime: torchserve

storage:

pvc:

name: tutorial

subPath: tutorial-examples/deployment/pvc/mlservice-torch/

containersResources:

- name: user-container

resources:

limits:

cpu: "500m"

memory: 1Gi

MLServiceRuntime

在示例中,我们使用了 MLServiceRuntime torchserve。MLServiceRuntime 定义了推理服务的模板,包含了推理服务的关键信息,例如镜像、启动命令、资源需求等,能够方便地帮助用户快速部署多种模型推理服务程序。

一个 MLServiceRuntime 可以被多个 MLService 使用。

定义

一个基本的 MLServiceRuntime 的示例:

apiVersion: tensorstack.dev/v1beta1

kind: MLServiceRuntime

metadata:

name: torchserve

spec:

enabled: true

template:

spec:

containers:

- name: user-container

image: torchserve:0.9.0-cpu

args:

- torchserve

- --start

- --model-store=/var/lib/t9k/model

- --models {{if .MODEL_PATH}}{{.MODEL_PATH}}{{else}}all{{end}}

resources:

limits:

cpu: "200m"

memory: 200Mi

ports:

- containerPort: 8080

protocol: TCP

该 MLServiceRuntime 在 spec.template 中定义了推理服务的副本(Pod)的模板,以指定容器镜像 torchserve:0.9.0-cpu、启动命令 torchserve 及其他命令行参数等。

使用

用户可以在 MLService 的 predictor 定义中指定要使用的 MLServiceRuntime 名称,例如:

apiVersion: tensorstack.dev/v1beta1

kind: MLService

metadata:

name: demo

spec:

default: version1

releases:

- name: version1

predictor:

model:

runtime: torchserve

storage:

pvc:

name: <pvc-name>

subPath: <model-path>

用户在 release version1 的 .predictor.model.runtime 中指定了 torchserve,系统在创建推理服务器副本(Pod)时,将会使用名称为 torchserve 的 MLServiceRuntime。

进一步的配置

除了直接使用 MLServiceRuntime 定义好的 Pod 模板,MLService 还支持对其进行进一步的配置和修改。

Parameters

MLService 支持在 predictor 的 .model.parameters 设置参数,该字段是一个 map 类型,key 为参数名,value 为参数值。

在之前的 MLServiceRuntime 示例 中包含了 --models {{if .MODEL_PATH}}{{.MODEL_PATH}}{{else}}all{{end}} 的内容。这里使用了 golang template 的语法,含义为:

- 如果使用此 MLServiceRuntime 的 MLService 指定了

MODEL_PATH,这一行会被设置为--model <用户指定的 MODEL_PATH> - 如果没有指定

MODEL_PATH,这一行会被设置为--model all

如下所示,在 MLService 中设置 MODEL_PATH:

apiVersion: tensorstack.dev/v1beta1

kind: MLService

metadata:

name: demo

spec:

default: version1

releases:

- name: version1

predictor:

model:

parameters:

"MODEL_PATH": "mnist=model.mar"

runtime: torchserve

storage:

pvc:

name: <pvc-name>

subPath: <model-path>

由上述 MLService 最终产生的副本(Pod)的 args 中会包含 --model mnist=model.mar,指定了使用模型的名称和文件。

StrategicMergePatch

MLServiceRuntime 定义了 Pod 模板,但不一定能适用于所有场景。MLService 支持用户在 MLServiceRuntime 的基础上,进行进一步的叠加修改,例如:

apiVersion: tensorstack.dev/v1beta1

kind: MLService

metadata:

name: demo

spec:

default: version1

releases:

- name: version1

predictor:

model:

parameters:

"MODEL_PATH": "mnist=model.mar"

runtime: torchserve

storage:

pvc:

name: <pvc-name>

subPath: <model-path>

template:

spec:

containers:

- name: user-container

image: self-torchserve:latest

将上面 MLService 中 predictor version1 的 template.spec 和之前的 Runtime 定义示例 相比,

可以发现他们都定义了一个名为 user-container 的 container,但是 image 不同。

于是最终生成的 Pod 中,MLService 中定义的 image 会覆盖 MLServiceRuntime 中的 image,但是 MLServiceRuntime 中 args 等其余设置都会被保留。

计算资源

MLServiceRuntime 定义了 Pod 模板,但对于容器的资源要求,不同场景之间存在差异。因此, MLServiceRuntime 中定义的容器资源要求只是一个缺省时的默认值。

用户可以直接在 MLService predictor 中的 containersResources 定义容器的资源要求,例如:

apiVersion: tensorstack.dev/v1beta1

kind: MLService

metadata:

name: demo

spec:

default: version1

releases:

- name: version1

predictor:

model:

modelFormat:

name: pytorch

storage:

pvc:

name: <pvc-name>

subPath: <model-path>

containersResources:

- name: user-container

resources:

limits:

cpu: "500m"

memory: 1Gi

模型存储

你可以为 Release 或 Transformer 定义模型存储:

- 通过

spec.releases[*].predictor.storage可以设置当前 Release 的模型存储信息。 - 通过

spec.transformer.storage可以设置 Transformer 的模型存储信息。

详情请见 模型存储。

更多配置

发布策略

多版本支持

一个 MLService 可以同时部署多个版本(release)的推理服务,以使用不同的模型文件,或者其他配置等。

在下面的示例中,MLService 同时部署了 nov-02(设置为默认)、nov-05 和 nov-11 三个版本的服务,这三个版本都使用同一个 MLServiceRuntime,但是使用了不同的模型:

apiVersion: tensorstack.dev/v1beta1

kind: MLService

metadata:

name: multi-releases

spec:

default: nov-02

releases:

- name: nov-02

predictor:

model:

runtime: torchserve

storage:

pvc:

name: tutorial

subPath: model-11-02

- name: nov-05

predictor:

model:

runtime: torchserve

storage:

pvc:

name: tutorial

subPath: model-11-05

- name: nov-11

predictor:

model:

runtime: torchserve

storage:

pvc:

name: tutorial

subPath: model-11-11

金丝雀发布

MLService 支持金丝雀(canary release)发布策略。用户可以通过 spec.canary 字段设置金丝雀发布对应的模型版本(release),spec.canaryTrafficPercent 字段设置金丝雀发布的路由权重。spec.default 是必需字段,用于设置默认发布。

例如上一节中我们部署了 3 个版本的模型,我们想主要(80% 流量)使用 nov-02 这个版本,并且将刚刚训练好的 nov-11 作为金丝雀版本:

- 默认发布:

nov-02,路由权重为 80%。 - 金丝雀发布:

nov-11,路由权重为 20%。

...

spec:

default: nov-02

canary: nov-11

canaryTrafficPercent: 20

...

日志收集

MLService 支持对预测请求进行日志收集,详情见2.2.2.1日志收集

前处理及后处理

MLService 支持部署含有 transformer 模块的前处理(pre-processing)及后处理(post-processing)的推理服务:

- 预处理:用户发向推理服务的原始数据,先经过 transformer 预处理,然后再被发送到推理服务。

- 后处理:推理服务返回的预测结果,先经过 transformer 后处理,然后再返回给用户。

用户可以使用 Tensorstack SDK 编写 transformer 代码,制作镜像,并基于该镜像创建含有 transformer 的推理服务。详细示例请参阅制作并部署含有 Transformer 的模型推理服务。

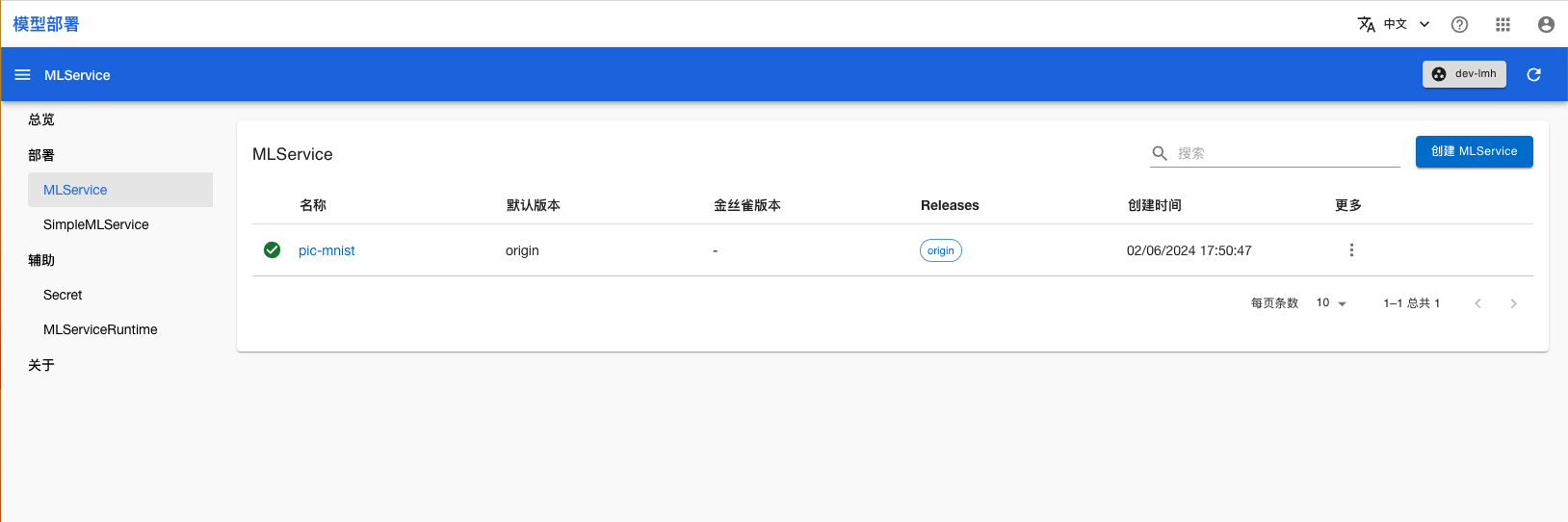

下文展示了一个使用 transformer 的推理服务:

apiVersion: tensorstack.dev/v1beta1

kind: MLService

metadata:

name: pic-mnist

spec:

default: origin

transformer:

minReplicas: 1

minReplicas: 5

template:

spec:

containers:

- name: user-container

image: t9kpublic/transformer-example:0.1.0

resources:

limits:

cpu: "500m"

memory: 500Mi

容量伸缩

MLService 支持自动伸缩服务容量:即根据服务负载的变化,自动调节推理服务的部署规模(副本数量)。具体原理可以查看 Knative Autoscaling。

用户可以通过设置 spec.releases[*].predictor.minReplicas 字段和 spec.releases[*].predictor.maxReplicas 字段来指定 Predictor 工作负载数量的下限和上限。

同样的,如果用户启用了 Transformer,可以通过 spec.transformer.minReplicas 字段和 spec.transformer.maxReplicas 字段来指定 Transformer 工作负载数量的下限和上限。

以下是一些特殊情况:

minReplicas不填时,工作负载数量的默认最小值为 1。minReplicas等于 0 时,当没有流量请求时,MLService 会缩容到 0,不再占用系统资源。maxReplicas不填或设为 0 时,工作负载数量没有上限。

除了负载数量的限制,用户还可以在具体的 Runtime 或者组件(Predictor 或者 Transformer)的 Pod 定义中设置 Knative Autoscaling 相关的 Annotation,例如:

...

spec:

releases:

- name: version1

minReplicas: 1

maxReplicas: 3

predictor:

template:

metadata:

annotations:

autoscaling.knative.dev/metric: "rps"

autoscaling.knative.dev/target: "100"

...

在上面的示例中,我们设置了工作负载数量的范围为 [1,3],自动伸缩指标(metric)为 rps,自动伸缩目标(target)为 100。这意味着当每个工作负载每秒处理的请求数量(requests-per-second)达到 100 时,负载会开始扩容,且扩容最大数量为 3,最小数量为 1。

调度器

MLService 支持使用两种调度器:Kubernetes 默认调度器(默认)和 T9k Scheduler。MLService 通过 spec.scheduler 字段设置调度器:

- 不设置

spec.scheduler字段,则默认使用 Kubernetes 默认调度器。 - 设置

spec.scheduler.t9kScheduler字段,则使用 T9k Scheduler 调度器。

在下面的示例中,使用了 T9k Scheduler 调度器,且工作负载处于队列 default 中。

...

spec:

scheduler:

t9kScheduler:

queue: default

...

服务状态

通过 MLService 的状态字段可以获取如下信息:

- 推理服务的全局状态及服务地址:

status.ready表明推理服务是否准备就绪,status.address.url表明全局推理服务地址。 - 每个部署的模型的状态及服务地址:

status.releases[*].ready表明该版本推理服务是否准备就绪,status.releases[*].url表明该版本的推理服务地址。 - Transformer 的状态及服务地址:

status.ready表明 Transformer 服务是否准备就绪,status.transformer.url表明 Transformer 服务地址。 - 推理服务没有就绪的原因:

status.conditions以及status.releases[*].message等字段中会记录相关报错信息。

以多版本支持的示例的状态为例,其 MLService 状态字段如下。从状态字段可以看出,该推理服务处于就绪状态,外部访问地址为 http://multi-releases.<project>.<domain>,某个 release 的访问地址为 http://multi-releases-predict-<release>.<project>.<domain>

status:

address:

url: http://multi-releases.<project>.<domain>

canaryRelease: nov-02

conditions:

- lastTransitionTime: "2023-11-27T10:44:27Z"

status: "False"

type: Paused

- lastTransitionTime: "2023-11-27T10:50:04Z"

status: "True"

type: Ready

defaultRelease: nov-05

releases:

- name: nov-02

ready: true

readyReplicas: 1

totalReplicas: 1

trafficPercent: 80

url: http://multi-releases-predict-nov-02.<project>.<domain>

- name: nov-05

ready: true

readyReplicas: 1

totalReplicas: 1

trafficPercent: 20

url: http://multi-releases-predict-nov-05.<project>.<domain>

- name: nov-11

ready: true

readyReplicas: 1

totalReplicas: 1

trafficPercent: 0

url: http://multi-releases-predict-nov-11.<project>.<domain>

如果推理服务没有就绪,你可以通过查看 status.conditions 中 type 为 Ready 的 reason 以及 message 来查看具体信息,同时 Event 中也会有相关的错误信息。

访问推理服务

MLService 部署成功后,通过状态字段 status.address.url 可以查询到全局推理服务的 Base URL,再加上部署模型对应的路径即可得到访问推理服务的地址。

以示例中的服务为例,推理服务地址的状态字段如下:

...

status:

address:

url: http://torch-mnist.<project>.<domain>

...

由于服务使用的是 TorchServe 框架,按照其 API 规范,用户可以通过下述命令查看服务状态:

$ curl http://torch-mnist.<project-name>.<domain-name>/v1/models/mnist

{

"model_version_status": <model-status>

}

并调用推理服务:

# 数据在 https://github.com/t9k/tutorial-examples/blob/master/deployment/pvc/mlservice-torch/test_data/0.png

$ curl -T test_data/0.png http://torch-mnist.<project-name>.<domain-name>/v1/models/mnist:predict

{

"predictions": <predict-result>

}

下一步

- 学习如何部署一个模型推理服务

- 学习如何部署一个包含 Transformer 的推理服务

- 应用示例:使用 vLLM 部署 LLM 推理服务

- 应用示例:部署对话式搜索引擎

参考

- API 参考:MLService

- API 参考:MLServiceRuntime

- Knative Autoscaling

日志收集

MLService 支持对 predictor 和 transformer 服务进行日志收集,包括接收到的 request 和返回的 response 消息。开启日志收集后,系统会为 MLService 添加日志发送能力,其根据配置的接收 URL,将日志发送到 URL 指定的服务。

设置 MLService

用户可以为每个 predictor 和 transformer 设置日志收集功能:

- predictor: MLService 的

spec.releases[*].predictor.logger字段来启用 predictor 的日志收集功能。 - transformer:通过设置 MLService 的

spec.transformer.logger字段启用 transformer 的日志收集功能。

用户可以通过日志收集的下列字段,来设置日志收集配置:

urls:url 数组,系统会将收集到的日志发送到 url 对应的服务。mode:表示对哪些内容进行收集记录。可选值是 all, response, request,默认值是 all。- all:requests 和 response 都会被收集记录。

- response:只记录收集 response。

- request:只记录收集 requests。

接收日志

日志数据通过 HTTP 协议被发送(HTTP POST)到用户提供的 URL。

日志数据格式是 CloudEvent,如下例所示:

Context Attributes,

specversion: 1.0

type: tensorstack.dev.mlservice.response

source: torch-mnist-logger-predict-origin

id: 0009174a-24a8-4603-b098-09c8799950e9

time: 2021-04-10T00:23:26.080736102Z

datacontenttype: application/json

Extensions,

component: predict

inferenceurl: /v1/models/mnist

mlservicename: torch-mnist-logger

namespace: example

traceparent: 00-6d69e2d3917689ee301610780af06de8-be01c3cfdf8e446e-00

Data,

{

"0": 1.0,

"2": 1.3369853835154544e-10,

"6": 7.10219507987428e-14,

"5": 5.859705488843112e-14,

"9": 3.2580891499658536e-15

}

在上述示例中:

type:表明当前 CloudEvent 数据记录 response 内容。source:release 名称是 origin(source 命名规则是<mlservice-name>-<component>-<release-name>)component:组件是 predictinferenceurl:URL path 是/v1/models/mnistmlservicename:MLService 的名称是 torch-mnist-loggernamespace:MLService 所在的 namespace 是 exampleData:MLService 向用户返回的 response 内容是 {"0": 1.0,"2": 1.3369...}

在 HTTP Request 中:

- CloudEvent 的 Data 内容存在 Request Body 中

- CloudEvent 的其他内容存在 Request Header 中

可使用 CloudEvent 库来实现接收日志数据的 HTTP Server,具体实现可参考 CloudEvent Sample。

示例

部署日志接收服务

我们在集群内部署 event-display 服务来接受日志,注意:

- event-display 仅简单地将接收到的 CloudEvents 打印出来;

- event-display 作为演示的目的。

event-display.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: event-display

spec:

replicas: 1

selector:

matchLabels:

app: event-display

template:

metadata:

labels:

app: event-display

spec:

containers:

- name: event-display

image: t9kpublic/knative_event_display:1.0.0

resources:

limits:

cpu: 100m

memory: 100Mi

---

kind: Service

apiVersion: v1

metadata:

name: event-display

spec:

selector:

app: event-display

ports:

- protocol: TCP

port: 80

targetPort: 8080

部署命令

kubectl create -f event-display.yaml

部署 MLService

请按照使用方法准备环境,基于部署用于生产环境的模型推理服务示例来部署 MLService logger-example。

首先将 mlservice.yaml 修改为下列内容,注意:

- event-display 和 MLService 需要部署在同一个 namespace/project 中。

- 这个 MLService 仅对 predictor 设置了 logger 服务。

mlservice.yaml

apiVersion: tensorstack.dev/v1beta1

kind: MLService

metadata:

name: logger-example

spec:

default: origin

releases:

- name: origin

predictor:

logger:

mode: all

resources:

limits:

cpu: "1"

memory: 2Gi

requests:

cpu: "0.5"

memory: 1Gi

urls:

- http://event-display

minReplicas: 1

model:

parameters:

"MODEL_PATH": "mnist=model.mar"

runtime: t9k-torchserve

containersResources:

- name: user-container

resources:

limits:

cpu: "500m"

memory: 1Gi

storage:

pvc:

name: tutorial

subPath: tutorial-examples/deployment/mlservice/torch-pvc

然后按照 README 文档的操作步骤进行操作。

查看日志

查看 event-display 容器的日志,可看到日志中打印的 CloudEvent 记录了预测请求的详细信息:

terminal.log

$ k get pod -l app=event-display

NAME READY STATUS RESTARTS AGE

event-display-7d8d9f97db-lpgg2 1/1 Running 0 14m

$ k logs event-display-7d8d9f97db-lpgg2

Context Attributes,

specversion: 1.0

type: tensorstack.dev.mlservice.request

source: logger-example-predict-origin

id: ff726d6b-7fd8-471e-9ddc-de03b201d882

time: 2024-02-29T08:07:00.849119273Z

Extensions,

component: predict

inferenceurl: /v1/models/mnist:predict

mlservicename: logger-example

namespace: demo

Data,

PNG

IHDWfHIDATxc`X`ˬUvo>C0$ůشi˿_{ ZATI̶_Q%̓*y_:=U9;4ɺpJ^{oG8NIx$!K.w;@@4^0

G$Qp֛q?{4g^B

<`Rr330

ztB?IENDB`

☁️ cloudevents.Event

Context Attributes,

specversion: 1.0

type: tensorstack.dev.mlservice.response

source: logger-example-predict-origin

id: ff726d6b-7fd8-471e-9ddc-de03b201d882

time: 2024-02-29T08:07:01.468872477Z

Extensions,

component: predict

inferenceurl: /v1/models/mnist:predict

mlservicename: logger-example

namespace: demo

Data,

{

"0": 1.0,

"2": 1.3369905182969433e-10,

"6": 7.102208632401436e-14,

"5": 5.859716330864836e-14,

"9": 3.2580891499658536e-15

}

参考

- API 参考:MLService

- CloudEvents

- event display 源码

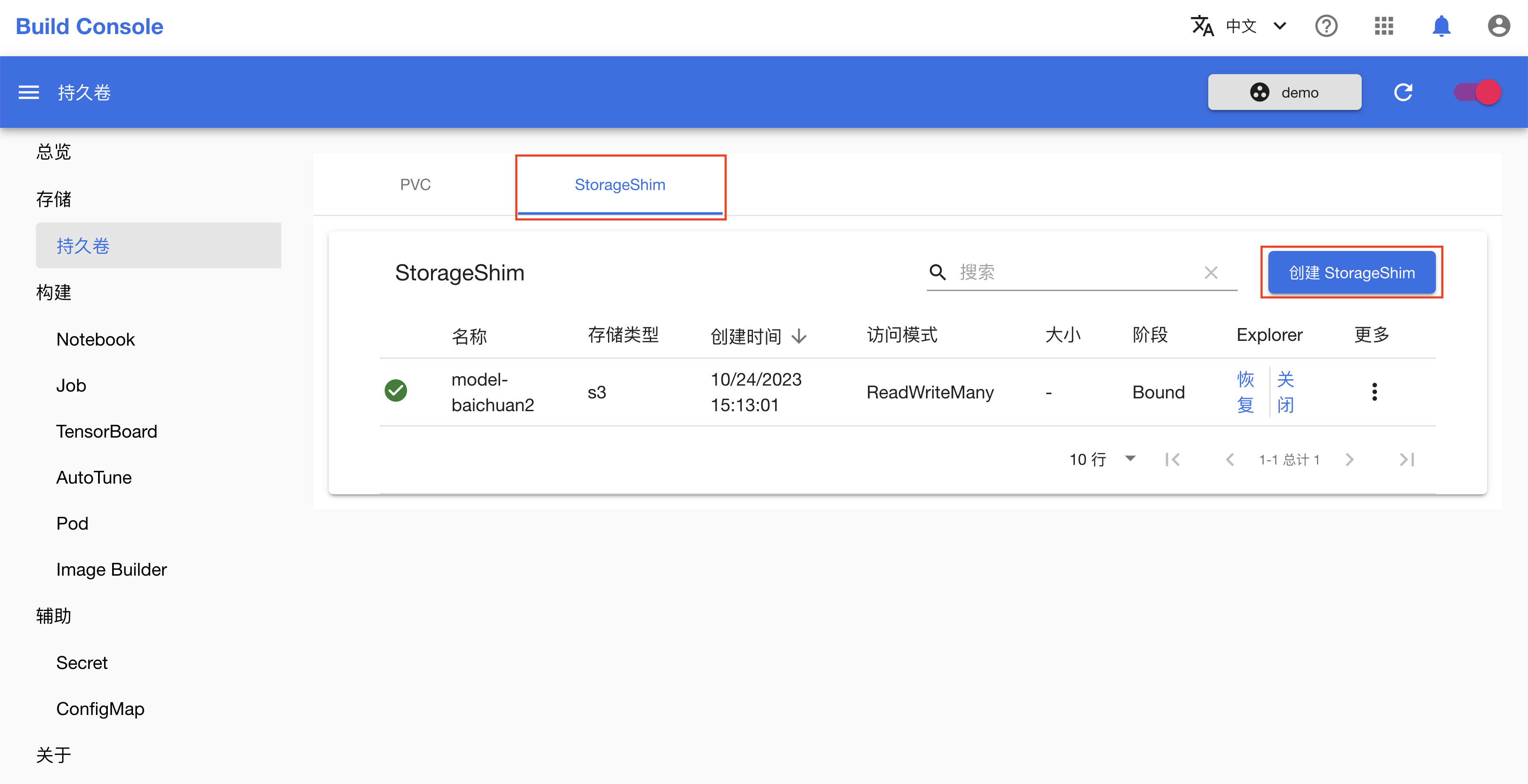

模型存储

AI 模型可以存储在集群的文件系统里,或者 S3 对象存储服务中。

SimpleMLService 和 MLService 采用相同的方式指定模型的存储细节,用户可以明确、方便地指定模型在集群文件系统或者 S3 对象存储服务中的位置,并设置模型在容器中的挂载路径。

文件系统

通过配置 storage.pvc 字段可以通过 PVC 使用集群文件系统中的模型。storage.pvc 字段包含下列子字段:

name: 存储模型数据的 PVC 的名称。subPath: 模型在 PVC 中的路径,不可以是绝对路径(即开头不能是/)。mountPath: 模型在容器中的挂载路径,必须是绝对路径。未设置时,默认值是/var/lib/t9k/model。

示例如下:

storage:

pvc:

name: demo

subPath: path/mnist

mountPath: /var/lib/custom

在上述示例中:

- PVC 名称是

demo。 - 模型在 PVC 中的路径是

path/mnist。 - 模型会被挂载到容器的路径

/var/lib/custom下。

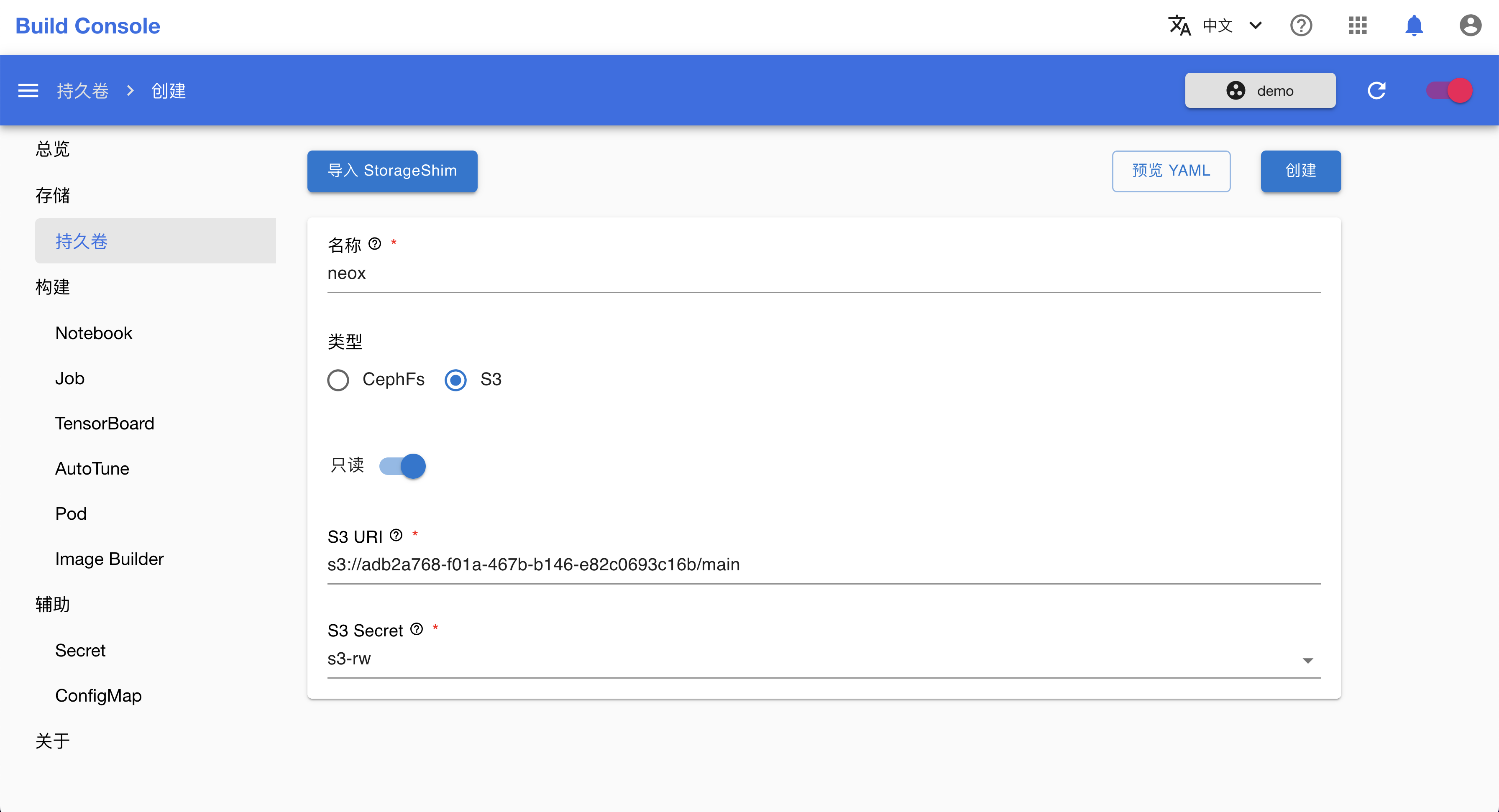

S3

当使用 S3 服务存储的模型数据时:

- SimpleMLService/MLService 需要先通过 initContainer 下载模型数据到容器本地,然后才能供给推理服务使用。如果下载失败,则推理服务无法启动。

- 当 SimpleMLService/MLService 设置了多个副本时,每个副本都需要单独下载模型数据,副本间无法共享模型数据。

如果用户想使用存储在 S3 服务中的模型数据,需要:

- 创建存储 S3 服务信息的 Secret

- 设置

storage.s3字段

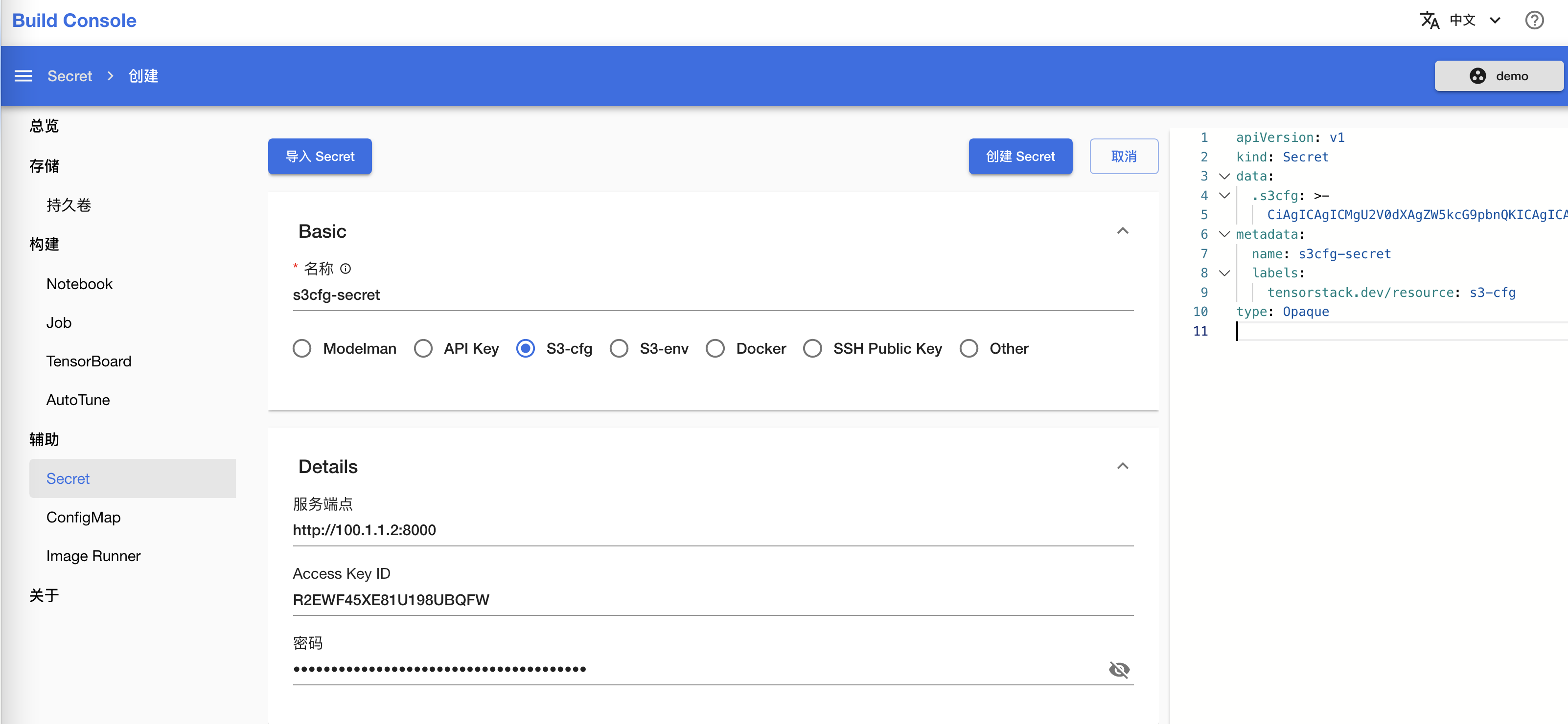

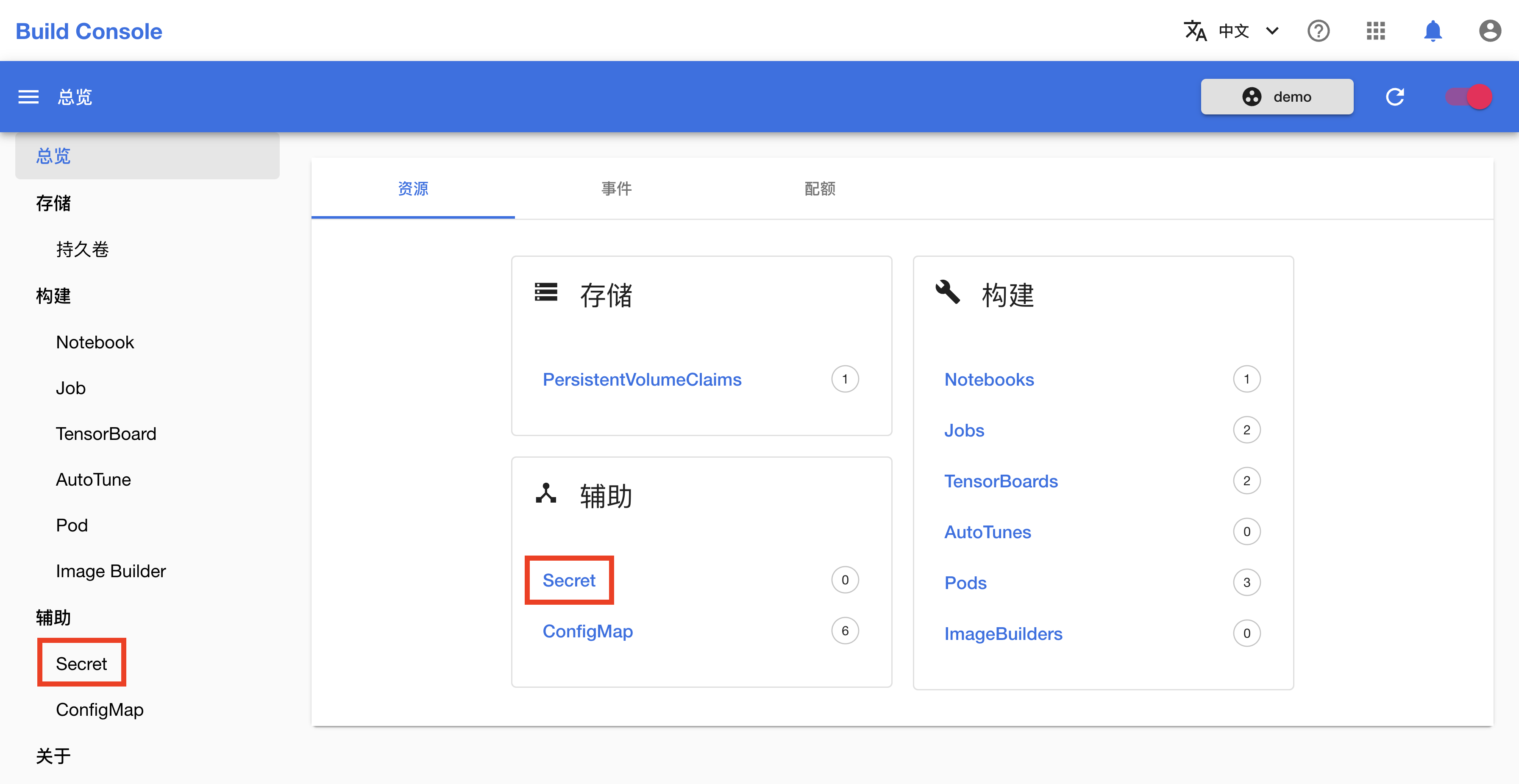

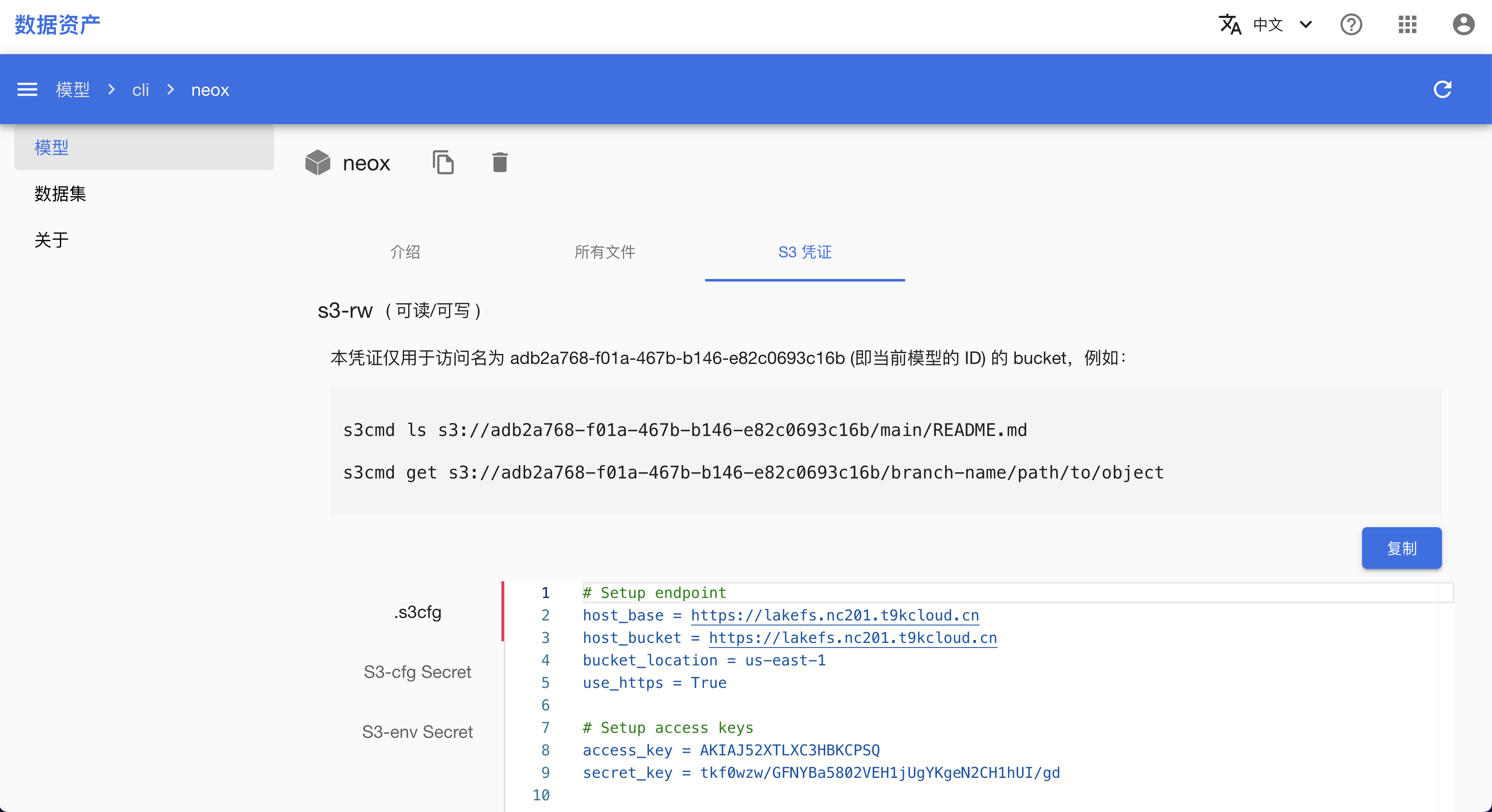

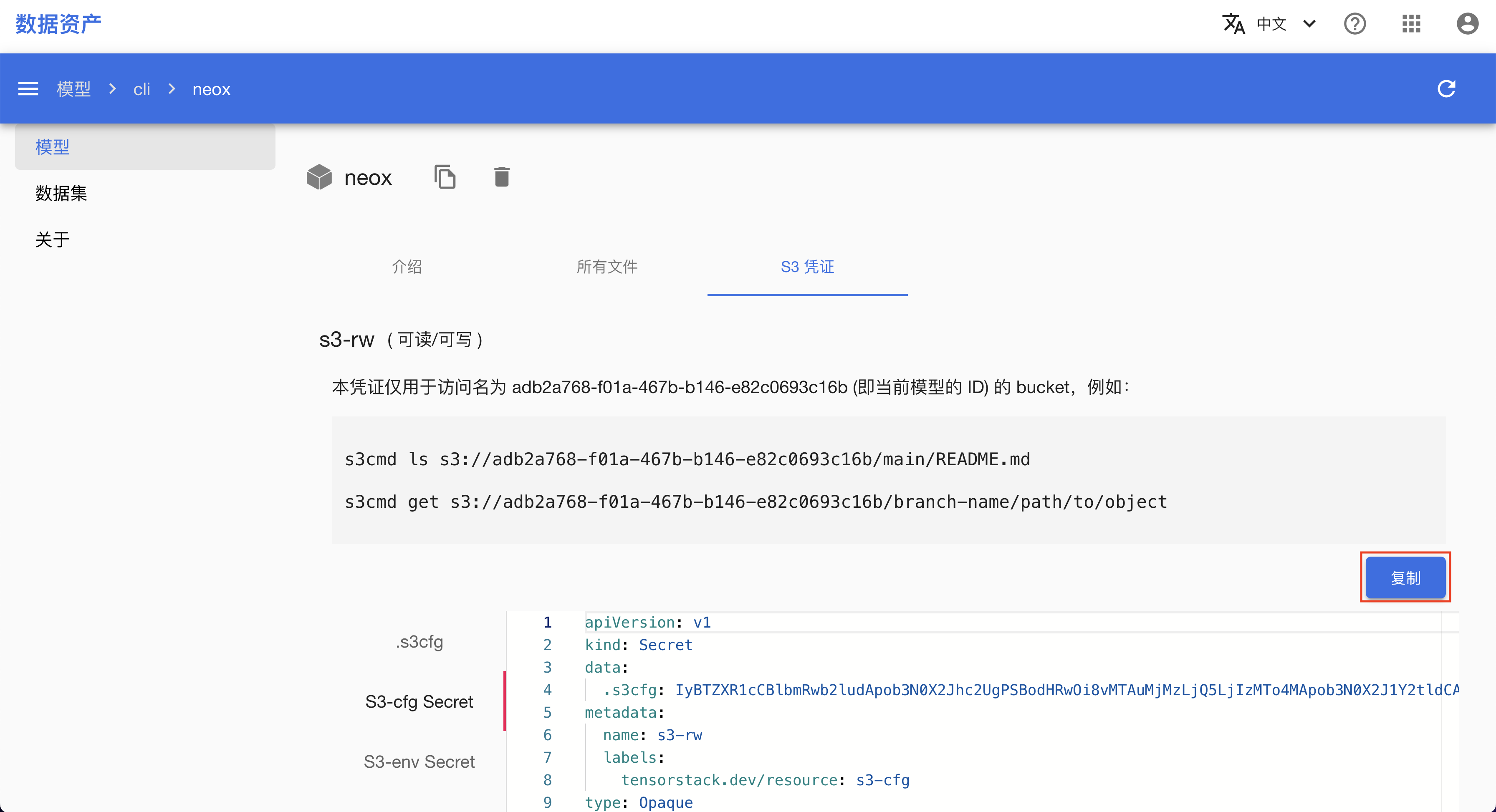

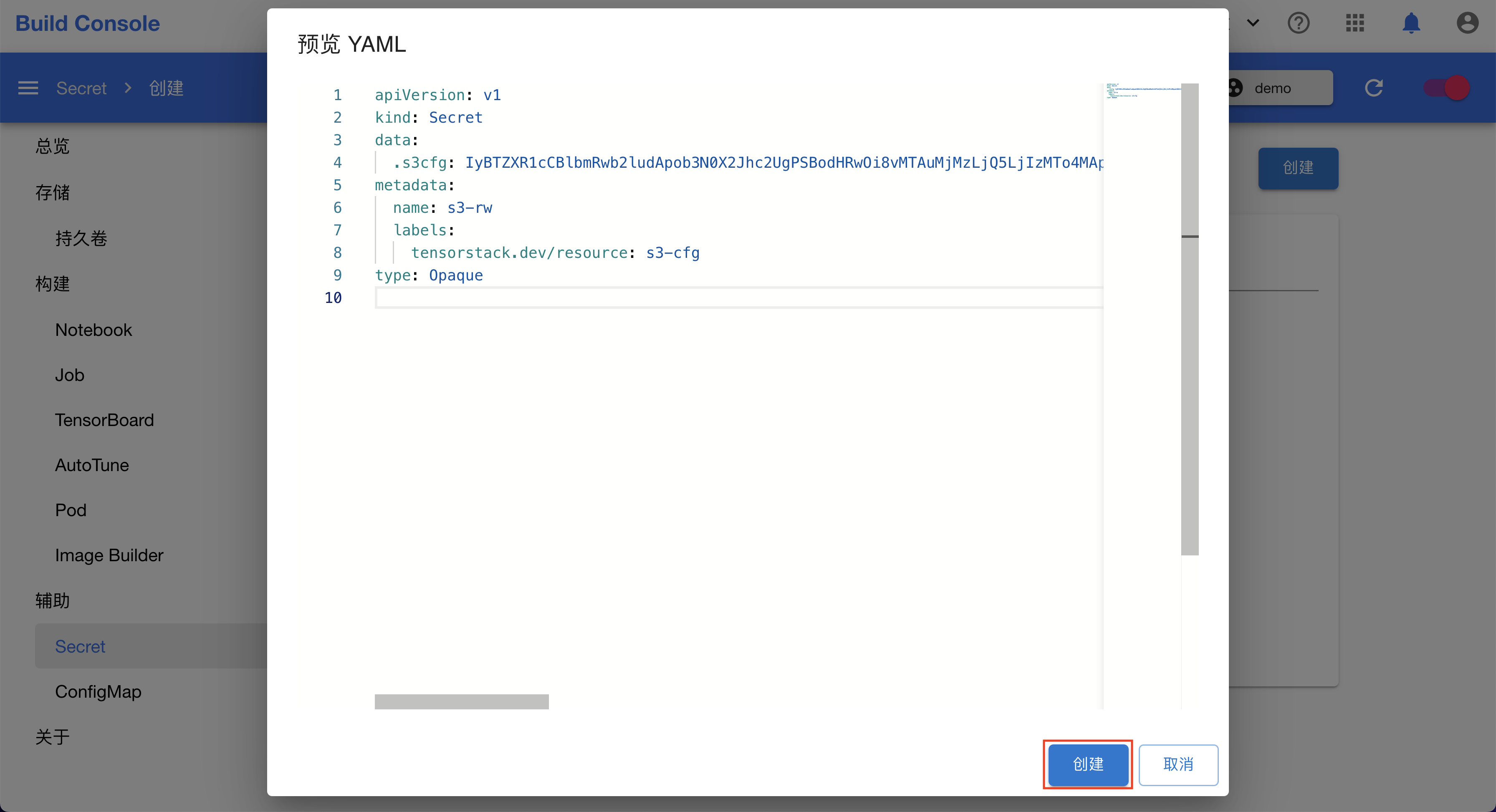

创建 S3 Secret

存储 S3 信息的 Secret 需要满足下列条件:

- 设置 label

tensorstack.dev/resource: s3。 - 设置

data[.s3cfg]字段,内容是 Base64 编码的 s3cmd config。

YAML 示例如下:

apiVersion: v1

kind: Secret

metadata:

name: s3-sample

labels:

tensorstack.dev/resource: s3

type: Opaque

data:

.s3cfg: aG9zdF9iYXNlID0gczMuYXAtZWFzdC0xLmFtYXpvbmF3cy5jb20KaG9zdF9idWNrZXQgPSBleGFtcGxlLnMzLmFwLWVhc3QtMS5hbWF6b25hd3MuY29tCmJ1Y2tldF9sb2NhdGlvbiA9IGFwLWVhc3QtMQp1c2VfaHR0cHMgPSBGYWxzZQphY2Nlc3Nfa2V5ID0gdXNlcgpzZWNyZXRfa2V5ID0gcGFzc3dvcmQKc2lnbmF0dXJlX3YyID0gRmFsc2U=

其中 data[.s3cfg] 字段 Base64 解码后如下:

host_base = s3.ap-east-1.amazonaws.com

host_bucket = example.s3.ap-east-1.amazonaws.com

bucket_location = ap-east-1

use_https = False

access_key = user

secret_key = password

signature_v2 = False

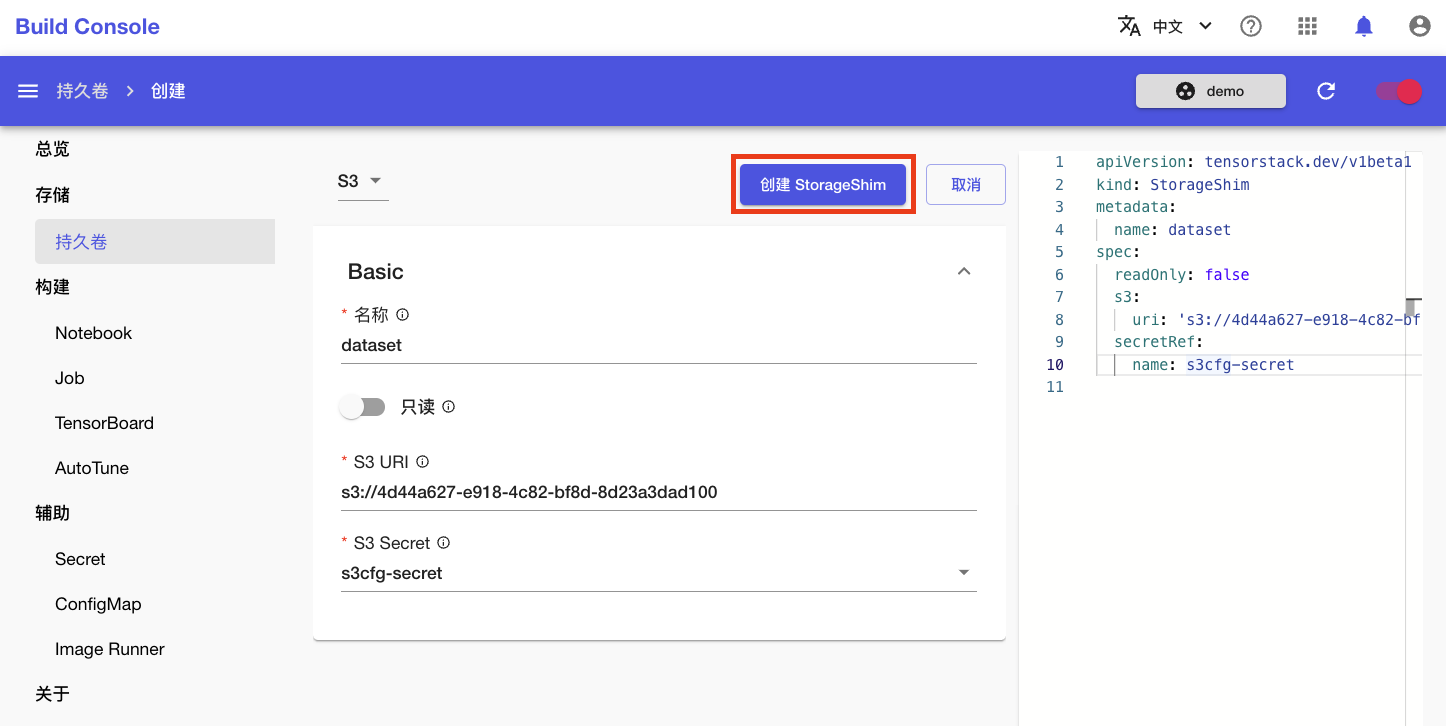

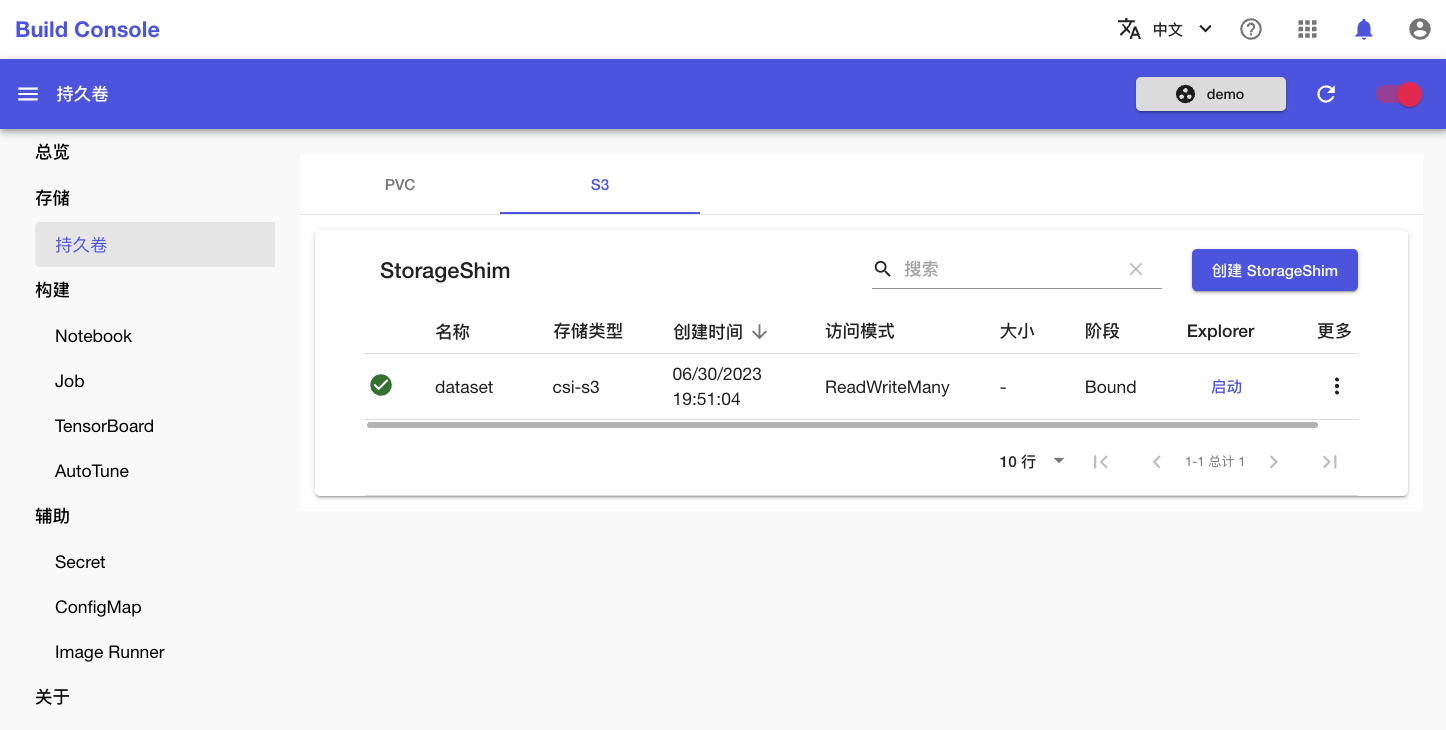

设置 storage.s3

设置 storage.s3 字段来使用存储在 S3 中的模型数据。storage.s3 字段包含下列子字段:

secretRef: 记录存储 S3 配置信息的 Secret。该字段有下列子字段:name:Secret 名称。

uri: 模型在 S3 中的存储标识。mountPath: 模型在容器中的挂载路径,必须是绝对路径。未设置时,默认值是/var/lib/t9k/model。

示例如下:

storage:

s3:

secretRef:

name: s3-secret

uri: s3://models/mnist/

mountPath: /var/lib/custom

在上述示例中:

- Secret

s3-secret存储着 S3 配置信息。 - 模型在 S3 中的存储标识是

s3://models/mnist/。 - 模型会被挂载到容器的路径

/var/lib/custom下。

存储类型比较

使用 PVC 存储模型数据:

- 优点:

- 挂载速度快

- 多副本可以共享 PVC 数据

- 缺点:

- 需要提前创建 PVC,并在 PVC 中准备好模型数据

使用 S3 存储模型数据:

- 优点:

- 只需简单设置,就能 S3 服务存储的模型数据

- 跨项目共享使用模型很方便

- 缺点:

- S3 中的模型需要先被下载才能使用,启动时间一般较长

- 多副本间无法共享模型数据,每个副本都需要从 S3 下载模型数据

下一步

- 查看 MLService 部署示例的模型存储设置

- 查看 SimpleMLService 部署示例的模型存储设置

参考

- S3

- s3cmd

- PVC

- API 参考:Storage in MLService

- API 参考:Storage in SimpleMLService

Job

TensorStack AI 平台定义了一系列 CRD(称为 Job)以支持批处理(Batch Processing)计算任务,特别是 AI 领域的大规模分布式并行训练类型性质的计算。

Job 类型

为了支持不同框架的计算任务,TensorStack 提供了一系列 Job:

- TrainingJob:一类使用分布式计算框架进行机器学习的 T9k Job。

- PyTorchTrainingJob:服务于 PyTorch 分布式训练框架的 T9k Job。

- TensorFlowTrainingJob:服务于 TensorFlow 分布式训练框架的 T9k Job。

- XGBoostTrainingJob:服务于 XGBoost 分布式计算框架的 T9k Job。

- ColossalAIJob:服务于 ColossalAI 分布式训练框架的 T9k Job。

- DeepSpeedJob:服务于 DeepSpeed 分布式训练框架的 T9k Job。

- MPIJob:MPIJob 使用户能够方便地在集群环境中使用 OpenMPI 进行并行计算。

- BeamJob:用于在集群中通过 Apache Beam Python SDK 运行分布式计算任务,并支持多种底层计算引擎(例如 Apache Spark, Apache Flink)。

- GenericJob:一个通用的 T9k Job 资源,支持各种并行计算场景及 T9k 高级调度策略。

- GenericJob 十分灵活,用户可以使用 GenericJob 实现 MPIJob、PyTorchTrainingJob 等特定功能的 T9k Job;但其自动化程度低,需要手工设置很多参数。

- GenericJob 的目的是提供一个总是可行的 “通用” 机制,以支持一些其他特定功能 T9k Job 还未支持的新的计算场景。

运行模式

T9k Job 支持多种运行模式(spec.runMode):

- 立即(Immediate)模式:默认、基本模式。Job 被分配资源后,将会立即开始运行。

- 调试(Debug)模式:帮助用户创建 Job 环境,但不立即执行,用户可以在训练环境中手动启动 Job 或者运行调试代码。

- 暂停(Pause)模式:暂停执行 Job;在一些场合下(如集群资源不足),用户可随时暂停 Job,待条件允许再继续执行 Job。

- 弹性(Elastic)伸缩模式:可以动态调整 Job 规模。

以下是各类型 Job 支持的模式列表:

| Job 类型 | 立即模式 | 调试模式 | 暂停模式 | 弹性伸缩模式 |

|---|---|---|---|---|

| GenricJob | * | * | * | |

| PyTorchTrainingJob | * | * | * | * |

| TensorFlowTrainingJob | * | * | * | |

| XGBoostTrainingJob | * | * | * | |

| MPIJob | * | * | * | |

| ColossalAIJob | * | * | * | |

| DeepSpeedJob | * | * | * | * |

| BeamJob | * |

各种模式的具体使用方式,请参考对应 Job 类型的文档。

GenericJob

GenericJob 是最基本的 T9k Job 资源,支持使用 T9k 高级调度策略。GenericJob 的使用十分灵活,一个熟练的使用者可以通过 GenericJob 实现 MPIJob、PyTorchTrainingJob 等特定功能的 T9k Job。

创建 GenericJob

下面是一个基本的 GenericJob 示例:

apiVersion: batch.tensorstack.dev/v1beta1

kind: GenericJob

metadata:

name: generic-example

spec:

successRules:

- { "worker": [0] }

failureRules:

- { "worker": [0] }

- { "worker": [1] }

replicaSpecs:

- type: worker

replicas: 4

template:

spec:

containers:

- command:

- sleep

- '365'

image: nginx:latest

name: sleep

在该例中:

- 创建 4 个副本(由

spec.replicaSpecs[0].replicas字段指定),这些副本的类型为worker(由spec.replicaSpecs[0].type字段指定)。每个副本执行命令sleep 365(由spec.replicaSpecs[0].template字段指定)。 - GenericJob 的成功条件为序号为 0 且类型为

worker的副本执行完成(由spec.successRules字段指定)。 - GenericJob 的失败条件有两个,任意一个条件达成都会导致 GenericJob 失败(由

spec.failureRules字段指定):- 序号为 0 且类型为

worker的副本执行失败。 - 序号为 1 且类型为

worker的副本执行失败。

- 序号为 0 且类型为

副本设置

GenericJob 副本运行环境和命令可以通过 spec.replicaSpecs[*].template 进行配置,可配置内容包括镜像、运行命令、资源配置、环境变量等。

资源配置

副本资源配置通过 spec.replicaSpecs[*].template.spec.containers[*].resources 字段指定。

GenericJob 的资源配置包括两部分:

- 资源请求量(

requests):创建该副本时,节点上至少应具有这些数量的资源。如果集群中所有节点都不满足副本的资源请求量,则副本的创建可能会被阻塞;或者如果副本的优先级较高,则有可能驱逐节点上其他工作负载来为副本空出可用的资源。 - 资源上限(

limits):该副本在运行期间,最多可以使用的资源数量。比如:如果副本在运行时申请分配超过上限的内存,则有可能出现OOMKILLED错误。(注:资源上限不能小于资源请求量)

在下面的示例中,GenericJob 中每个 worker 副本设置了以下资源配置:

- 资源请求量:2 个 cpu 核心、2Gi 内存;

- 资源上限:4 个 cpu 核心、4Gi 内存。

apiVersion: batch.tensorstack.dev/v1beta1

kind: GenericJob

metadata:

name: generic-example

spec:

replicaSpecs:

- type: worker

replicas: 4

template:

spec:

containers:

- resources:

limits:

cpu: 4

memory: 4Gi

requests:

cpu: 2

memory: 2Gi

共享内存

在进行多节点任务时,可以按照如下方式修改 GenericJob 来使用共享内存:

apiVersion: batch.tensorstack.dev/v1beta1

kind: GenericJob

metadata:

name: generic-example

spec:

replicaSpecs:

- type: worker

replicas: 4

template:

spec:

containers:

- ...

volumeMounts:

- mountPath: /dev/shm

name: dshm

volumes:

- name: dshm

emptyDir:

medium: Memory

sizeLimit: "1Gi"

在该例中:

- 在

spec.replicaSpecs[*].template.spec.volumes中增加一项,名称为dshm,其中限制共享内存最大为1Gi; - 在

spec.replicaSpecs[*].template.spec.containers[*].volumeMounts中增加一项,将上述dshm绑定到/dev/shm路径。

环境变量

副本环境变量通过 spec.replicaSpecs[*].template.spec.containers[*].env 字段指定。GenericJob 支持直接设置环境变量内容和引用其他资源字段作为环境变量两种方式。

在下面的示例中,GenericJob 给 worker 副本设置了两个环境变量:ENV_DIRECT 和 ENV_REFERENCED。其中 ENV_DIRECT 环境变量被直接设置为 env-value,ENV_REFERENCED 环境变量引用了 secret-name Secret 的 key-in-secret 字段的内容。

apiVersion: batch.tensorstack.dev/v1beta1

kind: GenericJob

metadata:

name: generic-example

spec:

replicaSpecs:

- type: worker

replicas: 4

template:

spec:

containers:

- env:

- name: ENV_DIRECT

value: env-value

- name: ENV_REFERENCED

valueFrom:

secretKeyRef:

name: secret-name

key: key-in-secret

变量替换

在副本的配置信息中有时需要传入副本自身或其他副本的信息,包括序号、类型和副本的服务地址等。GenericJob 通过变量替换的方式提供这些信息,主要有以下 5 种变量:

$(type):当前副本的类型。$(rank):当前副本在同类副本中的序号。$(replicas[_type_]):扮演此类型的副本的数量。$(service._type_[_rank_].host):各个副本的域名(当且仅当副本的服务被暴露出来,此变量可用)。$(service.port[_port-name_]):spec.service.ports字段中定义的服务端口号(当且仅当副本的服务被暴露出来,此变量可用)。

上述变量中 _type_、_rank_ 和 _port-name_ 需填入具体的类型、序号和端口名称(由 spec.service.ports[*].name 字段指定)。

变量替换可以被使用在下列字段中:

spec.replicaSpecs[*].template.commandspec.replicaSpecs[*].template.argsspec.replicaSpecs[*].template.env

以下是用 GenericJob 实现的 TensorFlow 分布式框架使用示例,其中 TF_CONFIG 环境变量需要填写所有副本的地址和当前副本的序号等信息,我们使用变量替换的方式添加:

apiVersion: batch.tensorstack.dev/v1beta1

kind: GenericJob

metadata:

name: generic-example

spec:

replicaSpecs:

- type: worker

replicas: 4

template:

spec:

containers:

- command:

- python

- /mnt/training.py

image: tensorflow/tensorflow:2.11.0

name: tensorflow

env:

- name: TF_CONFIG

value: '{"task":{"type":"$(type)","index":$(rank)},"cluster":{"worker":["$(service.worker[0].host):$(service.port[http])","$(service.worker[1].host):$(service.port[http])","$(service.worker[2].host):$(service.port[http])","$(service.worker[3].host):$(service.port[http])"]}}'

重启机制

GenericJob 为副本提供以下重启机制:

Never:不重启OnFailure:错误即重启Always:总是重启(谨慎使用此策略,此策略可能导致 GenericJob 无法停止)

GenericJob 重启机制通过 spec.replicaSpecs[*].restartPolicy 字段指定:

spec.replicaSpecs[*].restartPolicy.policy表示当前副本所使用的重启策略,可以设置为Never、OnFailure或Always。spec.replicaSpecs[*].restartPolicy.limit表示当前副本的最大重启次数。

不同的类型可以使用不同的重启策略,比如 master 使用 Always,worker 使用 OnFailure。

成功和失败

GenericJob 的成功和失败条件是通过 spec.successRules 和 spec.failureRules 字段指定的,其规则如下:

spec.successRules数组包含 GenericJob 的所有成功条件,其中:- 任意一个条件达成则 GenericJob 成功。

- 每个条件是一个由若干副本组成的集合,如果这些副本都执行完成,则该条件达成。

spec.failureRules数组包含 GenericJob 的所有失败条件,其中- 任意一个条件达成则 GenericJob 失败。

- 每个条件是一个由若干副本组成的集合,如果这些副本都失败或者重启次数耗尽,则该条件达成。

在下面的示例中,记录了 3 种 GenericJob 成功的判定条件:

- 类型为

master且序号为 0 的副本执行完成。 - 类型为

worker且序号为 0、1、2 的三个副本全部执行完成。 - 类型为

master且序号为 2 和类型为worker且序号为 0、1 的三个副本全部执行完成。

和 1 种 GenericJob 失败的判定:

- 类型为

master且序号为 0 的副本执行失败。

...

spec:

successRules:

- {"master": [0]}

- {"worker": [0, 1, 2]}

- {"master": [2], "worker": [0, 1]}

failureRules:

- {"master": [0]}

暴露副本的服务

在分布式计算中,有时需要不同的副本之间进行通信和数据交换。使用者可以通过设置 spec.service 字段来暴露副本的端口。

在下面的示例中,GenericJob 暴露出每一个副本的服务:端口为 2222,域名的格式为 [job-name]-[type]-[rank],例如下例中类型为 worker 且序号为 0 的副本的域名为 generic-example-worker-0。

apiVersion: batch.tensorstack.dev/v1beta1

kind: GenericJob

metadata:

name: generic-example

spec:

service:

ports:

- name: http

port: 2222

replicaSpecs:

- type: worker

replicas: 1

...

清除策略

在 GenericJob 成功或失败后,控制器清理所创建的 Kubernetes 资源,使 GenericJob 不再浪费集群资源(内存、CPU 等)。GenericJob 提供三种策略,通过 spec.cleanUpPolicy 字段指定:

All:清除全部副本None:不清除副本Unfinished:清除未结束(处于Pending、Running或Unknown阶段)的副本

调度器

目前 GenericJob 支持两种调度器:

- Kubernetes 的默认调度器

- T9k Scheduler 调度器

调度器通过 spec.scheduler 字段设置:

- 不设置

spec.scheduler字段,则默认使用 Kubernetes 的默认调度器。 - 设置

spec.scheduler.t9kScheduler字段,则使用 T9k Scheduler 调度器。

在下面的示例中,GenericJob 启用 T9k Scheduler 调度器,将副本插入 default 队列中等待调度,其优先级为 50。

...

spec:

scheduler:

t9kScheduler:

queue: default

priority: 50

调试模式

GenericJob 支持调试模式。在该模式下,训练环境会被部署好,但不会启动训练,用户可以连入副本测试环境或脚本。

该模式可以通过 spec.runMode.debug 字段来设置:

spec.runMode.debug.enabled表示是否启用调试模式。spec.runMode.debug.replicaSpecs表示如何配置各个副本的调试模式:spec.runMode.debug.replicaSpecs.type表示作用于的副本类型。spec.runMode.debug.replicaSpecs.skipInitContainer表示让副本的 InitContainer 失效,默认为false。spec.runMode.debug.replicaSpecs.command表示副本在等待调试的时候执行的命令,默认为sleep inf。- 如果不填写

spec.runMode.debug.replicaSpecs字段,则表示所有副本都使用默认设置。

在下面的示例中:

- 示例一:开启了调试模式,并配置 worker 跳过 InitContainer,并执行

/usr/bin/sshd。 - 示例二:开启了调试模式,副本使用默认调试设置,即不跳过 InitContainer,并执行

sleep inf。

# 示例一

...

spec:

runMode:

debug:

enabled: true

replicaSpecs:

- type: worker

skipInitContainer: true

command: ["/usr/bin/sshd"]

---

# 示例二

...

spec:

runMode:

debug:

enabled: true

暂停模式

GenericJob 支持暂停模式。在该模式下,删除(或不创建)副本,停止训练。

该模式可以通过 spec.runMode.pause 字段来设置:

spec.runMode.pause.enabled表示是否启用暂停模式。spec.runMode.pause.resumeSpecs表示结束暂停后,如何恢复各个副本:spec.runMode.pause.resumeSpecs.type表示作用于的副本类型。spec.runMode.pause.resumeSpecs.skipInitContainer表示让副本的 InitContainer 失效,默认为false。spec.runMode.pause.resumeSpecs.command和spec.runMode.pause.resumeSpecs.args表示副本在恢复运行时候执行的命令,默认使用spec.replicaSpecs[0].template中的命令。- 如果不填写

spec.runMode.pause.resumeSpecs字段,则表示所有副本都使用默认设置。

用户可以随时修改 spec.runMode.pause.enabled 来控制任务暂停,但是不可以更改 spec.runMode.pause.resumeSpecs,所以如果有暂停 GenericJob 的需求,请提前设置好恢复设置。

在下面的示例中:

- 示例一:开启了暂停模式,并配置 worker 跳过 InitContainer,并执行

/usr/bin/sshd。 - 示例二:开启了暂停模式,副本使用默认恢复设置,即不跳过 InitContainer,并执行

spec.replicaSpecs[0].template中设置的命令。

# 示例一

...

spec:

runMode:

pause:

enabled: true

resumeSpecs:

- type: worker

skipInitContainer: true

command: ["/usr/bin/sshd"]

---

# 示例二

...

spec:

runMode:

pause:

enabled: true

GenericJob 状态

GenericJob 的状态和阶段

status.conditions 字段用于描述当前 GenericJob 的状态,包括以下 6 种类型:

Initialized:GenericJob 已经成功创建各子资源,完成初始化。Running:开始执行任务。ReplicaFailure:有一个或多个副本出现错误。Completed:GenericJob 成功。Failed:GenericJob 失败。Paused:GenericJob 进入暂停模式,所有副本都已删除或正在删除。

status.phase 字段用于描述当前 GenericJob 所处的阶段,GenericJob 的整个生命周期主要有以下7个阶段:

Pending:GenericJob 刚刚创建,等待副本启动。Running:副本创建成功,开始执行任务。Paused:GenericJob 进入暂停模式。Resuming:GenericJob 正从暂停模式中恢复运行。恢复运行后,切换为Running阶段。Succeeded:GenericJob 成功。Failed:GenericJob 失败。Unknown:控制器无法获得 GenericJob 的阶段。

在下面的示例中,GenericJob 所有子资源创建成功,所以类型为 Initalized 的 condition 被设为 True;GenericJob 运行结束,所以类型为 Completed 的 condition 被设置为 True;但是 GenericJob 的训练结果是失败的,所以类型为 Failed 的 condition 被设置为 True(原因是 The job is failed with rule: { "worker": [0] })。当前 GenericJob 运行阶段为 Failed。

...

status:

conditions:

- lastTransitionTime: "2021-01-18T02:36:09Z"

status: "True"

message: "The job has been initialized successfully."

reason: "-"

type: Initializing

- lastTransitionTime: "2021-01-18T02:36:09Z"

status: "True"

message: "All pods are running normally."

reason: "-"

type: Running

- lastTransitionTime: "2021-01-18T02:36:09Z"

status: "False"

message: "All pods are running normally."

reason: "-"

type: ReplicaFailure

- lastTransitionTime: "2021-01-18T02:36:31Z"

status: "False"

message: 'The job is failed with rule: { "worker": [0] }'

reason: "Failed"

type: Completed

- lastTransitionTime: "2021-01-18T02:36:31Z"

status: "True"

message: 'The job is failed with rule: { "worker": [0] }'

reason: "Failed"

type: Failed

phase: Failed

副本的状态

status.tasks 字段用来记录副本的状态,记录的内容主要包括:

- 副本的重启次数(同一种类型的副本的重启次数之和);

- 副本当前的运行阶段,此处的“运行阶段”在 K8s Pod 的 5 个阶段的基础上,添加了

Creating和Deleted分别表示正在创建和已删除; - 副本在集群中对应的 Pod 的索引信息。